category

数据编制是一种集中式数据体系结构,为授权消费者提供集成的、受管理的、新鲜的数据,用于分析和操作工作负载。

数据编制——以数据为中心的企业的“必备品”在过去几年中,“数据编制”一词已成为企业数据集成和管理的代名词。

分析公司Gartner将“数据编制列为“顶级战略技术趋势” 并预测到2024年,25%的数据管理供应商将为数据编制提供完整的框架,高于目前的5%。

本文通过引用数据编制的定义、目的、体系结构、挑战、最佳实践、好处、供应商以及数据编制能力清单,阐述了数据编制的内容、原因、方式和对象。

第01章

数据编制定义

数据编制使整个企业的数据访问大规模民主化。它是一个单一、统一的体系结构,具有一套集成的技术和服务,旨在在正确的时间、正确的方法和向正确的数据消费者提供集成和丰富的数据,以支持操作和分析工作负载。

数据编制结合了关键的数据管理技术,如数据目录、数据治理、数据集成、数据管道和数据编排。

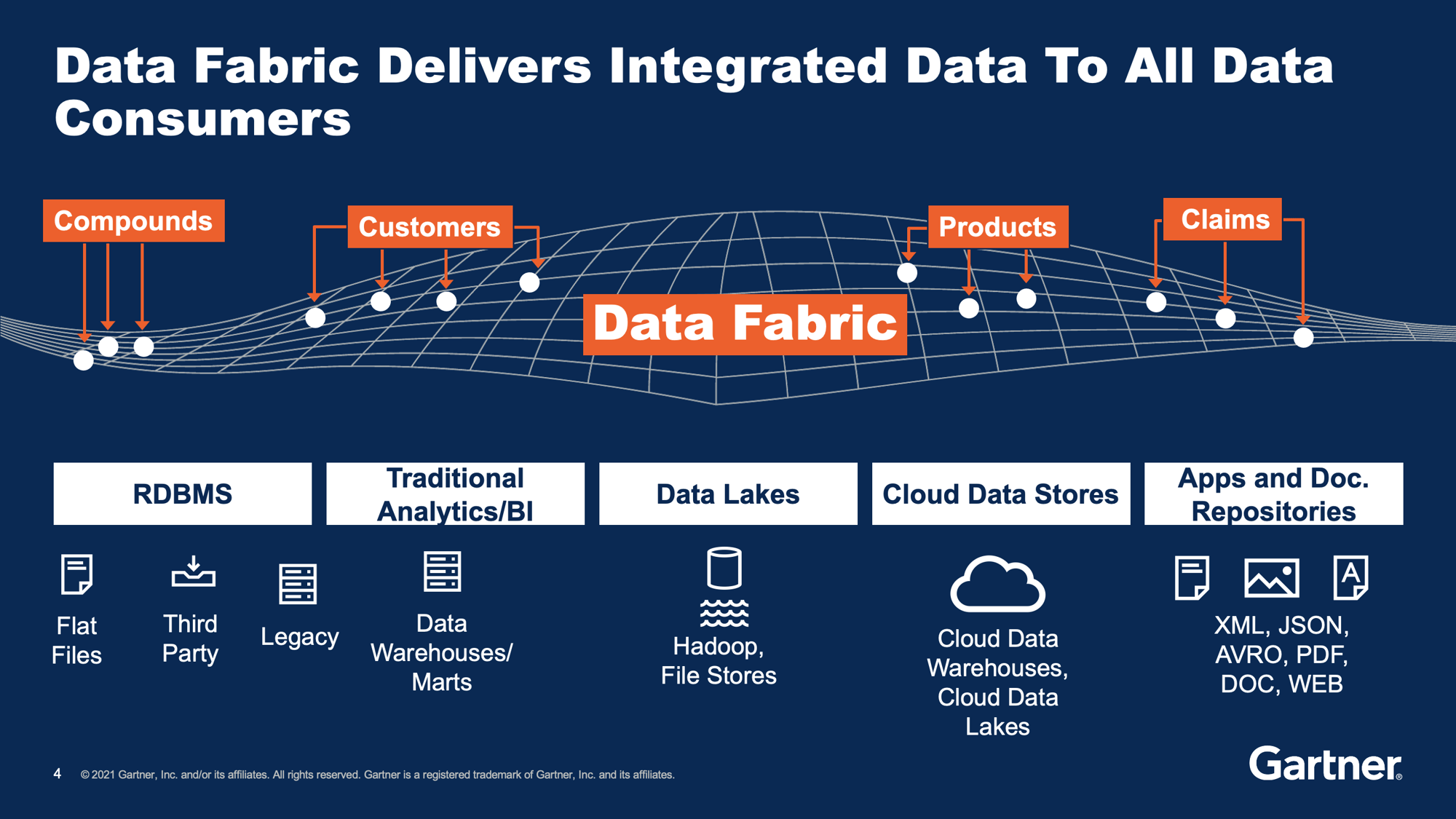

Gartner:数据编制将来自许多不同来源的集成数据缝合在一起,并将其提供给各种数据消费者。

第02章。为什么Data fabric

Data fabric服务于广泛的业务、技术和组织调整驱动因素。

业务驱动程序

- 通过可靠快速地将数据输送到数据湖和仓库,加快洞察和决策的时间。

- 实时、360度查看任何业务实体,如客户、索赔、订单、设备或零售店,以实现细分、减少客户流失、警惕运营风险或提供个性化客户服务。

- 通过逐步快速地对遗留系统进行现代化,降低了运营、扩展、维护和更改遗留系统的总体拥有成本。

数据管理驱动程序

- 数据准备自动化节省了数据科学家、数据工程师和其他IT资源,使其免于承担乏味的重复数据转换、清理和丰富任务。

- 以任何数据交付方法访问企业数据,包括批量数据移动(ETL)、数据虚拟化、数据流、更改数据捕获和API。

- 数据编制平台集成和增强了公司目前使用的数据管理工具,并允许其他人退休,以提高成本效益。

组织驱动程序

- 数据工程师和数据消费者之间共享的一种通用语言改善了数据和业务团队之间的协作。

- 自助数据访问功能使数据消费者能够在需要时获得所需的数据,从而提高业务灵活性和速度。

第03章数据编制体系结构

数据编制体系结构

Gartner:一个理想的、完整的数据编制设计,包含许多组件。

设计良好的数据编制架构是模块化的,支持大规模、分布式多云、内部部署和混合部署。

如上图所示,当数据从来源提供给消费者时,会对其进行编目、准备、丰富以提供见解和建议,并进行编排和交付。

数据编制能够集成和统一来自所有数据源的数据,从孤立的遗留系统到现代云应用程序和分析数据存储(数据仓库和湖泊)。

数据编制的数据消费者包括分析数据用户,如数据科学家和数据分析师,以及操作工作负载,如MDM、Customer 360、测试数据管理等。

第04章数据编制和数据网格架构

数据网格架构解决了数据管理中的四个关键问题:

- 数据分散在数十个,有时甚至数百个遗留系统和云系统中,使其难以实现单一的真实数据源

- 速度和数据量,以数据为中心的企业必须处理

- 难以理解的数据,除非你是业务线SME

- 业务分析师、运营数据消费者、数据工程师和数据科学家之间缺乏沟通。

数据网格是一种分布式数据管理体系结构和操作模型,为业务域提供数据产品所有权。

数据编制是对数据网格的补充,因为它在广泛的数据源中构建了一个集成的连接数据层。

它为分析和操作工作负载提供了即时、全面的业务视图。数据编制建立了不同数据产品的语义定义、数据接收模式以及保护数据的必要治理策略。

它充当数据网格体系结构中的集线器。

数据编制

数据编制可以作为数据网格体系结构中的数据治理中心

一个可以实时管理、准备和交付数据的数据编制,创建了理想的数据网格核心。当然,数据网格体系结构也有其实现挑战,但数据编制很容易解决这些挑战:

| Data mesh implementation challenges | How they are handled by data fabric |

|---|---|

|

对数据集成专业知识的要求:跨许多不同企业源系统的数据集成通常需要特定领域的数据管道专业知识。 |

|

|

联合与独立:在依赖中央数据团队和领域独立之间实现正确的平衡并不简单。 |

企业范围的协作:特定领域的团队与集中式数据团队协调,为其数据消费者构建API和管道,控制和管理访问权限,并监控使用情况。 |

|

批量数据以及实时和批量数据交付:数据产品必须在单个平台上安全高效地提供给离线和在线数据消费者。 |

分析和操作工作负载:数据结构从底层系统收集和处理数据,以按需提供数据产品,用于离线和在线用例。 |

第05章数据编制核心功能

数据沿袭是一种关键的数据编制功能,因为使用传统的数据建模和集成工具时会丢失关系洞察力。

数据编制支持集成到单个平台中的以下关键功能:

- 数据目录

- 对数据资产进行分类和盘点,并直观地表示信息供应链

- 数据工程

- 为操作和分析用例构建可靠和稳健的数据管道

- 数据治理

- 确保质量,遵守隐私法规,并安全、大规模地提供数据

- 数据准备和编排

- 定义从源到目标的数据流,包括数据清理、转换、屏蔽、丰富和验证的步骤序列

- 数据集成和交付

- 以任何方法从任何源检索数据并将其传递到任何目标:ETL(批量)、消息传递、CDC、虚拟化和API

- 数据持久层

- 动态持久化数据以实现实时数据处理、搜索和分析。

数据编制还应解决以下关键的非功能性功能:

- 数据规模、容量和性能

- 无论数据量有多大,都可以无缝地动态上下扩展。

- 支持企业规模的操作和分析工作负载。

- 可访问性

- 支持所有数据访问模式、数据源和数据类型,并集成静止或运动中的主数据和事务数据。

- 以任何格式(结构化或非结构化)从内部部署和云系统中获取和统一数据。

- 数据编制逻辑访问层需要允许数据消耗,无论数据存储或分发在何处或如何,因此不需要深入了解底层数据源。

- 分配

- 数据编制应可部署在多云、内部部署或混合环境中。

- 为了保持事务完整性和数据治理能力,数据编制需要支持智能数据虚拟化战略。

- 安全

- 在数据持久化的情况下,必须对其进行加密和屏蔽,以满足数据隐私法规的要求。

- 数据编制应该能够将用户凭据传递到源系统,以便正确检查和授权访问权限。

第06章操作工作量的数据编制与数据湖与数据库

为了解释数据编制如何使大数据存储能够处理操作工作量,数据编制、数据湖和数据库之间的比较是有用的。

下表总结了每个数据存储的优缺点,因为它与大规模、高容量、可操作的用例有关。

优点与缺点

| Pros | Cons | |

|---|---|---|

| Data Lake, DWH |

|

|

| Relational Database |

|

|

| NoSQL Database |

|

|

| Data Fabric |

|

因此,虽然数据编制是高规模操作工作负载的卓越解决方案,但它也是离线分析工作负载的数据湖和数据库的对等技术。

对于此类工作负载,数据编制可以:

- 将新鲜、可信的数据导入其中,用于离线分析目的。

- 从他们那里获得业务见解,以嵌入到实时运营用例中。

第07章数据编制用例

在企业运营中,有许多用例需要能够支持数千个同时事务的高规模、高速数据架构。示例包括:

提供客户360解决方案

将客户的单一视图提供给自助IVR、客户服务代理(CRM)、客户自助门户(网络或移动)、聊天服务机器人和现场服务技术人员

遵守数据隐私法

通过灵活的工作流程和数据自动化解决方案,采用数据编排和数据屏蔽工具,实现跨人员、系统和数据的合规性,旨在解决当前和未来的法规

将企业数据管道传输到数据湖和仓库

使数据工程师能够快速、大规模地准备和交付新鲜、可信的数据,从所有来源到所有目标按需

提供测试数据

创建测试数据仓库,并在几分钟内自动向测试人员和CI/CD管道提供匿名测试数据,实现完全的数据集成

现代化遗留系统

将数据从遗留系统安全地迁移到数据编制中,然后将该结构用作新开发应用程序的记录数据库

保护信用卡交易

通过加密和标记原始数据来保护敏感的持卡人信息,以避免数据泄露

预测客户流失,检测客户欺诈

。。。信用评分等

许多操作用例都要求数据编制在一瞬间对复杂的查询做出响应。因此,数据编制必须包括内置的处理机制:

- 实时数据摄入

- 从操作系统不断更新(每天更新数百万到数十亿次)

- 与不同系统的连接

- TB的数据分布在数十个大型数据库/表中,通常采用不同的技术

- 飞行中的数据转换、数据清理和数据丰富

- 提供有意义的见解并实时影响业务成果

- 商业实体的特定实例

- 例如,检索特定客户、位置、设备等的完整数据。

- 高并发性

- 每秒数千个请求

第08章数据编制优势

数据编制比其他数据管理方法(如主数据管理、数据中心和数据湖)具有许多优势,包括:

- 增强的数据管理

- 允许自动检索、验证和丰富数据—无需任何转换脚本或第三方工具

- 扩展的数据服务

- 使用创新引擎管理和同步数据,完全支持SQL和嵌入式web服务层

- 高一致性、耐用性和可用性

- 符合企业标准,具有值得信赖的数据库层和处理引擎

- 卓越的性能

- 依靠能够在少量数据上运行每个查询的体系结构,以及内存处理

- 严密的安全性

- 由于采用了复杂的多密钥加密引擎,消除了大规模数据泄露的可能性

第09章数据编制的好处

数据编制为企业提供的运营好处包括:

- 简化了数据编排

- 集成用于外部数据库、业务逻辑、屏蔽、解析和流化的操作员

- 自动化测试数据管理

- 从生产系统生成数据,然后向测试团队提供高质量的测试数据

- 快速遵守数据隐私

- 配置、管理和审核与GDPR、CCPA、LGPD等数据隐私法规相关的数据主体访问请求。

- 全面的数据管理

- 使用管理管理工具、直观的可视化工作室和web管理工具配置、监控和管理数据

- 优化了拥有成本

- 依靠商品硬件的内存性能、完全的线性可扩展性和无风险集成

第10章数据编制供应商

有多个供应商提供一套集成的功能来支持数据编制体系结构。排名前五的数据编制供应商如下所示:

| Strengths | Concerns | |

|---|---|---|

| K2view |

|

|

| Denodo |

|

|

| Talend |

|

|

| Informatica |

|

|

| IBM Cloud Pak for Data |

|

|

第11章分析和运营的数据编制

通常认为,数据编制是为了支持数据科学家在离线模式下进行的大数据分析,特别是趋势分析、预测分析、机器学习和商业智能,以产生商业见解。

但数据编制对于依赖准确、完整和新鲜数据的运营用例(如流失预测、信用评分、数据隐私合规性、欺诈检测、实时数据治理和客户360)同样重要。

数据团队不希望有一个用于数据分析的数据编制解决方案,另一个用于操作智能的解决方案。他们希望两者都有一个单一的数据编制。

理想的数据编制优化了每个业务实体(客户、产品、订单等)的视野和理解深度。它为企业提供了用于离线数据分析的干净、新鲜的数据,并为在线运营分析提供了实时、可操作的数据。

数据编制支持离线数据分析和在线操作智能。

- 数据编制基于业务实体的360度视图(如某一细分客户、一系列公司产品或特定地理位置的所有零售店)不断向数据湖或DWH提供高质量数据。利用这些数据,数据科学家创建并完善机器学习(ML)模型,而数据分析师则使用商业智能(BI)来分析趋势、细分客户并执行根本原因分析(RCA)。

- 精化的ML模型被部署到数据编制中,针对单个实体(客户、产品、位置等)实时执行,从而“操作”机器学习算法。

- 数据编制根据需要实时执行ML模型,为其提供单个实体的完整和当前数据。

- ML输出立即返回到请求的应用程序,并作为实体的一部分保留在数据编制中,以供将来分析。数据编制还可以调用实时推荐引擎来提供次优操作。

最新内容

- 1 day 9 hours ago

- 1 day 9 hours ago

- 1 week 2 days ago

- 1 week 2 days ago

- 1 week 6 days ago

- 2 weeks ago

- 2 weeks 3 days ago

- 2 weeks 4 days ago

- 3 weeks 2 days ago

- 3 weeks 2 days ago