人工智能为推动我们作为一个社会向前发展带来了无限的潜力,但巨大的潜力也带来了巨大的风险。

当你使用人工智能来支持基于敏感数据的关键业务决策时,你需要确保你了解人工智能在做什么,以及为什么。它是否做出了准确、有偏见的决定?这侵犯了任何人的隐私吗?你能管理和监控这项强大的技术吗?在全球范围内,各组织认识到对负责任人工智能的需求,但正处于不同的发展阶段。

负责任的人工智能(RAI)是减轻人工智能风险的唯一途径。现在是时候评估你现有的做法或创建新的做法,以负责任和合乎道德的方式构建技术和使用数据,并为未来的监管做好准备了。未来的收益将给早期采用者带来竞争对手可能永远无法超越的优势。

普华永道的RAI诊断调查可以帮助您评估组织相对于行业同行的绩效。该调查需要5-10分钟才能完成,并将生成一个分数,根据需要考虑的行动对您的组织进行排名。

潜在的人工智能风险

多种因素可以影响人工智能风险,随着时间的推移而变化,包括利益相关者、部门、用例和技术。以下是人工智能技术应用的六大风险类别。

性能

将真实世界的数据和偏好作为输入的人工智能算法可能存在学习和模仿可能的偏见和偏见的风险。

性能风险包括:

- 错误风险

- 存在偏见和歧视的风险

- 不透明和缺乏可解释性的风险

- 性能不稳定的风险

安全

自从自动化系统存在以来,人类就一直试图绕过它们。这与人工智能没有什么不同。

安全风险包括:

- 对抗性攻击

- 网络入侵和隐私风险

- 开源软件风险

控制

与任何其他技术类似,人工智能应该在全组织范围内进行监督,明确识别风险和控制措施。

控制风险包括:

- 缺乏人的能动性

- 检测流氓人工智能和意外后果

- 缺乏明确的问责制

经济的

自动化在经济各个领域的广泛应用可能会影响就业,并将需求转移到不同的技能上。

经济风险包括:

- 工作调动风险

- 加剧不平等

- 一个或几个公司内的权力集中风险

社会的

复杂和自主人工智能系统的广泛采用可能导致机器之间产生“回声室”,并对人机交互产生更广泛的影响。

社会风险包括:

- 错误信息和操纵风险

- 情报分歧的风险

- 监视和战争风险

企业

人工智能解决方案的设计考虑了特定的目标,这些目标可能会与它们运作的总体组织和社会价值观相竞争。长期以来,社区往往非正式地同意一套核心价值观,供社会反对。有一个运动,以确定一套价值观,从而道德,以帮助推动人工智能系统,但仍有分歧,这些伦理可能意味着在实践中,以及如何管理他们。因此,上述风险类别也是固有的道德风险。

企业风险包括:

- 声誉风险

- 财务业绩风险

- 法律和合规风险

- 歧视风险

- 价值不一致的风险

普华永道责任AI工具包

您的利益相关者,包括董事会成员、客户和监管机构,将对您的组织如何使用AI和数据(从如何开发到如何管理)提出许多问题。您不仅需要准备好提供答案,还必须展示持续的治理和法规遵从性。

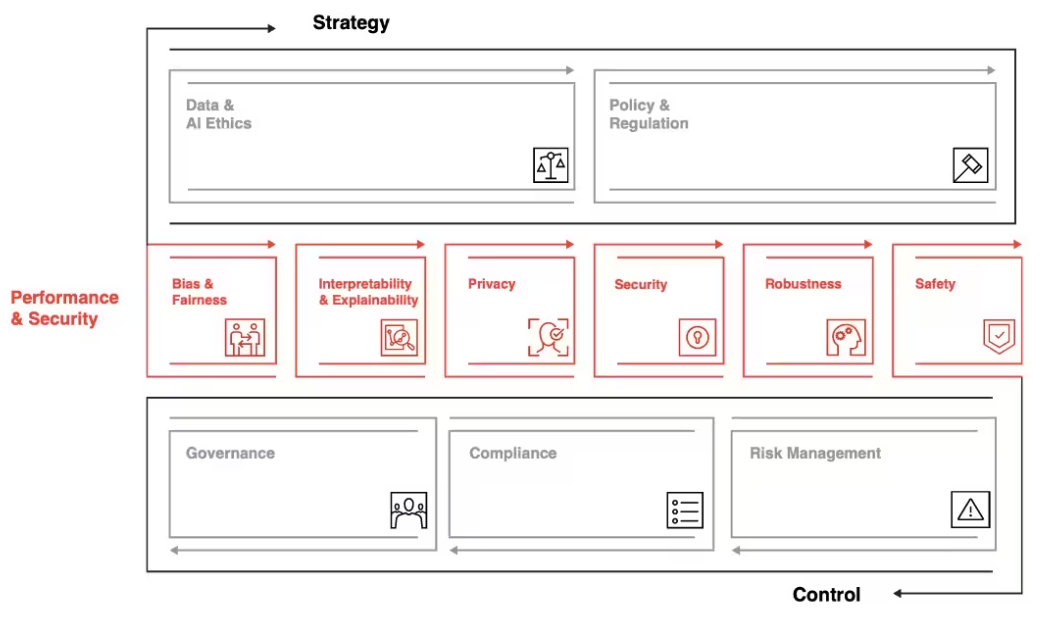

我们的负责任AI工具包是一套可定制的框架、工具和流程,旨在帮助您以合乎道德和负责任的方式利用AI的力量——从战略到执行。借助负责任的AI工具包,我们将定制解决方案,以满足您组织的独特业务需求和AI成熟度。

我们的负责任AI工具包解决负责任AI的三个维度

谁对您的AI系统负责?负责任人工智能的基础是一个端到端的企业治理框架,重点关注组织从上到下的人工智能过程中的风险和控制。普华永道开发了可根据您的组织量身定制的稳健治理模型。该框架使监督具有明确的角色和职责、跨越三道防线的明确要求以及可追溯性和持续评估机制。

在普华永道,信任是我们宗旨的核心。

我们拥有一个合适的团队,负责在内部和为客户构建人工智能,并在人工智能采用的各个阶段将大想法付诸实践。

- AI、数据和数据使用治理

- 人工智能与数据伦理

- 人工智能专业知识:机器学习、模型操作和数据科学

- 隐私权

- 网络安全

- 风险管理

- 变更管理

- 合规与法律

- 可持续性与气候变化

- 多样性和包容性

普华永道自豪地与世界经济论坛合作,为跨行业使用的人工智能开发制定前瞻性思维和实用指南。在此处了解更多信息。

我们支持RAI旅程的所有阶段

- 评估:对模型和过程进行技术和定性评估,以确定差距

- 构建:根据特定需求和机会开发和设计新模型和流程

- 验证+规模:技术模型验证和部署服务;治理与伦理变革管理

- 评估+监控:AI准备就绪,包括确认控制框架设计、内部审计培训

最新内容

- 1 month ago

- 1 month ago

- 1 month ago

- 1 month ago

- 1 month ago

- 1 month ago

- 1 month ago

- 1 month ago

- 1 month ago

- 1 month ago