category

大多数ML模型是独立训练的,没有与其他模型进行任何交互。

然而,在真实世界的ML领域中,有许多强大的学习技术依赖于模型交互来提高性能。

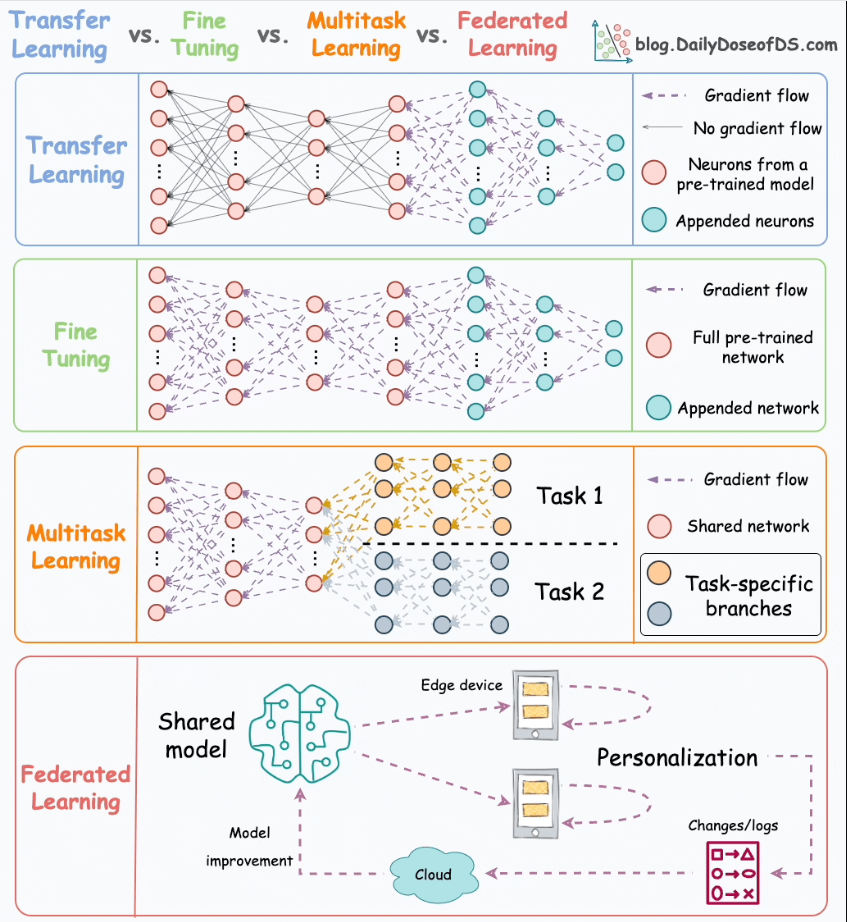

以下动画巧妙地总结了四种行之有效的培训方法:

让我们今天讨论一下。

#1) 迁移学习

这在以下情况下非常有用:

- 感兴趣的任务的数据较少。

- 但相关的任务有丰富的数据。

它是这样工作的:

- 在相关任务上训练神经网络模型(基础模型)。

- 用新图层替换基础模型上的最后几层。

- 对网络进行感兴趣的任务训练,但在反向传播过程中不要更新未经训练层的权重。

通过首先训练相关任务的模型,我们可以捕捉感兴趣任务的核心模式。

稍后,我们可以调整最后几层,以捕捉特定于任务的行为。

另一个有点类似于这些思路的想法是知识提炼,它涉及知识的“转移”。如果您有兴趣了解它,我们在这里进行了讨论。

迁移学习通常用于许多计算机视觉任务。

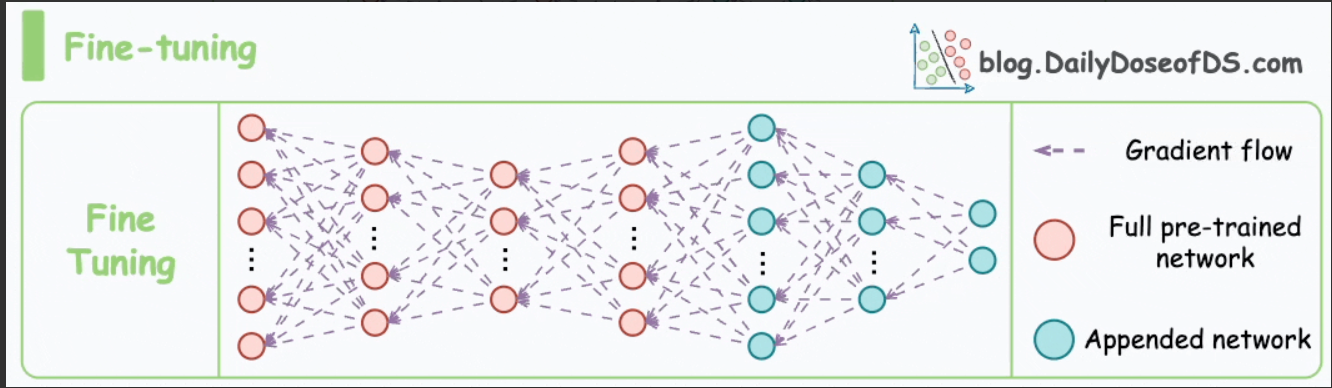

#2) 微调

微调包括更新预训练模型的一些或所有层的权重,以使其适应新任务。

这个想法可能看起来类似于迁移学习,但在微调中,我们通常不会替换预训练网络的最后几层。

相反,预训练的模型本身会根据新数据进行调整。

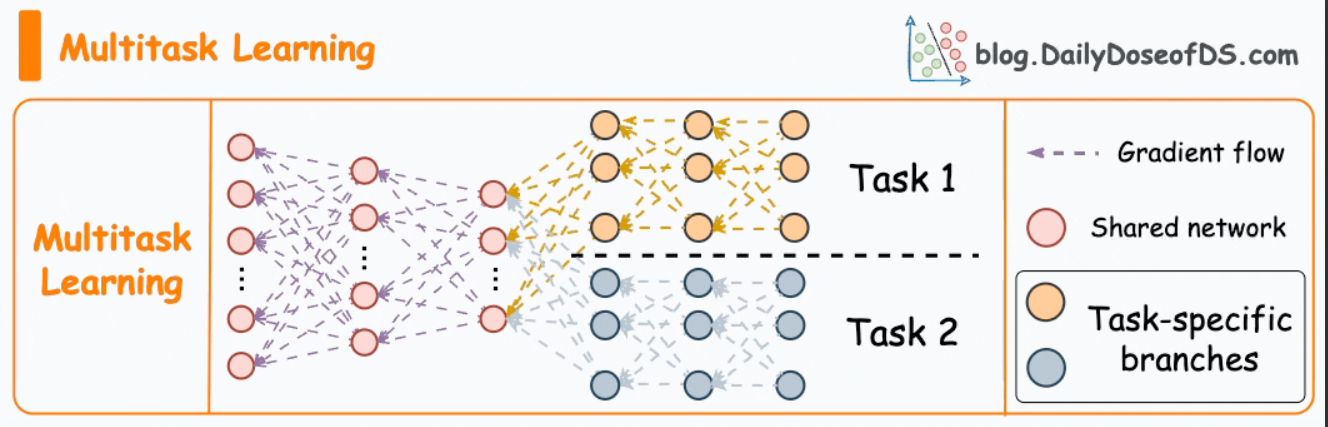

#3) 多任务学习

顾名思义,一个模型被训练为同时执行多个任务。

该模型跨任务共享知识,旨在提高每个任务的泛化能力和性能。

它可以在任务相关的场景中提供帮助,或者它们可以从共享表示中受益。

事实上,多任务学习的动机不仅仅是为了提高泛化能力。

我们还可以通过共享层和特定任务段来节省训练期间的计算能力。

- 想象一下,在相关任务上独立训练两个模型。

- 现在将其与具有共享层和特定任务分支的网络进行比较。

选项2通常会导致:

- 更好地概括所有任务。

- 存储模型权重的内存利用率较低。

- 培训期间资源利用率较低。

这是我读过的关于多任务学习的两篇最好的调查论文。

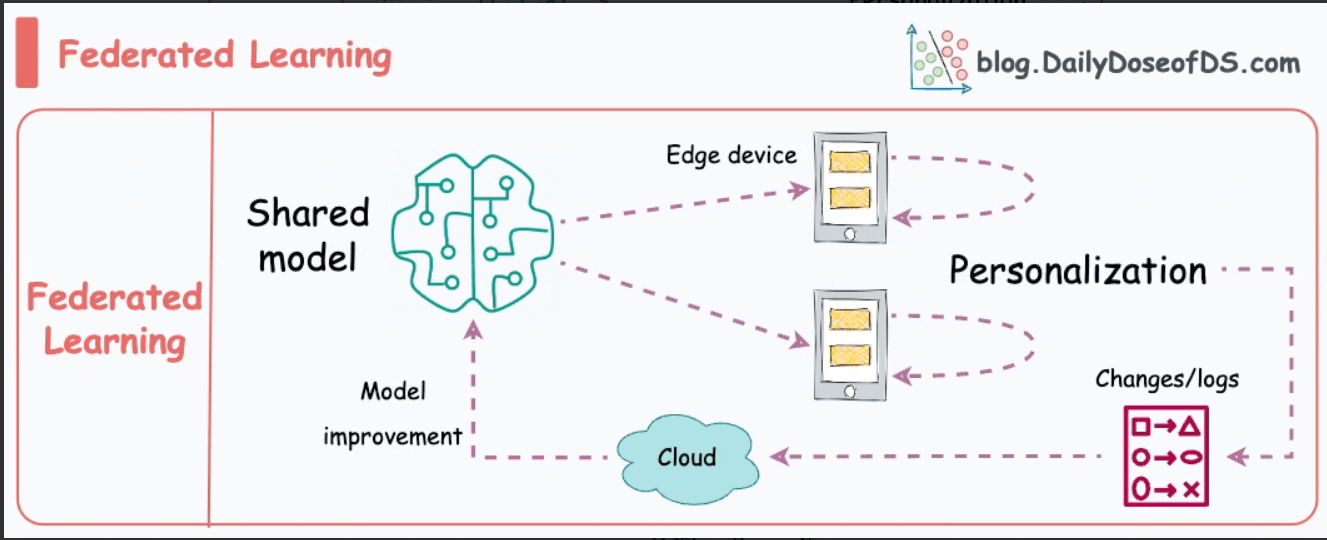

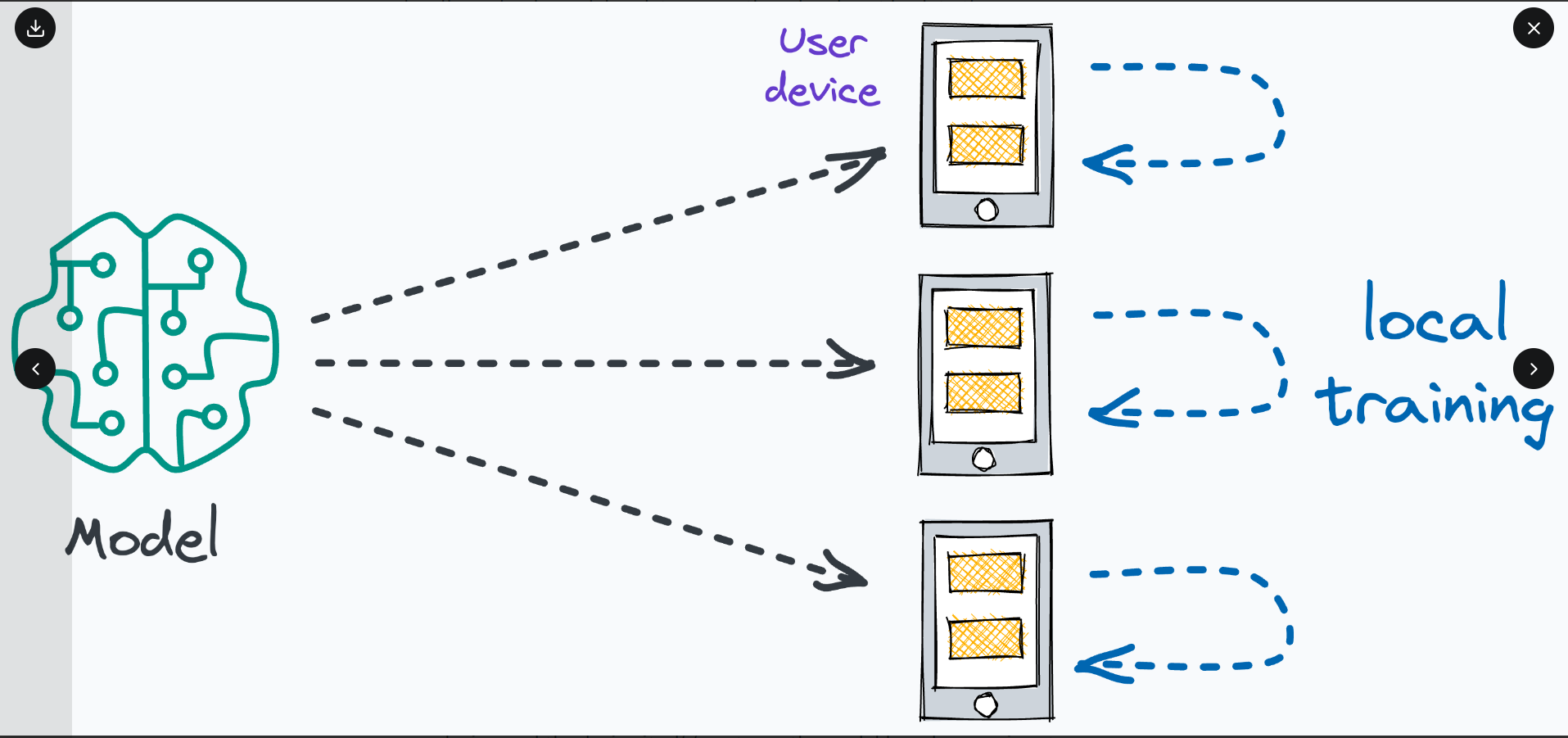

#4) 联合学习

这是训练ML模型的另一个非常酷的技术。

简单地说,联合学习是一种去中心化的机器学习方法。在这里,训练数据保留在用户的设备(例如智能手机)上。

模型不是发送数据到中央服务器,而是发送到设备,在本地进行训练,并且只收集模型更新并发送回服务器。

增强隐私和安全性尤其有用。此外,它还减少了对集中数据收集的需求。

我们智能手机的键盘就是一个很好的例子。

联合学习使我们的智能手机键盘能够学习并适应我们的打字习惯。这种情况不会将敏感的按键或个人数据传输到中央服务器。

预测我们的下一个单词或建议自动更正的模型被发送到我们的设备,设备本身根据我们的输入对模型进行微调。

随着时间的推移,该模型变得个性化,符合我们的打字风格,同时保护我们的数据隐私和安全。

请注意,由于模型是在小型设备上训练的,这也意味着这些模型必须非常轻,但功能强大,才能发挥作用。

- 登录 发表评论

- 164 次浏览

最新内容

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago