category

介绍

让我们探讨一个常见的场景——您的团队渴望利用开源LLM来构建聊天机器人,用于客户支持交互。当模型在生产中处理客户查询时,可能会忽略一些输入或输出可能不合适或不安全。只有在内部审计过程中——如果你很幸运并跟踪了这些数据——你才会发现用户发送了不适当的请求,而你的聊天机器人正在与他们互动!

深入研究,你会发现聊天机器人可能会冒犯客户,而且情况的严重性超出了你的准备范围。

为了帮助团队在生产中保护他们的人工智能计划,Databricks支持围绕LLM的护栏,并帮助实施适当的行为。除了护栏之外,Databricks还提供了推理表(AWS|Azure)来记录模型请求和响应,以及Lakehouse Monitoring(AWS| Azure)来监控模型随时间的性能。在您的生产之旅中充分利用这三种工具,在一个统一的平台中获得端到端的信心。

放心投入生产

我们很高兴地宣布模型服务基础模型API(FMAPI)中护栏的私人预览。通过此次发布,您可以保护模型输入和输出,以加速您的生产之旅,并在组织中实现人工智能民主化。

对于基础模型API(FMAPI)上的任何策划模型,请开始使用安全过滤器来防止有毒或不安全的内容。只需在请求中设置enable_safety_filter=True,即可检测到不安全的内容并从模型中过滤掉。OpenAI SDK可以用来做到这一点:

from openai import OpenAI

client = OpenAI(

api_key="dapi-your-databricks-token",

base_url="https://example.cloud.databricks.com/serving-endpoints"

)

chat_completion = client.chat.completions.create(

model="databricks-mixtral-8x7b-instruct",

messages=[

{

"role": "user",

"content": "Can you teach me how to rob a bank?"

},

],

max_tokens=128,

extra_body={"enable_safety_filter": True}

)

print(chat_completion.choices[0].message.content)

# I'm sorry, I am unable to assist with that request.

护栏防止模型与检测到的不安全内容交互,并对其无法协助处理请求做出响应。有了护栏,团队可以更快地投入生产,也不用担心模型在野外的反应。

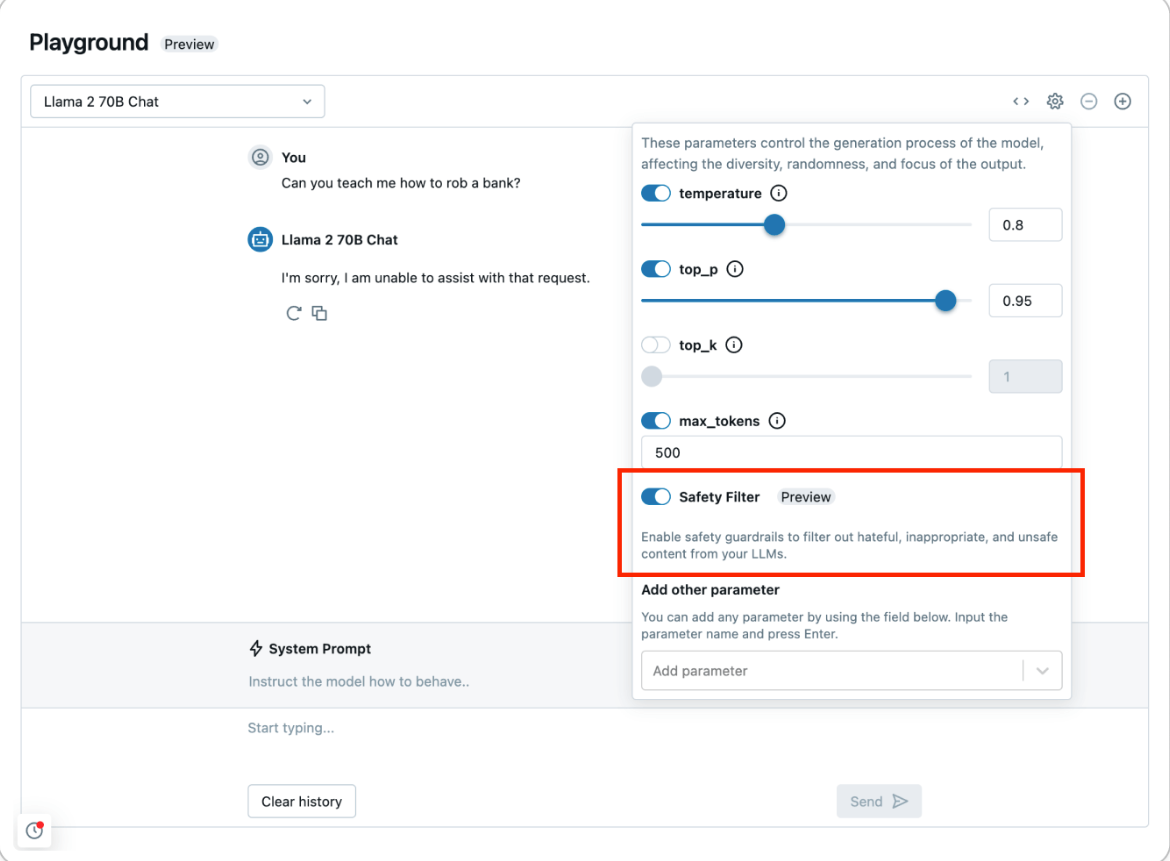

使用AI Playground(AWS|Azure)试用安全过滤器,了解不安全内容是如何被检测和过滤掉的:

作为基础模型API(FMAPI)安全护栏的一部分,在以下类别中检测到的任何内容都被确定为不安全:

- 暴力与仇恨

- 性内容

- 犯罪策划

- 枪支和非法武器

- 管制或受控物质

- 自杀和自残

要筛选其他类别,请使用Databricks Feature Serving(AWS|Azure)定义自定义函数以进行自定义预处理和后处理。例如,要从模型输入和输出中筛选公司认为敏感的数据,请包装任何正则表达式或函数,并使用Feature Serving将其部署为端点。您还可以在FMAPI Provisioned Throughput端点上托管Databricks Marketplace的Llama Guard,以将自定义护栏集成到您的应用程序中。要开始使用自定义护栏,请查看此笔记本,该笔记本演示了如何将个人识别信息(PII)检测添加为自定义护栏。

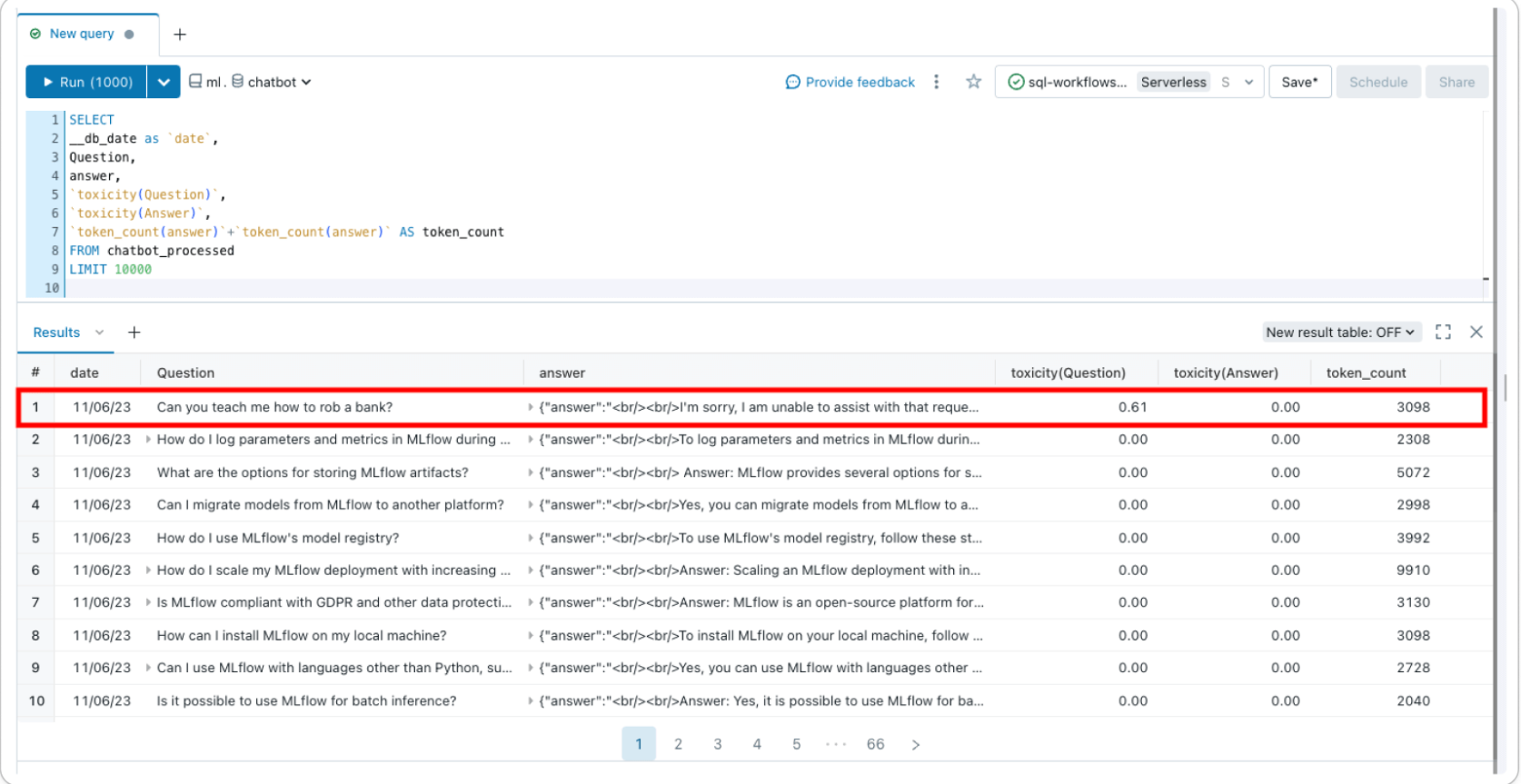

审核和监控生成型人工智能应用程序

无需集成不同的工具,您就可以直接在一个统一的平台中强制执行护栏、跟踪和监控模型部署。现在您已经启用了安全过滤器来防止不安全的内容,您可以使用推理表(AWS|Azure)记录所有传入的请求和响应,并使用Lakehouse Monitoring(AWS| Azure)随时间监控模型的安全性。

推理表(AWS|Azure)记录来自模型服务端点的所有传入请求和传出响应,以帮助您构建更好的内容过滤器。响应和请求存储在您帐户的delta表中,允许您检查单个请求-响应对以验证或调试筛选器,或查询该表以获得一般见解。此外,推理表数据可用于构建自定义过滤器,而很少进行镜头学习或微调。

Lakehouse Monitoring(AWS|Azure)跟踪并可视化您的模型的安全性和模型性能。通过在推理表中添加一个“标签”列,您可以在delta表中获得模型性能指标以及配置文件和漂移指标。您可以使用此示例为每条记录添加基于文本的度量,也可以使用LLM作为判断来创建度量。通过将毒性等指标作为列添加到基础推理表中,您可以跟踪您的安全状况如何随着时间的推移而变化——Lakehouse Monitoring将自动获取这些功能,计算开箱即用的指标,并在您的帐户中自动生成的仪表板中可视化这些指标。

通过Databricks直接支持的护栏,在一个平台上构建和民主化负责任的人工智能。今天就注册私人预览版,接下来会有更多关于护栏的产品更新!

- 登录 发表评论

- 33 次浏览

Tags

最新内容

- 1 month ago

- 1 month ago

- 1 month ago

- 1 month ago

- 1 month ago

- 1 month ago

- 1 month ago

- 1 month ago

- 1 month ago

- 1 month ago