category

1位LLM是高效的,并且适合于资源受限的平台。

摘要

2023年推出的BitNet模型开创了1位LLM的时代。该模型标志着从传统的高精度、计算成本高昂的LLM向低精度、低成本的LLM的重大转变。BitNet b1.58是基于BitNet的一种新的1位LLM变体,该模型将每个权重限制为三个可能的值:-1、0或1。BitNet b1.58模型可以在使用相同的模型大小和训练数据的情况下匹配全精度(FP16或BF16)LLM的性能(困惑和最终任务结果)。此外,与传统LLM相比,BitNet b1.58显著降低了延迟、内存使用和能耗。

介绍

全精度LLM的问题

大型语言模型(LLM)在自然语言处理方面取得了令人难以置信的进展,但这是随着模型大小的不断增加而来的。LLM的大小给实际部署带来了问题。这些模型计算成本高,能耗高,并且占用大量内存。

量化是次优解

训练后量化是一种用于使LLM更小、更高效地进行推理(模型的实际使用)的技术。它通过降低用于表示权重和激活的数字的精度来压缩模型。典型的减少是从16位表示减少到4位或更低。低位模型使用更少的内存,计算速度更快,使用起来更实用。尽管培训后量化在行业中很受欢迎,但它并不是完美的解决方案。压缩模型的过程有时会影响其性能。

解决方案是1位LLM

BitNet等1位模型体系结构为降低LLM的成本同时保持其性能提供了一个很有前途的方向。BitNet 1.58b基于BitNet架构,并将其权重限制为-1、0或1。最初的BitNet架构只使用-1和1,而BitNet 1.58b除了使用-1和1。包含“0”允许在模型中进行功能筛选。这意味着它可以选择性地忽略某些功能,与纯1位LLM相比,提高了性能。

BitNet 1.58b架构

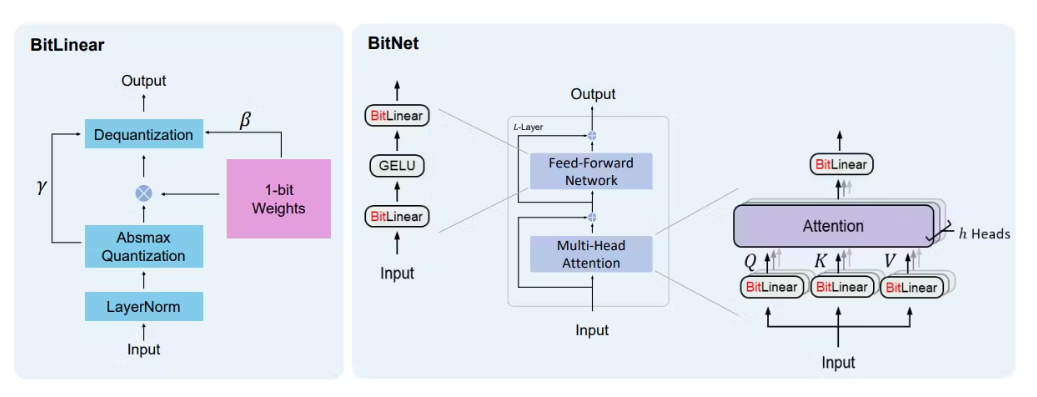

BitNet b1.58基于BitNet架构。BitNet是一个取代nn的1位转换器。线性与BitLinear。

与最初的BitNet相比,BitNet b1.58 LLM引入了以下修改

三元零-与纯1位模型不同,BitNet b1.58使用值为-1、0和1的三元权重系统。关键的创新是将“0”作为一个可能的值。包含“0”允许在模型中进行功能筛选,并使BitNet b1.58与BitNet相比更强大。

LLaMA相似组件-LLaMA的体系结构实际上是开源LLM的支柱。为了拥抱开源社区,BitNet b1.58采用了类似LLaMA的组件。具体来说,它使用RMSNorm、SwiGLU、旋转嵌入,并消除所有偏差。

实验结果

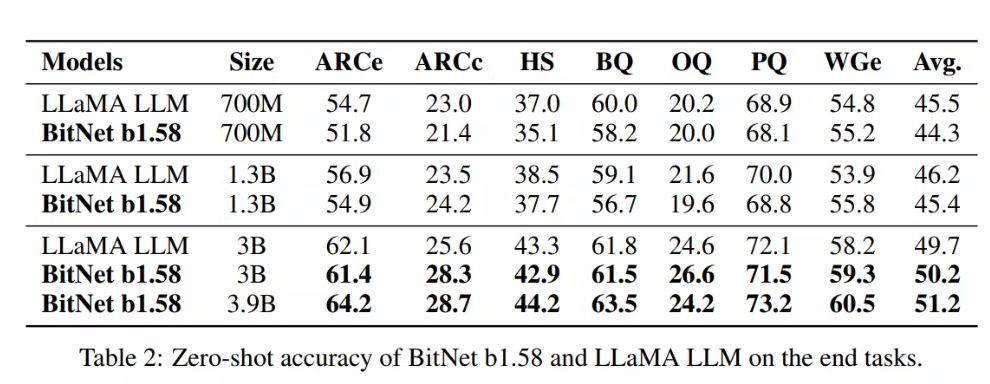

最终任务性能–BitNet 1.58b在大部分任务中与Llama LLM的性能相匹配,平均而言实现了更好的性能。

内存和延迟-与LLaMA LLM相比,BitNet b1.58 70B是4.1倍,所需GPU内存减少7.16倍。

能耗-BitNet b1.58包括INT8加法计算,而LLaMA LLM包括两个FP16加法。因此,与LLaMA LLM相比,BitNet b1.58更节能。

吞吐量-BitNet b1.58 70B最多可支持11倍于LLaMA LLM的批处理大小,从而使吞吐量提高8.9倍。

总结

1位LLM解决了LLM的大内存和高延迟要求。此外,像BitNet 1.58b这样的1位LLM与全精度LLM的性能相匹配。1位LLM的发展大大减少了内存和延迟,使其能够部署在边缘和移动设备上。

- 登录 发表评论

- 45 次浏览

最新内容

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago