目录

- 什么是ML测试?

- ML测试的类型

- ML模型的评估度量

- 如何测试机器学习模型?

- ML测试中的伦理考量

- ML测试的工具和框架

-

结论

从让我们的生活更轻松的智能助手到检测医疗状况的复杂算法,机器学习技术的应用引人注目。然而,随着我们越来越依赖这些算法,一个问题出现了:我们如何才能信任它们?

与遵循明确指令的传统软件不同,ML算法从数据中学习,绘制模式并做出决策。这种学习模式虽然高度智能,但也带来了复杂性。如果传统软件出现故障,通常是由于编码错误——一个逻辑错误。但是,当ML模型失败时,可能是由于各种原因:

- •培训数据存在偏差

- •过拟合错误

- •不可预见的变量整合

由于ML模型涉及审批贷款、驾驶自动驾驶汽车或诊断患者等关键决策,因此可能会出现错误。这就是为什么ML测试是每个业务都需要实现的关键过程。它确保ML模型以负责任、准确和合乎道德的方式运行。

什么是ML测试?

机器学习测试是评估和验证机器学习模型性能的过程,以确保其正确性、准确性和稳健性。与主要关注代码功能的传统软件测试不同,ML测试由于ML模型的固有复杂性而包括额外的层。它确保ML模型按预期运行,提供可靠的结果并遵守行业标准。

ML测试的重要性

保持模型准确性

ML模型是根据历史数据进行训练的,其准确性在很大程度上取决于这些数据的质量和相关性。ML模型测试有助于识别预测结果和实际结果之间的错误,使开发人员能够微调模型并提高其准确性。

防止偏差

ML模型中的偏见可能导致不公平或歧视性的结果。彻底的测试可以揭示数据和算法中的偏见,使开发人员能够解决这些问题并创建更公平的模型。

适应不断变化的数据

真实世界的数据在不断演变。ML测试确保模型在引入新数据时保持有效,并随着时间的推移保持其预测能力。

提高可靠性

稳健的测试程序增强了ML系统的可靠性,增强了对其性能的信心,并降低了意外故障的风险。

ML测试的类型

让我们研究一下各种类型的ML测试,每种测试都旨在解决模型性能的特定方面,同时保持简单易懂

组件的单元测试

与传统的软件测试一样,ML中的单元测试侧重于测试ML管道的各个组件。它涉及评估每个步骤的正确性,从数据预处理到特征提取、模型架构和超参数。确保每个构建块按预期运行有助于提高模型的整体可靠性。

数据测试和预处理

输入数据的质量影响ML模型的性能。数据测试包括验证数据的完整性、准确性和一致性。此步骤还包括预处理测试,以确保正确执行数据转换、规范化和清理过程。干净可靠的数据可以带来准确的预测。

交叉验证

交叉验证是一种强大的技术,用于评估ML模型对新的、看不见的数据的泛化能力。它包括将数据集划分为多个子集,在不同的子集上训练模型,并在剩余数据上测试其性能。交叉验证通过重复此过程并对结果求平均值,深入了解模型在不同输入上的潜在性能。

性能指标测试

选择适当的性能指标对于评估模型性能至关重要。准确性、准确度、召回率和F1分数等指标提供了模型运行情况的定量衡量标准。测试这些指标可以确保模型按照预期目标交付结果。

稳健性和对抗性测试

鲁棒性测试包括评估模型处理意外输入或对抗性攻击的能力。对抗性测试在暴露于故意修改的输入以混淆模型时,会明确评估模型的行为。稳健模型在具有挑战性的条件下不太可能做出错误预测。

A/B部署测试

一旦模型准备好进行部署,就可以使用a/B测试。它包括将新的ML模型与现有模型一起部署,并在现实世界中比较它们的性能。A/B测试有助于确保新模型不会引入意外问题,并且性能至少与当前解决方案一样好。

偏差测试

ML模型中的偏见可能导致不公平或歧视性的结果。为了解决这一问题,偏差和公平性测试旨在识别和减轻数据和ML模型预测中的偏差。它确保该模型公平对待所有个人和群体。

ML模型的评估度量

必须依靠评估指标来衡量这些模型的性能和有效性。这些指标为ML模型的性能提供了有价值的见解,有助于对其进行微调和优化,以获得更好的结果。让我们来看看其中的一些指标

精确(Accuracy)

准确性是最直接的衡量标准,衡量正确预测的实例与数据集中总实例的比率。它提供了模型正确性的总体视图。然而,在处理不平衡的数据集时,它可能不是最好的选择,因为其中一个类占另一个类的主导地位。

精确(Precision)

精度关注的是模型做出的积极预测的准确性。它是准确的阳性预测与真阳性和假阳性之和的比率。当假阳性代价高昂或不受欢迎时,精确性是有价值的。

敏感性(Sensitivity)

敏感性,或真阳性率,评估模型捕捉所有阳性实例的能力。它是真阳性与真阳性和假阴性之和的比率。当假阴性的后果显著时,回忆是至关重要的。

特异性(Specificity)

特异性,也称为真负率,评估模型正确识别负实例的能力。这是真阴性与真阴性和假阳性之和的比率。当关注负面预测的表现时,具体性是有价值的。

ROC曲线下面积(AUC-ROC)

AUC-ROC度量有助于解决二进制分类问题。它绘制了真阳性率与假阳性率的关系图,直观地表示了模型区分类别的能力。AUC-ROC值接近1表示模型性能更好。

平均绝对误差

超越分类,MAE是回归任务中使用的度量。它测量预测值和实际值之间的平均绝对差。它让我们知道我们的预测与现实有多远。

均方根误差

与MAE一样,RMSE是一种回归度量,专注于预测值和实际值之间的平均平方差的平方根。它比较小的错误惩罚更大的错误。

ML模型的评估度量

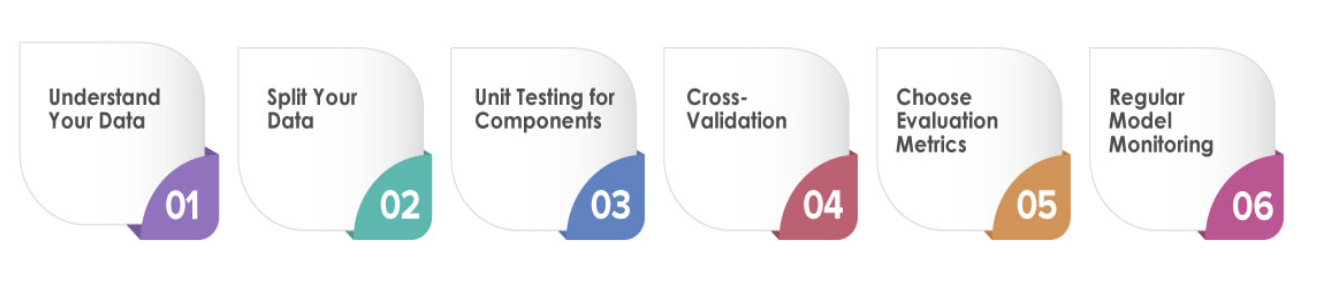

测试ML模型涉及到针对其独特复杂性量身定制的特定策略。让我们看看如何有效地测试机器学习模型,提供可操作的步骤来提高其性能:

了解您的数据

在开始测试之前,深入了解数据集是至关重要的。探索其特点、分布和潜在挑战。这些知识将帮助您设计有效的测试场景并识别潜在的陷阱。

拆分数据

将数据集划分为训练集、验证集和测试集。训练集用于训练模型,验证集帮助微调超参数,测试集评估模型的最终性能。

组件的单元测试

首先测试ML管道的各个组件。这包括检查数据预处理步骤、特征提取方法和模型架构。在将每个组件集成到整个管道中之前,验证它们是否按预期工作。

交叉验证

利用交叉验证来评估模型的泛化能力。应用K-fold交叉验证等技术,将数据集划分为K个子集,对模型进行K次训练和评估,每次使用不同的子集进行验证。

选择评估指标

根据问题的性质选择适当的评估指标。对于分类任务,精确性、准确性、召回率和F1分数是标准的。回归任务通常使用MAE或RMSE等指标。

定期模型监测

由于数据分布的变化或其他因素,机器学习模型可能会随着时间的推移而退化。定期监控已部署的模型,并定期对其进行重新测试,以确保其保持准确性和可靠性。

ML测试中的伦理考量

通过严格的测试和完善ML模型,考虑可能出现的道德影响至关重要。让我们探讨有关ML测试的道德考虑、潜在陷阱以及如何确保测试实践符合道德规则

数据隐私和安全

在测试ML模型时,必须极其小心地处理数据。确保对敏感和个人身份信息进行适当加密,以保护个人隐私。道德测试尊重数据主体的权利,并保护其免受潜在的数据泄露。

公平与偏见

在测试ML模型时,检查他们是否表现出对某些群体的偏见是至关重要的。可以使用工具和技术来衡量和减轻偏见,确保我们的模型公平、公正地对待所有个人。

透明度和可解释性

ML模型可能很复杂,使其决策难以理解。道德测试包括评估模型的透明度和可解释性。用户和利益相关者应该了解模型是如何实现预测的,从而培养信任和问责制。

责任和责任(Accountability and Liability)

如果ML模型做出了有害或错误的预测,谁负责?道德ML测试应解决责任和责任问题。制定明确的指导方针,确定对示范成果负责的各方,并实施机制纠正任何负面影响。

以人为本的设计

ML模型与人类相互作用,因此它们的测试应该反映以人为本的设计原则。在评估模型性能时,考虑最终用户的需求、期望和潜在影响。这种方法确保模型能够增强而不是破坏人类体验。

同意和数据使用

测试通常涉及使用真实世界的数据,其中可能包括个人信息。获得其数据用于测试目的的个人的适当同意。对数据使用保持透明,并确保遵守数据保护法规。

长期影响

ML模型是为进化而设计的。道德测试应考虑模型部署的长期影响,包括随着数据分布的变化,模型可能会如何运行。定期测试和监控可确保模型在其整个生命周期中保持准确和合乎道德。

协作监督

ML测试中的道德考虑不应仅限于开发人员。让不同的利益相关者参与进来,包括伦理学家、法律专家和受影响社区的代表,对潜在的道德挑战提供全面的视角。

ML测试的工具和框架

各种ML测试工具和框架可用于简化和增强测试过程。让我们来看看一些工具和框架,它们可以帮助您有效地驾驭ML测试的复杂性

TensorFlow

TensorFlow由谷歌开发,是最流行的ML测试开源框架之一。它提供了一系列用于构建和测试ML模型的工具。TensorFlow强大的生态系统包括用于生产管道测试的TensorFlow Extended(TFX)、用于机器学习中测试数据的TensorFlow Data Validation,以及用于深入模型评估的TensorFlowModel Analysis。

PyTorch

PyTorch是另一个广泛使用的开源ML框架,以其动态计算图和易用性而闻名。PyTorch提供了用于模型评估、调试和可视化的工具。例如,“torchvision”软件包提供了各种数据集和转换,用于测试和验证计算机视觉模型。

Scikit学习

Scikit-learn是一个通用的Python库,提供数据挖掘、分析和机器学习工具。它包括用于模型评估的各种算法和度量,例如用于超参数调整的交叉验证和网格搜索。

Fairlearn

Fairlearn是一个工具包,旨在评估和缓解ML模型中的公平性和偏见问题。它包括重新加权数据和调整预测以实现公平的算法。Fairlearn可以帮助您测试和解决ML模型中的道德问题。

结论

测试机器学习模型是一个系统和迭代的过程,可以确保您的模型准确可靠地运行。遵循本指南,您可以识别和解决潜在问题,优化性能,并提供符合最高标准的人工智能解决方案。请记住,测试不是一次性事件。这是一个持续的过程,在机器学习模型的整个生命周期中保护其有效性。

最新内容

- 1 month 1 week ago

- 1 month 1 week ago

- 1 month 1 week ago

- 1 month 1 week ago

- 1 month 1 week ago

- 1 month 1 week ago

- 1 month 1 week ago

- 1 month 1 week ago

- 1 month 1 week ago

- 1 month 1 week ago