category

在全球范围内,企业正在意识到生成人工智能模型的好处。他们正竞相在各种应用程序中采用这些模型,如聊天机器人、虚拟助理、编码副驾驶员等。

虽然通用模型适用于简单的任务,但在满足各个行业的独特需求方面表现不佳。定制生成的人工智能模型优于普通人工智能模型,并通过整合特定领域的知识、理解当地文化的细微差别以及与品牌声音和价值观保持一致来满足企业要求。

NVIDIA NeMo团队宣布了NVIDIA NeMo Curator、NVIDIA NeMo Customizer和NVIDIA Nelo Evaluator微服务的早期访问计划。这些微服务涵盖了从数据管理、定制到评估的所有开发阶段,简化了用户构建自定义生成人工智能模型的过程。

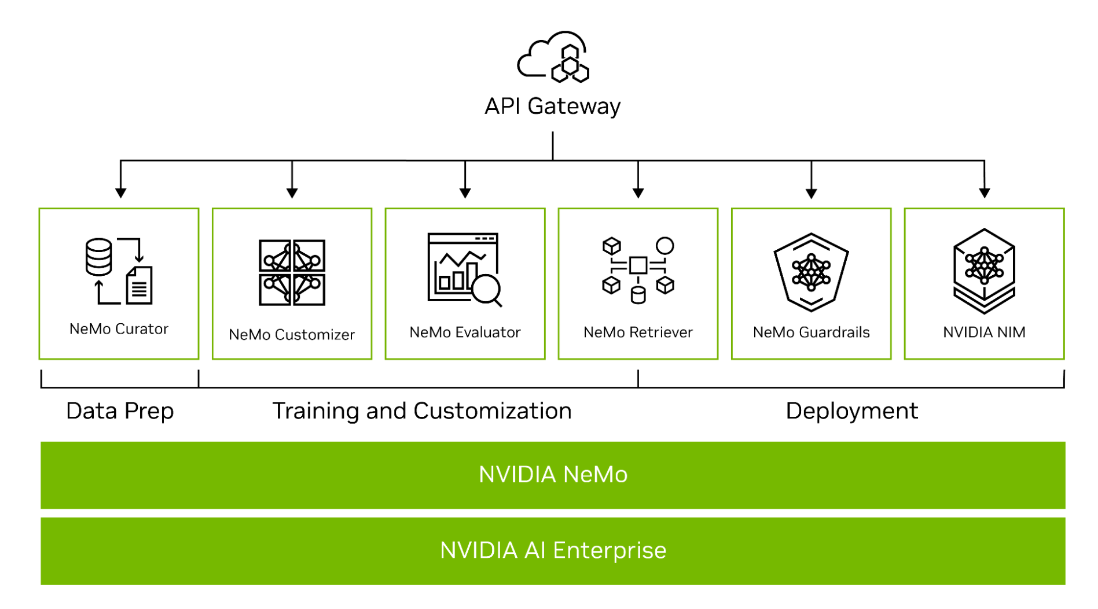

NVIDIA NeMo是一个端到端平台,可在任何地方开发自定义生成人工智能。它包括用于训练、微调、检索增强生成、防护、数据管理和预训练模型的工具。它提供了跨技术堆栈的产品,从框架到高级API端点(图1)。

Figure 1. NVIDIA NeMo end-to-end platform offerings for developing custom generative AI

作为NVIDIA CUDA-X微服务的一部分,NeMo API端点构建在NVIDIA库的基础上,为企业构建自定义生成人工智能提供了一条简单的途径。

为自定义生成人工智能开发微服务

在早期访问程序中,开发人员可以请求访问NeMo Curator、NeMo Customizer和NeMo Evaluator微服务。这些微服务共同使企业能够构建企业级定制生成人工智能,并更快地将解决方案推向市场。

NeMo Curator微服务帮助开发人员管理用于预训练和微调LLM的数据,而NeMo Customizer则可以实现微调和对齐。最后,使用NeMo Evaluator,开发人员可以根据学术或自定义基准评估这些模型,并确定需要改进的领域。

下面将详细介绍这些微服务。

NeMo Curator

NeMo Curator是一个可扩展的GPU加速数据管理微服务,为预训练和定制生成人工智能模型准备高质量的数据集。Curator简化了数据管理任务,如数据下载、文本提取、清洁、质量过滤、精确/模糊重复数据消除和多语言下游任务净化。

策展人支持以下内容:

- 微调技术,如监督微调(SFT)、P调谐和低秩自适应(LoRA)。

- 一个更快的数据注释管道,支持不同类型的元数据分类器,包括:

- 适用于医疗保健、法律等各个领域的领域分类器。开发人员可以使用最相关的数据进行特定领域的定制,用于模型开发、数据混合和丰富原始数据

- 个人可识别信息(PII)检测,以大规模编辑或删除训练数据中的PII信息,并遵守数据隐私。

- 毒性过滤器(Toxicity filter),通过定义的自定义过滤器和类别识别和删除无关和毒性数据

NeMo Customizer

NeMo Customizer是一种高性能、可扩展的微服务,可简化特定领域用例LLM的微调和调整。微服务最初支持两种流行的参数有效微调(PEFT)技术:LoRA和p微调。

此外,NeMo Customizer微服务将在未来增加对完全对齐技术的支持:

- SFT

- 从人类反馈中强化学习(RLHF)

- 直接偏好优化(DPO)

- NVIDIA NeMo SteerLM

NeMo Customizer微服务支持Kubernetes访问类似NFS的文件系统和火山调度程序进行部署。这实现了批量调度功能,这通常是LLM的高性能多节点微调所必需的。

NeMo评估器

为特定任务定制LLM可能会导致灾难性的遗忘,这是一个模型忘记先前学习的任务的问题。使用LLM的企业必须评估原始任务和新任务的性能,不断优化模型以改善体验。NeMo Evaluator在任何云或数据中心的不同学术和自定义基准上提供自定义生成人工智能模型的自动评估。

它支持通过选定的学术基准集合进行自动评估,包括超越模仿游戏基准【beyond the imitation game benchmark】(BIG Bench)、多语言【Multilingual】、BigCode评估工具【BigCode Evaluation Harness】和毒性【Toxicity】。

NeMo Evaluator支持在自定义数据集上进行评估,提供了准确性【accuracy】、面向召回的注册评估【recall-oriented understudy for gisting evaluation 】(ROUGE)、F1和精确匹配等指标【exact match】。

它还允许使用LLM作为一个法官【LLM-as-a-judge】来全面评估模型响应。它可以利用NVIDIA API目录中提供的任何NVIDIA NIM支持的LLM来评估MT-Bench数据集上的模型响应。

轻松构建自定义生成AI

NeMo微服务提供了NeMo平台的全部优势,如加速的性能和可扩展性。开发人员可以通过利用并行技术并在需要时扩展到多GPU和多节点来获得更快的训练性能。

微服务还为企业提供了好处,例如能够在其首选的基础设施上运行,从预处理到云,使他们能够控制数据安全,避免供应商锁定,并降低成本。

无论开发堆栈中的特定选择如何,微服务都提供了适应性和兼容性。它们可以很容易地作为API集成到当前的工作流程中,而无需考虑所使用的特定技术。

Related resources

- GTC session: A New Class of Cloud-Native Applications at the Far Edge With Generative AI

- GTC session: Customizing Generative AI with Your Own AI Foundry

- GTC session: Enhancing the Digital Human Experience with Cloud Microservices Accelerated by Generative AI

- SDK: NeMo LLM Service

- SDK: NeMo Inferencing Microservice

- SDK: NeMo Retriever

- 登录 发表评论

- 41 次浏览

Tags

最新内容

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago