category

语言模型是可以生成自然人类语言的人工智能计算模型。这可不容易。

这些模型被训练成概率机器学习模型——预测适合在短语序列中生成的单词的概率分布,试图模拟人类智能。语言模型在科学领域的重点有两个:

- 理解智力的本质。

- 并以与真实人类进行有意义的智能交流的形式体现这一本质。

在展示人类智能方面,当今自然语言处理(NLP)领域的前沿AI模型还没有完全通过图灵测试。(如果无法辨别通信是来自人类还是计算机,则机器通过图灵测试。)

特别有趣的是,我们正非常接近这一标志:当然是大肆宣传的大型语言模型(LLM)和有前景但不那么大肆宣传的SLM。(SLM可以代表小语言模型或短语言模型。)

小型语言模型与大型语言模型

如果你追随了炒作,那么你可能对ChatGPT等LLM很熟悉。这些生成性人工智能在学术、工业和消费领域都非常有趣。这主要是因为它们能够以语音交流的形式进行相对复杂的交互。

目前,LLM工具正被用作互联网上可用知识的智能机器接口。LLM在互联网上提取相关信息,并将其用于训练,为用户提供简洁易用的知识。这是在互联网上搜索查询、浏览数千个网页并得出简洁而结论性答案的另一种选择。

事实上,ChatGPT是LLM的第一个面向消费者的用例,以前LLM仅限于OpenAI的GPT和谷歌的BERT技术。

最近的迭代,包括但不限于ChatGPT,已经在编程脚本上进行了训练和设计。开发人员使用ChatGPT编写完整的程序函数——假设他们可以通过文本用户提示充分指定要求和限制。

(担心LLM的安全性?了解如何防御OWASP LLM Top 10。)

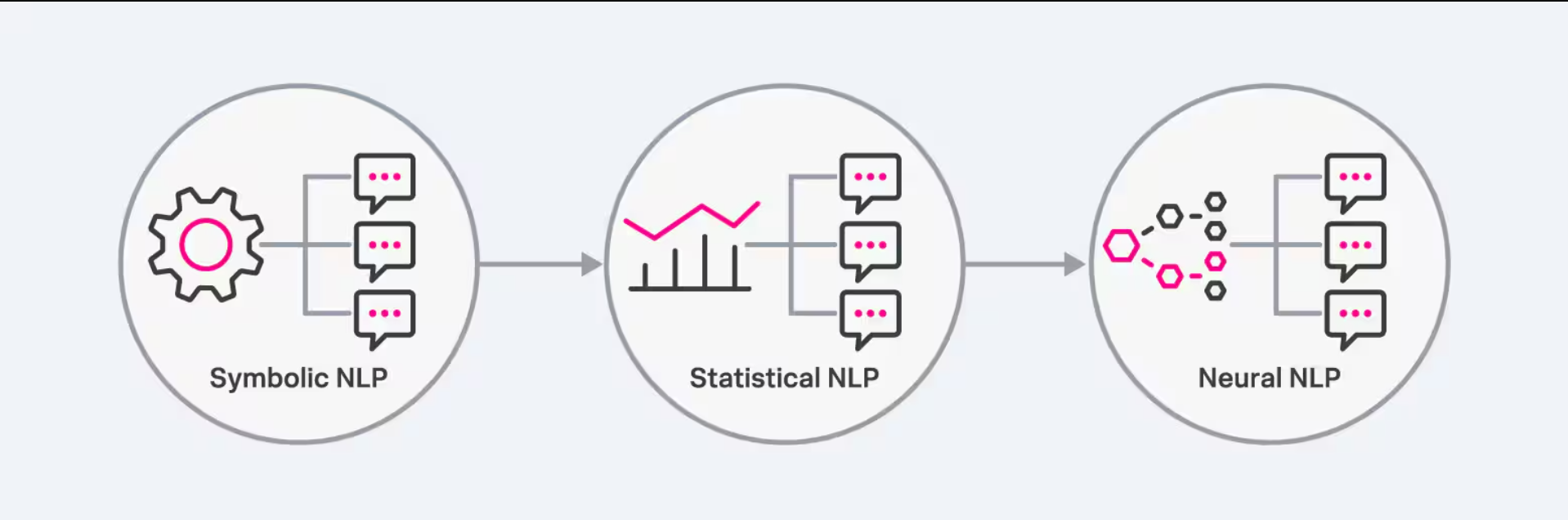

NLP模型的三种主要类型包括符号NLP、统计NLP和神经NLP。

LLMs如何工作

那么,大型语言模型是如何工作的呢?让我们回顾一下使用LLM生成自然语言的关键步骤。

步骤1。通用概率机器学习

这个想法是开发一个具有参数的数学模型,这些参数可以以最高的概率表示真实的预测。

在语言模型的背景下,这些预测是自然语言数据的分布。目标是使用学习到的自然语言概率分布,根据可用的上下文知识(包括用户提示查询)生成最有可能出现的短语序列。

步骤2。建筑变革与自我关注

为了学习单词和连续短语之间的复杂关系,ChatGPT和BERT等现代语言模型依赖于所谓的基于Transformers的深度学习架构。Transformer的总体思路是在进行序列预测时,将文本转换为根据重要性加权的数值表示。

步骤3。预训练和微调

语言模型在特定的任务域上进行了大量的微调和工程设计。工程语言模型的另一个重要用例是消除对仇恨言论和歧视等不必要的语言结果的偏见。

该过程涉及通过以下方式调整模型参数:

- 对模型进行领域特定知识的训练。

- 基于预训练数据初始化模型参数。

- 监控模型性能。

- 进一步调整模型超参数。

LLM和SLM之间的区别

SLM和LLM在架构设计、训练、数据生成和模型评估方面都遵循了类似的概率机器学习概念。

现在,让我们讨论一下SLM和LLM技术的区别。

尺寸和模型复杂性

SLM和LLM之间最明显的区别可能是模型大小。

- 据称,诸如ChatGPT(GPT-4)之类的LLM包含1.76万亿个参数。

- Mistral 7B等开源SLM可以包含70亿个模型参数。

差异归结为模型架构中的训练过程。ChatGPT在编码器-解码器模型方案中使用自注意机制,而Mistral 7B使用滑动窗口注意,允许在仅解码器模型中进行高效训练。

上下文理解和领域特异性

SLM基于特定领域的数据进行训练。他们可能缺乏来自所有多个知识领域的整体上下文信息,但很可能在所选领域表现出色。

另一方面,法学硕士的目标是在更广泛的层面上模仿人类智能。它在更大的数据源上进行了训练,与特定领域的SLM相比,预计在所有领域都表现良好。

这意味着LLM也更通用,可以进行调整、改进和设计,以更好地完成编程等下游任务。

资源消耗

训练LLM是一个资源密集型过程,需要大规模的云中GPU计算资源。从头开始训练ChatGPT需要数千个GPU进行训练,而Mistral 7B SLM可以在具有体面GPU的本地机器上运行——训练7B参数模型仍然需要在多个GPU上花费几个计算小时。

偏见

法学硕士往往有偏见。这是因为它们没有得到充分的微调,而且它们是在互联网上公开访问和发布的原始数据上进行训练的。由于训练数据的来源,训练数据可能…

- 低估或歪曲某些群体或思想

- 被错误地贴上标签。

其他地方出现了进一步的复杂性:语言本身引入了自己的偏见,这取决于方言、地理位置和语法规则等各种因素。另一个常见的问题是,模型架构本身可能会无意中强加一种偏见,而这种偏见可能会被忽视。

由于SLM在相对较小的领域特定数据集上训练,与LLM相比,偏差的风险自然较低。

推理速度

SLM的较小模型大小意味着用户可以在本地计算机上运行模型,并且仍然可以在可接受的时间内生成数据。

LLM需要多个并行处理单元来生成数据。根据访问LLM的并发用户数量,模型推理往往会减慢。

那么,法学硕士是所有事情的正确选择吗?

这个问题的答案完全取决于你的语言模型的用例和你可用的资源。在商业环境中,LLM可能更适合作为呼叫中心和客户支持团队的聊天代理。

在大多数特定功能的用例中,SLM可能会表现出色。

考虑医疗、法律和金融领域的用例。这里的每个应用程序都需要高度专业化和专有的知识。利用这些知识对SLM进行内部培训,并针对内部使用进行微调,可以作为高度监管和专业化行业中特定领域用例的智能代理。

- 登录 发表评论

- 263 次浏览

最新内容

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago