对未来人工智能生态系统的预测

在过去的10年里,人工智能不断进步,每一次新的发展浪潮都能带来令人兴奋的新功能和应用。毫无疑问,最大的这一波浪潮是最近兴起的一种单一的通用人工智能模型,例如LLM,它可以用于从代码生成到图像理解再到科学推理的各种任务。

这些任务是以如此高保真的方式执行的,以至于正在定义和开发全新一代的技术应用程序。虽然考虑到潜在的影响令人兴奋,但这一失控的成功确实给我们留下了一个关于未来人工智能生态系统的令人深感不安的问题:

未来的人工智能格局会由单一的通用人工智能模型主导吗?

具体而言,未来的人工智能格局是否会:

- 由少数(<5)个实体主导,每个实体都有一个大型通用人工智能模型?

- 这些通用人工智能模型是否是推动所有重大人工智能技术进步和产品的关键组成部分?

随着ChatGPT和GPT-4等模型的发布,改变了我们对人工智能功能的理解,以及开发此类模型的成本不断上升,这已成为一种普遍的看法。

我们认为恰恰相反!

- 将会有许多实体为人工智能生态系统的发展做出贡献。

- 许多高效用的人工智能系统将出现,不同于(单一的)通用人工智能模型。

- 这些人工智能系统将结构复杂,由多个人工智能模型、API等提供动力,并将推动新的人工智能技术发展。

- 定义明确、高价值的工作流程将主要由专门的人工智能系统解决,而不是通用的人工智能模型。

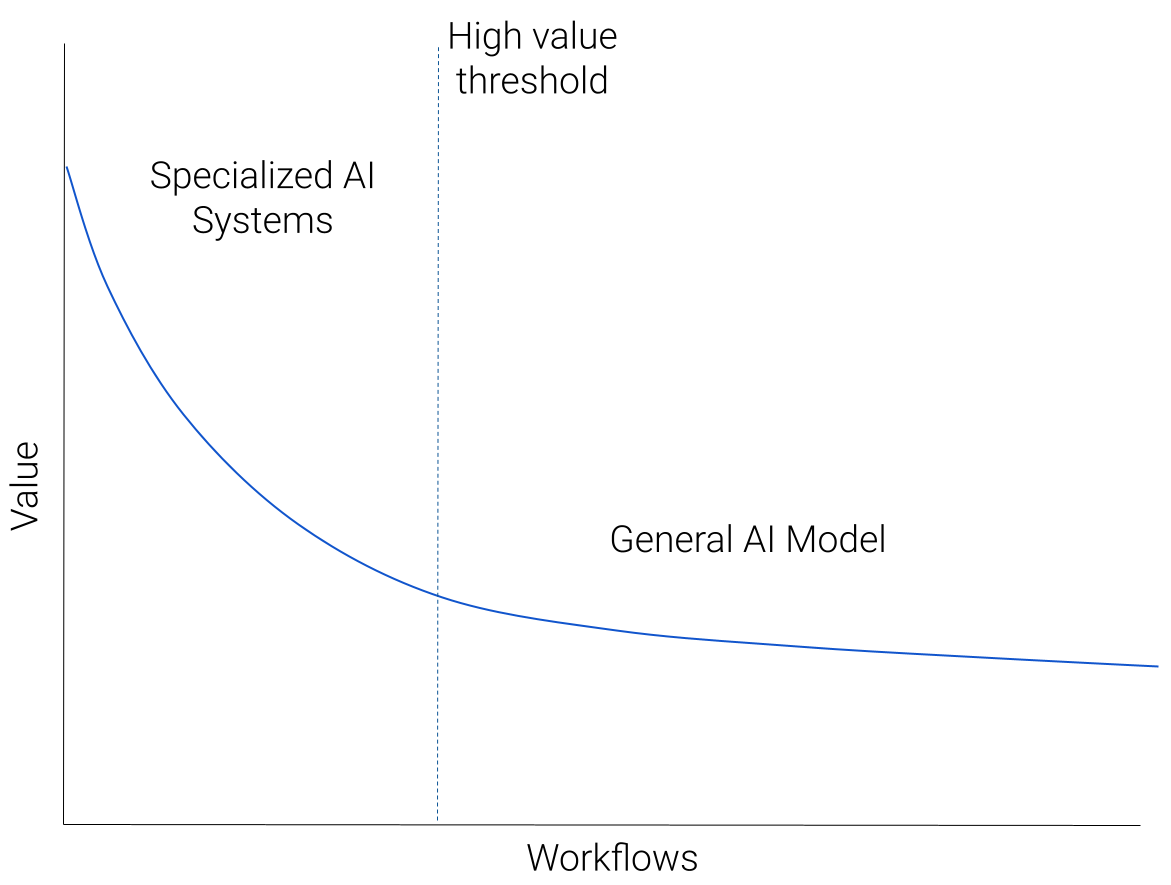

我们可以用下图来说明我们对人工智能生态系统的预测:

想象一下,我们采用了所有适用于基于人工智能的解决方案的工作流程,并按照“价值”的递减顺序绘制它们。价值可以是潜在的收入,也可以只是对用户的效用。将会有少量非常高价值的工作流-一个大市场或大量用户有明确定义的人工智能可解决的痛点。这将下降到一个由各种但价值较低的工作流组成的长长的、沉重的尾巴,代表人工智能可以帮助的许多自定义预测任务。

高价值工作流程的例子有哪些?现在还为时过早,但我们看到了编码助理、视觉内容创建、搜索和写作助理方面令人兴奋的发展。

低价值工作流程的沉重尾巴呢?这些将不那么明确地规定,由习俗环境引起的习俗需求。例如,通过分类对来自客户支持机器人的请求进行分类。

我们预测,图表的左上角(高价值工作流)将由专门的人工智能系统主导,随着我们沿着蓝色曲线向下到低价值工作流,通用人工智能模型将成为主要方法。

起初,这张照片看起来有些违反直觉。一些最先进的人工智能功能似乎来自通用模型。那么,为什么这些不应该主导高价值的工作流程呢?但是,考虑到生态系统可能如何演变,有许多重要因素支持这一观点,我们将在下面对此进行扩展。

专业化对质量至关重要

高价值的工作流程需要高质量,并奖励任何质量改进。任何应用于高价值工作流程的人工智能解决方案都会不断进行调整,以提高质量。由于工作流程特定的考虑因素导致了质量上的差距,这种调整导致了专业化。

专业化可以像调整特定于工作流程的数据一样简单,或者(更有可能)开发多个专门的人工智能组件。

我们可以通过考虑当前用于自动驾驶汽车的人工智能系统来了解一个具体的例子。这些系统有多个人工智能组件,从规划组件到检测组件以及用于数据标记和生成的组件。(如需更多详细信息,请参阅特斯拉的人工智能日演示。)

用GPT-4这样的通用人工智能模型天真地取代这个专门的人工智能系统将导致质量的灾难性下降。

但是,一个更先进的通用人工智能模型GPT-(4+n),在战略上应用,能执行这个工作流程吗?

我们可以进行一个思想实验,看看这可能会如何展开:

- 想象一下,GPT-(4+n)发布了,具有非常有用的功能,包括自动驾驶功能。

- 我们无法立即替换整个现有系统。

- 因此,我们确定了GPT-(4+n)最有用的功能,并考虑将这些功能作为另一个组件添加进来,可能是通过API调用。

- 然后对这个新系统进行测试,不可避免地会发现质量上的差距。

- 人们正在努力解决这些差距,当它们出现在特定的工作流程(自动驾驶)中时,就会开发出特定于工作流程的解决方案。

- 最终结果可能是API调用被一个新的专用AI组件完全替换,或者被其他专用组件增强。

虽然这个思想实验可能并不完全准确,但它说明了我们如何从一个通用的人工智能模型开始,然后对其进行实质性的专门化以提高质量。

总之,(1)高价值工作流程的质量很重要,(2)专业化有助于提高质量。

利用用户反馈

与质量考虑密切相关的是用户反馈的作用。有明确证据表明,对高质量的人类“使用”数据(如偏好、指令、提示和响应等)进行仔细调整,是推动通用人工智能模型能力的核心。

例如,在LLM中,RLHF(来自人类反馈的强化学习)和对类人指令/偏好数据的监督学习等技术对于获得高质量的生成和指令跟随行为至关重要。这一点在InstructGPT和ChatGPT中得到了显著的证明,目前正在推动一些LLM开发工作(Alpaca、Dolly、gpt4all)。

同样,我们希望用户反馈在推动人工智能在特定工作流程中的能力方面发挥关键作用。但要有效地整合这种反馈,就需要对人工智能系统进行细粒度的控制。我们不仅可能希望根据用户反馈仔细调整底层模型(由于成本和访问受限,一般人工智能模型很难实现),而且我们可能需要调整整个人工智能系统的结构,例如定义数据、人工智能模型和工具之间的交互。

从工程(各种微调方法、链接API调用、使用不同的AI组件)、成本(适应大型模型的成本很高)和安全(参数泄漏、数据共享)的角度来看,为通用AI模型设置这样的细粒度控制具有挑战性。

总之,用户反馈所需的细粒度控制更容易实现

专有数据和专有知识

许多高价值、特定于领域的工作流都依赖于丰富的专有数据集。这些工作流程的最佳人工智能解决方案需要对这些数据进行培训。然而,拥有这些数据集的实体将专注于保护其数据护城河,不太可能允许无限制地访问第三方进行人工智能培训。因此,这些实体将在内部或通过特定的合作伙伴关系建立专门用于这些工作流程的人工智能系统。这些将不同于一般的人工智能模型。

与此相关的是,许多领域也使用专有知识——这是一个只有少数人类专家才能理解的“商业秘密”。例如,为台积电尖端芯片制造提供动力的技术,或顶级对冲基金使用的定量算法。利用这些专有知识的人工智能解决方案将再次在内部构建,专门用于这些工作流程。

这些是“构建与购买”计算的例子,这种计算在之前的许多技术周期中都发生过,并且在这一波浪潮中也会重复出现。

人工智能模型的商品化

在努力开发GPT-4等昂贵的专有模型的同时,也在努力构建和发布Llama等人工智能模型,然后快速优化,甚至可以在手机上运行(!)

这些是(1)基于成本的效用和(2)效率之间激烈而持续的竞争的例子。

效率是指在保持效用的同时,降低人工智能新进展的成本的快速过程。发生这种情况的原因有几个关键属性:

- 人工智能领域在合作、发表研究和开源方面有着强大的根基,从而实现了(精心发现的)技术见解的快速知识传播。

- 由于更好的硬件、基础设施和训练方法,训练流行人工智能模型的计算成本迅速下降。

- 收集、整理和开源数据集的努力有助于模型构建的民主化和质量的提高。

对于我们目前最强大的模型来说,效率似乎很可能会在竞争中获胜,从而导致这些模型的商品化。

通用人工智能模型的未来?

但这是否意味着所有大型通用人工智能模型都将被商品化?

这取决于另一个竞争者,基于成本的效用。如果人工智能模型有用但成本也很高,那么效率过程需要更长的时间才能运行——前期成本越高,降低成本所需的时间就越长。

- 如果成本保持在今天的水平,那么很可能会出现完全的商品化。

- 如果成本增加了一个数量级,但效用显示出回报递减,那么我们将再次看到商品化

- 如果成本增加了一个数量级,并且效用有成比例的收益,那么很可能会有少量成本很高的通用型号没有商品化。

哪种情况最有可能发生?

这很难确定。未来的人工智能模型肯定有构建的空间,可以使用更大数量/类型的数据和更多的计算。如果效用也继续增加,我们将有一些昂贵的通用人工智能模型用于大量多样、难以定义的工作流,如上图所示——为人工智能做的事情就像云为计算做的事情一样。

总结

尽管人工智能的发展浪潮持续了十年,但人工智能的未来看起来仍然比过去更加多事之秋!我们预计将出现一个丰富的生态系统,拥有各种高价值、专业的人工智能系统,由不同的人工智能组件提供动力,以及一些通用的人工智能模型,支持多种多样的人工智能工作流程。