Chinese, Simplified

category

介绍

正如我之前多次提到的,大型语言模型(LLM)在同步的会话UI等实时任务中难以应对延迟问题。

当增加额外的开销,比如检查幻觉时,这个问题就会加剧。

因此,微软研究院提出了一个框架,该框架利用小语言模型(SLM)作为初始检测器,LLM作为约束推理器,为任何检测到的幻觉生成详细的解释。

其目的是通过引入提示技术,使LLM生成的解释与SLM决策相一致,从而优化实时、可解释的幻觉检测。

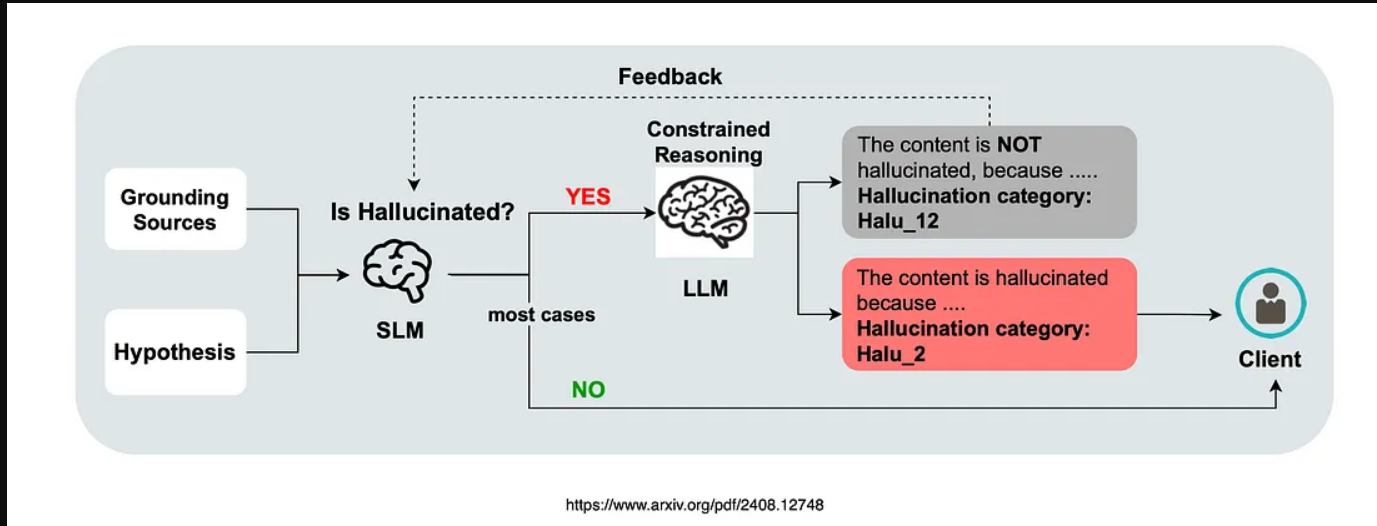

考虑到上面的图像,它演示了使用LLM作为约束推理器的幻觉检测…

- 初始检测:将接地源和假设对输入到小型语言模型(SLM)分类器中。

- 无幻觉:如果没有检测到幻觉,“无幻觉”结果将直接发送给客户。

- 检测到幻觉:如果SLM检测到幻觉,基于LLM的约束推理器会介入解释SLM的决定。

- 对齐检查:如果推理者同意SLM的幻觉检测,则将此信息与原始假设一起发送给客户端。

- 差异:如果存在分歧,则可能有问题的假设要么被过滤掉,要么被用作改进SLM的反馈。

更多关于微软的方法

鉴于幻觉在实际使用中很少发生,使用LLM对幻觉文本进行推理的平均时间和成本是可控的。

这种方法利用了LLM现有的推理和解释能力,消除了对大量特定领域数据和昂贵微调的需求。

虽然LLM传统上被用作端到端的解决方案,但最近的方法已经探索了它们通过潜在特征解释小分类器的能力。

我们提出了一种新的工作流程,通过平衡延迟和可解释性来应对这一挑战。~来源

SLM和LLM协议

这种实施的一个挑战是SLM的决定和LLM的解释之间可能存在的差异…

- 这项工作介绍了一种用于幻觉检测的约束推理器,平衡了延迟和可解释性。

- 提供对上下游一致性的全面分析。

- 提供实用的解决方案,以提高检测和解释之间的一致性。

- 展示了在多个开源数据集上的有效性。

结语

如果你发现我的任何观察不准确,请随时告诉我…🙂

- 我很欣赏这项研究侧重于为对话式UI引入护栏和检查。

- 在与真实用户交互时,将人纳入循环方法有助于通过审查对话进行数据注释和持续改进。

- 它还增加了发现、观察和解释的元素,为幻觉检测的有效性提供了见解。

- 本研究中提出的架构提供了对未来的一瞥,展示了一种更协调的方法,其中多个模型协同工作。

- 该研究还解决了当前的挑战,如成本、延迟以及批判性地评估任何额外开销的必要性。

- 使用小型语言模型是有利的,因为它允许使用开源模型,这降低了成本,提供了托管灵活性,并提供了其他好处。

- 此外,这种架构可以异步应用,框架在对话发生后进行审查。然后,这些人工监督的审查可用于微调SLM或执行系统更新。

- 登录 发表评论

- 24 次浏览

发布日期

星期三, 十一月 13, 2024 - 22:13

最后修改

星期三, 十一月 13, 2024 - 22:12

Article

最新内容

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago