category

如何在本地运行开源LLM

在本地运行开源LLM是了解其功能和局限性的关键一步。本节提供了关于如何在本地计算机上运行一些最流行的开源LLM的全面指南。我们将介绍Ollama、LM Studio等型号,提供循序渐进的说明和技巧,以实现平稳成功的设置。

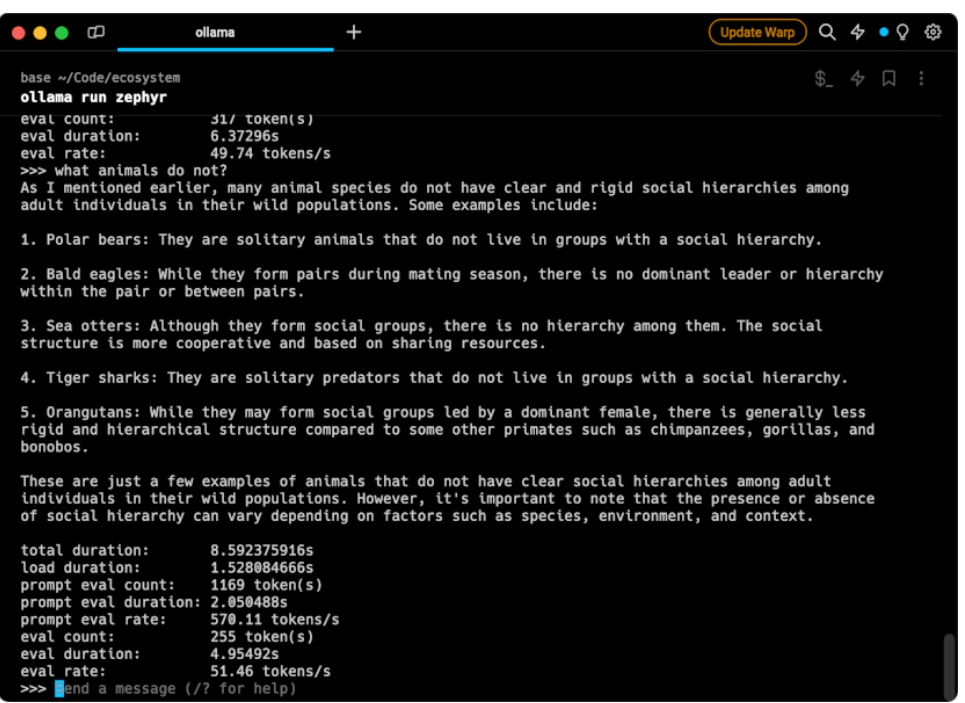

Ollama

Ollama是一个用户友好的工具,设计用于在计算机上本地运行大型语言模型(LLM)。它支持各种人工智能模型,包括Llama-2、未经审查的Llama、CodeLlama,Falcon、Mistral、Vicuna模型、WizardCoder和Wizard未经审查。它目前与MacOS和Linux兼容,Windows支持有望很快推出。

- 安装--从官方网站下载Ollama并使用命令

curl https://ollama.ai/install.sh | sh. - 运行模型——使用终端中的run命令运行模型。例如,

ollama run codellama. - Python集成——您可以将Ollama与Python一起使用。例如,使用Langchain库,可以按如下方式连接到Ollama上的模型:

from langchain.lm import Ollama

ollama = Ollama(base_url="http://localhost:11434", model="llama2")

print(ollama.generate("Why is the sky blue?"))- 附加功能——Ollama支持在Modelfile中导入GGUF和GGML文件格式,允许您创建、迭代和共享模型。

- 可用型号——查看Ollama型号库页面以获取可用型号的列表。确保您有足够的RAM用于您正在运行的模型。

Ollama简化了本地运行LLM的过程,使其成为开发人员和研究人员的宝贵工具。

LM Studio

LM Studio是一个桌面应用程序,允许您在笔记本电脑上发现、下载和运行本地和开源大型语言模型(LLM)。它提供了一个易于使用的界面,可以在不需要命令行设置的情况下尝试LLM。

要开始使用LM Studio,请执行以下步骤:

- 访问LM Studio网站并下载适用于您的操作系统(在您的情况下为macOS)的应用程序。

- 按照提供的安装说明在笔记本电脑上安装LM Studio。

- 启动LM Studio,您将能够发现并下载各种开源LLM。

- 下载LLM后,您可以使用LM Studio的界面在笔记本电脑上本地运行该模型。

我们是Klu LM工作室的忠实粉丝。

Jan

Jan是一个开源平台,允许您在计算机上本地运行人工智能模型,确保数据隐私和安全。它离线运行,可定制以满足您的特定需求。Jan才刚刚起步,但我们Klu.ai将其视为LM Studio的潜在替代品,LM Studio具有更多功能,但用户体验较差。

以下是开始使用Jan的步骤:

- 下载并安装——Jan是免费的,可以在自己的硬件上运行,无需每月订阅或基于使用情况的API。从官方网站下载并按照安装说明进行操作。

- 扩展功能——Jan支持应用程序和插件框架。您可以添加更多功能来满足您的需求。

- 使用您自己的文件——Jan使用本地存储在您设备上的开放、标准和非专有文件。这

- 你可以完全控制你的人工智能,并允许在需要时轻松迁移到另一个应用程序。

在本地运行模型——使用Jan,您可以直接在桌面上运行大型语言模型(LLM)。这使其成为本地LLM操作的经济高效的解决方案。

Jan的一个关键优势是,它不需要每月订阅或基于使用情况的API,因为它在您自己的硬件上100%免费运行。这使它成为在桌面上本地运行大型语言模型(LLM)的经济高效的解决方案。

Llama.cpp

为了获得更多的自定义和性能,您可以使用llama.cpp等工具在本地运行模型。这使您能够完全控制从拥抱脸加载预训练模型,并在CPU或GPU上进行推理。只要确保下载一个适合笔记本电脑RAM的型号,比如7B参数型号。llama.cpp库将模型封装在一个简单的API中,用于Python、Go、Node.js等。

运行您自己的LLM可以为您提供隐私、速度和灵活性。您可以在不依赖API的情况下将模型用于个性化项目。因此,只需一点设置,您就可以解锁最新的人工智能,在本地机器上生成内容、分类文本、回答问题等。

Replicate发布了一个大大简化了入门过程的脚本。要使用llama.cpp在本地运行模型,请执行以下步骤:

- 安装llama cpp软件包--要在M1/M2 Mac上安装llama ppp软件包,请使用以下一行命令:

curl -L "https://replicate.fyi/install-llama-cpp" | bash. 对于英特尔Mac或Linux计算机,请使用:curl -L "https://replicate.fyi/install-llama-cpp-cpu" | bash. 对于WSL上的Windows,请使用:curl -L "https://replicate.fyi/windows-install-llama-cpp" | bash.

以下是脚本运行的内容:

请记住,将<PATH TO WEIGHTS>.gguf 替换为模型权重文件的实际路径,将<tokenizer>替换为要使用的标记器。如果您想对huggillama/lama-7b使用默认的标记化器,可以省略标记化器参数。

我们是llama.cpp和Georgi Gerganov发起的革命的忠实粉丝。

- 登录 发表评论

- 237 次浏览

最新内容

- 1 month 1 week ago

- 1 month 1 week ago

- 1 month 1 week ago

- 1 month 1 week ago

- 1 month 1 week ago

- 1 month 1 week ago

- 1 month 1 week ago

- 1 month 1 week ago

- 1 month 1 week ago

- 1 month 1 week ago