category

人工智能的快速发展导致了能够执行复杂任务的日益复杂的人工智能代理的发展。这些代理,特别是那些利用大型语言模型(LLM)功能的代理,通常需要访问其固有训练数据之外的信息和工具才能有效运行。例如,一个旨在安排会议的人工智能代理需要与日历应用程序、电子邮件服务以及其他潜在的生产力工具进行交互。如果没有这种交互的标准化机制,将这些代理与不同的数据源和功能集成的过程就会变得复杂、耗时且难以扩展。LLM的固有局限性,如知识截断和上下文窗口的有限大小,进一步强调了动态方法增强其知识和能力的必要性。

人工智能代理简介

人工智能代理可以被理解为一种计算机程序,它可以根据自己的目标和收到的信息自行执行任务或做出决策。

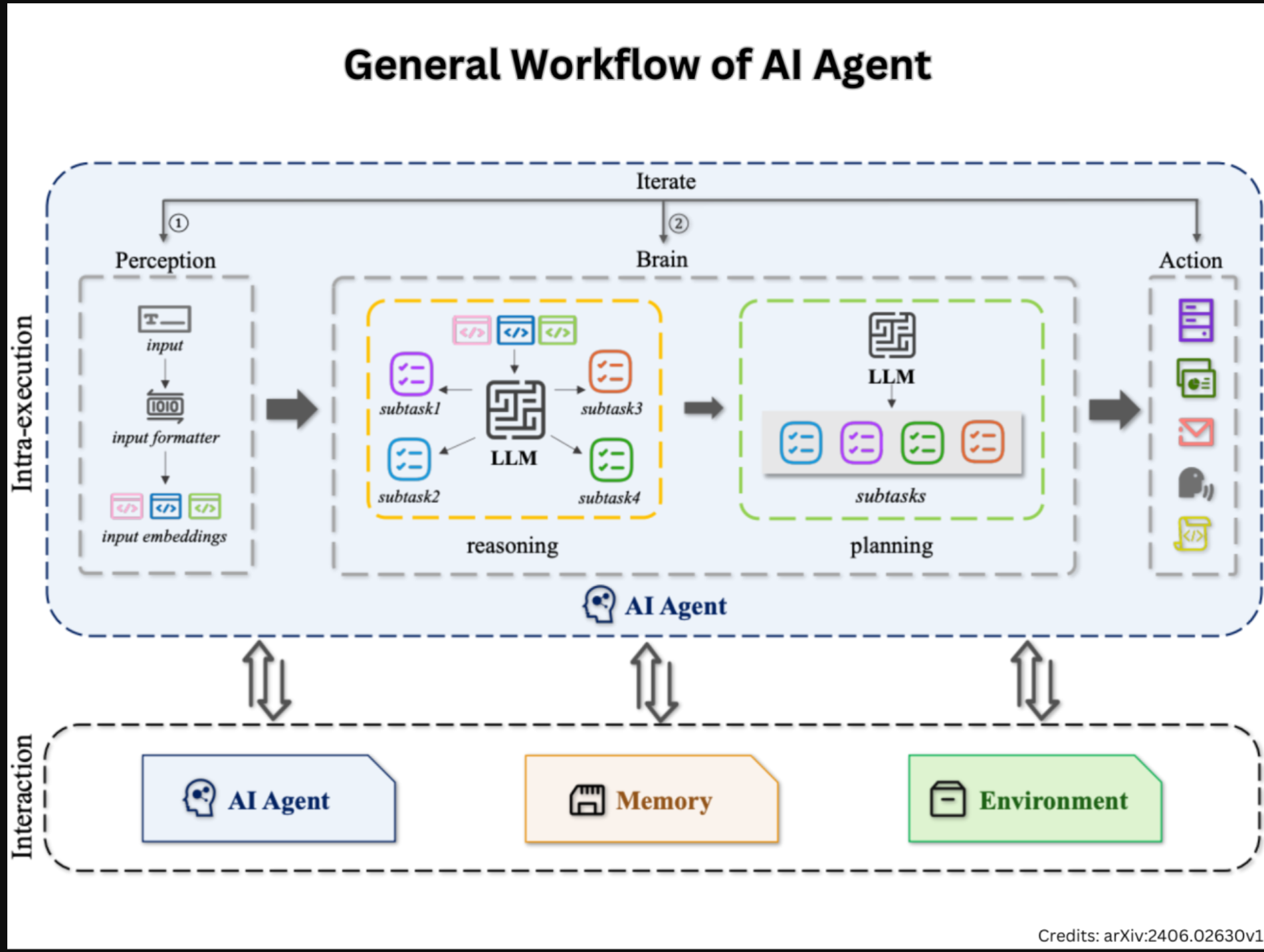

人工智能代理主要有三个主要组成部分——感知、大脑和行动。

这三个部分协同工作:感知收集信息,大脑想出该做什么,行动执行计划。这个过程允许AI代理执行各种各样的任务,从回答问题到控制复杂的系统。

该图说明了AI代理的一般工作流程,通常涉及两个核心组件:内部执行和交互。

内部执行组件侧重于单个AI代理中的过程,包括三个主要模块:感知、大脑和动作,如上所述。工作流程从用户输入开始,用户输入通过作为感知模块一部分的输入格式化工具。

然后嵌入输入,然后由大脑进行推理和规划,这就是LLM用于分析和推断信息并为特定目标制定策略的地方。

这会产生子任务,然后由动作模块执行,其中可能包括调用外部工具。这个过程迭代,在大脑和动作模块之间移动,直到达到最终结果。代理还与其内存和环境进行交互。

让我们举一个现实生活中的例子来看看人工智能代理是如何工作的。假设你需要一双500美元以下的耐克鞋,颜色应该是蓝色。人工智能代理将把用户对500美元以下蓝色耐克跑鞋的请求分解为结构化数据。然后,它将使用推理和规划来识别相关的鞋子型号,收集细节,并根据标准评估选项。代理将执行子任务,如查询电子商务API和查看客户反馈,在其大脑和动作模块之间迭代,直到推荐最佳鞋子。在整个过程中,代理将利用其内存和环境有效地满足用户的需求。

这是我使用LangChain构建AI代理的完整指南!

代理工作流

让AI代理与代理工作流协同工作!

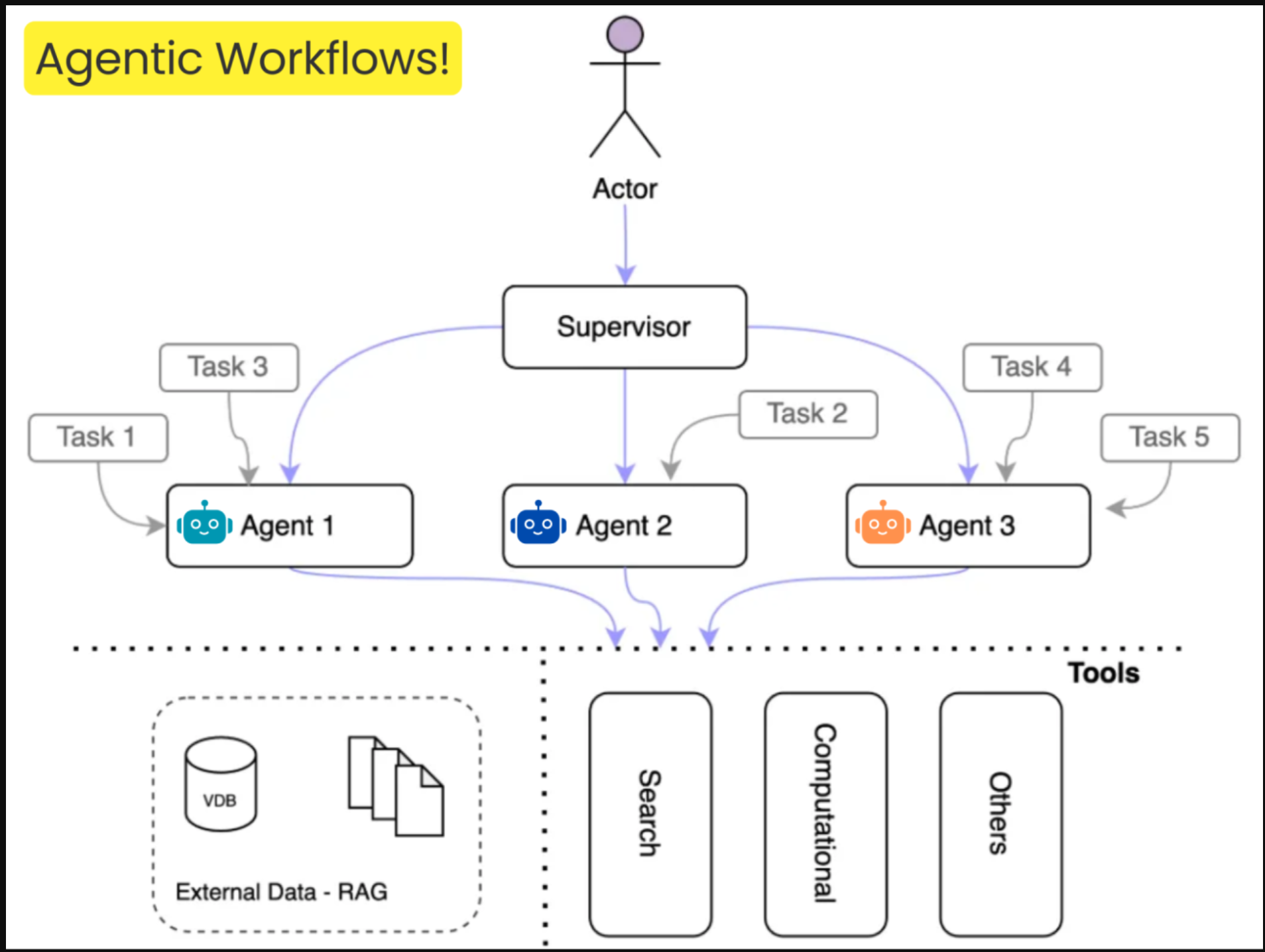

Agent工作流旨在通过专门的AI代理自主执行一系列任务,这些代理在没有持续人工监督的情况下运行。这些工作流通过组织和分配工作给各种代理来管理任务,确保每个任务都由最适合执行它的组件处理。这种分散的任务管理使系统能够动态地做出决策——人工智能代理分析数据、调整流程,甚至随着时间的推移从反馈中学习以提高性能。

这种方法的好处是巨大的。自动化简化了从数据输入到复杂决策的任务,减少了人为错误,并为更具战略性的活动腾出了资源。优化来自系统随着时间的推移改进任务序列的能力,从而提高效率。可扩展性是另一个关键优势,因为代理工作流的模块化设计允许他们通过简单地添加更多代理或集成新工具来处理大规模流程。

这些特性使代理工作流在各种应用程序中具有很高的价值。

了解如何构建高效的代理系统。(Understand How to Build Efficient Agentic Systems. )

此外,以下是如何以正确的方式构建Agent系统和LLM应用程序。(how you can build Agentic systems & LLM applications the right way. )

以下是我使用LangGraph构建代理工作流的分步指南。(agentic workflows using LangGraph. )

让我们了解多智能体系统(MAS)

多代理应用程序正在彻底改变我们解决复杂问题的方式。这些应用程序利用多个智能代理进行协作,以处理需要不同专业知识的任务。这些代理的编排允许分工,每个代理专门处理任务的特定方面。随着组织越来越多地寻求自动化复杂的任务,对多代理应用程序的需求也在不断上升。他们简化工作流程和提高生产力的能力使他们成为从软件开发到数据分析等各个领域的宝贵资产。

多智能体系统(MAS)由一组智能体定义,也称为团队。

每个人都拥有独特的技能和专业能力。这些代理协作解决简单的任务,以实现更大、更复杂的共同目标。

这些代理通过将其任务的输出发送给后续代理进行构建来相互通信。

根据代理之间的交互,船员的结构可分为三种主要类型:

➤顺序:代理在链中工作,其中一个代理的输出是下一个的输入。通过解决较小的任务,他们可以解决船员设计的更大、更复杂的目标。

➤ 层级:通常由一名经理和多名下属组成,领导者的角色是委派、计划和管理任务的完成。下属执行领导的指示。在这种情况下,我们可以让代理同时执行任务,因为并非每个代理都有顺序依赖关系。

➤混合:这种结构在同一个团队中具有顺序和层次环境。当一些代理手头有复杂的任务时,通常会将它们分解成更小的代理,并用新的代理构建一个子团队。他们成为该子船员的领导者,同时也是原船员的下属。

这是我关于构建多智能体系统的实用指南。

以下是我在10分钟内使用CrewAI构建多代理系统的实践指南。

在本文中了解更多关于多代理系统的信息。

构建多代理系统

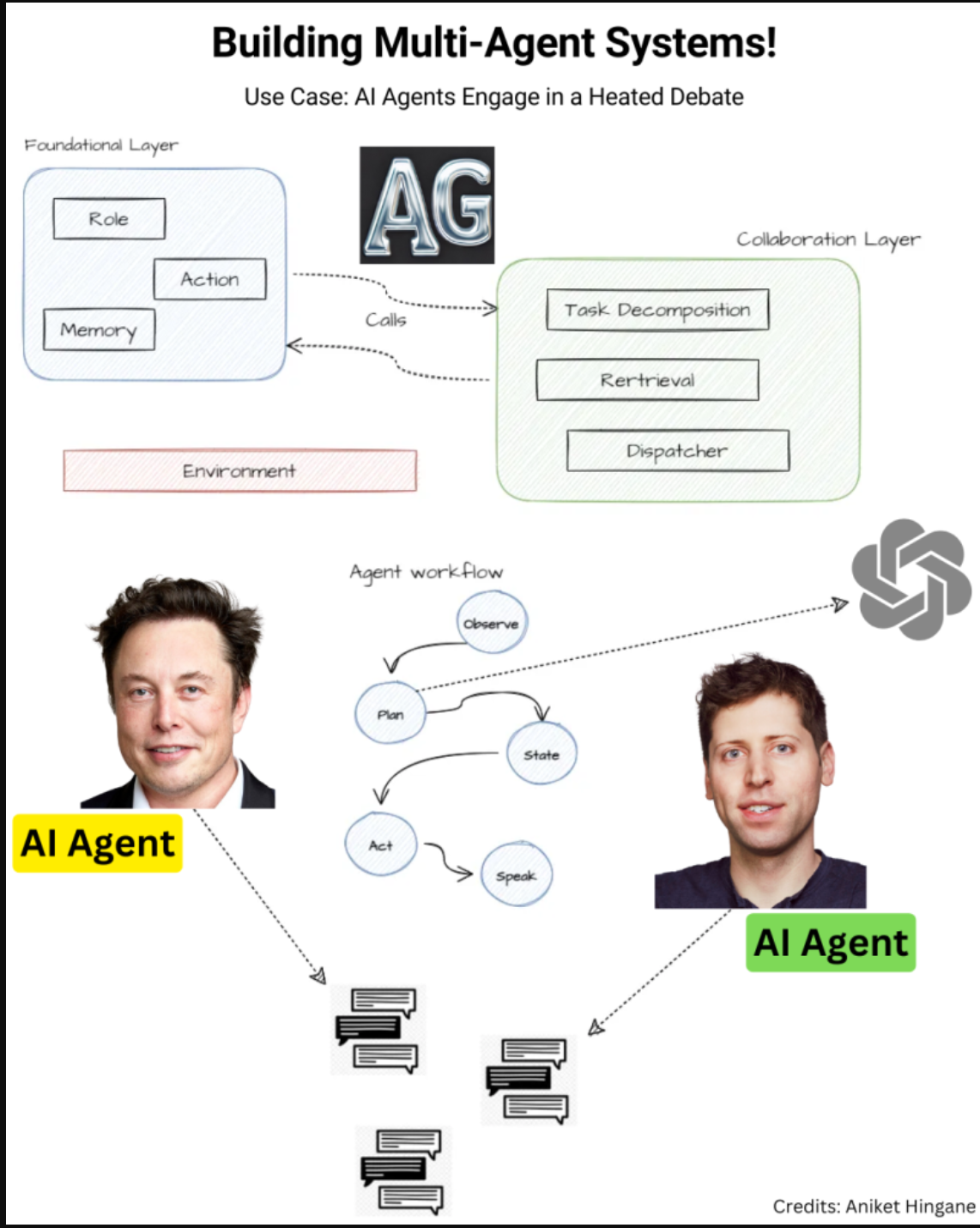

想看看两个人工智能代理是如何参与激烈辩论的吗?

多人工智能代理系统代表了人工智能领域的重大进步。

好吧,未来都是关于多AI代理系统的。

这些系统由各种自主的人工智能代理组成,它们协同完成特定任务或解决复杂问题。与独立运行的单个AI代理不同,多AI代理协同工作,利用其独特的能力来提高性能和效率。

多代理RAG系统利用多个专门的代理,每个代理都有自己的知识库。用户提示由这些代理按顺序处理,每个代理贡献其特定的专业知识。

在我最近的教程中,你可以看到两个代理人,一个是埃隆·马斯克的粉丝,另一个是萨姆·奥特曼的粉丝,他们都参与了激烈的辩论,并分享了他们对谁更好的看法。第三个代理人,即裁判代理人,进入对话,最终宣布获胜者。

很有趣,对吧?

在我的分步指南中学习如何构建多代理AI系统。

本教程的灵感来自Aniket Hingane,这是您可以参考了解更多信息的文章。

多代理系统层和工具

每个AI代理的核心都是一个LLM,它围绕着一个专门的应用程序或功能来处理自然语言查询和分析数据。代理解释用户请求,将其分解为子任务,并将其分配给其他专门的代理。它们在多代理框架内持续通信,确保任务高效有效地完成。

那么,它们与工作流有何不同?

多智能体系统包括多个自主智能体,它们相互作用、协作或协调以完成任务、解决问题或实现特定目标。这些代理可以独立运行,动态适应,并做出分散的决策。

相比之下,工作流代表了一系列结构化的任务或流程,旨在实现预定义的结果。与多代理系统不同,工作流通常遵循线性或预定义的路径,适应性和自主性有限。

您可以使用哪些不同的工具和框架来构建多代理系统?

- -crewAI

- -AutoGen

- -LangGraph

- -Agno(Phidata)

- -OpenAI Swarm

- -Pydantic AI等

下面的工作流程图显示了医生的多代理预约系统。您可以很容易地看到多个代理如何高效协作,无缝处理日程安排、取消和患者交互。

从下面的指南中了解更多关于多智能体AI系统的信息。

以下是我关于使用crewAI构建多智能体系统的指南。

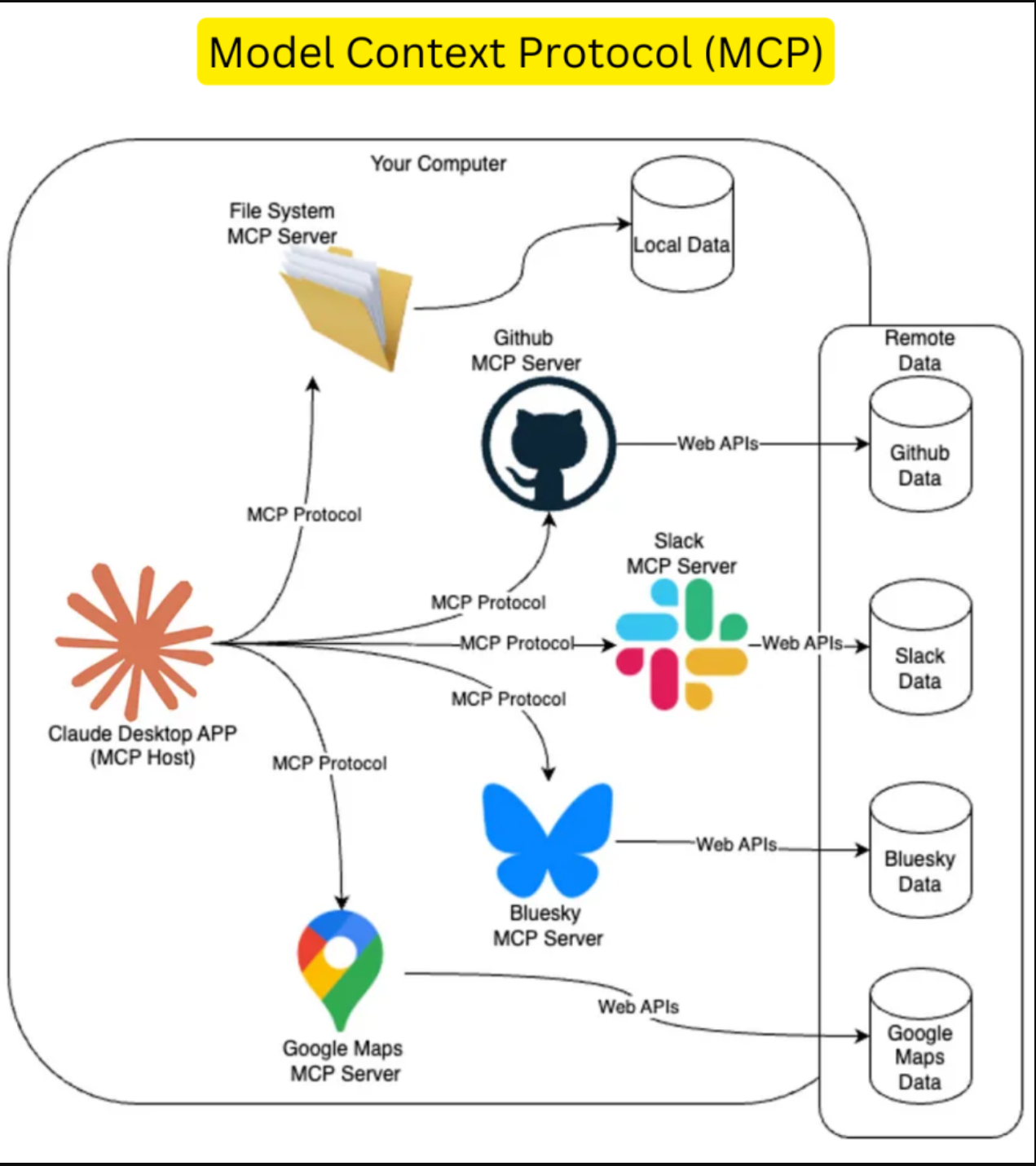

输入模型上下文协议(MCP)

MCP最初是Anthropic的一个项目,现在是镇上的热门话题。

尽管它是在几个月前推出的,但开发人员已经逐渐开始理解它的重要性。

这是一个试图标准化LLM访问外部数据和工具的协议。

那么,为什么大家突然都在谈论它呢?

MCP通过提供将AI代理与外部工具和数据源集成的标准化协议简化了开发人员的生活。

它促进了互操作性,减少了对自定义集成的需求,并简化了人工智能应用程序开发。MCP充当通用适配器,使LLM能够访问真实世界的数据,并以一致和可扩展的方式执行操作。

MCP具有增强上下文感知、简化开发和提高安全性等优点,使其成为人工智能工具集成的宝贵工具。目标是让MCP成为AI的USB-C,允许标准化的AI模型交互。MCP培育了一个可重用连接器的生态系统,允许开发人员一次性构建并在多个LLM和客户端之间重用它们,从而消除了以多种方式重写相同集成的需要。这种统一的数据访问意味着,使用MCP,配置了一个协议,然后LLM可以“看到”所有注册的连接器。

例如,现在MCP服务器允许您将Claude连接到GitHub、Slack和Google Maps等功能强大的工具。这些集成可帮助您节省时间,简化工作流程,并专注于最重要的事情。忘记RAG吧,MCP将通过实现更自主、上下文感知和高效的工作流程,使人工智能代理和代理应用程序受益匪浅。

了解更多关于MCP的信息。

MCP的核心组件

图片来源:Digital Ocean

模型上下文协议基于客户端-服务器架构运行,该架构涉及不同组件的不同角色:MCP主机、MCP客户端和MCP服务器。MCP主机是人工智能应用程序本身或用户与这些应用程序交互的界面,例如Anthropic的Claude Desktop或各种人工智能驱动的集成开发环境(IDE)。这些主机是需要访问外部数据或工具以满足用户请求或执行特定任务的实体。

MCP客户端是特定于协议的客户端,与MCP服务器建立和维护专用的一对一连接。作为中介,这些客户端负责将来自MCP主机的请求转发到相应的MCP服务器,然后将服务器的响应中继回主机。这种关注点的分离允许AI应用程序专注于其核心逻辑,而客户端则处理MCP通信协议的复杂性。

MCP服务器是轻量级的独立程序,通过标准化的MCP接口公开特定的功能或数据源。这些服务器充当各种本地或远程数据源的网关,这些数据源可以包括文件系统、数据库、外部服务的应用程序编程接口(API)等。每个MCP服务器都宣传它提供的特定工具、资源和提示,允许MCP客户端发现和利用这些功能。

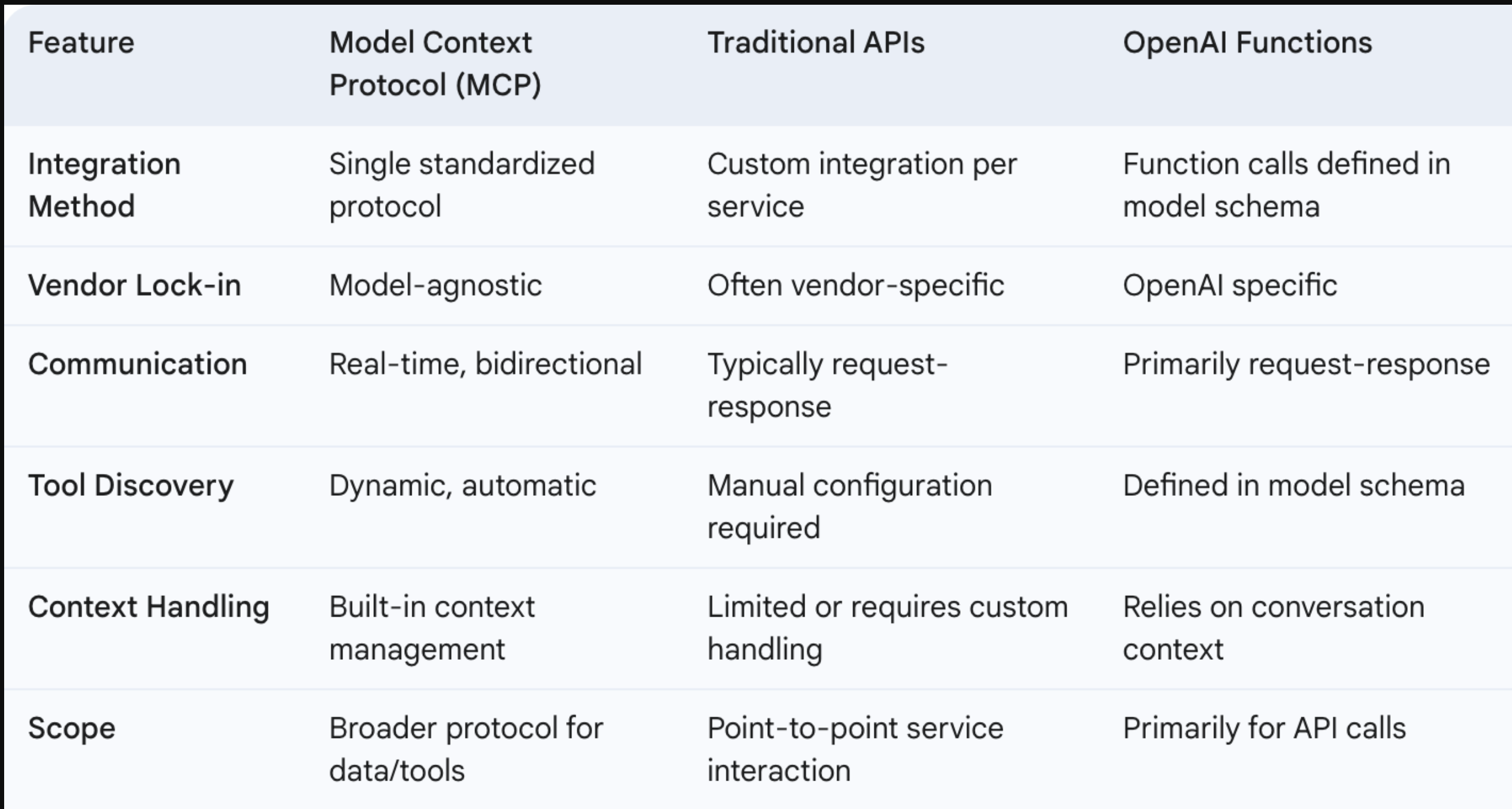

人工智能集成景观中的MCP:与现有方法的比较

为代理应用程序的基础设施提供动力!

代理应用程序依赖于强大的基础设施,包括强大的计算能力,通常利用GPU和TPU,以及可扩展的数据存储解决方案,如矢量数据库,如SingleStore,以实现高效的信息检索。高带宽、低延迟的网络也是至关重要的。支持这一点的工具和平台包括来自Google cloud AI和Azure AI等主要云提供商的LLM管理服务,用于管理复杂工作流的LangChain和Kubernetes等编排框架,以及用于性能跟踪的监控工具。

AdaniConneX提供注重可扩展性、可靠性和可持续性的数据中心基础设施,为部署代理应用程序所需的高要求资源提供了一个潜在的平台

AdaniConneX数据中心在印度新兴IT中心的战略位置也使其靠近人才库和代理应用程序的潜在用户。

我真的很喜欢AdaniConneX的“你依赖什么,依赖我们”活动。

想象一下,让你的人工智能助手安排你的一天,却听到一片寂静。打开你最喜欢的应用程序,使用人工智能进行个性化推荐,却发现它没有反应。

没有人工智能帮助你起草那封重要的电子邮件。没有智能助手帮你订购杂货。没有个性化的健康见解来分析你的睡眠模式。没有智能导航系统为您重新安排交通路线。听起来很令人沮丧,不是吗?

今天的代理人工智能应用程序在幕后不知疲倦地工作,以看似人类般的理解处理复杂的任务。但你有没有想过这些数字奇迹的动力是什么?在每一个智能响应、个性化推荐和自主决策的背后,都是一个复杂的高性能数据中心网络,这是人工智能革命的真正推动者。AdaniConneX最先进的数据中心提供了当今要求最苛刻的人工智能应用程序无缝运行所需的计算能力、可靠性和安全性。

- 登录 发表评论

- 46 次浏览

最新内容

- 1 month ago

- 1 month ago

- 1 month ago

- 1 month ago

- 1 month ago

- 1 month ago

- 1 month ago

- 1 month ago

- 1 month ago

- 1 month ago