1.目的

本文档是负责使用Azure OpenAI资源设计和实施网关解决方案的工程团队的重要指南。它旨在为团队提供构建生成人工智能(GenAI)网关所需的基本指导和参考设计。GenAI网关可以有效地处理和优化GenAI资源利用率,促进无缝集成,并在各种部署之间分配工作负载。它还可以实现细粒度的监控和计费

值得注意的是,本文档没有深入探讨实现级别的细节。相反,它为团队如何实现构建具有以下关键功能的GenAI网关的最终目标提供了指导:

- 身份验证

- 可观察性

- 顺从(合规)

- 控制

2.定义和问题陈述

2.1. 问题陈述

在使用大型语言模型(LLM)的应用程序的技术环境中,组织面临着有效联合和管理GenAI资源的挑战。随着对多样化和专业化LLM需求的增长,对集中式解决方案的需求变得更加必要。这种集中式解决方案必须在GenAI资源的联邦网络中无缝集成、优化和分配工作负载。现有的传统网关解决方案往往缺乏统一的方法来促进GenAI资源的联合。这种缺陷可能会导致资源利用率不理想、延迟增加,以及管理一组人工智能模型的挑战。

什么是GenAI网关?

“GenAI网关”充当智能接口/中间件,动态平衡后端资源之间的传入流量,以实现优化资源利用率。除了负载平衡,GenAI网关还可以配备额外的功能,以应对计费、监控等方面的挑战。

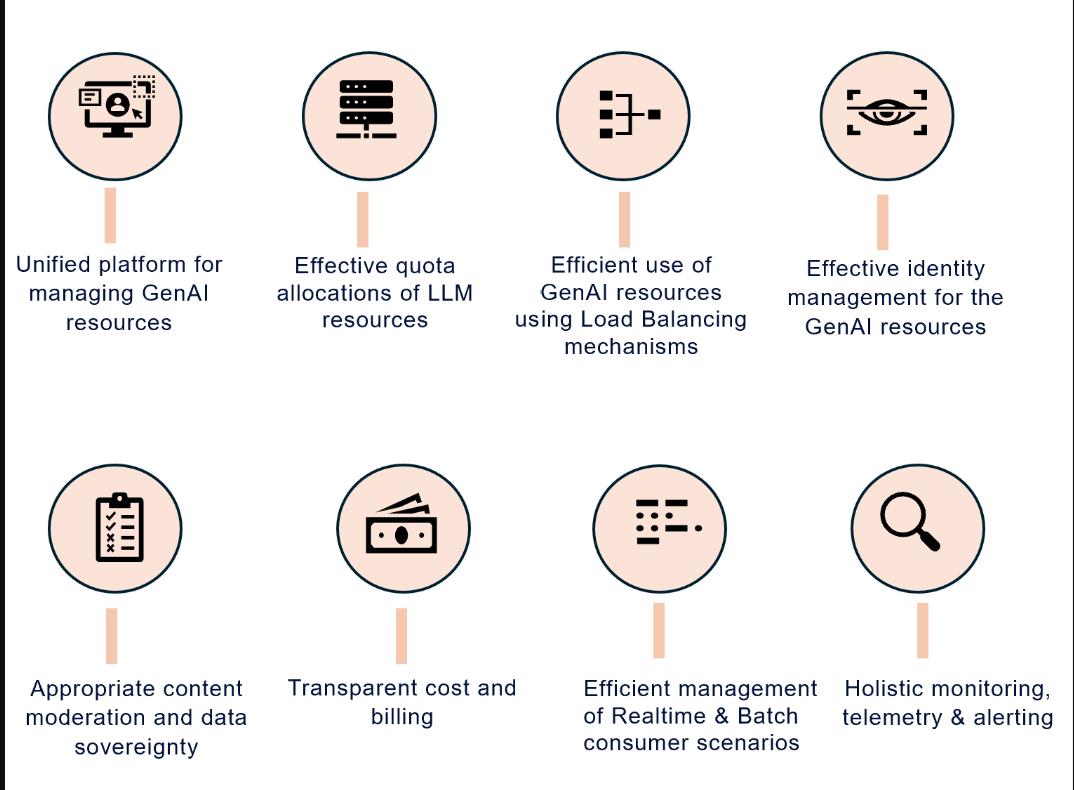

使用GenAI网关可以实现的一些关键好处:

GenAI网关的主要优势

图1:GenAI网关的主要优势

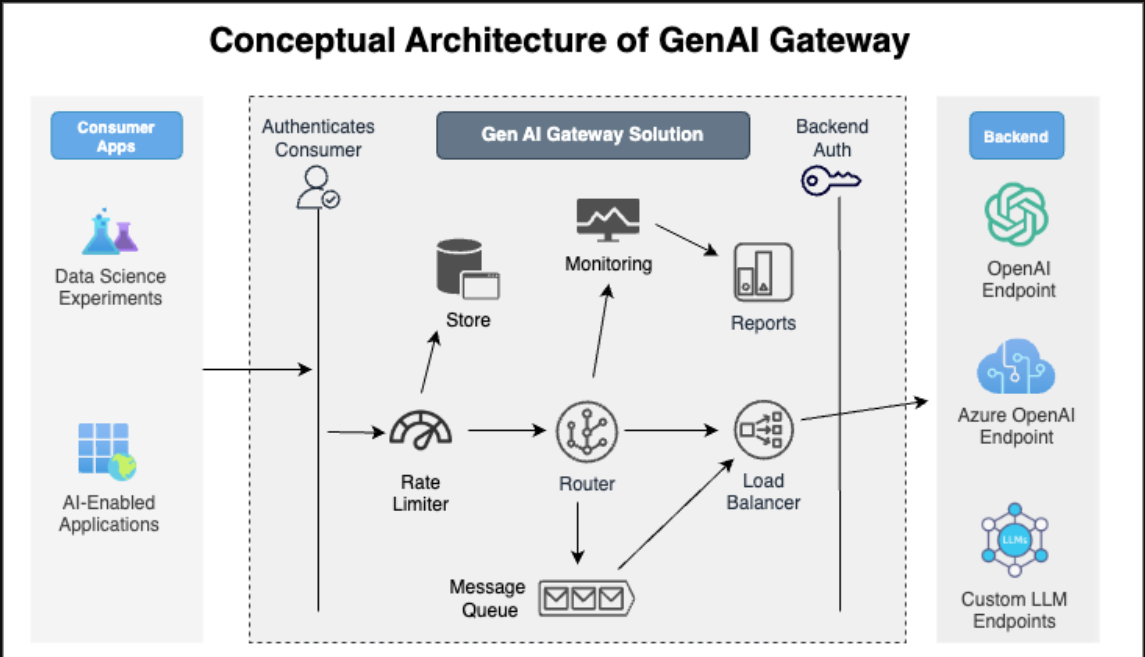

2.2. GenAI网关的概念架构

下面是描述GenAI网关高级组件的概念架构。

概念架构

图2:概念架构

3.推荐预读

建议读者熟悉Azure OpenAI的某些关键概念和术语。这些概念和术语对于建立基础理解至关重要。

4.构建GenAI网关的复杂性

大型语言模型(LLM)通过REST接口公开,允许用户轻松调用其端点。在大多数大型企业中,REST资源通常通过网关组件对消费者隐藏。通过网关路由请求,企业可以集中控制访问和使用。集中控制可有效实施以下策略:

- 速率限制

- 身份验证

- 数据隐私控制

在传统的API网关中,处理资源的速率限制和负载平衡通常涉及随着时间的推移调节请求的数量。通常采用节流或平衡多个后端负载等技术。

然而,当使用Azure OpenAI资源作为后端时,TPM(每分钟令牌数)的增加维度引入了另一层复杂性。这种复杂性在于确保后端之间负载分布的一致性和均匀性。因此,除了GenAI网关需要确保对请求数量的监管外,它还必须考虑跨多个请求处理的令牌总数。

5.构建GenAI网关时的关键考虑因素

每分钟令牌数约束的另一个维度迫使传统网关进行了一些更改。这些人工智能端点的固有性质带来了一些需要解决的挑战。

以下是构建与Azure良好架构框架一致的GenAI网关时的关键考虑因素。

- Scalability

- Performance Efficiency

- Security and Data Integrity

- Operational Excellence

- Cost Optimization

6.总结

本文档不仅提供了对关键概念的基本理解,还提供了实施GenAI网关的实用见解和策略。它解决了有效联合和管理GenAI资源的挑战,这对于使用AOAI(Azure OpenAI)和自定义大型语言模型(LLM)的应用程序至关重要。本文档应用行业标准架构框架对构建GenAI网关的复杂性进行分类和解决。它还提供了全面的方法/参考设计,不仅在技术上合理,而且符合最佳实践*。

- 登录 发表评论

- 18 次浏览

最新内容

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago