Chinese, Simplified

SEO Title

category

人工智能和大型语言模型(LLMs)的兴起改变了许多行业。LLM支持开发具有类人文本理解和文本生成功能的应用程序。快速工程在充分发挥LLM的潜力方面发挥着至关重要的作用。它创建了满足特定业务场景的有效提示。大型语言模型操作(LLMOps)已成为高效快速工程和LLM应用程序开发和部署的基石。

业务问题

实施LLM应用程序的客户希望使用最适合其解决方案的技术栈进行智能部署,但往往缺乏全面的指导和既定的模式来提前做出明智的决策。缺乏适当的指导和模式会延长开发时间,并导致在试错部署上浪费投资。

解决方案

LLMOps与Prompt-flow相结合,是一个用于开发与LLM应用程序相关的多个流的综合平台。它为简单和复杂的LLM应用程序提供了功能,并为所有流程提供了一个单一的存储库。每个流都可以处理多个数据集,并且可以定制以满足应用程序的需求。

价值主张

具有提示流的LLMOps在许多领域提供了价值:

- 加快价值实现时间:

- 每个流程都有自己的生命周期,允许从开发到生产的平稳过渡。

- 无缝实施A/B部署,轻松比较不同的流版本。

- 支持在本地和云中执行即时实验和评估。

- 启用缩放:

- 支持将流部署到Kubernetes和Azure Managed计算,并通过配置设置驱动,确保您的流根据需要自动扩展。

- 提供基于配置的部署。

- 综合报告:

- 为每个变体配置生成详细的报告,使您能够做出明智的决定。

- 为所有变体批量运行和实验提供CSV和HTML文件的度量收集,从而实现数据驱动的决策。

LLMOP工作流的逻辑架构

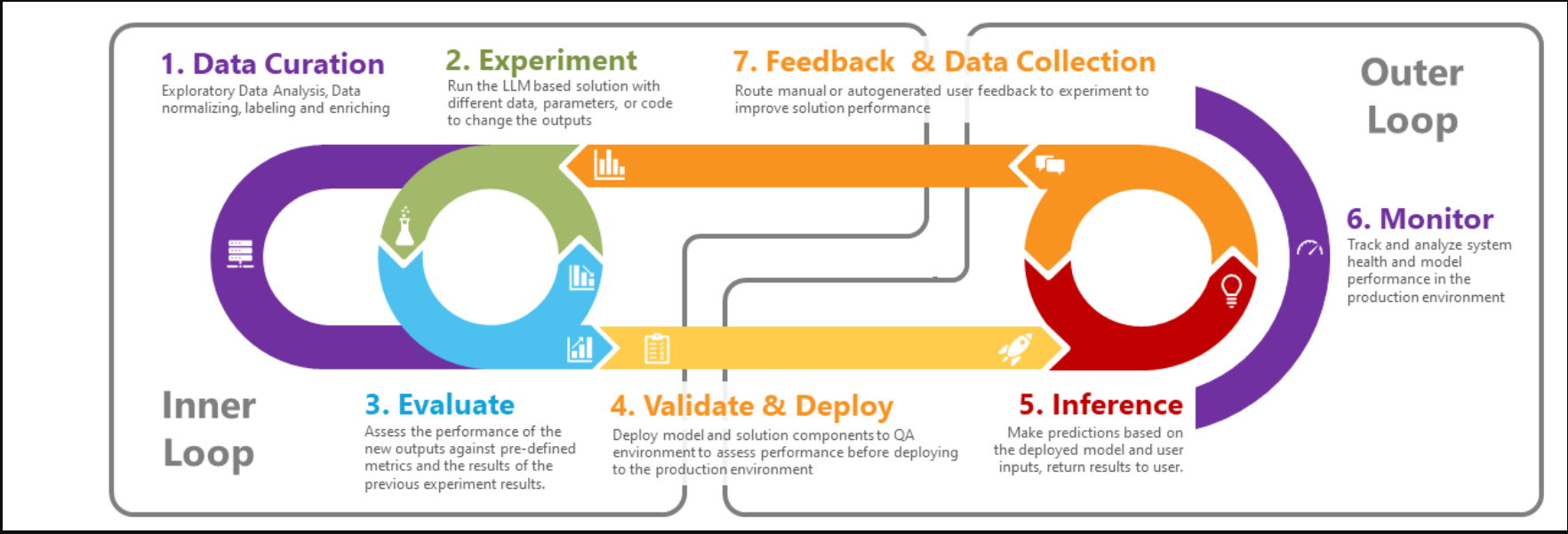

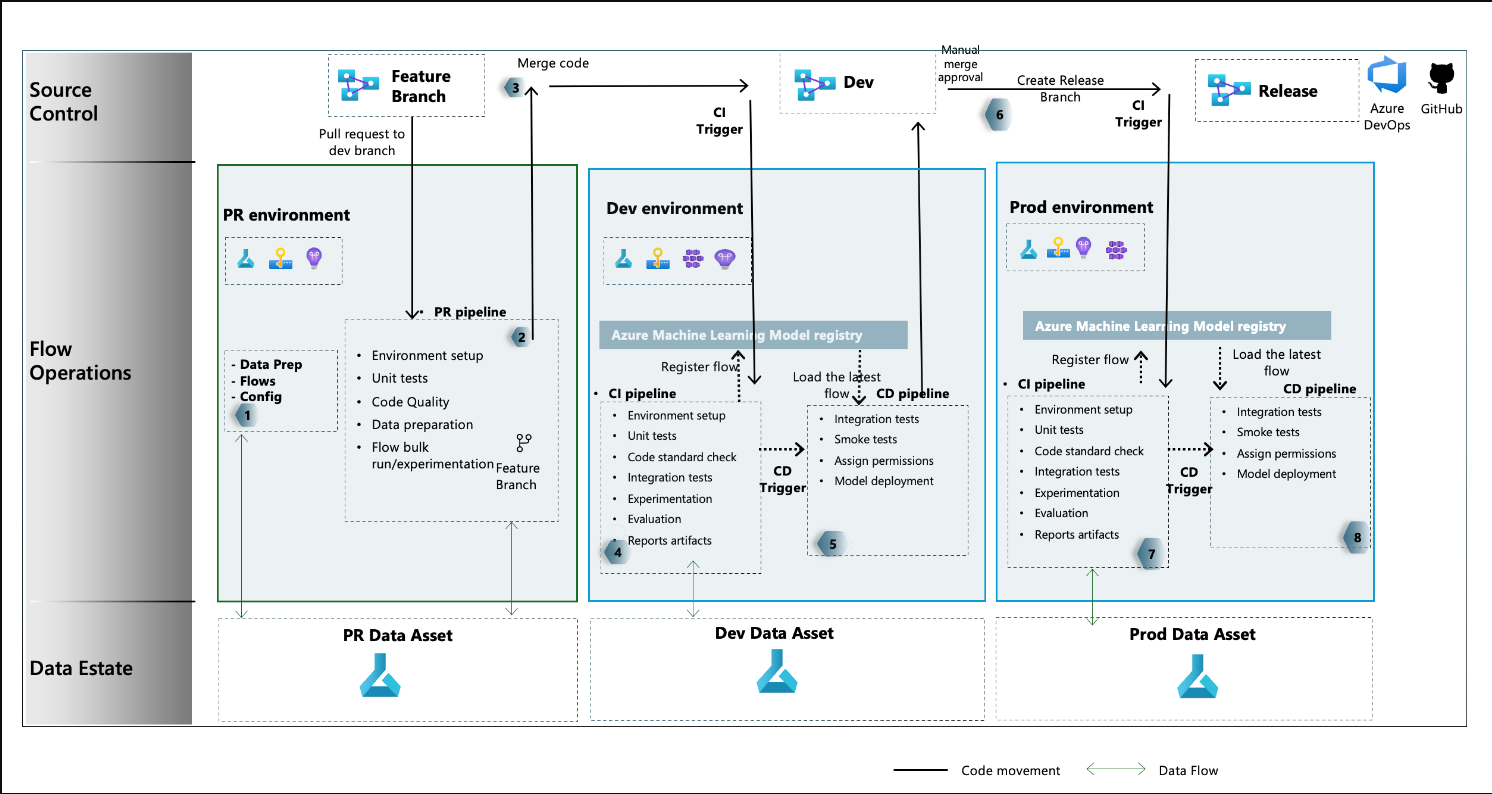

LLMOps工作流

Prompt flow LLMOps流程

RAG实验加速器

实施

带有Prompt-flow的LLMOps是作为GitHub存储库提供的,您可以克隆并开始使用 microsoft/llmops-promptflow-template (github.com)

- 登录 发表评论

- 19 次浏览

发布日期

星期六, 十月 5, 2024 - 22:30

最后修改

星期六, 十月 5, 2024 - 22:31

Tags

Article

最新内容

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago