category

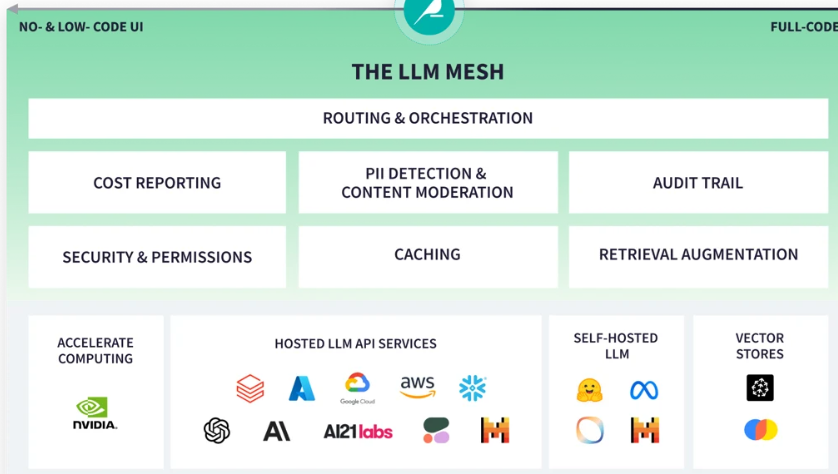

随着越来越多的组织尝试Generative AI并将其部署到生产中,一个关键问题出现了:这些应用程序在企业环境中是否既安全又可扩展?答案是肯定的,通过LLM Mesh——Generative AI应用程序的共同支柱,它有望重塑分析和IT团队安全访问Generative AI模型和服务的方式。

LLM Mesh使组织能够高效地构建企业级应用程序,同时解决与成本管理、法规遵从性和技术依赖性相关的问题。它还允许在越来越多的型号和供应商之间进行选择和灵活性。

我们很高兴能与LLM Mesh Launch合作伙伴Snowflake、NVIDIA、Pinecone和AI21实验室一起解决在企业中集成LLM的有效、可扩展和安全平台的迫切需求。Dataiku的LLM Mesh集成的完整列表包括:

托管LLM API服务:

- Snowflake

- AI21 Labs

- Azure OpenAI Service

- Google Vertex AI

- AWS Bedrock

- OpenAI

- Anthropic

- Cohere

- MosaicML

自托管私人LLM:

- Hugging Face (Llama2, Falcon, Dolly 2, MPT, and other fully-private LLMs)

矢量存储:

- Pinecone

- FAISS

- ChromaDB

加速计算:

- NVIDIA

本文总结了LLM Mesh解决的核心挑战(即管理安全、性能和成本),组织可以通过利用它带来的主要好处,以及Dataiku如何使组织能够通过LLM Mesh构建和部署企业级的Generative AI应用程序。

使用LLM网格克服生成性人工智能障碍

为了构建能够产生短期和持续价值的Generative AI应用程序,分析和IT团队需要克服几个关键挑战。LLM网格旨在解决以下问题:

- 选择和依赖:应用程序构建者可以从不同的提供商那里选择越来越多的模型。这是一件好事:不同的模型和提供商允许组织选择最适合给定应用程序的成本、性能和安全需求的模型和服务。考虑到快速发展的环境,团队将从保持他们的选择开放中受益,而不是成为锁定的牺牲品。然而,如果应用程序“硬连接”到底层模型或服务,这将使在设计阶段测试不同的模型变得困难,并产生一种依赖关系,一旦应用程序部署到生产中,这种依赖关系可能很难打破,而且代价高昂。

- 成本:创建和运行LLM是昂贵的,提供商自然会通过API费用来传递成本。因此,如果不能正确管理请求,尤其是对于重复提示,可能会导致相当大的不可预见成本,并给IT运营带来严重的黑眼圈。虽然数据团队将根据准确性评估LLM的性能,但IT必须关注延迟和SLA。

- 隐私、安全和合规性:LLM应用程序的用户创建可能传达敏感企业IP或PII的提示。如果这些数据出现在公共领域,这种数据泄露可能会导致收入损失、巨额罚款(来自监管机构)或公关灾难。此外,新的人工智能法规,如《欧盟人工智能法案》,将要求使用LLM的公司显示他们在哪里使用该技术,谁可以获得该技术,并证明他们限制了消费者的风险,否则将面临巨额罚款。最后,LLM的反应可能包含不恰当甚至冒犯性的内容(称为毒性)。从客户关系、法律和公关的角度来看,允许员工或更糟的是,允许客户查看这些内容可能会严重影响您的业务。

LLM网格的优点

LLM-Mesh位于LLM服务提供商和最终用户应用程序之间,公司可以灵活地根据自己的需求选择最具成本效益的模型,确保数据和响应的安全,并为可扩展的应用程序开发创建可重复使用的组件。让我们更深入地了解其中一些关键优势:

1.将应用程序与服务层解耦

目前并不总是很清楚哪种LLM将为团队试图构建的应用程序提供最佳输出。他们需要平衡成本、安全性、性能和速度。首先,在设计阶段,他们需要能够有效地测试不同的模型,以确定哪种模型最有效。然后,他们需要在部署应用程序后保持更改的能力。应用程序和人工智能服务层的这种解耦使设计尽可能好的应用程序成为可能,然后在生产中轻松维护它们。

2.强制执行安全网关

标准的IT实践规定,组织需要维护针对其基础架构运行的查询的完整跟踪。这既是为了管理性能(即识别低效联接背后的罪魁祸首),也是为了确保安全性(即知道谁在查询哪些数据以及出于哪些原因)。同样的需求转化为LLM。

LLMMesh作为一个安全的API网关来分解硬编码的依赖关系,并管理和路由应用程序和底层服务之间的请求。一个完全可审计的日志,记录谁在使用哪种LLM和哪种服务,用于哪种目的,允许成本跟踪(和内部重新计费),以及对这些有时不可预测的模型的请求和响应的完全可跟踪性。

3.安全性、权限和PII

在筛选私人数据时,LLM Mesh会评估每一个敏感信息请求,如机密或专有数据或客户PII。然后,系统采取适当的操作:在将请求发送到LLM API之前对这些敏感信息进行编辑,完全阻止请求,和/或警告管理员。通过使用标准PII检测模型、利用内部数据库或使用提供高级功能或行业特定知识的第三方服务,多种形式的PII检测共存。

接下来,为了降低商业用户向公共聊天机器人发出未经管理的请求的风险,公司可以使用具有安全访问权限的付费LLM服务。这些服务,例如来自OpenAI、Azure和谷歌的服务,不会捕获模型训练的请求信息。LLM Mesh提供对AI服务的集中访问,包括保护API密钥,这允许对LLM服务的受控访问,并简化了应用程序开发和维护,因为密钥没有硬编码到应用程序中。

4.成本和性能控制

LLMMesh监视LLM的每次查询的成本,并按应用程序和服务聚合成本。这使团队能够预测成本,并就服务使用情况做出明智的决定。

对于性能监视,LLM-Mesh监视LLM服务和提供商的往返性能,以便团队能够诊断问题并根据应用程序需求和SLA选择最佳服务。此外,缓存对常见查询的响应可以避免重新生成响应,从而节省成本并提高性能。

5.检索增强生成和矢量数据库

LLM Mesh包括标准应用程序开发组件和跨多个应用程序使用的功能,例如,检索增强生成(RAG)。RAG正成为将公司内部知识融入LLM响应的标准方式。

RAG的工作原理是将您的内部知识(如产品目录、支持知识库等)索引到一个称为Vector Store的专门数据结构中。在查询时,Vector Store会根据用户查询搜索最合适的内容片段,并将其注入提交给LLM的提示中,确保LLM能够生成将您的内部知识考虑在内的答案。LLMMesh提供了与VectorStores的集成,并在不需要代码的情况下实现了整个RAG模式。

- 登录 发表评论

- 31 次浏览

最新内容

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago