category

在微软,信任是我们所做一切的基础。随着越来越多的组织在Dynamics 365和Power Platform中采用Copilot,我们致力于帮助每个人负责任地使用人工智能。我们通过确保我们的人工智能产品按照我们的负责任人工智能标准提供最高级别的安全性、合规性和隐私性来实现这一点,该标准是我们安全部署人工智能技术的框架。

花点时间回顾一下我们正在采取的最新步骤,以帮助您的组织在我们的安全、安保和信任原则的指导下安全地部署Copilot。

Copilot架构和负责任的人工智能原则正在发挥作用

让我们从Copilot的工作原理开始,它如何保护您的业务数据安全并遵守隐私要求,以及它如何负责任地使用生成式人工智能。观看此视频以快速浏览。

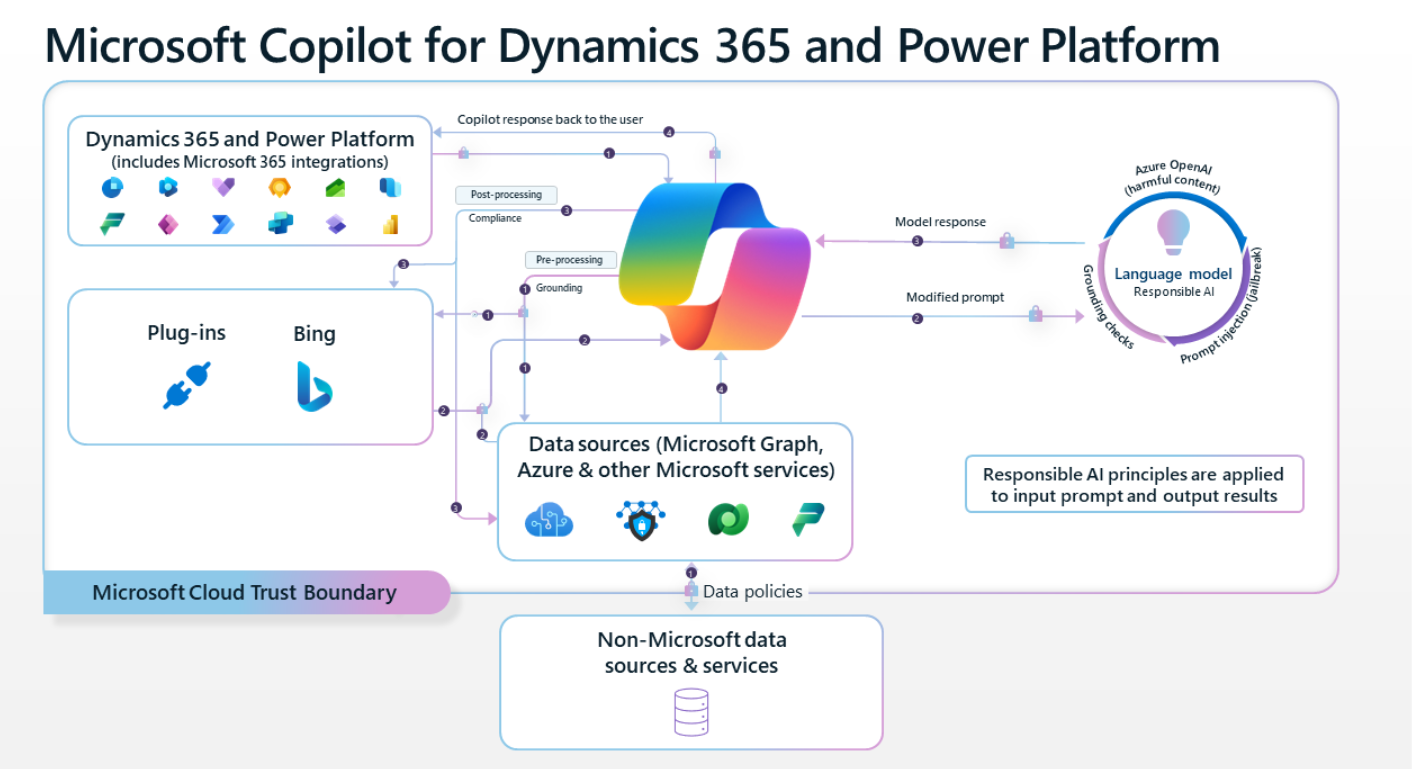

首先,Copilot在Dynamics 365或Power Platform中收到用户的提示。此提示的形式可以是用户在聊天窗格中键入的问题,也可以是操作,例如选择标记为“创建电子邮件”的按钮

Copilot使用一种称为“基础”的方法来处理提示,其中可能包括从Microsoft Nexus、Microsoft Graph或外部源检索数据。接地提高了提示的相关性,因此用户得到的响应更适合他们的任务。与Copilot的交互是针对每个用户的。这意味着Copilot只能访问当前用户有权访问的数据。

Copilot使用Azure OpenAI服务访问强大的生成式AI模型,这些模型能够理解自然语言输入,并以适当的形式向用户返回响应。例如,响应可能是聊天消息、电子邮件或图表的形式。用户在采取任何行动之前,应始终查看响应。

Copilot如何使用您的专有业务数据

响应基于您的业务内容和业务数据。Copilot可以实时访问您的内容和上下文,以生成精确、相关且基于您的业务数据的答案,以确保准确性和特异性。这种实时访问通过我们的WAX平台(包括所有Power platform连接器)进行,遵守贵组织制定的数据丢失预防和其他安全政策。我们遵循检索增强生成(RAG)的模式,通过在发送给模型的提示中添加动态基础数据来增强语言模型的能力。我们的系统使用我们自己的嵌入索引动态查找相关的数据模式,然后使用语言模型将用户的问题转换为我们可以在记录系统上运行的查询。

我们不会使用您的数据来训练语言模型。我们相信,根据微软的数据隐私政策,我们客户的数据就是他们的数据。基于人工智能的语言模型是在庞大但有限的数据语料库上训练的,但通过微软Graph和微软服务访问的提示、响应和数据不会用于训练用于Dynamics 365的Copilot或供其他客户使用的Power Platform功能。此外,这些模型并没有通过您的使用得到改进。这意味着您的数据只能由组织内的授权用户访问,除非您明确同意其他访问或使用。

Copilot如何保护业务信息和数据

企业级AI,由Azure OpenAI服务提供支持。Copilot由可信且合规的Azure OpenAI服务提供支持,该服务提供了强大的企业级安全功能。这些功能包括内容过滤,以识别和阻止有害内容的输出,并防止及时注入(越狱攻击),这是一种用户提示,会促使生成式人工智能模型以训练不到的方式行事。Azure人工智能服务旨在加强数据治理和隐私,并遵守微软严格的数据保护和隐私标准。Azure OpenAI还支持企业功能,如Azure策略和Microsoft Defender for Cloud基于AI的安全建议,满足客户管理的数据加密密钥和强大的治理功能的合规要求。

基于微软全面的安全、隐私和合规方法构建。Copilot已集成到微软Dynamics 365和Power Platform中。它会自动继承贵公司所有有价值的安全、合规和隐私政策和流程。Copilot托管在Microsoft Cloud Trust Boundary内,并遵守全面、行业领先的合规性、安全性和隐私实践。我们对Copilot数据的处理反映了我们对其他客户数据的处理,使您在决定是否保留数据和确定要保留的特定数据元素方面拥有完全的自主权。

客户数据受到多种形式的保护。客户数据受到几种技术和流程的保护,包括各种形式的加密。服务端技术对静止和传输中的组织内容进行加密,以实现强大的安全性。连接受到传输层安全性(TLS)的保护,Dynamics 365、Power Platform和Azure OpenAI之间的数据传输通过Microsoft骨干网进行,确保了可靠性和安全性。当数据在网络上移动时,Copilot使用行业标准的安全传输协议——在用户设备和Microsoft数据中心之间或数据中心内部。

观看James Oleinik的演示文稿[ presentation by James Oleinik],深入了解Copilot如何允许用户在其上下文中安全地与业务数据交互,帮助确保数据在Microsoft Cloud Trust Boundary内得到保护。您还将了解我们为确保Copilot对您的员工和数据安全而采取的措施,例如Copilot如何将业务数据与语言模型隔离开来,以免重新训练AI模型。

旨在保护租户、组和个人数据。我们知道数据泄露是客户关注的问题。除非您的租户管理员选择与我们共享数据,否则Microsoft AI模型不会接受培训,也不会从您的租户数据或提示中学习。在您的环境中,您可以通过设置的权限来控制访问。身份验证和授权机制将对共享模型的请求隔离在租户之间。Copilot使用只有您才能访问的数据。您的数据不可供他人使用。

致力于负责任地构建人工智能

随着您的组织探索用于Dynamics 365和Power Platform的Copilot,我们致力于提供最高级别的安全、隐私、合规和监管承诺,帮助您自信地转型为人工智能驱动的企业。

了解更多关于Copilot和负责任的人工智能

- Trust and responsible AI in Copilot for Dynamics 365 and Copilot in Power Platform

- Copilot data security and privacy for Dynamics 365 and Power Platform FAQ

- Copilot availability

- Microsoft Responsible AI Standard

- How other organizations are using Copilot to improve operational efficiency and customer experiences

- Responsible AI FAQ for Microsoft Power Platform

- Responsible AI FAQ for Dynamics 365

- 登录 发表评论

- 25 次浏览

最新内容

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago

- 1 month 2 weeks ago