安全技术

视频号

微信公众号

知识星球

- 209 次浏览

【安全技术】可信的执行环境

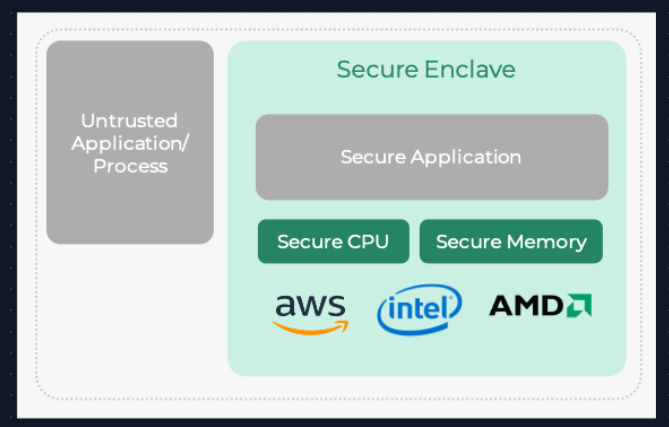

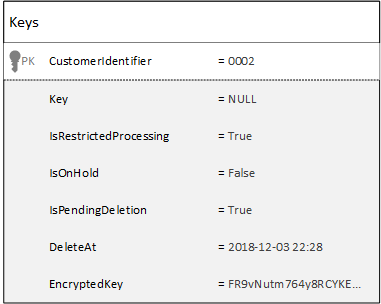

可信执行环境(TEE)是主处理器的安全区域。它保证加载在内部的代码和数据在保密性和完整性方面受到保护,数据完整性-当TEE外部的任何实体处理数据时,防止未经授权的实体更改数据,代码完整性-TEE中的代码不能被未经授权实体替换或修改,也可能是计算机所有者本身,如SGX中描述的某些DRM方案。这是通过实现独特、不可变和机密的体系结构安全来实现的,如Intel®Software Guard Extensions(Intel®SGX),它提供基于硬件的内存加密,隔离内存中的特定应用程序代码和数据。Intel®SGX允许用户级代码分配称为enclaves的私有内存区域,这些内存区域旨在防止以更高权限级别运行的进程。[1] [2][3]作为隔离执行环境的TEE提供了安全特性,例如隔离执行、使用TEE执行的应用程序的完整性以及其资产的机密性。[4] 一般来说,TEE提供的执行空间为设备上运行的受信任应用程序提供了比富操作系统(OS)更高级别的安全性,并比“安全元素”(SE)提供了更多功能。

历史

开放移动终端平台(OMTP)在其“高级可信环境:OMTP TR1”标准中首次定义了TEE,将其定义为“提供支持应用程序所需设施的一组硬件和软件组件”,必须满足两个定义的安全级别之一的要求。第一个安全级别Profile 1仅针对软件攻击,而Profile 2针对软件和硬件攻击。[5]

基于ARM TrustZone技术的商业TEE解决方案符合TR1标准,随后推出,例如Trusted Logic开发的Trusted Foundations。[6]

OMTP标准的工作于2010年中期结束,当时该集团过渡到批发应用社区(WAC)。[7]

OMTP标准,包括那些定义TEE的标准,由GSMA托管

细节

TEE通常由硬件隔离机制和在该隔离机制之上运行的安全操作系统组成,然而,该术语通常用于表示受保护的解决方案。[9] [10][11][12]虽然GlobalPlatform TEE需要硬件隔离,但其他公司(如EMVCo)使用术语TEE指硬件/软件,仅指基于软件的解决方案。[13] FIDO在基于硬件隔离的TEE受限操作环境中使用TEE概念。[14] 只有在TEE中运行的受信任应用程序才能访问设备的主处理器、外围设备和内存的全部功能,而硬件隔离保护这些设备免受在主操作系统中运行的用户安装应用程序的影响。TEE内的软件和加密隔离可相互保护其中包含的受信任应用程序。[15]

服务提供商、移动网络运营商(MNO)、操作系统开发人员、应用程序开发人员、设备制造商、平台提供商和硅供应商是围绕TEE开展标准化工作的主要利益相关者。

为了防止用用户控制的软件模拟硬件,使用了所谓的“硬件信任根”。这是一组在制造过程中直接嵌入芯片的私钥;移动设备上通常使用eFuse等一次性可编程存储器。即使在设备重置后,这些参数也无法更改,它们的公共对应项与属于受信任方(通常是芯片供应商)的公钥的非机密哈希一起驻留在制造商数据库中,用于在执行加密操作和控制访问的电路旁签署受信任固件。硬件的设计方式可以防止所有未经受信任方密钥签名的软件访问特权功能。供应商的公钥在运行时提供并哈希;然后将该散列与芯片中嵌入的散列进行比较。如果哈希匹配,则公钥用于验证受信任的供应商控制固件的数字签名(例如安卓设备上的引导加载程序链或SGX中的“架构飞地”)。然后,可信固件用于实现远程认证。[16]

当应用程序被证明时,它的不受信任组件将其受信任组件加载到内存中;受信任的应用程序受到保护,不会被硬件上不受信任的组件修改。不受信任方从验证器的服务器请求nonce,并将其用作加密身份验证协议的一部分,以证明受信任应用程序的完整性。证据被传递给验证者,验证者对其进行验证。无法在模拟硬件(即QEMU)中计算有效证明,因为为了构造它,需要访问烘焙到硬件中的密钥;只有受信任的固件可以访问这些密钥和/或从中派生或使用它们获得的密钥。因为只有平台所有者才能访问铸造厂记录的数据,所以验证方必须与供应商设置的服务进行交互。如果方案实施不当,芯片供应商可以跟踪在哪个芯片上使用了哪些应用程序,并通过返回表明身份验证未通过的消息选择性地拒绝服务。[17]

为了模拟硬件,使其能够非法通过远程身份验证,攻击者必须从硬件中提取密钥,因为执行该硬件所需的设备和技术技能非常昂贵。例如,使用聚焦离子束、扫描电子显微镜、微探针和芯片去封装[18][19][20][21][22][23],或者甚至不可能,如果硬件的设计方式使得逆向工程破坏了密钥。在大多数情况下,每个硬件的密钥都是唯一的,因此从一个芯片提取的密钥不能被其他芯片使用(例如,物理上不可识别的功能[24][25])。

虽然所有权剥夺不是TEE的固有属性(系统设计可能只允许首先获得设备所有权的用户控制系统),但实际上,消费电子产品中的所有此类系统都是有意设计的,以允许芯片制造商控制对认证及其算法的访问。它允许制造商仅向与制造商签订(通常是商业)业务协议的软件开发人员授予访问TEE的权限,并允许使用诸如虚拟化和DRM之类的用例。

使用

TEE有许多用例。虽然并非所有可能的用例都利用所有权剥夺,但TEE通常正是用于此目的。

高级内容保护/数字版权管理

注:许多TEE文献在“优质内容保护”的定义下涵盖了这个主题,这是许多版权所有者的首选术语。高级内容保护是数字版权管理(DRM)的一个特定用例,在一些社区(如自由软件基金会)中存在争议。[26]版权持有人广泛使用它来限制最终用户消费4K高清电影等内容的方式。

TEE是一个合适的环境,用于保护智能手机、平板电脑和高清电视等连接设备上的数字编码信息(例如高清电影或音频)。这种适用性源于TEE能够阻止设备所有者读取存储的机密,以及TEE与设备上的显示器和/或子系统之间通常存在受保护的硬件路径这一事实。

TEE用于在内容位于设备上时保护内容:虽然内容在传输或流式传输过程中通过使用加密进行保护,但一旦内容在设备上解密,TEE将通过确保解密的内容不会暴露在未经应用程序开发人员或平台供应商批准的环境中来保护内容。

移动金融服务

移动商务应用程序,例如:移动钱包、点对点支付、非接触式支付或使用移动设备作为销售点(POS)终端,通常都有明确的安全要求。TEE通常可与近场通信(NFC)、SE和可信后端系统结合使用,以提供进行金融交易所需的安全性

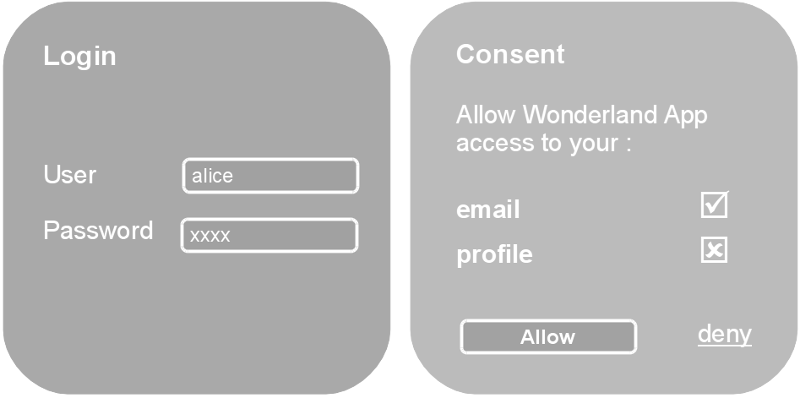

在某些情况下,需要与最终用户进行交互,这可能需要用户向移动操作系统公开PIN、密码或生物识别码等敏感信息,作为验证用户身份的手段。TEE可选地提供可用于在移动设备上构造用户身份验证的可信用户界面。

随着加密货币的兴起,TEE越来越多地被用于实现加密钱包,因为它们能够比常规操作系统更安全地存储令牌,并可以提供必要的计算和身份验证应用程序。[27]

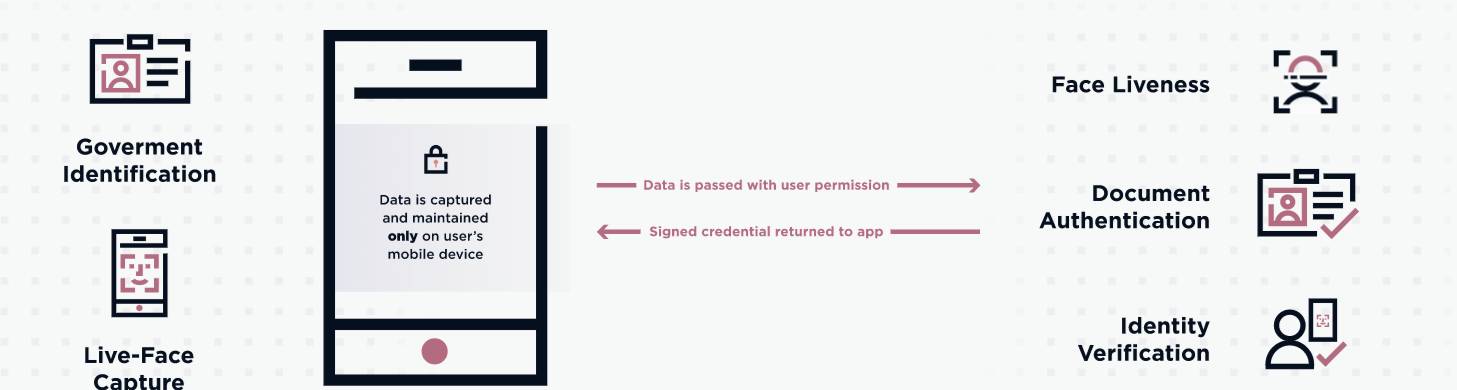

认证

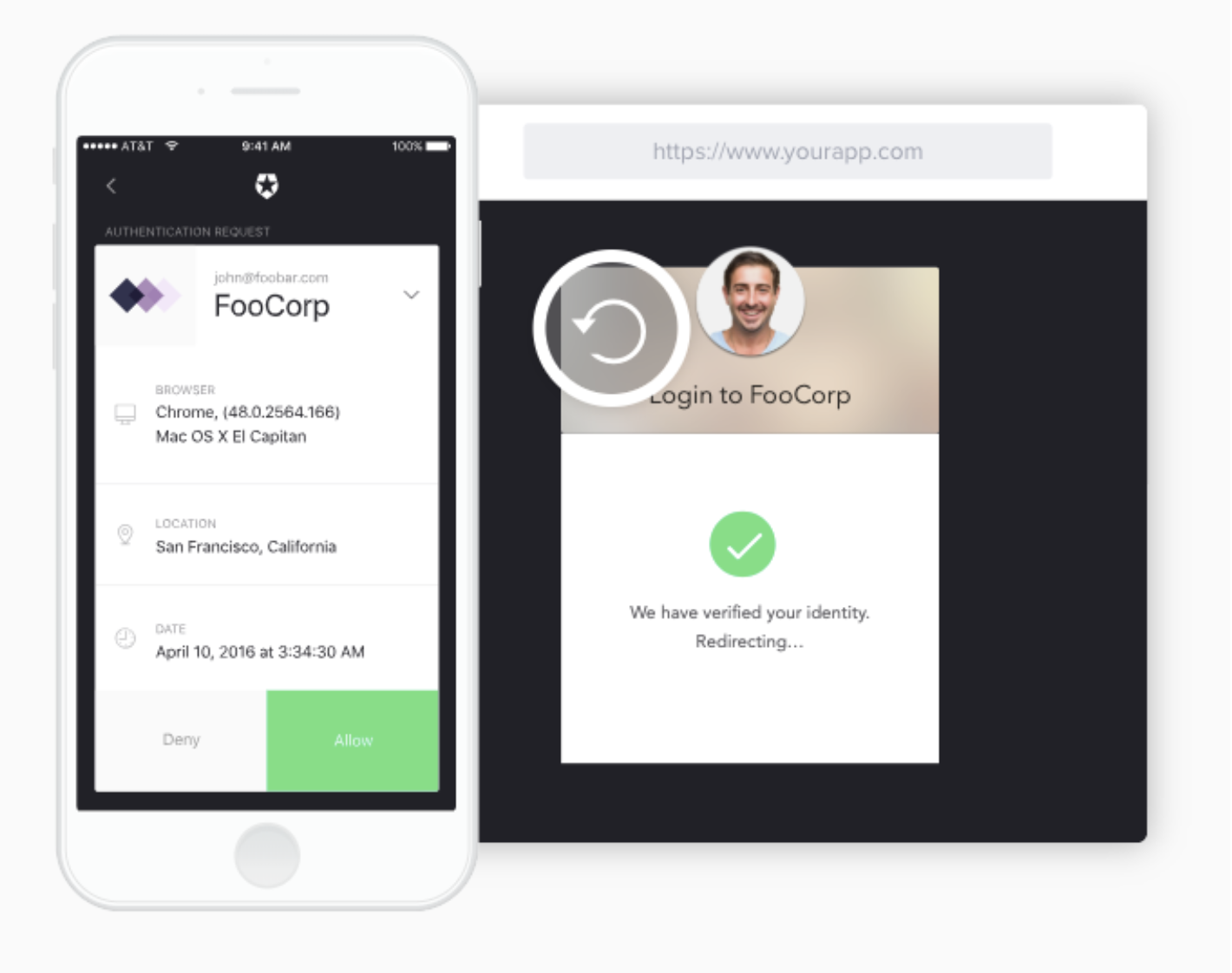

TEE非常适合支持生物识别ID方法(面部识别、指纹传感器和语音授权),这可能比PIN和密码更容易使用,更难窃取。身份验证过程通常分为三个主要阶段:

- 将参考“模板”标识符存储在设备上,以便与下一阶段提取的“图像”进行比较。

- 提取“图像”(例如扫描指纹或捕获语音样本)。

- 使用匹配引擎比较“图像”和“模板”。

TEE是移动设备中一个很好的区域,可以容纳匹配引擎和认证用户所需的相关处理。该环境旨在保护数据,并针对移动操作系统中的非安全应用程序建立缓冲区。这种额外的安全性有助于满足服务提供商的安全需求,并降低手机开发商的成本。

企业、政府和云

政府、企业和云服务提供商可以使用TEE安全处理移动设备和服务器基础设施上的机密信息。TEE对移动操作系统中产生的软件攻击提供了一定程度的保护,并有助于控制访问权限。它通过存储敏感的“可信”应用程序来实现这一点,这些应用程序需要与移动操作系统和可能存在的任何恶意恶意软件隔离和保护。通过利用TEE提供的功能和安全级别,政府和企业可以放心,员工使用自己的设备是安全可靠的。同样,基于服务器的TEE有助于抵御针对后端基础设施的内部和外部攻击。

安全的模块化编程

随着软件资产和重用的增加,模块化编程通过将功能分解为小的独立模块,成为设计软件架构的最高效的过程。由于每个模块都包含执行其所需功能所需的一切,因此TEE允许组织具有高可靠性和安全性的完整系统,同时防止每个模块受到其他模块的漏洞。

为了让模块进行通信和共享数据,TEE提供了在模块之间安全地发送/接收有效负载的方法,使用诸如对象序列化之类的机制以及代理。

参见基于组件的软件工程

TEE操作系统

| Company | Product | Hardware Used | API Standard | Certification type | References |

|---|---|---|---|---|---|

| Alibaba | Cloud Link TEE | GlobalPlatform | Full | [28] | |

| Apple | iOS Secure Enclave | Separate processor | Proprietary | [29] | |

| BeanPod | Arm TrustZone | GlobalPlatform | [30] | ||

| Huawei | iTrustee | Arm TrustZone | GlobalPlatform | Full | [31] |

| Trusty | ARM / Intel | Proprietary | [32] | ||

| Linaro | OPTEE | Arm TrustZone | GlobalPlatform | [33] | |

| Qualcomm | QTEE | ARM TrustZone | GlobalPlatform + Proprietary | [34] | |

| Samsung | TEEgris | Arm TrustZone | GlobalPlatform | Full | [35] |

| TrustKernel | T6 | Arm / Intel | GlobalPlatform | [36] | |

| Trustonic | Kinibi | Arm TrustZone | GlobalPlatform | Full | [37] |

| Trustonic | SW TEE | SW TEE on | GlobalPlatform | [37] | |

| Watchdata | WatchTrust | Arm TrustZone | GlobalPlatform | Full | [38] |

硬件支持

以下硬件技术可用于支持TEE实施:

- AMD:

- ARM:

- IBM:

- IBM Secure Service Container,[45] formerly zACI, first introduced in IBM z13 generation machines (including all LinuxONE machines) in driver level 27.[46]

- IBM Secure Execution,[47] introduced in IBM z15 and LinuxONE III generation machines on April 14, 2020.

- Intel:

- Trusted Execution Technology

- SGX Software Guard Extensions[48]

- "Silent Lake" (available on Atom processors)[49][50][51]

- RISC-V:

See also[edit]

- Open Mobile Terminal Platform

- Trusted Computing Group

- FIDO Alliance

- Java Card

- Intel Management Engine

- Intel LaGrande

- Software Guard Extensions

- AMD Platform Security Processor

- Trusted Platform Module

- ARM TrustZone

- NFC Secure Element

- Next-Generation Secure Computing Base

本文:

- 238 次浏览

【网络安全标准】网络安全标准和框架

视频号

微信公众号

知识星球

什么是网络安全标准?

网络安全标准是组织可以用来改善其网络安全态势的一套指导方针或最佳实践。

组织可以使用网络安全标准来帮助他们识别和实施适当的措施,以保护他们的系统和数据免受网络威胁。标准还可以为如何应对网络安全事件和从中恢复提供指导。

网络安全框架通常适用于所有组织,无论其规模、行业或部门如何。本页详细介绍了常见的网络安全合规标准,这些标准为任何网络安全战略奠定了坚实的基础。

DFARS(国防部联邦采购条例补充)

DFARS(Defense Federal Acquisition Regulation Supplement)是国防部发布的一套法规,对《联邦采购条例》进行了补充。DFARS为国防部获取物资和服务提供指导和程序。

与国防部有业务往来的国防部政府采购官员、承包商和分包商必须遵守DFARS。

FISMA(联邦信息安全管理法案)

FISMA(联邦信息安全管理法案)是一项美国联邦法律,作为2002年电子政府法案的第三章颁布。该法律为确保所有行政部门机构的信息和信息系统的安全建立了一个全面的框架。

FISMA旨在加强联邦机构、NIST和OMB(管理和预算办公室)内部的信息安全。它要求联邦机构实施信息安全计划,以确保其信息和It系统的机密性、完整性和可用性,包括由其他机构或承包商提供或管理的信息和信息系统。

HIPAA(健康保险便携性和责任法案)

HIPAA(健康保险便携性和责任法案)是一套保护患者健康信息隐私的联邦法规。HIPAA适用于所有形式的健康信息,包括纸质记录、电子记录和口头交流。

它旨在让人们在换工作时更容易保留健康保险,保护医疗保健信息的机密性和安全性,并帮助医疗保健行业控制其管理成本。

ISO 22301

ISO 22301是一项国际标准,概述了组织如何确保业务连续性并保护自己免受灾难的影响。本标准为全面的BCMS(业务连续性管理系统)提供了一个框架。它可以由任何组织使用,无论其规模、行业或位置如何。

ISO/IEC 27001

ISO 27001是一项信息安全的国际标准,为管理敏感的公司信息提供了一个框架。该标准包括开发ISMS(信息安全管理系统)、实施安全控制和进行风险评估的要求。

该标准的框架旨在帮助组织在一个地方统一、一致且经济高效地管理其安全实践。

ISO/IEC 27002

ISO 27002是信息安全管理的实施规范。它就如何在组织内实施安全控制提供了指导和建议。ISO 27002支持ISO 27001标准,该标准提供了ISMS的要求。

ISO/IEC 27031

ISO 27031是为业务连续性做好ICT(信息和通信技术)准备的标准。它就各组织如何使用信息和通信技术来保护其业务运营并确保在发生事故或灾难时的连续性提供了指导。

遵守ISO 27031有助于组织了解信息和通信技术服务面临的威胁,确保在发生意外事件时的安全。

ISO/IEC 27032

ISO 27032是国际公认的标准,为组织提供网络安全指导。该标准旨在帮助组织保护自己免受网络攻击,并管理与技术使用相关的风险。它基于风险管理方法,并就如何识别、评估和管理网络风险提供指导。该标准还包括事故响应和恢复指南。

ISO/IEC 27701

ISO 27701规定了基于ISO 27001要求的PIMS(隐私信息管理系统)要求。它由一组特定于隐私的要求、控制目标和控制进行扩展。

实施了ISO 27001的组织可以使用ISO 27701将其安全工作扩展到隐私管理。这有助于证明遵守数据保护法,如《加利福尼亚隐私权法案》(CPRA)和《欧盟通用数据保护条例》(GDPR)。

NIST CSF(网络安全框架)

NIST CSF(美国国家标准与技术研究所网络安全框架)是一个自愿框架,为管理网络安全风险提供了一套标准、指南和最佳实践。

该框架有助于组织以结构化和可重复的方式识别、评估和管理其网络安全风险。该框架不是强制性的,但越来越多的组织将其作为改善网络安全态势的自愿措施。

- 34 次浏览

云安全

- 202 次浏览

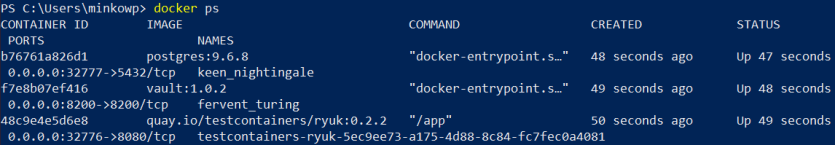

【云安全】10多个用于Docker安全性的顶级开源工具

对于容器安全性,你会发现许多开源工具可以帮助防止像特斯拉那样遭受Kubernetes集群破坏的另一场崩溃。但容器安全性仍然很棘手,因此您需要知道要添加到您的库中的实用程序。

如果您花时间选择最佳的应用程序安全测试工具并确保您的应用程序尽可能安全,那么您不希望它在不安全的容器上运行。幸运的是,那里有商业容器安全产品,但开源项目也可以带你走得很远。许多人专注于审计,跟踪由CIS,国家漏洞数据库和其他机构建立的常见漏洞和暴露(CVE)数据库和基准。然后,工具扫描容器图像,显示其内容,并将内容与已知漏洞的这些清单进行比较。

通过帮助团队在构建管道的早期捕获问题,自动化容器审计以及使用其他容器安全流程可以为企业带来巨大的好处。

虽然有很多开源容器安全工具,但这里有最好的,最成熟的用户社区。

1. Docker Bench for Security

用于根据安全基准审核Docker容器的脚本

面向使用Docker社区版管理容器的开发人员,Docker Bench for Security是Docker的开源脚本,用于审核容器以防止常见的安全最佳实践。

Docker Bench的测试基于行业标准的CIS基准测试,帮助实现手动漏洞测试的繁琐过程自动化。

Docker的安全负责人DiogoMónica将其描述为“测试容器的容器”。您可以按如下方式启动容器:

docker run -it --net host --pid host --userns host --cap-add audit_control \ -e DOCKER_CONTENT_TRUST=$DOCKER_CONTENT_TRUST \ -v /var/lib:/var/lib \ -v /var/run/docker.sock:/var/run/docker.sock \ -v /usr/lib/systemd:/usr/lib/systemd \ -v /etc:/etc --label docker_bench_security \ docker/docker-bench-security

结果会为每个安全配置基准测试发出Info,Warning和Pass日志。您也可以从Docker主机运行此实用程序,通过Docker Compose克隆它,或直接从基本主机运行它。

一个缺点是输出结果缺乏机器可读性。许多社区软件包,如Docker Bench Test,drydock和Actuary,都在Docker Bench上得到改进。

2. Clair

API驱动的静态容器安全性分析,具有庞大的CVE数据库

Clair由CoreOS构建,对容器漏洞进行静态分析。它也用在Quay.io中,这是一个替代Docker Hub的公共容器注册表。

Clair引入了许多漏洞数据源,例如Debian Security Bug Tracker,Ubuntu CVE Tracker和Red Hat Security Data。由于Clair消耗了如此多的CVE数据库,因此其审计非常全面。

Clair首先索引容器图像中的功能列表。然后,使用Clair API,开发人员可以在数据库中查询与特定映像相关的漏洞。

要开始使用Clair,请参阅Running Clair指南。将它部署到Kubernetes集群很容易:

git clone https://github.com/coreos/clair cd clair/contrib/helm cp clair/values.yaml ~/my_custom_values.yaml vi ~/my_custom_values.yaml helm dependency update clair helm install clair -f ~/my_custom_values.yaml

Clair的功能集非常灵活。它允许您添加自己的驱动程序以用于其他行为。此外,对审计特定容器映像进行单独的API调用是一种流畅的,机器驱动的替代方法,可以通过大量的报告日志进行搜索。

3. Cilium

内核层的API感知网络和安全性

Cilium致力于保护网络连接。 Cilium与Linux容器平台(如Docker和Kubernetes)兼容,增加了安全可见性和控制逻辑。

它由BPF(以前称为Berkeley数据包过滤器)提供支持,这是一种Linux内核技术。其低级实现的有趣方面是您可以在不更改应用程序代码或容器配置的情况下应用和更新Cilium安全策略。

CoreOS开发了Cilium,以响应现代微服务开发和快速容器部署的不稳定生命周期。将它与Kubernetes集成是很简单的;以下是如何使用本地更改部署Cilium:

$ kubectl create -f ./cilium.yaml clusterrole "cilium" created serviceaccount "cilium" created clusterrolebinding "cilium" created configmap "cilium-config" created secret "cilium-etcd-secrets" created daemonset "cilium" created $ kubectl get ds --namespace kube-system NAME DESIRED CURRENT READY NODE-SELECTOR AGE cilium 1 1 1 <none> 2m

Cilium周围的支持和社区非常棒。你会找到大量的指南和文档,一个专门的Slack频道,甚至每周一次与项目维护人员进行环聊。

4. Anchore

使用CVE数据和用户定义的策略检查容器安全性的工具

Anchore Engine是一种用于分析容器图像的工具。除了基于CVE的安全漏洞报告之外,Anchore Engine还可以使用自定义策略评估Docker镜像。

策略导致通过或失败结果。策略基于白名单或黑名单,凭据,文件内容,配置类型或其他用户生成的提示。

Anchore打包为Docker容器映像,可以独立运行,也可以在Kubernetes等业务流程平台上运行。它还有用于CI / CD的Jenkins和GitLab集成。

Anchore命令行界面(CLI)是一种操作Anchore Engine的简便方法。例如,此CLI命令返回有关图像内容的详细信息:

anchore-cli image content INPUT_IMAGE CONTENT_TYPE

此示例命令将对映像执行漏洞扫描:

anchore-cli image vuln docker.io/library/debian:latest os

Anchore输出漏洞详细信息,威胁级别,CVE标识符和其他相关信息的列表。由于用户定义的规则是使用Anchore Cloud Service图形用户界面(GUI)创建的,因此它的运行方式与SaaS类似。

5. OpenSCAP Workbench

用于为各种平台创建和维护安全策略的环境

OpenSCAP是IT管理员和安全审核员的生态系统,包括许多开放式安全基准指南,配置基线和开源工具。

在Fedora,Red Hat Enterprise Linux,CentOS或Scientific Linux上运行的人可以将OpenSCAP Workbench安装为GUI,以在虚拟机,容器和映像上运行扫描。使用以下命令安装OpenSCAP Workbench:

#yum install scap-workbench

要根据SCAP策略指南和CVE验证容器,请使用OpenSCAP附带的oscap-docker实用程序。

OpenSCAP以NIST认证的安全内容自动化协议(SCAP)为中心,并提供许多机器可读的安全策略。 OpenSCAP安全指南指出,该项目的目标是“允许多个组织通过避免冗余来有效地开发安全内容”。

由于OpenSCAP比此列表中的其他人更广泛,因此对于希望为整个平台创建安全策略的团队而言,它是一个不错的选择。

6. Dagda

用于扫描Docker容器中的漏洞,特洛伊木马,病毒和恶意软件的工具

Dagda是另一种用于容器安全性静态分析的工具。它的CVE源包括OWASP依赖性检查,Red Hat Oval和攻击性安全漏洞利用数据库。

要使用Dagda扫描Docker容器,首先要使用漏洞数据填充Mongo数据库。执行此命令以分析单个Docker镜像:

python3 dagda.py check --docker_image jboss/wildfly

您可以远程运行它,也可以不断调用它来监视活动的Docker容器。输出显示漏洞数,严重性级别和其他详细信息以帮助修复。

Dagda的一个好处是可以广泛覆盖漏洞数据。这意味着可以直接访问大量更新,全面的漏洞利用集合。它也很灵活,您可以通过CLI和REST API来控制它。

7. Notary

用于通过加密方式委派责任的服务器来提高容器安全性的框架

公证人是事实上的Docker图像签名框架,现在开源其他实现。 Docker开发了它,然后在2017年将其捐赠给了Cloud Native Computing Foundation。

公证就是责任分离;使用Notary,开发人员可以委派角色并在容器之间定义职责。该软件包提供服务器和客户端,以提供发布和验证内容的加密安全方法。

要在本地部署Notary,请通过克隆repo来开始。接下来,使用Docker Compose部署本地配置:

$ docker-compose build $ docker-compose up -d $ mkdir -p ~/.notary && cp cmd/notary/config.json cmd/notary/root-ca.crt ~/.notary

依赖于Update Framework和Go语言作为依赖关系,Notary可以验证容器应用程序映像的加密完整性。

8. Grafaes

用于帮助管理内部安全策略的元数据API

Grafaes可以极大地帮助您创建自己的容器安全扫描项目。该容器安全工具于2017年底宣布,由IBM和Google开发。

开发人员可以使用Grafaes(称为“组件元数据API”)来定义虚拟机和容器的元数据。 IBM的Vulnerability Advisor也集成到项目中。

有关可靠的案例研究,请参阅Shopify如何使用Grafaes管理500,000个容器图像的元数据。与Kritis合作,该团队在使用Grafeas元数据的Kubernetes集群上实施安全策略。

能够快速获取容器元数据有助于加快补救尝试,从而减少从利用到解决的窗口。虽然Grafaes是开源的,但它由大型软件提供商维护 - 这对长期支持是有益的。

9. Sysdig Falco

提供深度容器可见性的行为活动监控

Falco是一种由Kubernetes识别的安全审计工具,由Sysdig开发,强调对容器,主机和网络活动的行为监控。使用Falco,开发人员可以对其基础架构进行连续检查,检测异常情况,并为任何类型的Linux系统调用设置警报。

Falco文档建议用户将Falco作为Docker容器运行。可以使用这些命令安装它。实施后,标准输出Falco警报如下所示:

stdout_output: enabled: true 10:20:05.408091526: Warning Sensitive file opened for reading by non-trusted program

使用Falco监视shell在容器中运行的时间,容器已安装,敏感文件的意外读取,出站网络尝试或其他可疑调用。 Sysdig在此提供了更多容器故障排除材料。

10. Banyanops Collector

Docker容器图像的静态分析框架

在Banyanops的支持下,Collector是一个开源实用程序,可用于“窥视”Docker容器图像文件。使用Collector,开发人员可以收集容器数据,实施安全策略等。

首先,Banyanops可以在私有注册表上运行,也可以作为Docker Hub上的容器运行。 Banyanops还提供可提供更深入数据分析的SaaS产品,因此如果您遇到有限的功能,请注意向上销售。

尊敬的开源

- Dockscan:具有少量提交的安全漏洞扫描程序

- Batten:类似于Docker Bench的审计工具包,但具有非活动支持

- BlackDuck Docker安全性:作为Web服务构建的容器映像安全扫描工具。遗憾的是,目前的形式并未建议使用生产

- Inspec:具有Docker容器测试功能的审计和测试框架

你的旅费可能会改变

由于容器化已经发展成为一种流行的部署方式,因此需要使用适当的安全控制来扩充这些容器是至关重要的。值得庆幸的是,您将找到一个强大的开源安全解决方案生态系统,这些解决方案已针对许多不同的环境进行了定制。

这些工具的整体强度取决于所进行的检查的深度。有效性还取决于CVE数据库和基准本身继续使用新漏洞更新数据并发布新的最佳实践。值得庆幸的是,正在努力缩短零日漏洞利用和容器漏洞检测之间的时间。

开发人员还将倾向于使用具有更好体验的工具,这将减少日志结果中的噪音和重复。这种粒度偏好只能通过反复试验来确定,具体取决于您的构建例程和个人偏好。

原文:https://techbeacon.com/security/10-top-open-source-tools-docker-security

本文:http://pub.intelligentx.net/10-top-open-source-tools-docker-security

讨论:请加入知识星球或者小红圈【首席架构师圈】

- 110 次浏览

【云安全】Amazon API网关增加了对AWS WAF的支持

本文由Heitor Lessa提供,AWS专业解决方案架构师- Serverless

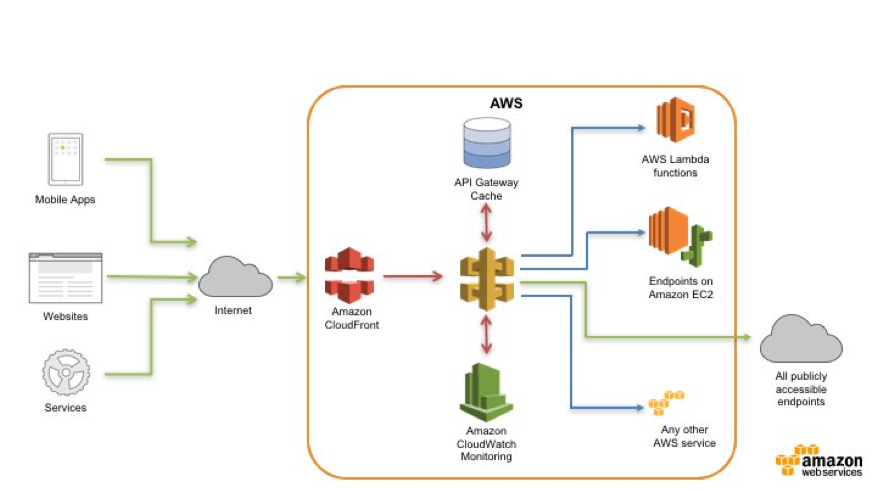

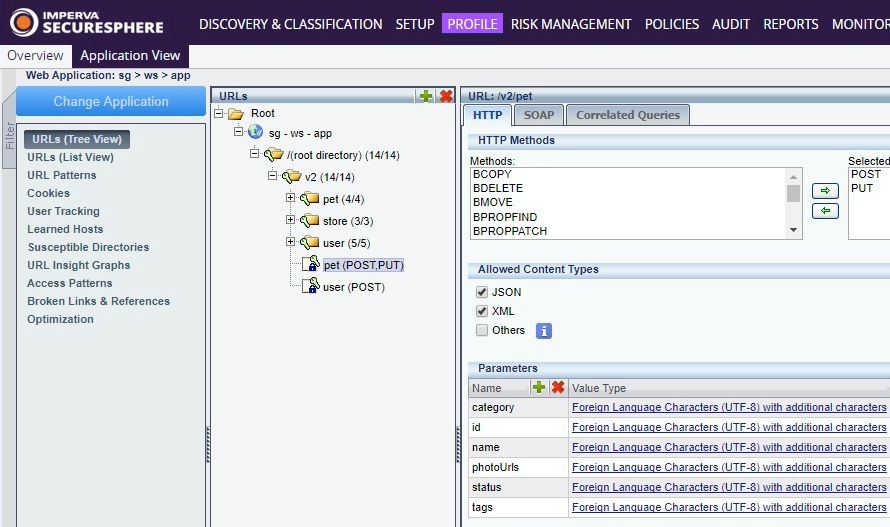

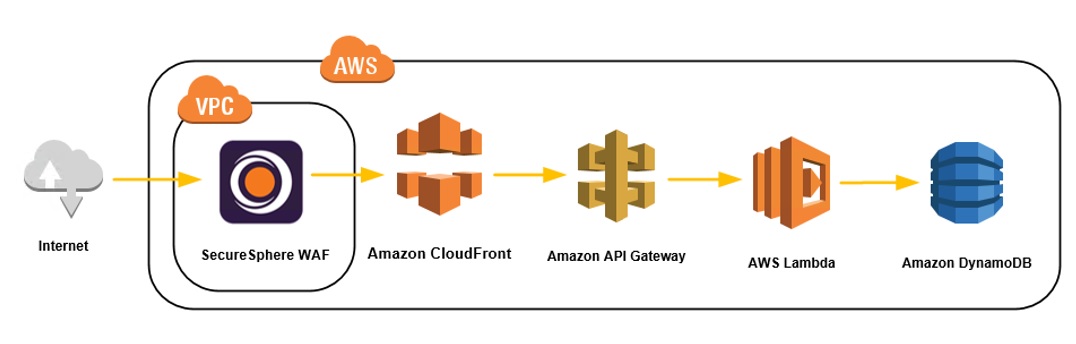

今天,我很兴奋地向您介绍Amazon API网关与AWS WAF的本地集成。以前,如果希望使用AWS WAF在Amazon API网关中保护API,就必须部署一个区域性API端点,并使用自己的Amazon CloudFront发行版。现在,这个新特性允许您提供任何—API网关端点,并使用AWS WAF保护它,而无需配置自己的CloudFront发行版来添加该功能。

在本系列的第1部分中,我描述了如何使用AWS WAF保护API网关提供的API。

在本系列的第2部分中,我描述了如何使用API密钥作为CloudFront发行版和API网关之间的共享秘密,以确保在API网关中对API的公共访问是安全的。这种新的AWS WAF集成意味着不再需要第2部分中描述的方法。

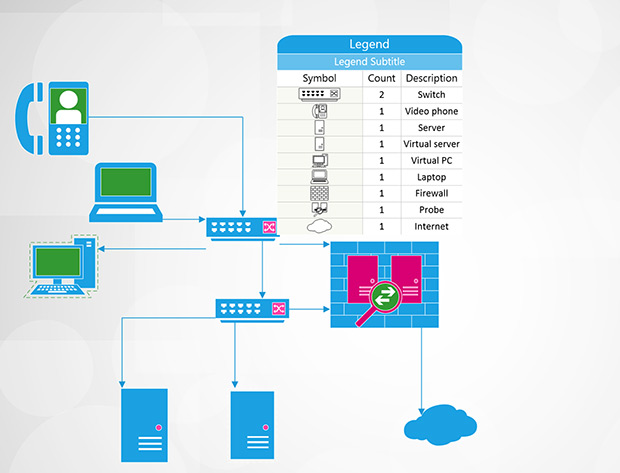

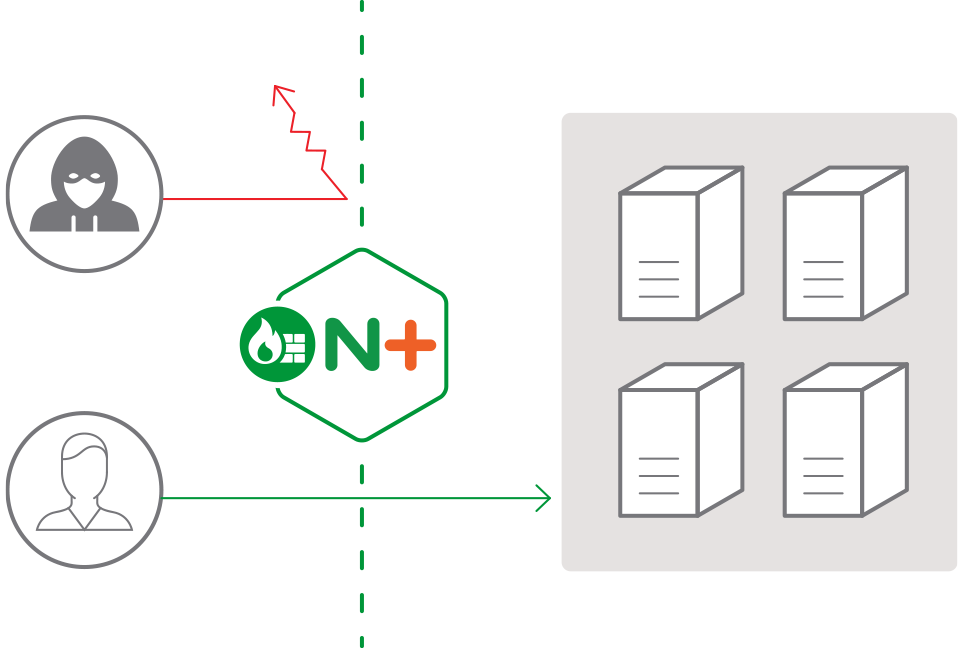

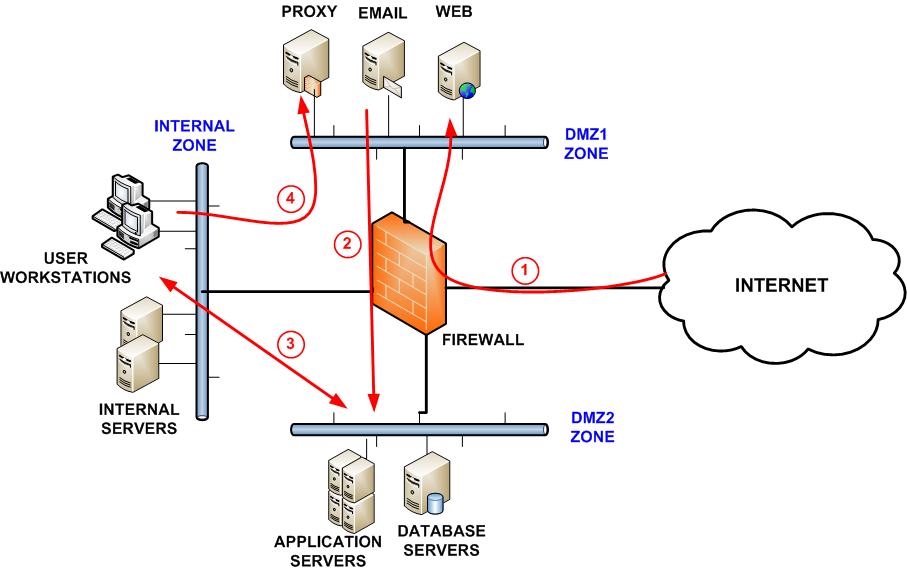

下面的图像描述了在这个特性可用之前和之后在API网关中保护API的方法。

地点:

- AWS WAF仅保护CloudFront端点。

- AWS WAF本地保护Amazon API网关端点。

为Amazon API网关管理的API启用AWS WAF

对于本演练,您可以使用现有的宠物商店API或您可能已经部署的API Gateway中的任何API。您将创建一个新的AWS WAF web ACL,该ACL稍后与您的API网关阶段相关联。

按照以下步骤创建web ACL:

- 打开AWS WAF控制台。

- 选择Create web ACL。

- 对于Web ACL名称,输入ApiGateway-HTTP-Flood-Sample。

- 对于地区,选择美国东部(北弗吉尼亚)。

- 选择Next,直到您达到步骤3:创建规则。

- 选择Create rule并输入HTTP Flood Sample。

- 对于规则类型,选择基于速率的规则。

- 对于速率限制,输入2000并选择Create。

- 对于默认操作,选择“允许不匹配任何规则的所有请求”。

- 选择Review并创建。

- 确认您的选项与下图相似,然后选择Confirm和create next。

您现在可以按照以下步骤为API网关中的现有API启用AWS WAF web ACL:

- 打开Amazon API网关控制台。

- 选择阶段,刺激。

- 在Web应用程序防火墙(Web Application Firewall, WAF)下,选择ApiGateway-HTTP-Flood-Sample(或您刚刚创建的Web ACL)。

- 选择保存更改。

在API网关中测试您的API,现在由AWS WAF保护

AWS WAF提供HTTP洪水保护,这是一个基于速率的规则。当来自客户机的web请求超过可配置阈值时,将自动触发基于速率的规则。阈值由一个IP地址在5分钟内允许的最大传入请求数定义。

在突破这个阈值之后,IP地址的其他请求将被阻塞,直到请求速率低于该阈值为止。对于本例,您将2000个请求定义为基于HTTP洪泛率规则的阈值。

火炮是一个开源的现代负载测试工具包,用于将大量请求直接发送到API网关调用URL,以测试AWS WAF本机集成是否正常工作。

首先,按照以下步骤检索正确的宠物商店API调用URL:

- 打开API网关控制台。

- 在左侧导航窗格中,打开PetStore API。

- 选择stage、选择prod并复制Invoke URL值。

其次,使用cURL查询您的分布,并在触发速率限制规则之前查看API输出:

$ curl -s INVOKE_URL/pets

[

{

"id": 1,

"type": "dog",

"price": 249.99

},

{

"id": 2,

"type": "cat",

"price": 124.99

},

{

"id": 3,

"type": "fish",

"price": 0.99

}

]

然后,用Artillery 在短时间内发送大量请求,触发你的速率限制规则:

$ artillery quick -n 2000 --count 10 INVOKE_URL/pets

使用这个命令,炮兵 artillery 从10个并发用户向PetStore API发送2000个请求。通过这样做,您可以在5分钟内触发速率限制规则。简而言之,我没有在这里发布炮兵输出。

炮兵完成任务后,尝试重新运行cURL命令。你不应该再看到宠物列表:

{“message”:”Forbidden”}

从输出中可以看到,请求被AWS WAF阻塞。当您的IP地址低于请求限制速率时,将从阻塞列表中删除。

结论

正如您所看到的,通过AWS WAF与Amazon API网关的本机集成,您不再需要管理自己的Amazon CloudFront发行版来使用AWS WAF保护您的API。AWS WAF本机集成使此过程无缝。

我希望这篇文章中的信息对你有所帮助。请记住,您现在可以将此集成用于所有Amazon API网关端点(Edge、Regional和Private)。它在下列区域提供:

- US East (N. Virginia)

- US East (Ohio)

- US West (Oregon)

- US West (N. California)

- EU (Ireland)

- EU (Frankfurt)

- Asia Pacific (Sydney)

- Asia Pacific (Tokyo)

原文:https://aws.amazon.com/cn/blogs/compute/amazon-api-gateway-adds-support-for-aws-waf/

本文:http://pub.intelligentx.net/amazon-api-gateway-adds-support-aws-waf

讨论:请加入知识星球或者小红圈【首席架构师圈】

- 93 次浏览

【云安全】什么是机密云?

公共云基础设施内构建的私有云

机密云是在一个或多个公共云内形成的安全机密计算环境。机密云构造中的应用程序、数据和工作负载受到硬件级加密、内存隔离和其他服务的组合保护,这些服务可确保工作负载、数据和平台的完整性。

机密云是在运行时按需创建的。工作负载和数据的运行完全不受内部人员、不良参与者和恶意进程的影响,即使在物理主机出现漏洞的情况下,工作负载的各个方面也能保持安全。

Anjuna Confidential Computing软件将公共云转换为具有最强保护能力的机密云,将任何公共云转换成最安全的计算场所。Anjuna的软件允许应用程序和整个环境在机密云结构内工作,无需修改。

增加软件抽象层和虚拟化层的优势在于,机密云本身不受Intel、AMD、Amazon和ARM开发的众多专有飞地技术和版本的限制。

任何即时安全的应用程序

Anjuna机密计算软件将安全性从专有硬件和公共云实现中抽象出来,简化了云迁移和多云部署。实际上,任何定制或打包的应用程序都是在机密云中部署和运行的。不需要SDK、重新编译和重新架构。

默认情况下从内部人员和不良参与者中消除攻击面

使用Anjuna Software创建的机密云实际上没有数据攻击面。工作负载在硬件中是孤立的,使它们对坏人和恶意软件不可见。与基于软件的安全和密钥管理系统不同,密钥和其他关键工件永远无法通过公开内存访问。

Anjuna的机密计算软件作为云基础设施的一部分进行了无形部署,远远低于用户和IT流程。这使IT员工能够在无中断的情况下工作,与敏感数据完全隔离,从而降低风险并提高生产率。

所有数据都受保护,无处不在

Anjuna机密计算软件保护扩展到所有使用数据的地方,消除了过度访问,从而加剧了公共云中的内部风险。所有数据,即使是存储和联网的数据,都会使用以硬件为基础、外部管理的加密密钥进行验证和隔离,并完全隔离,以完全缓解甚至是常见的基于内存的攻击。

今日企业就绪

Anjuna软件扩展到多个公共云提供商,以无缝保护传统、打包和高度分布式的云本地应用程序的组合,这些应用程序通常构成企业产品组合。

Anjuna软件无缝集成到现有IT管理系统和流程中。简单的部署和虚拟化使it员工能够在几分钟内将易受攻击的应用程序和数据快速转换为严格控制的资源。第三方集成和API使IT组织能够利用其在关键、SIEM、CARTA、Kubernetes和其他系统上的投资。

为迁移到机密云做好准备

向您的团队提出以下问题:

- 如何保护公共云中的敏感应用程序和数据?

- 您的云提供商正在做什么来解决持续的内部威胁?

- 您是否在数据中心内或通过云提供商接触第三方?

- 如何在不受信任的地区保护您的应用程序和数据?

- 您是否担心政府传票可能要求访问客户数据?

- 您是否愿意重新编写应用程序以利用机密云技术?

- 拥有一个能够自动将关键应用程序和数据移动到安全环境中而无需重写或SDK的解决方案有多重要?

本文:

- 69 次浏览

【云安全】使用Amazon API网关和AWS WAF保护您的API -第2部分

本文由Heitor Lessa提供,AWS专业解决方案架构师- Serverless

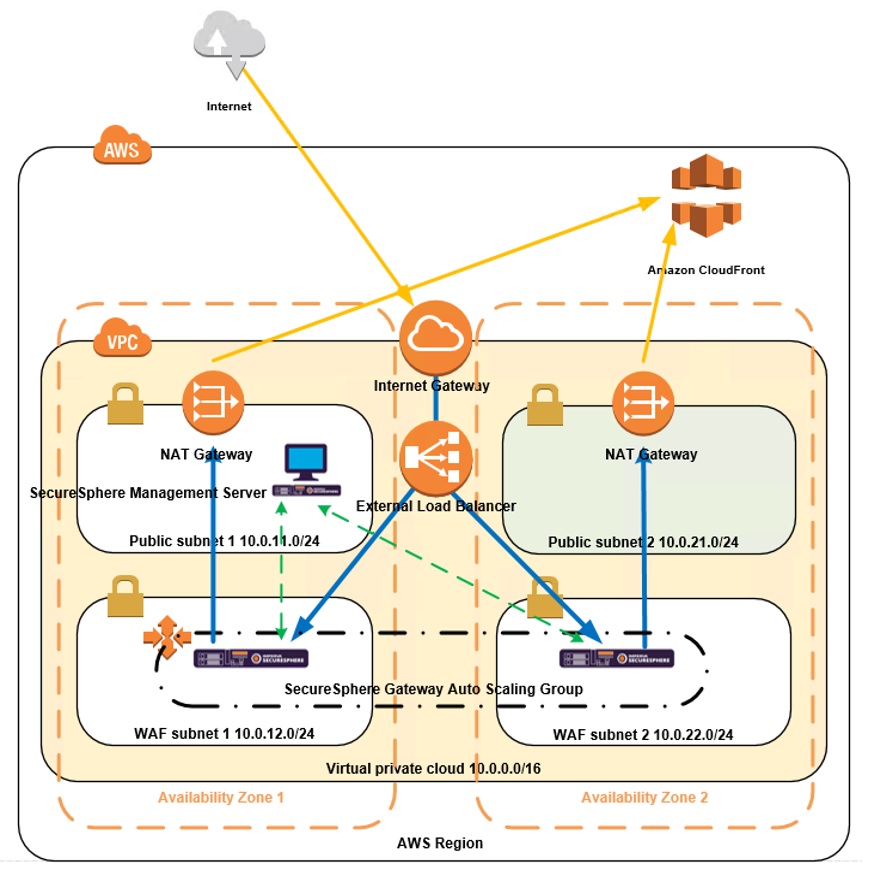

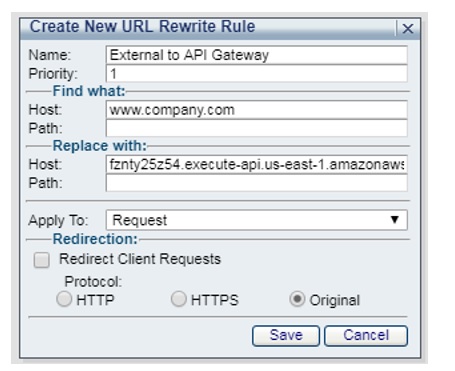

在本博客的第1部分中,我们描述了如何使用AWS WAF保护Amazon API Gateway提供的API。在本博客中,我们将展示如何在Amazon CloudFront分发和API网关之间使用API键,以确保除了已经在API网关中设置的首选授权(AuthZ)机制之外,还可以访问API网关中的API。有关API网关中的AuthZ机制的更多信息,请参见使用Amazon Cognito联合身份、Amazon Cognito用户池和Amazon API网关的安全API访问。

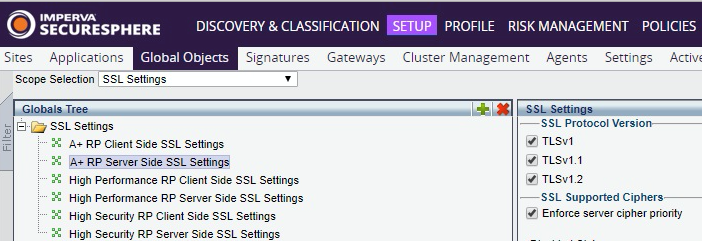

我们还扩展了以前用于自动创建此解决方案的以下必要资源的AWS CloudFormation堆栈:

- API网关使用计划——管理专用于CloudFront的API密钥,以及必要时的节流和计量使用

- AWS Lambda函数——更新AWS CloudFormation堆栈参数时间戳并触发API键旋转

- Amazon CloudWatch事件调度作业——在给定的调度中触发Lambda函数

以下是使用API密钥的替代解决方案,具体取决于您的安全需求:

在CloudFront中使用随机生成的HTTP秘密头,并通过API网关请求验证进行验证

使用Lambda@Edge对传入请求进行签名,并使用API网关Lambda授权器进行验证

需求

要继续,您需要完全的权限来通过AWS CloudFormation创建、更新和删除API网关、CloudFront、Lambda和CloudWatch事件。

扩展现有AWSCloudFormation 堆栈

首先,点击这里下载完整的模板。然后按照以下步骤更新现有的AWS云形成堆栈:

- 转到AWS管理控制台并打开AWS CloudFormation控制台。

- 选择您在第1部分中创建的堆栈,右键单击它,然后选择Update stack。

- 对于选项2,选择“选择文件”并选择下载的模板。

- 填写所需的参数,如下图所示。

以下是关于这些参数的更多信息:

- 发送流量的API网关——除了没有URL模式(https://)之外,我们使用与第1部分相同的API网关URL: cxm45444t9a.execute-api.us- east2.amazonaws.com/prod

- 旋转API键——我们定义了Daily并使用2018-04-03作为时间戳值来追加API键名

继续使用AWS CloudFormation控制台完成操作。更新堆栈可能需要几分钟,因为CloudFront需要时间在所有存在点上传播更改。

在示例宠物商店API中启用API键

当堆栈在后台完成时,让我们在CloudFront将发送流量到的API中启用API键。

- 转到AWS管理控制台并打开API网关控制台。

- 选择您在第1部分中创建的API并选择Resources。

- 在/pets下,选择GET,然后选择Method Request。

- 对于所需的API键,选择下拉菜单并选择true。

- 要保存此更改,请选择突出显示的复选标记,如下图所示。

接下来,我们需要部署这些更改,以便在没有API密钥时发送给/pets的请求失败。

- 选择Actions并选择Deploy API。

- 选择Deployment stage下拉菜单,并选择在第1部分中创建的舞台。

- 添加一个部署描述,例如“在/pets下需要API键”,然后选择Deploy。

当部署成功时,您将被重定向到API Gateway Stage页面。在那里,您可以使用Invoke URL来测试以下请求是否由于没有API密钥而失败。

这一失败是预料之中的,并证明我们部署的更改正在工作。接下来,让我们尝试访问相同的API,但这次是通过CloudFront分发。

- 从AWS管理控制台打开AWS Cloudformation控制台。

- 选择您在第1部分中创建的堆栈,并在左下角选择output。

- 在CFDistribution行上,复制URL。在粘贴新浏览器选项卡或窗口之前,请在其中添加' /pets '。

与我们第一次尝试不使用API键相反,我们从PetStore API接收JSON响应。这是因为CloudFront在将请求转发到PetStore API之前注入了一个API密钥。下图演示了这两种测试:

- 通过CloudFront访问API时请求成功

- 通过API的调用URL直接访问API时,请求失败

这是CloudFront和API网关之间的一个秘密,它可以是任何约定的随机秘密,可以像API密钥一样旋转。但是,重要的是要知道API key是一个跟踪或度量API使用者使用情况的特性。它不是一种安全的授权机制,因此只能与API网关授权器一起使用。

旋转的API密钥

API键会根据更新AWS CloudFormation堆栈时选择的时间表(例如,每日或每月)自动旋转。这就不需要您进行维护或干预。在本节中,我们将解释这个过程是如何工作的,以及如果您想手动触发API键旋转,您可以做些什么。

除了第1部分之外,我们下载并用于更新堆栈的AWS CloudFormation模板还执行了以下操作。

引入一个附加到API密钥名的时间戳参数

Parameters:

Timestamp:

Type: String

Description: Fill in this format <Year>-<Month>-<Day>

Default: 2018-04-02

创建一个API网关密钥,API网关使用计划,将新密钥与作为参数给出的API网关关联,并配置CloudFront分发,以便在将流量转发到API网关时发送一个自定义头

CFDistribution:

Type: AWS::CloudFront::Distribution

Properties:

DistributionConfig:

Logging:

IncludeCookies: 'false'

Bucket: !Sub ${S3BucketAccessLogs}.s3.amazonaws.com

Prefix: cloudfront-logs

Enabled: 'true'

Comment: API Gateway Regional Endpoint Blog post

Origins:

-

Id: APIGWRegional

DomainName: !Select [0, !Split ['/', !Ref ApiURL]]

CustomOriginConfig:

HTTPPort: 443

OriginProtocolPolicy: https-only

OriginCustomHeaders:

-

HeaderName: x-api-key

HeaderValue: !Ref ApiKey

...ApiUsagePlan:

Type: AWS::ApiGateway::UsagePlan

Properties:

Description: CloudFront usage only

UsagePlanName: CloudFront_only

ApiStages:

-

ApiId: !Select [0, !Split ['.', !Ref ApiURL]]

Stage: !Select [1, !Split ['/', !Ref ApiURL]]ApiKey:

Type: "AWS::ApiGateway::ApiKey"

Properties:

Name: !Sub "CloudFront-${Timestamp}"

Description: !Sub "CloudFormation API Key ${Timestamp}"

Enabled: trueApiKeyUsagePlan:

Type: "AWS::ApiGateway::UsagePlanKey"

Properties:

KeyId: !Ref ApiKey

KeyType: API_KEY

UsagePlanId: !Ref ApiUsagePlan

正如在ApiKey资源中所示,我们将给定的时间戳附加到Name中,并在API网关使用计划密钥资源中使用它。这意味着,无论何时时间戳参数发生变化,AWS CloudFormation都会触发资源替换,并更新依赖于该API键的每个资源。在本例中,这包括AWS CloudFront配置和API网关使用计划。

但是在这个例子中,您在本博客开头所选择的轮换计划意味着什么呢?

创建一个计划好的活动来触发给定计划中的Lambda函数

Parameters:

...

ApiKeyRotationSchedule:

Description: Schedule to rotate API Keys e.g. Daily, Monthly, Bimonthly basis

Type: String

Default: Daily

AllowedValues:

- Daily

- Fortnightly

- Monthly

- Bimonthly

- Quarterly

ConstraintDescription: Must be any of the available optionsMappings:

ScheduleMap:

CloudwatchEvents:

Daily: "rate(1 day)"

Fortnightly: "rate(14 days)"

Monthly: "rate(30 days)"

Bimonthly: "rate(60 days)"

Quarterly: "rate(90 days)"Resources:

...

RotateApiKeysScheduledJob:

Type: "AWS::Events::Rule"

Properties:

Description: "ScheduledRule"

ScheduleExpression: !FindInMap [ScheduleMap, CloudwatchEvents, !Ref ApiKeyRotationSchedule]

State: "ENABLED"

Targets:

-

Arn: !GetAtt RotateApiKeysFunction.Arn

Id: "RotateApiKeys"

资源RotateApiKeysScheduledJob显示,在更新AWS CloudFormation堆栈时,通过下拉菜单选择的调度实际上转换为CloudWatch事件规则。这进而触发在相同模板中定义的Lambda函数。

RotateApiKeysFunction:

Type: "AWS::Lambda::Function"

Properties:

Handler: "index.lambda_handler"

Role: !GetAtt RotateApiKeysFunctionRole.Arn

Runtime: python3.6

Environment:

Variables:

StackName: !Ref "AWS::StackName"

Code:

ZipFile: !Sub |

import datetime

import osimport boto3

from botocore.exceptions import ClientErrorsession = boto3.Session()

cfn = session.client('cloudformation')

timestamp = datetime.date.today()

params = {

'StackName': os.getenv('StackName'),

'UsePreviousTemplate': True,

'Capabilities': ["CAPABILITY_IAM"],

'Parameters': [

{

'ParameterKey': 'ApiURL',

'UsePreviousValue': True

},

{

'ParameterKey': 'ApiKeyRotationSchedule',

'UsePreviousValue': True

},

{

'ParameterKey': 'Timestamp',

'ParameterValue': str(timestamp)

},

],

}def lambda_handler(event, context):

""" Updates CloudFormation Stack with a new timestamp and returns CloudFormation response"""

try:

response = cfn.update_stack(**params)

except ClientError as err:

if "No updates are to be performed" in err.response['Error']['Message']:

return {"message": err.response['Error']['Message']}

else:

raise Exception("An error happened while updating the stack: {}".format(err))

return response

这个Lambda函数所做的一切就是通过API触发AWS CloudFormation堆栈更新(与您通过控制台所做的完全相同,但是以编程方式进行的),并更新时间戳参数。因此,它会旋转API键和CloudFront分发配置。

这为您提供了足够的灵活性,可以在任何时候更改API key rotation schedule,而无需维护或编写任何代码。您还可以手动更新堆栈,并通过更新AWS CloudFormation堆栈的时间戳参数来旋转键。

下一个步骤

我们希望你觉得这个博客的信息有帮助。您可以使用它来了解如何创建一种机制,只允许从CloudFront到API网关的通信,并避免绕过第1部分设置的AWS WAF规则。

关于这个解决方案,请记住以下几点:

- 它假设您已经拥有一个由API网关管理的强大AuthZ机制来控制对API的访问。

- 在此解决方案中创建的API网关使用计划和其他资源只适用于在相同帐户中创建的API (ApiUrl参数)。

- 如果您已经使用API键来跟踪API的使用情况,请考虑使用以下任何一种解决方案作为替代:

- 在CloudFront源配置中使用随机HTTP头值,并使用API网关请求模型验证来验证它,而不是单独使用API键。

- 结合Lambda@Edge和API网关自定义授权器,使用只有二者知道的共享秘密对传入的请求进行签名和验证。这是一种更先进的技术。

本文:http://pub.intelligentx.net/protecting-your-api-using-amazon-api-gateway-and-aws-waf-part-2

讨论:请加入知识星球或者小红圈【首席架构师圈】

- 65 次浏览

【应用安全】保护您的API使用亚马逊API网关和AWS WAF -第一部分

本文由AWS解决方案架构师Thiago Morais提供

当您构建web应用程序或在外部公开任何数据时,您可能会寻找一个平台,在这个平台上您可以构建高度可伸缩、安全且健壮的REST api。由于API是公开的,所以有许多最佳实践可以为使用API的用户提供安全机制。

Amazon API Gateway处理接受和处理多达数十万个并发API调用所涉及的所有任务,包括流量管理、授权和访问控制、监视和API版本管理。

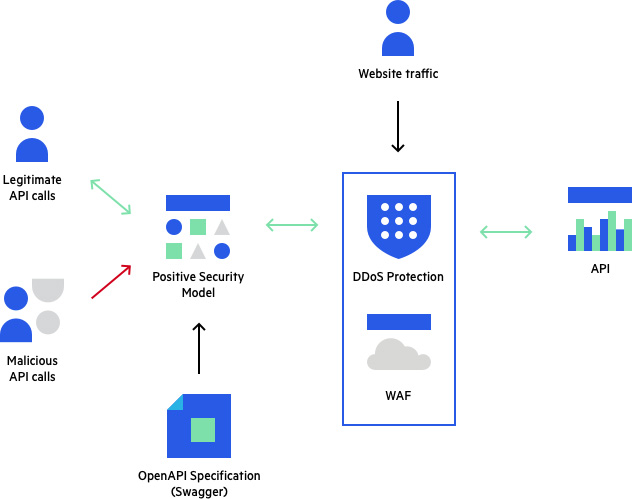

在本文中,我将向您展示如何利用API网关中的区域性API端点特性,以便您可以创建自己的Amazon CloudFront发布,并使用AWS WAF保护您的API。

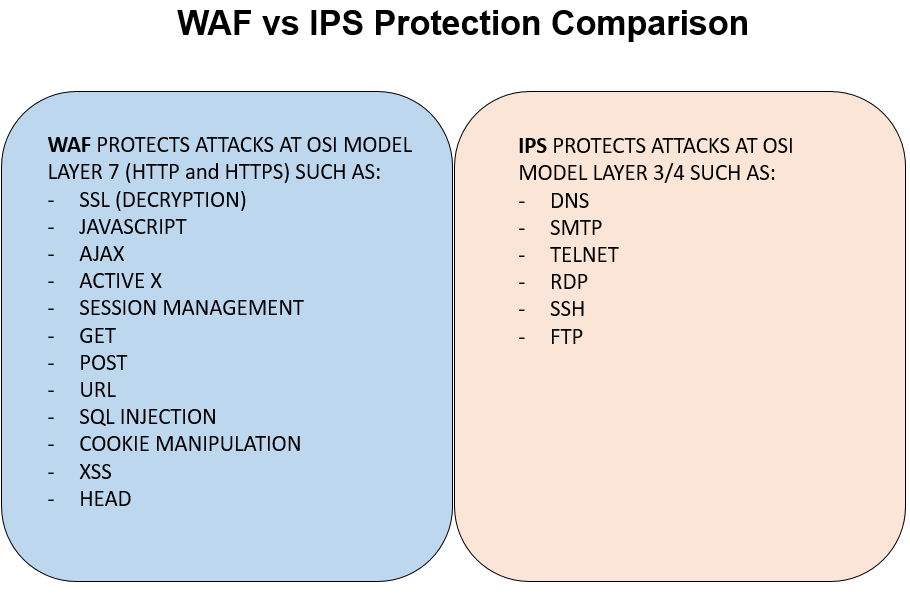

AWS WAF是一个web应用程序防火墙,它帮助保护您的web应用程序免受常见web攻击的影响,这些web攻击可能会影响应用程序的可用性、危害安全性或消耗过多的资源。

当您使您的api公开可用时,您就暴露在试图以几种方式利用您的服务的攻击者面前。AWS安全团队发布了一个使用AWS WAF的白皮书解决方案,即如何减轻OWASP的十大Web应用程序漏洞。

区域API端点

边缘优化API是通过由API网关创建和管理的CloudFront发布访问的端点。在启动区域API端点之前,这是使用API网关创建API时的默认选项。它主要帮助位于不同地理位置的API使用者减少延迟。

当API请求主要来自部署API时所在AWS区域内的Amazon EC2实例或其他服务时,区域API端点通常会降低连接的延迟。建议在这种情况下使用。

为了更好地控制缓存策略,客户可以为区域api使用自己的CloudFront发布。他们也有能力使用AWS WAF保护,正如我在这篇文章中所描述的。

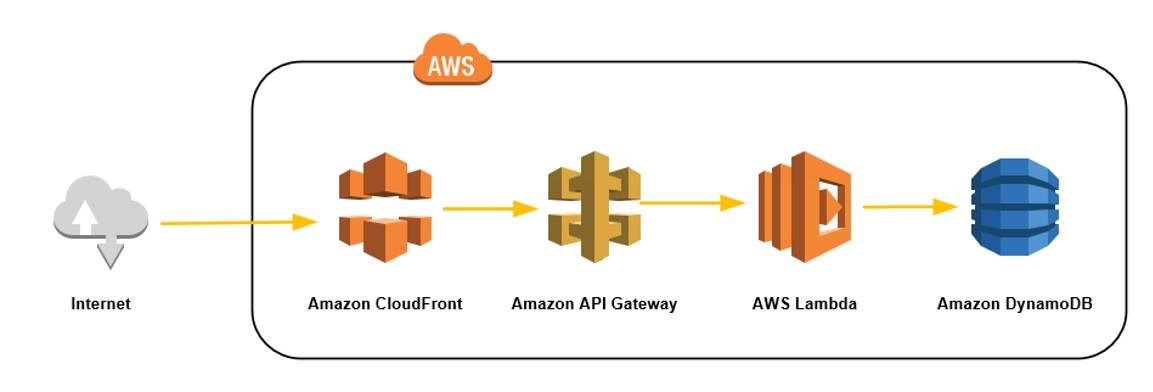

Edge-optimized API端点

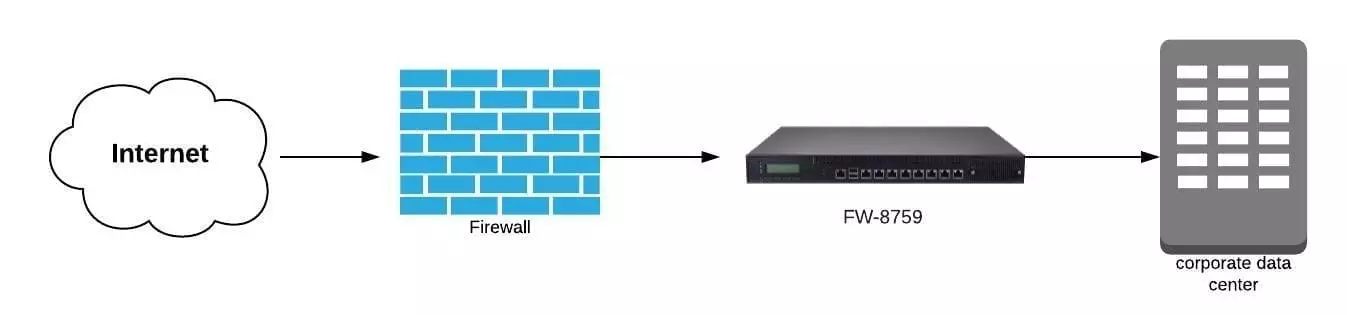

下图是一个经过边界优化的API端点的示例,您的API客户端通过由API网关创建和管理的CloudFront发布访问您的API。

区域API端点

对于区域API端点,您的客户可以从部署REST API的相同区域访问您的API。这有助于减少请求延迟,特别是允许您根据需要添加自己的内容交付网络。

预排

在本节中,您将执行以下步骤:

- 使用PetStore示例API创建一个区域性API。

- 为API创建一个CloudFront发布。

- 测试云前分布。

- 设置AWS WAF并创建web ACL。

- 将web ACL附加到CloudFront分发版。

- 测试AWS WAF保护。

创建区域API

对于本演练,请使用现有的PetStore API。所有新api都默认作为区域端点类型启动。要更改现有API的端点类型,请选择右上角的cog图标:

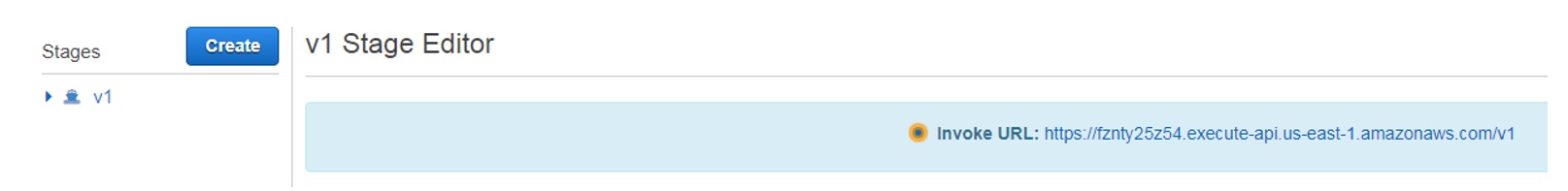

在您的帐户上创建了PetStore API之后,为PetStore API部署一个名为“prod”的阶段。

在API网关控制台,选择PetStore API并选择Actions, Deploy API。

对于Stage 名称,键入prod并添加舞台描述。

选择Deploy并创建新的API阶段。

使用以下AWS CLI命令将您的API从边缘优化更新到区域:

aws apigateway update-rest-api \ --rest-api-id {rest-api-id} \ --patch-operations op=replace,path=/endpointConfiguration/types/EDGE,value=REGIONAL

一个成功的响应如下:

{

"description": "Your first API with Amazon API Gateway. This is a sample API that integrates via HTTP with your demo Pet Store endpoints",

"createdDate": 1511525626,

"endpointConfiguration": {

"types": [

"REGIONAL"

]

},

"id": "{api-id}",

"name": "PetStore"

}

将API端点更改为region之后,现在可以将自己的CloudFront分发版分配给这个API。

创建一个CloudFront发布

为了使事情变得更简单,我提供了一个AWS CloudFormation模板来部署指向您刚刚创建的API的CloudFront发布。单击此按钮将模板部署到us-east-1区域。

对于堆栈名称,请输入RegionalAPI。对于APIGWEndpoint,请按照以下格式输入您的API FQDN:

{api-id}.execute-api.us-east-1.amazonaws.com

填写完参数后,选择Next继续堆栈部署。完成部署需要几分钟。完成后,Output选项卡列出以下项目:

- A CloudFront domain URL

- An S3 bucket for CloudFront access logs

Output from CloudFormation

测试CloudFront 分发

要查看CloudFront发布是否配置正确,请使用web浏览器并从发行版中输入URL,并使用以下参数:

https://{your-distribution-url}.cloudfront.net/{api-stage}/pets

您应该得到以下输出:

[

{

"id": 1,

"type": "dog",

"price": 249.99

},

{

"id": 2,

"type": "cat",

"price": 124.99

},

{

"id": 3,

"type": "fish",

"price": 0.99

}

]

设置AWS WAF并创建web ACL

有了新的CloudFront发布,您现在可以开始设置AWS WAF来保护您的API。

对于这个演示,您将部署AWS WAF安全自动化解决方案(https://aws.amazon.com/answers/security/aws-waf-security-automations/),该解决方案对试图访问您的API的请求提供细粒度控制。

有关部署的更多信息,请参见自动部署(https://docs.aws.amazon.com/solutions/latest/aws-waf-security-automatio…)。

对于CloudFront访问日志桶名,添加在部署CloudFormation堆栈期间为您的CloudFront分发版创建的桶名。

该解决方案允许您调整阈值,并选择启用哪些自动化来保护您的API。配置完这些设置后,选择Next。

要启动帐户中的部署过程,请遵循创建向导并选择Create。完成部署需要几分钟。您可以通过CloudFormation控制台跟踪创建过程。

部署完成后,您可以看到新的web ACL部署在AWSWAF控制台AWSWAFSecurityAutomations上。

将AWS WAF web ACL附加到CloudFront分发版

部署了解决方案后,现在可以将AWS WAF web ACL附加到前面创建的CloudFront分发版。

要分配新创建的AWS WAF web ACL,请回到您的CloudFront发布。打开要编辑的发行版后,选择General Edit。

选择前面创建的新的AWSWAF web ACL AWSWAFSecurityAutomations。

保存对CloudFront发布的更改,等待部署完成。

测试AWS WAF保护

要验证AWS WAF Web ACL设置,请使用 Artillery 加载测试API并查看AWS WAF的运行情况。

要在您的机器上安装火炮,请运行以下命令:

npm install -g artillery

安装完成后,您可以通过运行以下命令检查火炮是否安装成功:

$ artillery -V $ 1.6.0-12

在发布时, Artillery版是1.6.0-12。

您已经设置的WAF web ACL规则之一是基于速率的规则。默认情况下,它被设置为阻止任何请求者在5分钟内超过2000个请求。试试这个。

首先,使用cURL查询您的分布并查看API输出:

$ curl -s https://{distribution-name}.cloudfront.net/prod/pets

[

{

"id": 1,

"type": "dog",

"price": 249.99

},

{

"id": 2,

"type": "cat",

"price": 124.99

},

{

"id": 3,

"type": "fish",

"price": 0.99

}

]

根据上面的测试,结果看起来不错。但是,如果您在5分钟内最大限度地完成2000个请求呢?

运行以下artillery 命令:

artillery quick -n 2000 --count 10 https://{distribution-name}.cloudfront.net/prod/pets

您所做的是从10个并发用户向API发出2000个请求。简而言之,我没有在这里发布炮兵(artillery )输出。

炮兵(artillery )完成它的执行后,尝试再次运行cURL请求,看看会发生什么:

$ curl -s https://{distribution-name}.cloudfront.net/prod/pets

<!DOCTYPE HTML PUBLIC "-//W3C//DTD HTML 4.01 Transitional//EN" "http://www.w3.org/TR/html4/loose.dtd">

<HTML><HEAD><META HTTP-EQUIV="Content-Type" CONTENT="text/html; charset=iso-8859-1">

<TITLE>ERROR: The request could not be satisfied</TITLE>

</HEAD><BODY>

<H1>ERROR</H1>

<H2>The request could not be satisfied.</H2>

<HR noshade size="1px">

Request blocked.

<BR clear="all">

<HR noshade size="1px">

<PRE>

Generated by cloudfront (CloudFront)

Request ID: [removed]

</PRE>

<ADDRESS>

</ADDRESS>

</BODY></HTML>

从上面的输出可以看到,请求被AWS WAF阻止了。当您的IP地址低于请求限制速率时,将从阻塞列表中删除。

结论

在第一部分中,您了解了如何使用新的API网关区域API端点以及Amazon CloudFront和AWS WAF来保护您的API免受一系列攻击。

在第二部分中,我将演示使用API键和Amazon CloudFront自定义头保护API的其他一些技术。

本文:http://pub.intelligentx.net/node/595

讨论:请加入知识星球或者小红圈【首席架构师圈】

- 98 次浏览

安全工具

我们根据行业评论,您的反馈和自己的经验,准备了2018年最佳黑客工具的有用列表。 此列表将告诉您有关用于黑客目的的最佳软件,包括端口扫描程序,Web漏洞扫描程序,密码破解程序,取证工具,流量分析和社交工程工具。

我们编制了这个顶级黑客软件列表及其最佳功能和下载链接。 阅读它们,了解如何使用它们并分享您的评论,以使这个列表更好。 如果您正在寻找用于道德黑客攻击和测试的专用操作系统,请查看此专用文章 (具体链接后台询问)。

1. Metasploit | Best collection of exploit tools

我不是将Metasploit称为漏洞利用工具的集合,而是将其称为可用于构建自己的自定义工具的基础架构。 这个免费工具是最流行的网络安全工具之一,允许您在不同平台上查找漏洞。 Metasploit拥有超过200,000名用户和贡献者,可帮助您获得洞察力并发现系统中的弱点。

这个2018年的顶级黑客工具包让你可以模拟真实世界的攻击,告诉你弱点并找到它们。 作为渗透测试人员,它使用Top Remediation报告通过Nexpose闭环集成来确定漏洞。 使用开源Metasploit框架,用户可以构建自己的工具并充分利用这个多用途黑客工具。

支持的平台和下载:

Metasploit适用于所有主要平台,包括Windows,Linux和OS X.

2. Acunetix WVS | Vulnerability Scanner

Acunetix是一个Web漏洞扫描程序(WVS),可以扫描并发现网站中可能导致致命错误的缺陷。 这个多线程工具抓取一个网站,发现恶意的跨站点脚本,SQL注入和其他漏洞。 这个快速且易于使用的工具可以从WordPress.ethical-hacking-course-square-ad中的1200多个漏洞中扫描WordPress网站

Acunetix附带一个登录序列记录器,允许用户访问网站的密码保护区域。 此工具中使用的新AcuSensor技术可以降低误报率。 这些功能使Acunetix WVS成为您需要在2018年结账的首选黑客工具。

支持的平台和下载:

Acunetix适用于Windows XP及更高版本。

3. Nmap | Port scanner tool

Nmap - 也称为网络映射器 - 属于端口扫描程序工具的类别。 这个免费的开源黑客工具是最流行的端口扫描工具,可以实现高效的网络发现和安全审计。 Nmap用于广泛的服务,使用原始IP数据包来确定网络上可用的主机,它们的服务以及详细信息,主机使用的操作系统,使用的防火墙类型以及其他信息。

去年,Nmap赢得了多项年度奖项的安全产品,并出现在多部电影中,包括The Matrix Reloaded,Die Hard 4等。 在命令行中可用,Nmap可执行文件也带有高级GUI头像。

支持的平台和下载:

Nmap适用于所有主要平台,包括Windows,Linux和OS X.

4. Wireshark | Packet analyzer

Wireshark是一种众所周知的数据包制作工具,可以发现网络中的漏洞并探测防火墙规则集。 成千上万的安全专业人员使用它来分析数百个协议的网络和实时口袋捕获和深度扫描。 Wireshark可帮助您从以太网,IEEE 802.11,PPP / HDLC,ATM,蓝牙,USB,令牌环,帧中继,FDDI等读取实时数据。

这个免费的开源工具最初被命名为Ethereal。 Wireshark还有一个名为TShark的命令行版本。

支持的平台和下载:

这种基于GTK +的网络协议分析器可在Linux,Windows和OS X上轻松运行。

5. oclHashcat | Password cracking tool

如果密码破解是您每天都要做的事情,您可能会注意到免费密码破解工具Hashcat。 虽然Hashcat是一个基于CPU的密码破解工具,但oclHashcat是其高级版本,它使用GPU的强大功能。

oclHashcat称自己是世界上第一个也是唯一一个基于GPGPU的引擎的世界上最快的密码破解工具。 对于使用该工具,NVIDIA用户需要ForceWare 346.59或更高版本,AMD用户需要Catalyst 15.7或更高版本。

此工具使用以下攻击模式进行破解:

- 直接

- 组合

- 暴力

- 混合字典+面具

- 混合蒙版+字典

提到另一个主要功能,oclHashcat是一个MIT许可下的开源工具,可以轻松集成或打包常见的Linux发行版。

支持的平台和下载:

这个有用的密码破解工具可以在Linux,OSX和Windows的不同版本中下载。

6. Nessus | 漏洞扫描程序

这个2018年的顶级免费安全工具在客户端 - 服务器框架的帮助下工作。该工具由Tenable Network Security开发,是我们最受欢迎的漏洞扫描程序之一。 Nessus为不同类型的用户提供不同的用途--Nessus Home,Nessus Professional,Nessus Manager和Nessus Cloud。

使用Nessus,可以扫描多种类型的漏洞,包括远程访问漏洞检测,错误配置警报,拒绝针对TCP / IP堆栈的服务,准备PCI DSS审计,恶意软件检测,敏感数据搜索等。要启动字典攻击,Nessus也可以称之为流行工具Hydra external.ethical-hacking-course-square-ad

除了上述基本功能外,Nessus还可用于扫描IPv4,IPv6和混合网络上的多个网络。您可以将计划扫描设置为在所选时间运行,并使用选择性主机重新扫描重新扫描先前扫描的主机的全部或子部分。

支持的平台和下载:

Nessus得到了各种平台的支持,包括Windows 7和8,Mac OS X以及Debian,Ubuntu,Kali Linux等流行的Linux发行版。

7. Maltego 取证平台

Maltego是一个开源取证平台,提供严格的挖掘和信息收集,以描绘您周围的网络威胁。 Maltego擅长展示基础设施和周围环境中故障点的复杂性和严重性。

Maltego是一个很棒的黑客工具,可以分析人,公司,网站,域名,DNS名称,IP地址,文档等等之间的真实世界链接。 该工具基于Java,在易于使用的图形界面中运行,在扫描时丢失了自定义选项。

支持的平台和下载:

Maltego安全工具适用于Windows,Mac和Linux。

8. Social-Engineer Toolkit

TrustedSec的Social-Engineer Toolkit也是Robot先生的特色,是一个用于模拟多种类型的社会工程攻击的高级框架,如凭据收获,网络钓鱼攻击等。 在节目中,Elliot被使用来自Social-Engineer Toolkit的SMS欺骗工具。

这个Python驱动的工具是社交工程渗透测试的标准工具,下载量超过200万。 它可以自动化攻击并生成伪装的电子邮件,恶意网页等。

支持的平台和下载:

要在Linux上下载SET,请键入以下命令:

git clone https://github.com/trustedsec/social-engineer-toolkit/ set /

除Linux之外,Mac OS X和Windows部分支持Social-Engineer Toolkit。

9. Netsparker | Web app scanner

Netsparker是一种流行的Web应用程序扫描程序,可以找到SQL注入和本地文件归纳等缺陷,以只读和安全的方式建议补救措施。 由于这个黑客工具产生了一个利用证据,您不需要自己验证漏洞。 万一它无法自动验证缺陷,它会提醒您。 这个黑客工具很容易上手。 只需输入URL并让它执行扫描。 Netsparker支持基于JavaScript和AJAX的应用程序。 因此,您无需配置扫描仪或依赖某些复杂的扫描设置来扫描不同类型的Web应用程序。

如果你不想为Netsparker的专业版付钱,他们也有一个你可以使用的演示版。

支持的平台和下载:

Netsparker Web应用程序扫描程序适用于Windows

10. w3af | Web app scanner

w3af是一款免费的开源Web应用程序安全扫描程序,被黑客和渗透测试人员广泛使用。 w3af代表Web应用程序攻击和审计框架。使用此黑客工具,可以获得可以在渗透测试约定中进一步使用的安全漏洞信息。 w3af声称可识别200多个漏洞(包括跨站点脚本,SQL注入,PHP错误配置,可猜测的凭据和未处理的应用程序错误),并使Web应用程序(和网站)更安全。解决方法 - 黑客 - 课程 - 方广告

w3af同时提供命令行和图形用户界面,以满足黑客的需求。只需不到5次点击并为初学者使用预定义的配置文件,就可以审核Web应用程序的安全性。由于它有详细记录,新用户可以轻松找到自己的方式。作为一个开源黑客工具,经验丰富的开发人员可以使用代码,添加新功能和创建新功能。

支持的平台和下载:

w3af适用于Linux,BSD和OS X.在Windows上,支持其旧版本。

11. John The Ripper

在密码破解工具方面,John The Ripper成为大多数道德黑客的最佳选择。 这个免费的开源软件以源代码的形式分发。

John The Ripper主要使用C编程语言编写。 它已经能够实现一个伟大的伴侣的地位,因为它是许多密码破解者合二为一的事实。 不同的模块使其能够使用不同的加密技术破解密码

支持的平台和下载:

John The Ripper黑客软件可在各种平台上使用,包括Windows,Linux,DOS,OpenVMS和Unix。

12. Aircrack-ng | Password cracking tool

在密码破解方面,Aircrack-ng是您可以探索的另一种选择。 该网络套件包括探测器,流量嗅探器和密码破解工具。 所有这些工具都是基于命令行的,并允许繁重的脚本。

使用Aircrack-ng黑客软件,您可以捕获数据包,将数据导出到文本文件,执行不同的攻击,检查WiFi卡和驱动程序功能,破解WEP和WPA PSK等。

支持的平台和下载:

Aircrack-ng适用于macOS,Linux,FreeBSD,Windows等不同平台。 Lunux版本也已移植到Android。

2018年的多种类别的其他顶级黑客和安全工具:

- Web漏洞扫描程序 - Burp Suite,Firebug,AppScan,OWASP Zed,Paros Proxy,Nikto,Grendel-Scan

- 漏洞利用工具 - Netsparker,sqlmap,Core Impact,WebGoat,BeEF

- 法医工具 - Helix3 Pro,EnCase,Autopsy

- 端口扫描仪 - Unicornscan,NetScanTools,愤怒的IP扫描仪

- 交通监控工具 - Nagios,Ntop,Splunk,Ngrep,Argus

- 调试器 - IDA Pro,WinDbg,Immunity Debugger,GDB

- Rootkit探测器 - DumpSec,Tripwire,HijackThis

- 加密工具 - KeePass,OpenSSL,OpenSSH / PuTTY / SSH,Tor

- 密码破解者 - John the Ripper, Hydra, ophcrack

我们希望您发现此列表有用。 在下面的评论中分享您的评论,并帮助我们改进此列表。

- 298 次浏览

【安全】适用于Windows,Linux和OS X的2018年最佳黑客工具

我们根据行业评论,您的反馈和自己的经验,准备了2018年最佳黑客工具的有用列表。 此列表将告诉您有关用于黑客目的的最佳软件,包括端口扫描程序,Web漏洞扫描程序,密码破解程序,取证工具,流量分析和社交工程工具。

我们编制了这个顶级黑客软件列表及其最佳功能和下载链接。 阅读它们,了解如何使用它们并分享您的评论,以使这个列表更好。 如果您正在寻找用于道德黑客攻击和测试的专用操作系统,请查看此专用文章

1. Metasploit | Best collection of exploit tools

我不是将Metasploit称为漏洞利用工具的集合,而是将其称为可用于构建自己的自定义工具的基础架构。 这个免费工具是最流行的网络安全工具之一,允许您在不同平台上查找漏洞。 Metasploit拥有超过200,000名用户和贡献者,可帮助您获得洞察力并发现系统中的弱点。

这个2018年的顶级黑客工具包让你可以模拟真实世界的攻击,告诉你弱点并找到它们。 作为渗透测试人员,它使用Top Remediation报告通过Nexpose闭环集成来确定漏洞。 使用开源Metasploit框架,用户可以构建自己的工具并充分利用这个多用途黑客工具。

支持的平台和下载:

Metasploit适用于所有主要平台,包括Windows,Linux和OS X.

2. Acunetix WVS | Vulnerability Scanner

Acunetix是一个Web漏洞扫描程序(WVS),可以扫描并发现网站中可能导致致命错误的缺陷。 这个多线程工具抓取一个网站,发现恶意的跨站点脚本,SQL注入和其他漏洞。 这个快速且易于使用的工具可以从WordPress.ethical-hacking-course-square-ad中的1200多个漏洞中扫描WordPress网站

Acunetix附带一个登录序列记录器,允许用户访问网站的密码保护区域。 此工具中使用的新AcuSensor技术可以降低误报率。 这些功能使Acunetix WVS成为您需要在2018年结账的首选黑客工具。

支持的平台和下载:

Acunetix适用于Windows XP及更高版本。

3. Nmap | Port scanner tool

Nmap - 也称为网络映射器 - 属于端口扫描程序工具的类别。 这个免费的开源黑客工具是最流行的端口扫描工具,可以实现高效的网络发现和安全审计。 Nmap用于广泛的服务,使用原始IP数据包来确定网络上可用的主机,它们的服务以及详细信息,主机使用的操作系统,使用的防火墙类型以及其他信息。

去年,Nmap赢得了多项年度奖项的安全产品,并出现在多部电影中,包括The Matrix Reloaded,Die Hard 4等。 在命令行中可用,Nmap可执行文件也带有高级GUI头像。

支持的平台和下载:

Nmap适用于所有主要平台,包括Windows,Linux和OS X.

4. Wireshark | Packet analyzer

Wireshark是一种众所周知的数据包制作工具,可以发现网络中的漏洞并探测防火墙规则集。 成千上万的安全专业人员使用它来分析数百个协议的网络和实时口袋捕获和深度扫描。 Wireshark可帮助您从以太网,IEEE 802.11,PPP / HDLC,ATM,蓝牙,USB,令牌环,帧中继,FDDI等读取实时数据。

这个免费的开源工具最初被命名为Ethereal。 Wireshark还有一个名为TShark的命令行版本。

支持的平台和下载:

这种基于GTK +的网络协议分析器可在Linux,Windows和OS X上轻松运行。

5. oclHashcat | Password cracking tool

如果密码破解是您每天都要做的事情,您可能会注意到免费密码破解工具Hashcat。 虽然Hashcat是一个基于CPU的密码破解工具,但oclHashcat是其高级版本,它使用GPU的强大功能。

oclHashcat称自己是世界上第一个也是唯一一个基于GPGPU的引擎的世界上最快的密码破解工具。 对于使用该工具,NVIDIA用户需要ForceWare 346.59或更高版本,AMD用户需要Catalyst 15.7或更高版本。

此工具使用以下攻击模式进行破解:

- 直接

- 组合

- 暴力

- 混合字典+面具

- 混合蒙版+字典

提到另一个主要功能,oclHashcat是一个MIT许可下的开源工具,可以轻松集成或打包常见的Linux发行版。

支持的平台和下载:

这个有用的密码破解工具可以在Linux,OSX和Windows的不同版本中下载。

6. Nessus | 漏洞扫描程序

这个2018年的顶级免费安全工具在客户端 - 服务器框架的帮助下工作。该工具由Tenable Network Security开发,是我们最受欢迎的漏洞扫描程序之一。 Nessus为不同类型的用户提供不同的用途--Nessus Home,Nessus Professional,Nessus Manager和Nessus Cloud。

使用Nessus,可以扫描多种类型的漏洞,包括远程访问漏洞检测,错误配置警报,拒绝针对TCP / IP堆栈的服务,准备PCI DSS审计,恶意软件检测,敏感数据搜索等。要启动字典攻击,Nessus也可以称之为流行工具Hydra external.ethical-hacking-course-square-ad

除了上述基本功能外,Nessus还可用于扫描IPv4,IPv6和混合网络上的多个网络。您可以将计划扫描设置为在所选时间运行,并使用选择性主机重新扫描重新扫描先前扫描的主机的全部或子部分。

支持的平台和下载:

Nessus得到了各种平台的支持,包括Windows 7和8,Mac OS X以及Debian,Ubuntu,Kali Linux等流行的Linux发行版。

7. Maltego 取证平台

Maltego是一个开源取证平台,提供严格的挖掘和信息收集,以描绘您周围的网络威胁。 Maltego擅长展示基础设施和周围环境中故障点的复杂性和严重性。

Maltego是一个很棒的黑客工具,可以分析人,公司,网站,域名,DNS名称,IP地址,文档等等之间的真实世界链接。 该工具基于Java,在易于使用的图形界面中运行,在扫描时丢失了自定义选项。

支持的平台和下载:

Maltego安全工具适用于Windows,Mac和Linux。

8. Social-Engineer Toolkit

TrustedSec的Social-Engineer Toolkit也是Robot先生的特色,是一个用于模拟多种类型的社会工程攻击的高级框架,如凭据收获,网络钓鱼攻击等。 在节目中,Elliot被使用来自Social-Engineer Toolkit的SMS欺骗工具。

这个Python驱动的工具是社交工程渗透测试的标准工具,下载量超过200万。 它可以自动化攻击并生成伪装的电子邮件,恶意网页等。

支持的平台和下载:

要在Linux上下载SET,请键入以下命令:

git clone https://github.com/trustedsec/social-engineer-toolkit/ set /

除Linux之外,Mac OS X和Windows部分支持Social-Engineer Toolkit。

9. Netsparker | Web app scanner

Netsparker是一种流行的Web应用程序扫描程序,可以找到SQL注入和本地文件归纳等缺陷,以只读和安全的方式建议补救措施。 由于这个黑客工具产生了一个利用证据,您不需要自己验证漏洞。 万一它无法自动验证缺陷,它会提醒您。 这个黑客工具很容易上手。 只需输入URL并让它执行扫描。 Netsparker支持基于JavaScript和AJAX的应用程序。 因此,您无需配置扫描仪或依赖某些复杂的扫描设置来扫描不同类型的Web应用程序。

如果你不想为Netsparker的专业版付钱,他们也有一个你可以使用的演示版。

支持的平台和下载:

Netsparker Web应用程序扫描程序适用于Windows

10. w3af | Web app scanner

w3af是一款免费的开源Web应用程序安全扫描程序,被黑客和渗透测试人员广泛使用。 w3af代表Web应用程序攻击和审计框架。使用此黑客工具,可以获得可以在渗透测试约定中进一步使用的安全漏洞信息。 w3af声称可识别200多个漏洞(包括跨站点脚本,SQL注入,PHP错误配置,可猜测的凭据和未处理的应用程序错误),并使Web应用程序(和网站)更安全。

w3af同时提供命令行和图形用户界面,以满足黑客的需求。只需不到5次点击并为初学者使用预定义的配置文件,就可以审核Web应用程序的安全性。由于它有详细记录,新用户可以轻松找到自己的方式。作为一个开源黑客工具,经验丰富的开发人员可以使用代码,添加新功能和创建新功能。

支持的平台和下载:

w3af适用于Linux,BSD和OS X.在Windows上,支持其旧版本。

11. John The Ripper

在密码破解工具方面,John The Ripper成为大多数道德黑客的最佳选择。 这个免费的开源软件以源代码的形式分发。

John The Ripper主要使用C编程语言编写。 它已经能够实现一个伟大的伴侣的地位,因为它是许多密码破解者合二为一的事实。 不同的模块使其能够使用不同的加密技术破解密码

支持的平台和下载:

John The Ripper黑客软件可在各种平台上使用,包括Windows,Linux,DOS,OpenVMS和Unix。

12. Aircrack-ng | Password cracking tool

在密码破解方面,Aircrack-ng是您可以探索的另一种选择。 该网络套件包括探测器,流量嗅探器和密码破解工具。 所有这些工具都是基于命令行的,并允许繁重的脚本。

使用Aircrack-ng黑客软件,您可以捕获数据包,将数据导出到文本文件,执行不同的攻击,检查WiFi卡和驱动程序功能,破解WEP和WPA PSK等。

支持的平台和下载:

Aircrack-ng适用于macOS,Linux,FreeBSD,Windows等不同平台。 Lunux版本也已移植到Android。

2018年的多种类别的其他顶级黑客和安全工具:

- Web漏洞扫描程序 - Burp Suite,Firebug,AppScan,OWASP Zed,Paros Proxy,Nikto,Grendel-Scan

- 漏洞利用工具 - Netsparker,sqlmap,Core Impact,WebGoat,BeEF

- 法医工具 - Helix3 Pro,EnCase,Autopsy

- 端口扫描仪 - Unicornscan,NetScanTools,愤怒的IP扫描仪

- 交通监控工具 - Nagios,Ntop,Splunk,Ngrep,Argus

- 调试器 - IDA Pro,WinDbg,Immunity Debugger,GDB

- Rootkit探测器 - DumpSec,Tripwire,HijackThis

- 加密工具 - KeePass,OpenSSL,OpenSSH / PuTTY / SSH,Tor

- 密码破解者 - John the Ripper, Hydra, ophcrack

我们希望您发现此列表有用。 在下面的评论中分享您的评论,并帮助我们改进此列表。

下载地址:

- Metasploit :https://www.metasploit.com/

- Acunetix WVS:http://www.acunetix.com/vulnerability-scanner/

- Nmap:https://nmap.org/

- Wireshark :https://www.wireshark.org/

- oclHashcat :https://hashcat.net/oclhashcat/

- Nessus:http://www.tenable.com/

- Maltego :https://www.paterva.com/web6/products/maltego.php

- Social-Engineer Toolkit:https://github.com/trustedsec/social-engineer-toolkit/

- Netsparker :https://www.netsparker.com/web-vulnerability-scanner/

- w3af :http://w3af.org/

- John The Ripper:http://www.openwall.com/john/

- Aircrack-ng:https://www.aircrack-ng.org/

- 64 次浏览

【安全工具】57个开源应用程序工具:免费应用程序安全软件指南

阅读此列表的更新版本:您应该考虑的47个强大的开源应用程序秒工具

您无需花费大量资金在应用程序开发和交付日程中引入高功率安全性。这本开源应用程序工具指南旨在帮助那些希望投资应用程序安全软件的团队了解开源领域的内容,以及如何思考这些选择。随后将发布商业app sec供应商指南。

为什么需要免费的app sec工具指南?一般而言,有关应用程序安全性的信息可能会令人困惑,因为网站通常会在没有明确描述所提供解决方案类别的情况下展示产品的优势。这使得将一种产品与下一种产品进行比较变得困难。开源项目的网站通常提供有关特定工具的非常精细的信息,这要求读者已经了解如何以及为何使用特定工具。

开源app sec工具的价值

大多数开源项目都是针对app sec要求而设计的,其规模小于商业供应商所倾向的目标。尽管如此,我们认为这个高度专注的开源应用程序提供商名单应该为安全爱好者所熟悉,他们寻求针对特定类型的网络威胁的新的创造性方法。

其中一些操作系统项目非常活跃,并且经常使用新功能进行更新;其他人,嗯,不是那么多,但他们值得一试。自网络诞生以来,一些更强大的OS技术已经存在;其他人都很新,在推特和其他地方有越来越多的粉丝。

请注意,此处的一些列表是免费的“社区版”的高级商业产品。另请注意,您无法再通过.org或.net后缀识别开源项目。正如您将看到的,许多人现在使用.com约定以及许多其他URL约定。

Andiparos

着名的Paros Proxy的一个分支,一个开源Web应用程序安全评估工具,为渗透测试人员提供了抓取网站,分析内容,拦截和修改请求的能力

网址:https://code.google.com/archive/p/andiparos

BackTrack

这个发行版称为基于Linux的渗透测试工具,配置有数百种安全测试工具和脚本

网址:http://www.backtrack-linux.org

BeEF

开源的渗透测试

网址:http://beefproject.com

Caja

用于使第三方HTML,CSS和JavaScript安全嵌入网站的编译器。它使用对象功能安全模型来实现各种灵活的安全策略。

网址:http://developers.google.com/caja

ClamAV

用于检测特洛伊木马,病毒,恶意软件和其他恶意威胁的开源防病毒引擎

网址:http://clamav.net

DOM Snitch

实验性Chrome扩展程序,使开发人员和测试人员能够识别客户端代码中常见的不安全做法。开发人员和测试人员可以在浏览器内部进行DOM修改,无需使用调试器逐步执行JavaScript代码或暂停其应用程序的执行

网址:https://code.google.com/archive/p/domsnitchdomsnitch

Ettercap

被称为“针对中间人攻击的综合套件......具有嗅探现场连接,动态内容过滤以及许多其他有趣的技巧。”

网址:http://ettercap.github.io/ettercap

GoLismero

用于安全测试的免费软件框架。

网址:http://www.golismero.com

谷歌黑客数据库(GHDB)

SecTools.org将其描述为“安全研究人员和渗透测试人员的金矿”,该网站是漏洞利用数据库的一部分,这是一个非营利性项目,由进攻性安全部门提供为公共服务。

网址:https://www.exploit-db.com/google-hacking-database

Google应用安全工具

谷歌表示,这些工具“解决了其他开源工具中存在的差距。这些工具可能需要进行一些小的调整或编译才能在您的系统上运行。”有些是单独列在此列表中。

网址:https://www.google.com/about/appsecurity/tools

Grabber

Web应用程序扫描程序,可以检测Web应用程序中的许多安全漏洞。一个开源的Web应用程序渗透测试工具

网址:http://rgaucher.info/beta/grabber

Grendel

扫描Web应用程序安全工具以查找安全漏洞;功能也可用于手动渗透测试

网址:https://sourceforge.net/projects/grendel

Gruyere

被称为“小型,俗气的网络应用程序”;允许用户发布文本片段并存储各种文件。警告:Gruyere有多个安全漏洞,包括跨站点脚本和跨站点请求伪造,信息泄露,拒绝服务和远程代码执行

网址:http://google-gruyere.appspot.com

Kali

Linux渗透测试

网址:http://kali.org

Keyczar

开源加密工具包旨在使开发人员在其应用程序中使用加密更容易,更安全。它支持对称和非对称密钥的身份验证和加密;旨在实现开放,可扩展和跨平台兼容。

网址:https://github.com/google/keyczar

Kismet

无线网络探测器,嗅探器和入侵检测系统。 Kismet主要使用Wi-Fi(IEEE 802.11)网络,但可以通过插件扩展以处理其他网络类型。

网址:http://kismetwireless.org

Malwarebytes

适用于Windows的端点安全恶意软件扫描程序。

网址:http://malwarebytes.org

Metasploit

通过Rapid7渗透测试开源的Metasploit

网址:http://metasploit.com

ModSecurity

WAF开源

网址:http://modsecurity.org

Nagios

监控整个IT基础架构,以确保系统,应用程序,服务和业务流程正常运行。

网址:http://nagios.org

Native Client (NaCl)

一种在浏览器中运行本机编译代码的技术。 NaCl旨在保持人们对Web应用程序的操作系统可移植性和安全性

网址:http://developer.chrome.com/native-client

Nikto2

Web服务器测试工具,用于查找已知的易受攻击脚本,配置错误和相关的安全问题

网址:http://cirt.net/nikto2

NMAP

使用NSE脚本进行网络发现和安全审核的渗透测试实用程序,可以检测网络服务中的漏洞,错误配置和安全相关信息

网址:http://nmap.org

NoScript

Firefox插件,为Firefox,Seamonkey和其他基于Mozilla的浏览器提供额外保护;允许JavaScript,Java,Flash和其他插件只能由您选择的受信任网站执行

网址:http://noscript.net

OpenSSH

通过SSH隧道隧道安装不安全的协议来保护两点之间的流量

网址:http://www.openssh.com

OpenVAS

开源漏洞扫描套件

网址:http://openvas.org

OSSEC

基于主机的入侵检测系统或HIDS

网址:http://ossec.github.io

OWASP

owasp.org提供了一大类开源sec测试工具

网址:https://www.owasp.org/index.php/Appendix_A:_Testing_Tools

Packet Storm

提供各种用于漏洞和渗透的扫描仪工具

网址:http://packetstormsecurity.org/files/tags/scanner

Paros Proxy

用于安全性和漏洞测试的测试工具。用于对整个站点进行爬行/爬网,然后执行预装漏洞扫描程序测试

网址:http://www.testingsecurity.com/paros_proxy

Powerfuzzer

基于HTTP协议的应用程序模糊器基于许多其他开源模糊器

网址:http://www.powerfuzzer.com

Ratproxy

旨在克服用户在使用其他代理工具进行安全审核时通常面临的问题;能够区分CSS样式表和JavaScript代码

网址:https://code.google.com/archive/p/ratproxy

Secunia PSI

一种免费的计算机安全解决方案,可识别私人PC上的应用程序中的漏洞

Web:http://learn.flexerasoftware.com/SVM-EVAL-Personal-Software-Inspector

Security Onion

用于入侵检测,网络安全监控和日志管理的Linux发行版

网址:http://blog.securityonion.net

Skipfish

活跃的Web应用程序安全侦察工具。它通过执行递归爬网和字典工具为站点准备交互式站点地图。使用自定义HTTP堆栈编写的C语言,性能高,易于使用且可靠

网址:https://code.google.com/archive/p/skipfish

Snort

用于UNIX衍生产品和Windows的开源,免费和轻量级网络入侵检测系统(NIDS)

网址:http://snort.org

SonarQube

SonarQube™软件(以前称为“Sonar”)是一个管理代码质量的开放平台。因此,它涵盖了7轴代码质量。

网址:https://github.com/SonarSource/sonarqube

SQLMAP

渗透测试工具,自动化在网站数据库中查找和利用SQL注入漏洞的过程

网址:http://sqlmap.org

TCPDUMP

在其网站上称为“功能强大的命令行数据包分析器”,许多人仍然使用此工具作为资源密集型Wireshark的替代工具。

网址:http://tcpdump.org

Vega

Web漏洞扫描器和测试平台; SQL注入,跨站点脚本等

网址:https://subgraph.com/vega

W3AF

SQL注入,跨站点脚本检测工具

网址:http://w3af.org

Wapiti

Web漏洞扫描程序,可让您审核Web应用程序的安全性。它通过扫描网页和注入数据来执行黑盒测试

网址:http://wapiti.sourceforge.net

Watcher

一个Fiddler插件,帮助渗透测试人员被动地发现Web应用程序漏洞

网址:http://websecuritytool.codeplex.com

WATOBO

执行高效(半自动)Web应用程序安全审核

网址:http://watobo.sourceforge.net/index.html

WebScarab

基于Java的安全框架,用于使用HTTP或HTTPS协议分析Web应用程序。用Java编写,可移植到许多平台;提供多种操作模式,由多个插件实现。在最常见的用法中,WebScarab作为拦截代理运行

网址:http://www.owasp.org/index.php/Category:WHASP_WebScarab_Project

Websecurify

GNUCITIZEN(参见商业供应商列表)

网址:

Wfuzz

免费提供的用于Web应用程序渗透测试的开源工具。它可用于强制GET和POST参数,以便针对SQL,XSS,LDAP等许多其他注入进行测试

网址:http://code.google.com/p/wfuzz

SensePost

设备,网络和应用程序的漏洞工具。工具包括autoDANE,reGeorg,Jack和SensePost Maltego工具集

网址:http://sensepost.com

Wireshark

Wireshark渗透测试和数据包级监控开源;根据需要查看详细的流量;关注网络流并发现问题

网址:http://wireshark.org

Zed攻击代理

也称为Zap。开源,拦截代理是fork和更新严重过时的Paros Proxy。相当强大的手动测试,并包含一些自动测试功能。

网址:https://www.owasp.org

讨论:请加入只是星球【首席架构师圈】

- 80 次浏览

【安全工具】Gauntlt是一个安全测试框架,它使用命令行界面(CLI)来运行安全测试或攻击

Gauntlt为各种安全工具提供了钩子,并将它们放在安全,开发和运营团队的手中,以协作构建坚固的软件。 它旨在促进组之间的测试和通信,并创建可操作的测试,这些测试可以连接到您的部署和测试过程中。

特征

- Gauntlt攻击以易于阅读的语言编写

- 轻松连接到组织的测试工具和流程

- 安全工具适配器配有gauntlt

- 使用unix标准错误和标准输出来传递状态

Gauntlt包含这些工具的攻击适配器:

有两种方法可以开始使用gauntlt。 您可以使用gem安装方法,这将需要您下载和设置安全工具(不用担心gauntlt引导您完成)或者您可以使用Gauntlt入门工具包,这是一个流浪脚本,将自动为您启动工具。

Get started using in 3 easy steps

-

Install the gem

$ gem install gauntlt -

Download example attacks and customize. Here is a very simple network attack using the nmap adapter.

# nmap-simple.attack Feature: simple nmap attack to check for open ports Background: Given "nmap" is installed And the following profile: | name | value | | hostname | example.com | Scenario: Check standard web ports When I launch an "nmap" attack with: """ nmap -F <hostname> """ Then the output should match /80.tcp\s+open/ Then the output should not match: """ 25\/tcp\s+open """ -

Run gauntlt to launch the attack defined above

$ gauntlt # equivalent to gauntlt ./**/*.attack # you can also specify one or more paths yourself: $ gauntlt my_attacks/nmap-simple.attack # other commands to help $ gauntlt --list # the list option will show you the tools that are # available to use with gauntlt $ gauntlt --steps # the steps option will show the gauntlt specific # steps you can use in your attacks $ gauntlt --allsteps # the allsteps option will show all steps including # aruba file operations and parsing steps that are # available to use in attacks $ gauntlt --help # when all else fails use the helpFor more attack examples, refer to the examples.

安全测试通常在审计员的日程安排上进行,测试输出并不总是可操作的。 因此,针对已修复问题的回归常常会回到代码中。 这不好。 它应该是不同的。

本文:http://pub.intelligentx.net/gauntlt-be-mean-your-code-and-it

讨论:请加入知识星球【首席架构师圈】

- 63 次浏览

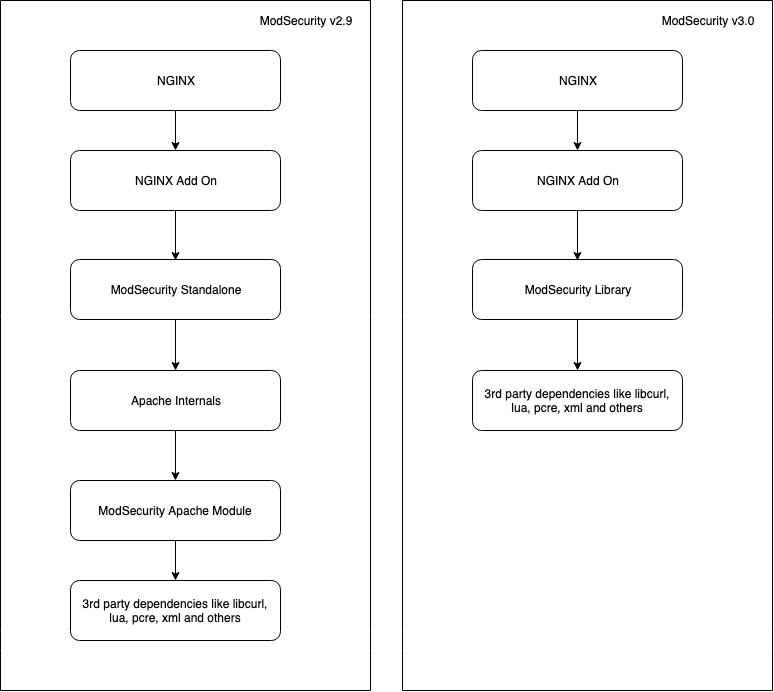

【安全工具】ModSecurity and nginx

nginx是一个网络服务器,它正在世界上越来越多的网站上取代Apache。到目前为止,nginx还不能从ModSecurity提供的安全性中获益。下面是如何安装ModSecurity并让它与nginx一起工作。

今年早些时候,流行的开源网络应用防火墙ModSecurity发布了其软件的第三版。版本3与早期版本有很大的不同,因为它现在已经模块化了。在版本3之前,ModSecurity仅作为一个依赖模块与Apache web服务器一起工作,因此其他HTTP应用程序无法使用ModSecurity。现在,HTTP过滤引擎ModSecurity的核心功能作为一个独立的库libModSecurity存在,它可以通过一个“连接器”集成到任何其他应用程序中。连接器是允许任何应用程序访问libModSecurity的一小段代码。

Web应用程序防火墙(WAF)是用于HTTP请求的一种防火墙。标准防火墙在数据包到达和离开网络接口时检查数据包,并根据规则列表比较数据包的属性。规则规定防火墙是允许数据包通过还是阻止数据包。

ModSecurity执行与标准防火墙相同的任务,但它不是查看数据包,而是在HTTP流量到达服务器时检查它。当HTTP请求到达服务器时,它首先通过ModSecurity路由,然后再路由到目标应用程序,如Apache2或nginx。ModSecurity将入站HTTP请求与规则列表进行比较。这些规则定义了恶意或有害请求的形式,因此,如果传入的请求与规则匹配,ModSecurity将阻止请求到达可能造成伤害的目标应用程序。

下面的例子演示了ModSecurity如何保护WordPress站点。下面的HTTP请求是index.php文件的非恶意请求,它出现在Apache2的日志文件中:

GET /index.php HTTP/1.1

这个请求不匹配任何规则,因此ModSecurity允许它进入web服务器。

WordPress在一个名为wp-config的文件中保存了很多秘密信息,比如数据库密码。它位于与index.php文件相同的目录中。粗心的系统管理员可能不保护这个重要的文件,这意味着像Apache或nginx这样的web服务器很乐意为它提供服务。这是因为它们将提供不受特定配置保护的任何文件。这意味着以下恶意请求:

GET /wp-config.php HTTP/1.1

将由Apache提供给任何请求它的人。

这就是ModSecurity为接受HTTP数据的应用程序提供保护的地方。在本例中,免费的核心ModSecurity规则集包含拒绝任何试图访问WordPress安装中的任何敏感文件的HTTP请求的规则。核心规则集还包含另一个流行的CMS Drupal的规则。

核心规则集还包含许多其他规则,这些规则涵盖了恶意构造HTTP请求以从网站获得访问或机密信息的许多其他方法。这些方法包括SQL注入、漏洞扫描、Java和PHP漏洞利用等等。ModSecurity还支持自定义规则,因此您可以通过编写自己的规则来保护HTTP应用程序免受特定目标的攻击。

首先让我们安装核心ModSecurity库libModSecurity,然后安装nginx连接器,使nginx能够使用ModSecurity。在版本3之前,nginx不可能使用ModSecurity。如果您正在使用Apache2,您应该继续使用ModSecurity version 2,因为Apache2连接器仍然有很多bug,不建议在生产环境中使用。

编译和安装libModSecurity

ModSecurity3不能通过包管理器用于任何主要的Linux发行版。相反,您需要克隆ModSecurity GitHub存储库,并从其源代码构建库。但在此之前,您必须安装所有必需的构建工具和依赖项。下面的列表的包提供了所有必需的和大部分的可选的差异在Debian和Ubuntu发行版:野牛,flex,, automake, gcc, pkg-config, libtool, doxygen, git,卷发,zlib1g-dev, libxml2-dev, libpcre3-dev,建设重要,libyajl-dev, yajl-tools, liblmdb-dev, rdmacm-utils, libgeoip-dev, libcurl4-openssl-dev, liblua5.2-dev, libfuzzy-dev, openssl和libssl-dev。

注意,其中一些包在基于Red hat的发行版上有不同的名称。这个页面将帮助您确定具体的包名是什么。

安装这些包之后,您可以继续编译库。这些指令与分布无关。

首先,克隆libModSecurity git存储库,它将下载构建libModSecurity所需的所有源代码。使用/opt/目录作为所有源代码的目标。移动到/opt/目录,并使用以下命令克隆libModSecurity git存储库:

cd /opt/ git clone https://github.com/SpiderLabs/ModSecurity

接下来,进入克隆ModSecurity存储库时创建的新目录,并切换到v3分支。你还需要引入几个必要的子模块:

cd ModSecurity git checkout v3/master git submodule init git submodule update

现在可以构建libModSecurity了。对于任何从源代码编译程序的人来说,这应该是一个熟悉的过程。你只需要以下三个命令来编译和安装程式库:

sh build.sh ./configure make make install

如果您在一个普通的虚拟服务器上运行make命令,则需要几分钟。libModSecurity库现在安装在/usr/local/modsecurity/lib/ libModSecurity .so上。但是,在安装将HTTP数据连同一些规则重定向到libModSecurity库的应用程序和连接器之前,它不能做任何事情。下一节将介绍如何安装nginx连接器和ModSecurity开发人员提供的核心规则集。

编译nginx连接器

让我们利用nginx动态加载第三方模块的能力来编译nginx连接器。nginx从1.11.5版开始就能够做到这一点。此版本或更高版本在大多数主要发行版的标准存储库中都不可用。nginx为Red Hat/CentOS、Debian和Ubuntu的当前稳定版本提供了存储库,其中包含一个支持动态模块加载的版本。这个页面列出了这些存储库以及将nginx存储库添加到您的发行版的信息。在将nginx存储库添加到存储库配置之后,需要使用包管理器安装nginx。当你安装了nginx,用这个命令找到你安装的版本:

nginx - v

当您拥有版本号时,请切换到/opt/目录并从此页下载与nginx版本匹配的源代码,然后解压缩下载的存档文件。

接下来,您需要为ModSecurity nginx连接器克隆git存储库。从/opt/目录中运行以下命令克隆这个存储库:

git clone https://github.com/SpiderLabs/ModSecurity-nginx

现在切换到解压nginx源存档时创建的新目录。在该目录中,运行以下命令编译连接器:

./configure --with-compat ↪--add-dynamic-module=/opt/ModSecurity-nginx make modules

现在,您需要使用以下命令将连接器模块复制到nginx modules目录中:

cp objs/ngx_http_modsecurity_module.so /etc/nginx/modules/

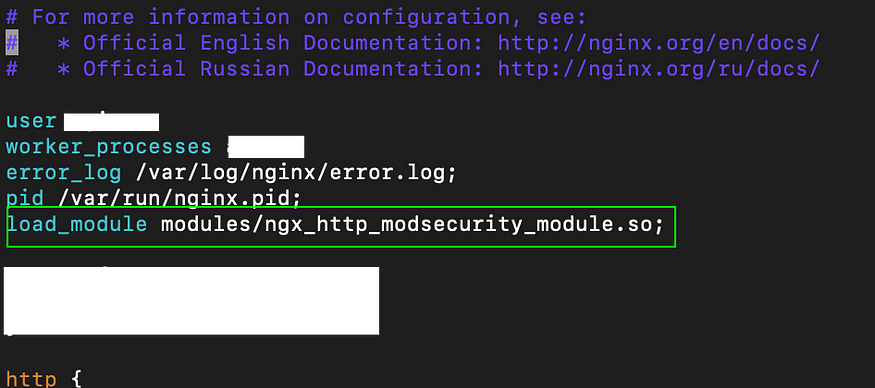

现在已经编译了nginx连接器并将其复制到正确的位置,您需要配置nginx来使用它。此外,还需要下载libModSecurity用于过滤HTTP数据的规则。

首先,移动到nginx配置目录:

cd /etc/nginx/

并将以下行添加到nginx的主配置文件/etc/nginx/nginx.conf:

load_module modules/ngx_http_modsecurity_module.so;

您需要将这一行放在以pid开头的行下面的第一个部分中,而不是放在事件或http部分中。

接下来,创建一个新的目录,并加载ModSecurity规则和配置到其中:

mkdir /etc/nginx/modsec cd /etc/nginx/modsec git clone https://github.com/SpiderLabs/ ↪owasp-modsecurity-crs.git

使用从git存储库下载的ModSecurity rules配置文件,使用以下命令重新命名它:

mv /etc/nginx/modsec/owasp-modsecurity-crs/ ↪crs-setup.conf.example /etc/nginx/modsec/ ↪owasp-modsecurity-crs/crs-setup.conf

现在需要将ModSecurity配置文件从构建libModSecurity的目录复制到/etc/nginx/modsec/:

cp /opt/ModSecurity/modsecurity.conf-recommended ↪/etc/nginx/modsec/modsecurity.conf

最后,创建一个新的配置文件,加载这两个配置文件和所有规则文件。这个文件将由nginx服务器配置块中的几行代码调用,这将调用ModSecurity的使用。用文本编辑器创建并开始编辑这个文件:

nano /etc/nginx/modsec/main.conf

添加以下三行到这个文件:

Include /etc/nginx/modsec/modsecurity.conf Include /etc/nginx/modsec/owasp-modsecurity-crs/crs-setup.conf Include /etc/nginx/modsec/owasp-modsecurity-crs/rules/*.conf

现在已经完成了nginx、libModSecurity、nginx连接器和ModSecurity规则的构建和安装。现在可以启动或重新启动nginx来加载新配置。如果一切正常,在重新启动nginx时,您不会看到打印出任何错误。

测试ModSecurity

让我们通过向“默认”服务器添加几行代码并发出一个将被ModSecurity阻塞的请求来测试ModSecurity。默认的服务器配置是nginx在安装时使用的配置,并且只在本地主机上监听,而不在面向internet的网络接口上监听。这使得在创建任何自定义服务器配置之前启动nginx是安全的,因为默认配置无法从internet访问。

默认服务器配置位于/etc/nginx/conf.d/default.conf。使用文本编辑器打开此文件,并在server_name行下添加以下两行:

modsecurity on; modsecurity_rules_file /etc/nginx/modsec/main.conf;

重新启动nginx来加载这个新配置。现在,要测试ModSecurity是否正常工作,您所需要做的就是发出一个匹配禁用规则的HTTP请求。

ModSecurity有两种操作模式。默认情况下,它将只记录与禁止规则匹配但允许它们传递给应用程序的查询。这种模式允许系统管理员运行ModSecurity一段时间,并确保没有干扰网站正常运行的假阳性请求被阻塞。ModSecurity将这些与/var/log/modsec_audit.log中禁止的规则匹配的请求记录下来。

您可以创建一个HTTP请求,通过使用curl发出包含禁用用户代理头的请求,该请求将被记录到该日志文件中。下面的命令发出一个HTTP请求,其中包含标题“User-Agent: masscan”。这是一个被禁止的用户代理,所以ModSecurity记录了它目睹了一个被禁止的HTTP请求。这个命令看起来像:

curl -H "User-Agent: masscan" http://localhost/

nginx返回默认的欢迎页面作为原始HTML,但是ModSecurity在/var/log/modsec_audit.log中创建了一个很长的日志条目,开头是:

ModSecurity: Warning. Matched "Operator `PmFromFile' ↪with parameter `scanners-user-agents.data' against &rarrhkk;variable `REQUEST_HEADERS:User-Agent' (Value: `masscan' )

这表明ModSecurity成功拦截并匹配了恶意HTTP请求。

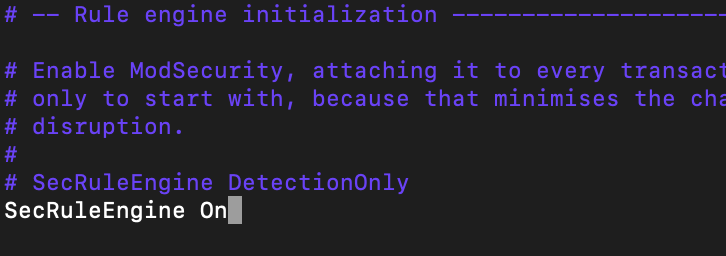

当您想要将ModSecurity从记录恶意HTTP请求切换到主动阻塞它们时,请编辑/etc/nginx/modsec/modsecurity.conf中的行:

SecRuleEngine DetectionOnly

to

SecRuleEngine On

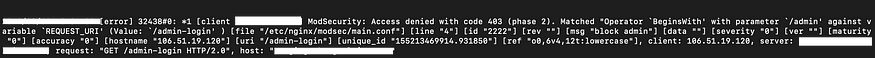

并重启nginx。现在相同的curl请求将导致403错误:

curl -H "User-Agent: masscan" http://localhost/ <html> <head><title>403 Forbidden</title></head> <body bgcolor="white"> <center><h1>403 Forbidden</h1></center> <hr><center>nginx/1.12.2</center> </body> </html>

被阻塞的请求也将被记录到/var/log/modsec_audit.log。

额外的ModSecurity连接器

ModSecurity新的模块化特性意味着任何接受或处理HTTP数据的应用程序都可以使用ModSecurity及其规则来分析HTTP数据。在撰写本文时,ModSecurity v3的发布质量只有几个月的时间,因此没有太多额外的连接器可以让应用程序连接到libModSecurity。

谷歌代码之夏产生了一些有趣的新连接器。第一个扩展了Snort v3使用ModSecurity规则的能力。Snort是一个入侵检测和实时包嗅探及日志记录应用程序。这个连接器允许Snort将捕获的HTTP数据发送到libModSecurity,并根据ModSecurity规则集对其进行检查。这个项目的主页(https://akoul.github.io/)在这里。

第二个google赞助的连接器目标是node.js服务器。js是一个JavaScript运行时,支持创建可伸缩的网络应用程序。该连接器通过ModSecurity路由所有入站HTTP请求,从而向节点应用程序添加一个安全层。你可以在它的主页上阅读更多关于这个项目的信息(https://m2n.me/gsoc)。

ModSecurity v3的发布将ModSecurity从Apache模块转换为一个灵活的应用程序,任何接受HTTP数据的应用程序都可以轻松地利用这个灵活的应用程序。由于人们所依赖的应用程序越来越多地从本地计算机转移到数据中心,因此确保这些应用程序和数据的安全性变得越来越重要。

原文:https://www.linuxjournal.com/content/modsecurity-and-nginx

本文:

讨论:请加入知识星球或者小红圈【首席架构师圈】

- 146 次浏览

【安全工具】ModSecurity性能的建议

有时我们看到ModSecurity用户在邮件列表中询问性能。在这篇文章中,我将讨论一些提高ModSecurity性能的重要主题。

1 - HTTP缓存和加速

在一个通用的web环境中,静态内容(例如。图像)http通信的大部分区域。通常,用户不希望对这类内容执行安全规则。因此,第一个建议是在ModSecurity前面设置一个HTTP缓存和加速解决方案。

我们有有趣的开源解决方案,其中之一就是Varnish。。您可以将其设置在ModSecurity前面,并将其配置为缓存静态流量。一旦完成,Varnish将开始提供这类内容,ModSecurity将只看到真正需要的东西。

另一个可能的解决方案是设置规则来检测您想要检查和忽略其他文件扩展名:

SecRuleEngine On

SecAction "id:'1', phase:1, t:none,setvar:'tx.inspect_extensions=.html/ .php/', nolog, pass"

SecRule REQUEST_BASENAME "\.(.*)$""chain,capture,allow,setvar:tx.exts=.%(tx.1}/,phase:1, t:none,t:urlDecodeUni, t:lowercase,id:2,logdata:'%{TX.0}'"

SecRule TX:EXTS "!@within %{tx.inspect_extensions}"

然而,这并不是最好的解决方案,因为即使您跳过所有其他规则,ModSecurity也会花时间对这类数据进行缓冲、转发和执行一些规则。

2 -规则选择

如果您正在使用OWASP核心规则集,那么规则选择是另一个要讨论的重要主题。

我们在CRS中有许多类别的规则,您应该重新查看它们,并确定所有类别和规则对您是否重要。

我们建议加载所有规则,但是从性能的角度来看,有时是不可能的。所以你应该做一个风险分析,并载入原始数据。

3 -规则执行模式

OWASP核心规则集项目中的规则可以在两种不同的模式下执行:

自包含模式——规则继承“拒绝”破坏性操作。第一个匹配的规则将被阻塞。

协作检测模式——这是一种“延迟阻塞”操作模式,其中每个匹配规则将继承“通过”操作,并且只会导致异常分数。

从性能的角度来看,自包含模式是最好的解决方案,因为它执行的规则应该少于协作模式,从而减少了由规则引擎和日志引擎引起的开销。然而,从假阳性的角度来看,协作模式可以发出较少的假阳性。

也就是说,您应该首先尝试默认模式(自包含模式),然后决定是否适合您。如果没有,在决定转向协作检测模式之前,我建议先使用ModSecurity规则异常特性。

值得一提的是,只有在SecRuleEngine打开时,才应该从性能的角度看到结果。

4 -规则预过滤

如果您打算编写自己的规则,特别是使用@rx操作符和非平凡的正则表达式来检查大量数据,比如响应体,您应该考虑使用@pm操作符作为预过滤器规则:

SecRule RESPONSE_BODY "@pm some_leak_patterns" "phase:4,chain,id:12345,deny"SecRule RESPONSE_BODY "@rxyour_nontrivial_regex_some_leak_patterns"

@pm操作符使用一种名为Aho-Corasick的快速多模式匹配算法,可以用来避免对入站和出站缓冲区执行regex。

另一个预过滤器的想法是:

- 立即拒绝来自国家的ip

- 立即拒绝有坏名声的ip

- 立即拒绝不允许参数数量的事务

- 立即拒绝参数长度不允许的事务。。

有了这个想法,您可以构建一小组规则,这些规则将在CRS之前运行,并将立即拒绝事务,以避免根据所有CRS规则检查它们。

5 -缓冲

ModSecurity工作,缓冲入站和出站数据到belater受规则检查。与此主题相关的主要瓶颈是缓冲响应体,原因有二:它将消耗大量RAM,并且通常放置在响应体阶段的规则非常昂贵。

也就是说,您可以考虑禁用响应体检查功能,将SecResponseBodyAccess设置为Off,并有条件地启用它,在特定情况下使用针对特定类型ecresponsebodymimetypes的responseBodyAccessOn ..

例如:

SecResponseBodyMimeType text/plain text/html text/xml

SecResponseBodyAccess Off

SecRule REQUEST_BODY|ARGS "@pm union select""phase:2,chain,id:1234,ctl:responseBodyAccess=On"

SecRule REQUEST_BODY|ARGS "@rxyour_nontrivial_regex_union_select"

SecRule RESPONSE_BODY "@pm some_leak_patterns""phase:4,chain,id:12345,deny"

SecRule RESPONSE_BODY "@rxyour_nontrivial_regex_some_leak_patterns"

6 -日志

如果你不集中注意力,日志引擎可能会成为性能杀手:

在规则中不断执行调优过程,以避免太多的误报。请记住,磁盘i/o非常昂贵,并且您不希望花费资源来记录误报。

不要使用串行记录模式。它使用锁来保护文件,这会降低性能。而是使用并发模式。

检查正在记录的审计日志部分。像k和E这样的部分可能会增加日志引擎带来的开销,因为它通常需要向磁盘写入大量数据。

不要启用生产中的调试日志。

7 - PCRE-JIT

在pcrelibrary中插入了即时编译器支持(>=8.20)。即时编译是一种优化,可以极大地加快模式匹配操作。当相同的条件被多次匹配时,效果最好。

发布8.20 21-Oct-2011——

这个版本的主要变化是包含了ZoltanHerczeg的即时编译器支持,可以通过构建PCREwith——enable-jit来访问它。8.20还修复了8.13中引入的一个不幸的bug,并消除了与Perl的一些错误和差异。

ModSecurity 2.7。x系列可以使用PCRE-JIT执行regex。从性能的角度来看,这是一个非常好的特性。要启用它,您必须使用以下配置选项编译ModSecurity:

./configure –enable-pcre-jit

确保您的PCRE库是使用JIT支持编译的(使用上面的PCRE发行说明中描述的选项)。而且modsecurityandapache必须使用相同的库版本。你可以查看intoerror log来检查它。

例如,我们发送了一个大的输入,请求体规则处理并测量了花费的时间:

JIT Disabled Phase 2 rules = 422749 usecs

JIT Enabled Phase 2 rules = 115777 usecs

看看这个例子,pcr -jit可以使规则平均速度提高75%。

8.缓存Lua虚拟机

这适用于需要在同一事务中执行多个Lua脚本的人。正常情况下,ModSecurity会创建并销毁一个运行在同一事务中的VM foreach lua脚本。你可以改变这个行为,重新编译ModSecurity与选项:

./configure –enable-lua-cache

重新编译后,ModSecurity将在整个事务期间将LuaVM保存在内存中,从而减少create/destroyVM操作造成的开销。

作为一个例子,让我们来测量在同一事务中执行的三个脚本的性能:

禁用缓存

Lua: Executing script: /etc/apache2/modsecurity/script1.lua

Lua: Script completed in 742 usec, returning: 1.

Lua: Executing script: /etc/apache2/modsecurity/script2.lua

Lua: Script completed in 517 usec, returning: 1.

Lua: Executing script: /etc/apache2/modsecurity/script3.lua

Lua: Script completed in 489 usec, returning: 1.

Total: 1748usecs

缓存启用

Lua: Executing script: /etc/apache2/modsecurity/script1.lua

Lua: Script completed in 592 usec, returning: 1.

Lua: Executing script: /etc/apache2/modsecurity/script2.lua

Lua: Script completed in 130 usec, returning: 1.

Lua: Executing script: /etc/apache2/modsecurity/script3.lua

Lua: Script completed in 101 usec, returning: 1.

Total: 823usecs

我们可以看到由VM创建/销毁操作导致的开销减少了约50%。

9.检测昂贵的规则。

如果有更多的性能问题,您可以尝试以下步骤来找到昂贵的规则,然后有机会改进它。

作为一个例子,假设我们试图检测运行在阶段2(请求体)上的昂贵规则。如果您使用的是最新的modsecurity版本(>= 2.7.4),则可以使用所有这些特性。

创建一个规则来检测阶段2是否存在问题。假设1000微秒太多了

SecRule PERF_PHASE2 "@qt 1000" "id:1234,phase:3"

如果你有一个触发器,它表明你有昂贵的规则。因此,让我们试着检测它们是否添加了遵循规则

# All rules that spent more than 50usecs will be present inaudit log part H

SecRulePerfTime 50

# PERF_RULES is a collection that will contain all rulesthat spent more than SecRulePerfTime vallue to run.

SecRule PERF_RULES "@qt 50" "id:1,phase:3"

所以如果你有昂贵的规则,我们会看到警告:

[Tue Apr 23 17:50:26 2013] [error] [client 192.168.0.103]ModSecurity: Warning. Operator GT matched 50 at PERF_RULES:960032. [file"/etc/apache2/modsecurity/owasp-modsecurity-crs-2.2.6/base_rules/modsecurity_crs_99_perl.conf"][line "2"] [id "1"] [hostname "192.168.0.104"][uri "/acao.php"] [unique_id "UXcCIsCoAGUAACvOLqcAAAAD"]

[Tue Apr 23 17:50:26 2013] [error] [client 192.168.0.103]ModSecurity: Warning. Operator GT matched 50 at PERF_RULES:958022. [file"/etc/apache2/modsecurity/owasp-modsecurity-crs-2.2.6/base_rules/modsecurity_crs_99_perl.conf"][line "2"] [id "1"] [hostname "192.168.0.104"][uri "/acao.php"] [unique_id "UXcCIsCoAGUAACvOLqcAAAAD"]

[Tue Apr 23 17:50:26 2013] [error] [client 192.168.0.103]ModSecurity: Warning. Operator GT matched 50 at PERF_RULES:973323. [file"/etc/apache2/modsecurity/owasp-modsecurity-crs-2.2.6/base_rules/modsecurity_crs_99_perl.conf"][line "2"] [id "1"] [hostname "192.168.0.104"][uri "/acao.php"] [unique_id "UXcCIsCoAGUAACvOLqcAAAAD"]

我们可以看到,规则960032、958022和973323的执行花费了50 usecs。,但具体需要多少时间呢?您将把这些信息放入审计日志H部分:

Rules-Performance-Info: "960032=622","958022=731", "973323=109".

请查看参考手册以查看所有PERF_variables。

10 -永久存储

ModSecurity的持久存储机制是基于磁盘的。尽管如此,它并不快,好像我们可以共享内存中的数据。因此,如果可能的话,我们可以在RAMDISK中设置和定义数据目录。modsecurity中持久存储文件可能比需要的大,因为旧条目只有在过期时才会被覆盖。默认过期时间是3600秒,这通常太多了,您可能需要几分钟的数据,所以可以使用SecCollectionTimeout指令减少默认超时。

本文:http://pub.intelligentx.net/modsecurity-performance-recommendations

讨论:请加入知识星球或者小红圈【首席架构师圈】

- 541 次浏览

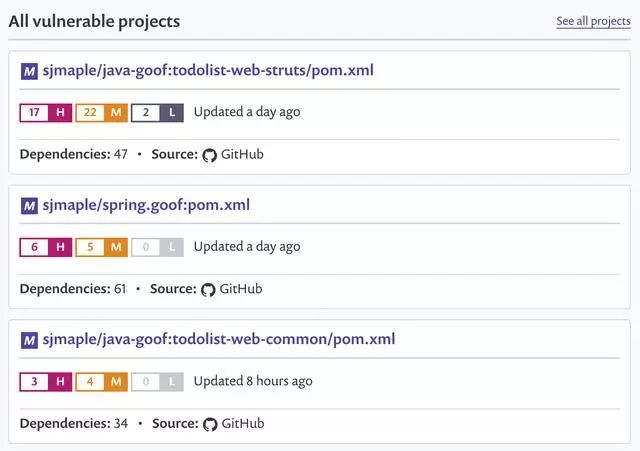

【安全工具】OWASP Dependency Check

OWASP依赖性检查

Dependency-Check是一个软件组合分析实用程序,用于识别项目依赖关系并检查是否存在任何已知的,公开披露的漏洞。目前,支持Java和.NET;为Ruby,Node.js,Python添加了额外的实验支持,并为C / C ++构建系统(autoconf和cmake)提供了有限的支持。该工具可以作为OWASP Top 10使用已知漏洞的组件的解决方案的一部分,该漏洞以前称为OWASP Top 10 2013 A9 - 使用具有已知漏洞的组件。

介绍

OWASP Top 10 2013包含一个新条目:A9-使用具有已知漏洞的组件。依赖性检查当前可用于扫描应用程序(及其依赖库)以识别任何已知的易受攻击的组件。

Jeff Williams和Arshan Dabirsiaghi在题为“不安全库存的不幸现实”的论文中很好地描述了使用已知易受攻击组件的问题。本文的要点是,作为开发社区,我们在应用程序中包含第三方库,其中包含众所周知的已发布漏洞(例如国家漏洞数据库中的漏洞)。

Dependency-check有一个命令行界面,一个Maven插件,一个Ant任务和一个Jenkins插件。核心引擎包含一系列分析器,用于检查项目依赖性,收集有关依赖项的信息(在工具中称为证据)。然后,该证据用于标识给定依赖项的公共平台枚举(CPE)。如果标识了CPE,则会在报告中列出关联的常见漏洞和披露(CVE)条目的列表。

依赖关系检查使用NIST托管的NVD数据源自动更新自身。重要说明:数据的初始下载可能需要十分钟或更长时间。如果您每七天至少运行一次该工具,则只需要下载一个小的XML文件,以使数据的本地副本保持最新。

Quick Download

Version 5.1.0

- Command Line

- Ant Task

- Maven Plugin

- Gradle Plugin

- Mac Homebrew:

brew update && brew install dependency-check

Version 4.0.2

Other Plugins

Integrations

讨论:请加入知识星球【首席架构师圈】

- 522 次浏览

【安全工具】Suricata完整的功能列表

引擎

- 网络入侵检测系统(NIDS)引擎

- 网络入侵防御系统(NIPS)引擎

- 网络安全监控(NSM)引擎

- 离线分析PCAP文件

- 使用pcap记录器记录流量

- Unix套接字模式,用于自动PCAP文件处理

- 与Linux Netfilter防火墙的高级集成

操作系统支持

- Linux

- FreeBSD

- OpenBSD

- macOS / Mac OS X

- Windows

配置

- 配置文件-人和机器可读

- 良好的注释和文档

- 支持包括其他文件

TCP / IP引擎

- Scalable flow engine

- Full IPv6 support

- Tunnel decoding

- Teredo

- IP-IP

- IP6-IP4

- IP4-IP6

- GRE

- TCP stream engine

- tracking sessions

- stream reassembly

- target based stream reassembly

- IP Defrag engine

- target based reassembly

协议解析器

- 支持数据包解码

- IPv4, IPv6, TCP, UDP, SCTP, ICMPv4, ICMPv6, GRE

- 以太网,PPP, PPPoE, Raw, SLL, VLAN, QINQ, MPLS, ERSPAN

- App层解码:

- HTTP、SSL、TLS、SMB、DCERPC、SMTP、FTP、SSH、DNS、Modbus、ENIP/CIP、DNP3、NFS、NTP、DHCP、TFTP、KRB5、IKEv2

- 使用Rust语言开发的新协议,用于安全快速的解码。

HTTP引擎

- Stateful HTTP parser built on libhtp

- HTTP request logger

- File identification, extraction and logging

- Per server settings — limits, personality, etc

- Keywords to match on (normalized) buffers:

- uri and raw uri

- headers and raw headers

- cookie

- user-agent

- request body and response body

- method, status and status code

- host

- request and response lines

- decompress flash files

- and many more

探测引擎

- Protocol keywords

- Multi-tenancy per vlan or capture device

- xbits – flowbits extension

- PCRE support

- substring capture for logging in EVE

- fast_pattern and prefilter support

- Rule profiling

- File matching

- file magic

- file size

- file name and extension

- file MD5/SHA1/SHA256 checksum — scales up to millions of checksums

- multiple pattern matcher algorithms that can be selected

- extensive tuning options

- live rule reloads — use new rules w/o restarting Suricata

- delayed rules initialization

- Lua scripting for custom detection logic

- Hyperscan integration

输出

- Eve log, all JSON alert and event output

- Lua output scripts for generating your own output formats

- Redis support

- HTTP request logging

- TLS handshake logging

- Unified2 output — compatible with Barnyard2

- Alert fast log

- Alert debug log — for rule writers

- Traffic recording using pcap logger

- Prelude support

- drop log — netfilter style log of dropped packets in IPS mode

- syslog — alert to syslog

- stats — engine stats at fixed intervals

- File logging including MD5 checksum in JSON format

- Extracted file storing to disk, with deduplication in the v2 format

- DNS request/reply logger, including TXT data

- Signal based Log rotation

- Flow logging

报警/事件过滤

- per rule alert filtering and thresholding

- global alert filtering and thresholding

- per host/subnet thresholding and rate limiting settings

包获取

- High performance capture

- AF_PACKET

- experimental eBPF and XDP modes available

- PF_RING

- NETMAP

- AF_PACKET

- Standard capture

- PCAP

- NFLOG (netfilter integration)

- IPS mode

- Netfilter based on Linux (nfqueue)

- fail open support

- ipfw based on FreeBSD and NetBSD

- AF_PACKET based on Linux

- NETMAP

- Netfilter based on Linux (nfqueue)

- Capture cards and specialized devices

- Endace

- Napatech

- Tilera

多线程

完全可配置线程——从单线程到几十个线程

预煮的“runmodes”

可选CPU关联设置

使用细粒度锁定和原子操作获得最佳性能

可选锁分析

IP的声誉

- loading of large amounts host based reputation data

- matching on reputation data in the rule language using the “iprep” keyword

- live reload support

- supports CIDR ranges

工具

- Suricata-Update for easy rule update management

- Suricata-Verify for QA during development

原文:https://suricata-ids.org/features/all-features/

本文:

讨论:请加入知识星球或者小红圈【首席架构师圈】

- 1091 次浏览

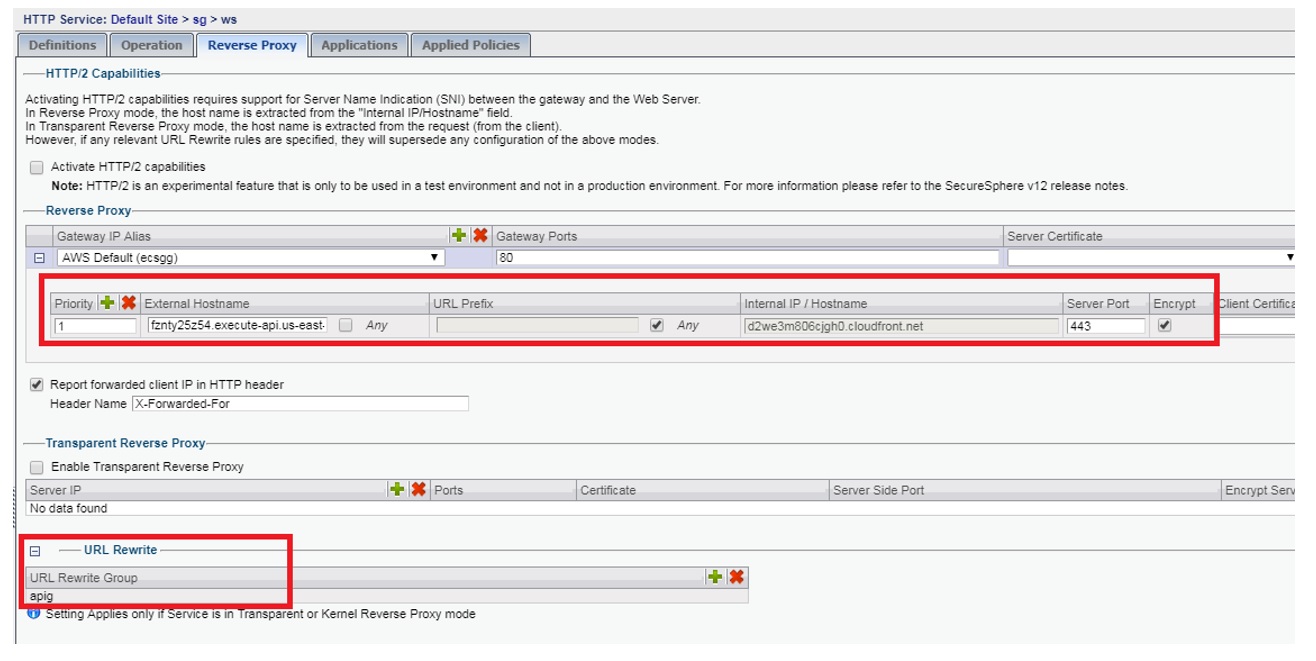

【安全工具】将ModSecurity与AWS WAF集成

对于企业来说,通往云的旅程并不像云提供商的营销视频所描述的那么容易和简单。这篇文章详细介绍了我们旅程中某个阶段的一些背景故事。

我们首先设置由ACM管理的ELB负载平衡器w/ certificates来处理面临HTTPS流量的客户。这些流量最终代理到运行WAF的现有web服务器,然后再代理到应用服务器。

我们从列出所有的NAT网关IP地址开始,这些地址会从我们的VPC攻击我们现有的WAF,这样如果我们现有的WAF阻塞了流量,它就不会避开作为我们NAT网关的IP。在这一点上,我们仍然会403恶意请求,但我们没有办法防火墙关闭IP完全停止他们的流量。

我们在AWS WAF上测试了几家供应商提供的一些托管规则,但说实话,我们只是觉得我们不了解这个产品,不知道如何配置它来真正阻止某些东西,等等。要完全取代我们现有的WAF,学习它们的WAF需要花费更多的时间。

我们仍然有一个问题,就是想要在一段时间内阻止恶意流量,一旦攻击被检测到,就像我们可以用我们的内部基础设施一样。我们需要在流量进入VPC之前阻止它。是时候写一些胶水代码了…

因此,让我们深入研究一下我们如何通过ModSecurity和AWS WAF进一步实现这一点。ModSecurity是可用的最流行的WAF (web应用程序防火墙)之一。Apache的ModSecurity已经存在很长时间了,最新的libmodsecurity 3也是如此。x把这个功能带到Nginx。ModSecurity提供的规则集范围从免费到付费和专业维护:

我们的组织长期以来一直是Atomicorp Secure Linux (ASL)的用户,因此我们非常熟悉他们的规则集、对它们进行调优,并与他们的支持进行交互。很好的合作组织。

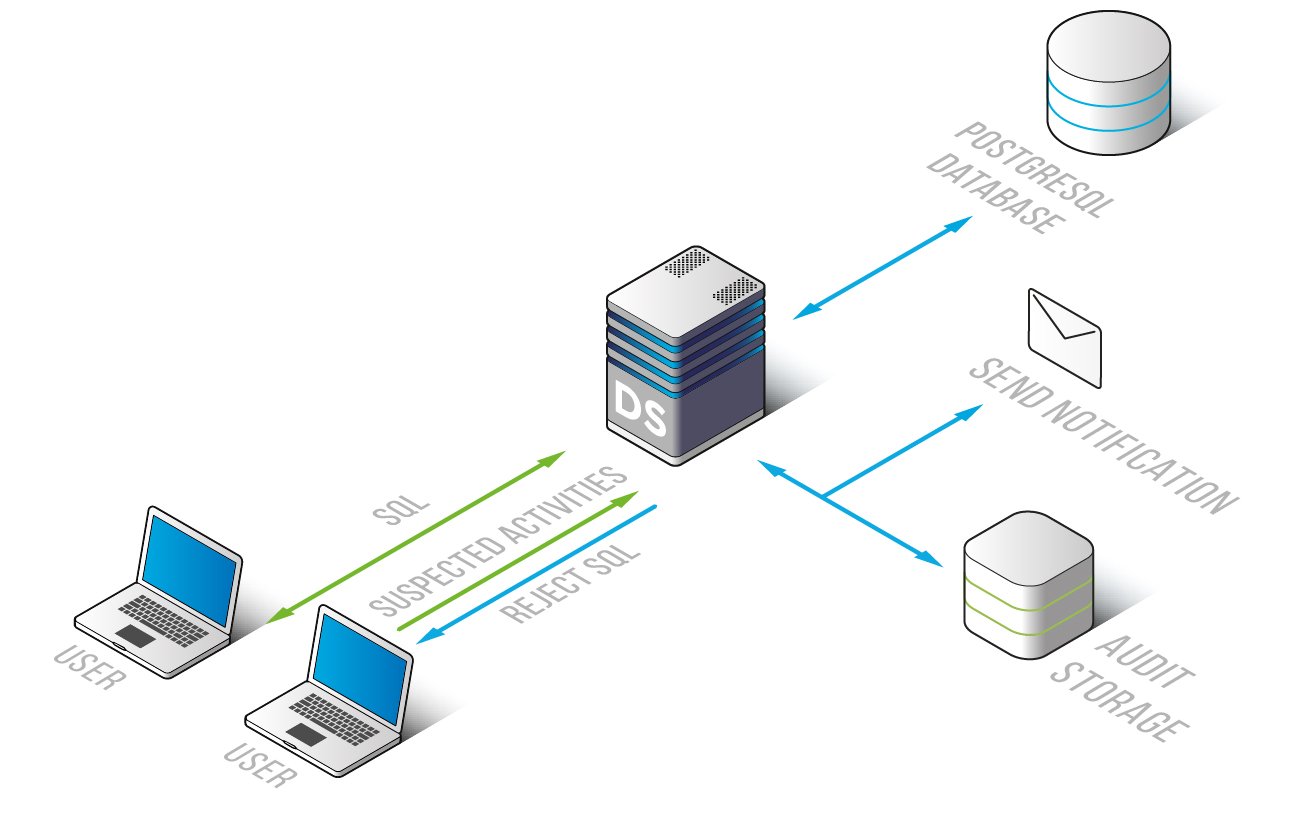

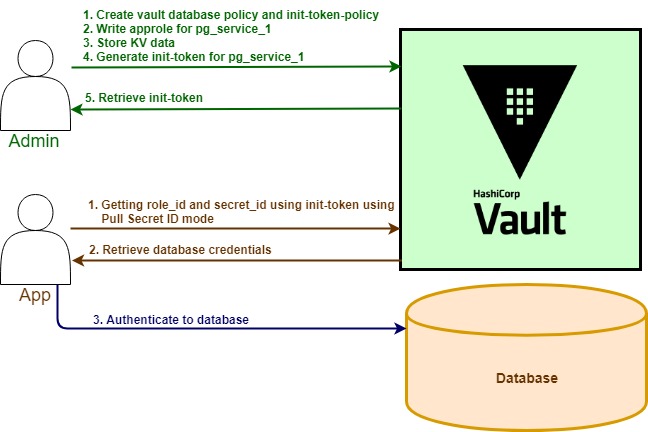

所以让我们来看看我们今天是如何探索事物的核心。ASL管理web服务器的Apache和ModSecurity组件。当恶意请求发生时,将一个条目输出到/var/log/httpd/audit_log,然后在/var/asl/audit/data/…下面写入一个文件,处理流程如下所示。

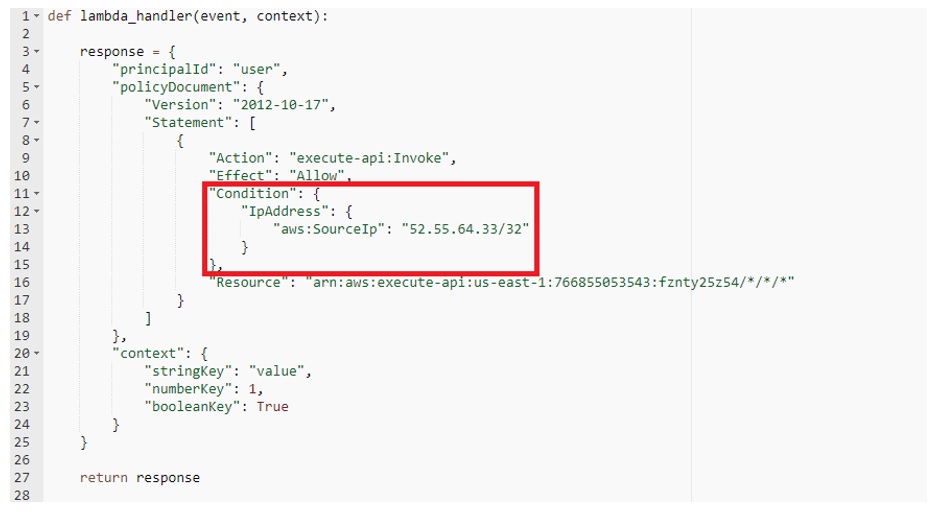

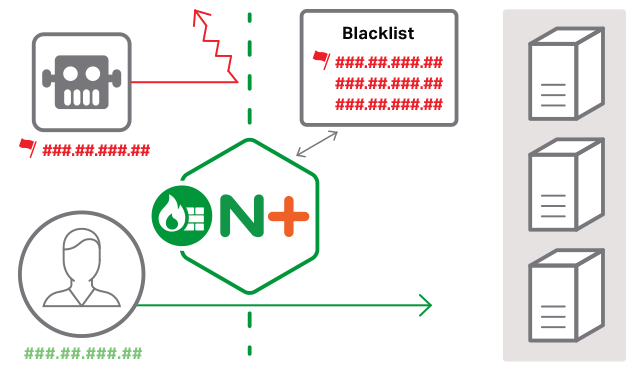

- 我们的web服务器监视程序跟踪audit_log,读取单个事件记录,执行一些正则表达式解析,然后通过HTTPS将事件数据发送到AWS API网关

- API网关将数据推送到SQS“shun”队列中。

- 我们将“SHUN”Lambda函数连接到SQS队列,以便立即调用它。它读取有效负载(提取ELB头,等等),与RDS数据库交互,以确定应该为给定的规则和IP的历史做什么,然后如果需要,我们更新一个绑定到黑名单规则的AWS WAF IP集。将IP放在黑名单规则的IP集中,相当于ASL运行iptables命令来避开linux防火墙级别的IP。lambda函数还将modsecurity事件有效负载的副本存储在S3中,以便以统一的方式进行进一步检查。

- 就像标准的ASL一样,您通常希望在一段时间后解除IP阻塞。因此,我们为“unshun”发送另一个SQS队列,但是这个队列被配置为有10分钟的交付延迟。

- 我们的“UNSHUN”lambda由SQS队列调用,然后决定是否应该解封IP地址。如果是这样,则从AWS WAF IP集中删除它。这个lambda函数还执行一些审计工作,以确保AWS WAF IP集中反映了我们希望基于跟踪数据库阻塞的IP。有时候,如果您有一批IP,并且必须一个接一个地重试,那么从IP集中删除一个IP将会失败。经过一些尝试和错误,使审计例程健壮。

所以我们用

- 1 API Gateway

- 1 S3 bucket

- 2 SQS queues

- 2 Lambda functions

- 1 RDS cluster (3 tables)

- AWS WAF

- ASL ModSecurity WAF

是一个基于云的WAF,具有业界领先的规则,可以在几毫秒内响应恶意请求,并在所有的esb中使用AWS WAF避开流量。

我们希望ASL能够更新他们的产品,提供与AWS WAF的直接集成来提供这个功能。在我们的理想世界,ASL会:

- 不运行本地数据库,而是所有实例都能够使用RDS Aurora MySQL数据库进行跨多个web服务器的所有事件跟踪、规则配置、IP信誉等,而无需进行glass部署。

- 通过一个简单的配置选项(当然还有分配给允许它的实例的IAM角色)管理AWS WAF IP集,将其列入黑名单

- 向SNS公开事件流信息,以便将其路由到其他各种AWS服务进行集成和分析。

我们还进行了一些实验,以构建尽可能轻的web服务器,并实现类似的阻塞功能。我们测试了下列各项:

- 从源代码编译modsecurity,在CentOS上支持JSON。这并不像你想象的那么糟糕,一旦你找到了依赖关系。

- 配置modsecurity和mlogc,直接将HTTPS PUT执行到API网关(因为它是JSON,我们可以直接进入API网关,而无需修改任何代码)

这个场景可以很好地使用OWASP核心规则集或ASL规则集,但是我们必须编写一个规则集升级引擎来自动化它,因为在那个特定的场景中我们没有完整的ASL安装。

我们做的另一件非常有效的事情是阻塞流量,其中主机头是一个数字IP地址,URL以.php结尾。这些只不过是恶意扫描器通过IP在internet上逐个查找易受攻击的PHP安装。它们会向您的服务器发出数百个请求。因此,我们现在对fire请求发出一个block,防止它们滥用我们的基础设施。

我们发现另一个有用的场景是,我们的应用程序使用403响应代码阻塞请求(这将导致生成modsecurity事件),并包含一个HTTP响应头和一个附加的原因代码。我们的shun lambda函数看到这些事件并执行块,就像触发了实际的modsecurity规则一样。这允许我们通过利用现有的管道将应用程序级安全代码绑定到AWS WAF。

在我们的跟踪数据库中,我们也完全禁止ip在他们绊倒一定数量的块之后。这些都是持续的不良行为ip,所以我们会在很长一段时间内禁止它们。

这个管道场景的操作成本是多少?最昂贵的部分将是RDS Aurora数据库集群,但大多数AWS客户至少有一个可以利用的数据库集群。其余的API网关、SQS和Lambda处理可能是< $1/mo。编写的代码量可能少于1000行。通过WAF传输的成本将根据您正在处理的请求的数量而变化。底线是这是一个廉价的解决方案。

你能把这个解扩展到多高?AWS WAF ACL可以有10条规则,如果这些规则都是黑名单规则,那么您可以同时阻塞多达100,000 (10 x 10,000)个ip。

我们和ASL的人分享了这个想法,他们都很兴奋。我非常希望在不久的将来,我们会在ASL或OSSEC中看到对此的原生支持。

原文:https://medium.com/@jonathantew/integrating-modsecurity-with-aws-waf-f26b5af4c1a8

本文:http://pub.intelligentx.net/node/573

讨论:请加入知识星球或者小红圈【首席架构师圈】

- 101 次浏览

【机密计算】什么是机密计算?为什么它对企业很重要

什么是机密计算?

机密计算是一种使用安全飞地技术的方法,可以基于CPU供应商提供的安全特性创建可信执行环境(TEE)。TEE允许在CPU内进行加密/解密、内存和数据隔离,以及其他因CPU供应商而异的安全功能。安全飞地技术是机密计算的基础。

云端及其以外的硬件级隐私

数据泄露的风险是巨大且持久的。它威胁到云本身的信任、完整性和生存能力。计算机科学已经解决并克服了对存储中的静态数据和网络传输中的数据进行加密的问题。但棘手的问题仍然存在:如何保护内存中实际使用的数据和代码——这个目标似乎受到传统计算架构本身的限制。使用软件加密隐藏数据的尝试失败。计算硬件要求加密密钥在使用前解密并在内存中公开,从而使其容易受到黑客或内部人员的攻击。

作为回应,机密计算通过安全飞地(通常与TEE互换使用)创新了前所未有的硬件级体系结构安全方法。Confidential Computing特别关注使用中的数据的安全,通过保护内存来消除数据在处理过程中未加密时的致命缺陷。

消除风险:默认建立数据安全和隐私

只要使用中的数据暴露在外,敏感的个人身份信息(PII),财务或健康信息在云中仍然存在风险。安全实体一直在努力消除网络威胁,但这场恶作剧的游戏往往输给了高价值信息的泄露和过滤。需要的是,未经修改的工作负载应用程序和数据系统内存能够在任何环境中的任何地方运行,完全与内部和外部攻击隔离。

现在,机密计算解决了在安全空间内隔离数据和执行的问题。使用CPU的一部分作为保护区或飞地,可以创建一个可信执行环境(TEE)。安全的飞地是一个内存和CPU专用环境,它与给定主机上的所有其他用户和进程隔离,并且对它们不可见。在一个安全的飞地内,代码只能引用自身。

保护领地安全:一项重大进展,但部署起来很复杂

实施安全封包既复杂又昂贵,需要重新设计每个应用程序。飞地要求工程师和专家亲自参与,这将运营费用提高到不切实际的高度。每个芯片和云提供商都创建了自己的飞地解决方案:Intel SGX、Azure、AMD SEV、AWS Nitro Enclaves和Google VM。但是,这些努力无论多么值得,都为已经维护本地、混合和多云环境的客户创造了一个令人眼花缭乱的选择领域。他们必须学习各自的安全飞地技术,这会增加工程人员、时间、应用程序性能和成本方面的开销。

化解未经授权的内部人士和外部威胁

在不降低IT生产力的情况下加强安全性是一个令人困惑的安全挑战,云只会加剧这一挑战,暴露出对IT云平台提供商的员工和第三方承包商的控制有限的问题。内部人员获得主机访问权限来执行其工作,这会使他们过度暴露于主机数据。为了一个组织的安全,需要一个报复心强、注意力不集中或机会主义的员工。

但机密计算关闭了“可信的内部人员”数据暴露和外部威胁。它确保了独占的数据控制和硬件级别的数据风险最小化;数据保护是数据本身的组成部分,无需依赖薄弱的外围安全层。数据所有者控制数据在it计算、存储和通信的基础架构中存储、传输或使用的任何位置。

Anjuna软件:默认保护数据

Anjuna机密计算软件不需要重新设计应用程序或内核。客户无需担心芯片或云基础设施级别的底层TEE。应用程序和整个环境在公共云基础设施上创建的私有环境中无需修改即可工作。在几分钟内,Anjuna自动创建了一个隔离且坚固的硬件加密环境,应用程序在其中运行并扩展机密计算硬件技术,以保护使用中、传输中和静止的数据。

Anjuna的独特之处是什么?

多平台和多云支持。

企业无需锁定在一个硬件平台或云上。Anjuna支持Intel、AMD和AWS Nitro Enclaves平台以及本地Kubernetes Key管理解决方案,适用于任何环境:内部部署、混合或多云。无需修改即可跨任何飞地平台执行工作负载。

无性能影响。

使用Anjuna,所有TEE技术都预先调整了环境。因为应用程序不需要重新编码,所以在软件的隔离环境中运行的延迟最小。

在几分钟内大规模加强安全性。

在每个应用程序周围快速创建一个隔离的安全环境,以显著减少攻击面并保护应用程序,即使基础架构遭到破坏。

全方位包覆

通过硬件和软件的全栈加密,将保护范围从内存扩展到存储和网络。运行应用程序时,数据被隔离,任何其他实体都无法访问;内存与机器上的任何其他东西都是隔离的,包括操作系统。

透明数据共享。

Anjuna软件使企业能够通过认证安全飞地运行的硬件为正版,在分布式应用程序上使用硬件信任根。这证实了飞地内存对远程方的完整性。

探索这些机密计算用例

安全云迁移

将应用程序迁移到云,其安全姿态超过本地保护。Anjuna扩展了机密计算技术提供的强化安全功能,并使任何公共云成为敏感企业应用程序和数据最安全的地方。云经济和强大的安全性之间不再妥协。

数据库保护

即使是安全的数据库也会在内存中存储未加密和公开的数据。Anjuna确保数据库及其数据在隔离的私有环境的安全范围内运行。通过加密和物理方式将数据与恶意进程和不良参与者隔离,实际上消除了数据泄露或渗出的可能性。

数据保护

Anjuna提供了最强大、最完整的数据安全和隐私控制。创建、处理、存储和联网的敏感数据受到基于硬件的零信任保护的保护,在整个生命周期中保护PII免受内部人员和不良行为者的侵害。数据默认受保护,包括密钥、PII、PHI、PCI、IP、专有算法、商业机密等。

加密MPC和区块链保护

见Anjuna首席技术官兼联合创始人Yan Michalevsky,讨论区块链应用的安全飞地、加密密钥和基础设施的安全存储,以及区块链和加密货币的挑战。Anjuna为加密公司保护MPC应用程序、数字资产、数字钱包、托管交易所、NFT和AI/ML算法。

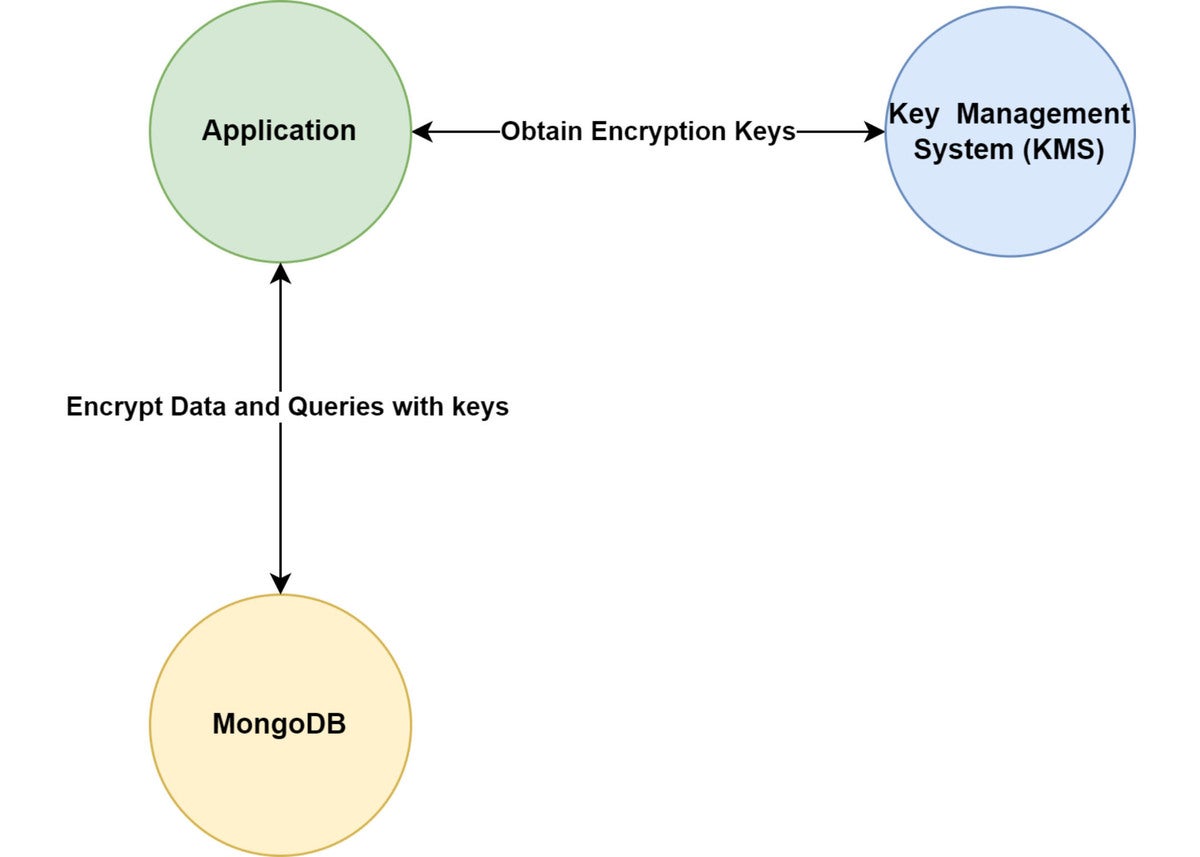

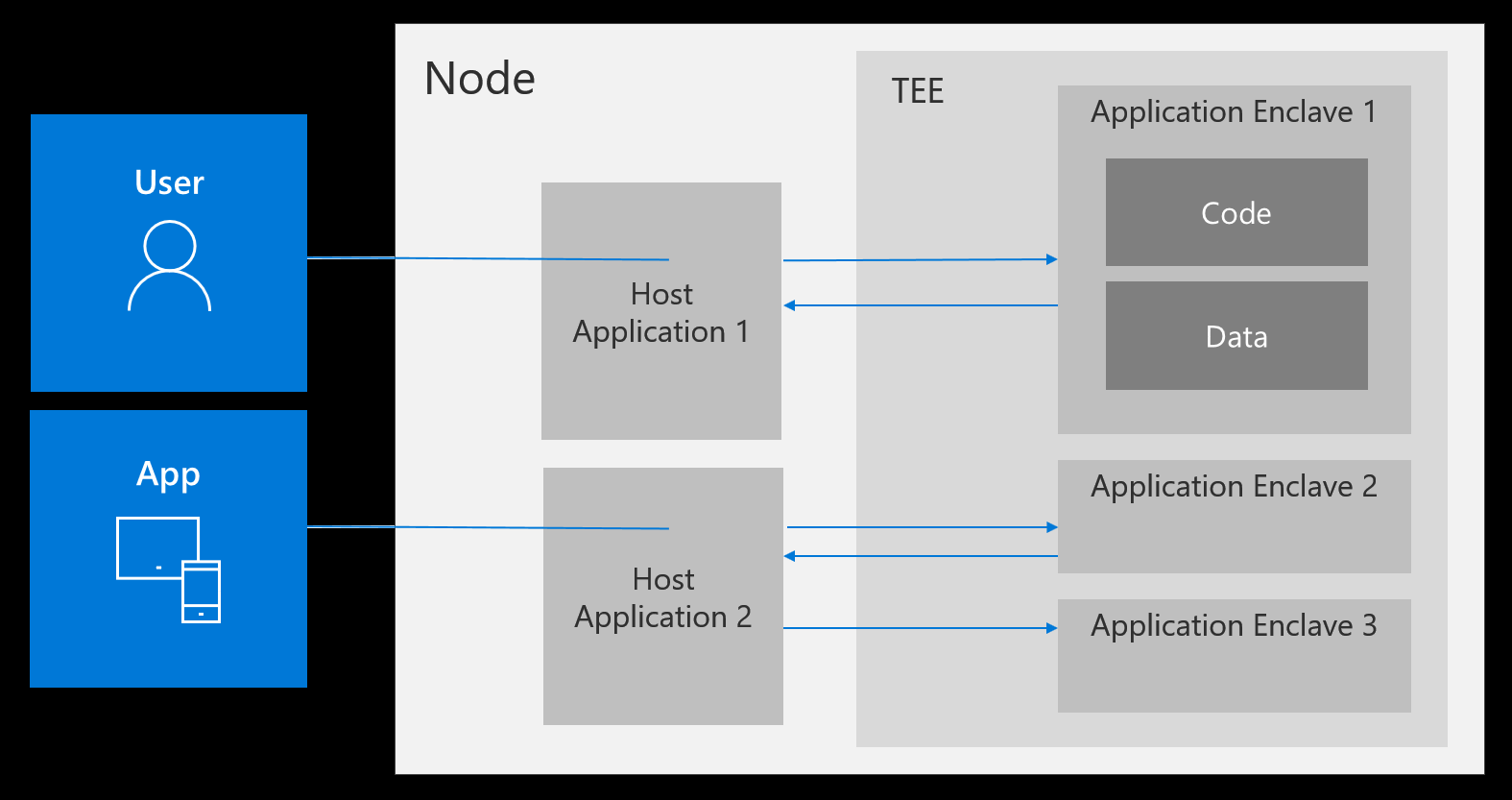

密钥管理系统(KMS)

有了机密计算,您现在可以现代化和扩展KMS功能,并禁止访问在隔离环境中运行的KMS应用程序。Anjuna与HashiCorp和Venafi合作,保护密钥和机密,甚至防止具有root访问权限的攻击者获取身份验证凭据。

强化的DevSecOps

DevSecOps管道的手动安全和审计流程可能是软件供应链受损的主要风险向量。这些缓慢的劳动密集型流程可能使迅速识别管道攻击变得困难。使用Anjuna在安全的飞地内运行应用程序可以提供基于硬件的软件组件完整性证明,从而更广泛地保护软件供应链。

本文:https://jiagoushi.pro/what-confidential-computing-and-why-it-important-…

- 125 次浏览

安全战略

【安全】考虑网络安全职业的4个理由

零失业率是一个有吸引力的数据。它肯定是指导顾问为学生选择网络安全作为职业的原因。毫无疑问,这是一个很好的特权,但它与一些追求网络安全职业的更有说服力的理由相比。

您不需要成为网络安全专家就能理解这是一个增长领域。网络安全已成为任何现代企业结构的关键。由于违规行为突破了头条新闻,所以每个人都清楚组织需要更多专注于网络安全的专业人士。

IT中的每个角色都有网络安全方面。专注于安全性作为您的主要角色开辟了一个选择的世界。从安全操作到风险评估,应用程序安全,调查到遵从教育工作者,网络安全中的角色与浏览器中运行的代码行一样多。

不要让那些负面的头条新闻让你失望。对于每一个Equifax,在线都有成千上万的成功交易。我们作为一个职业正在取得进步。

以下是您应该考虑从事网络安全职业生涯的四大理由 - 这也是您不应该这样做的原因之一。

1.实际上无限增长

随着范围不断扩大,网络安全呈现出最终的增长潜力 - 无论是在您的职业道路上还是在学习机会方面。

我们将安全作为自己的学科教授,但它与所有其他IT技能组合相关联。一个优秀的网络安全专业人员尽可能地了解技术和组织的工作方式。

一位伟大的网络安全专家意识到学习永远不会停止。

这是一个保持参与和挑战的巨大机会。

当安全团队开始时,他们是从“万事通”类型构建的。该学科尚未发展到足以支持法医学或应用程序安全或事件响应方面的专业。

当前的工作量迫使安全团队迅速扩大规模。愿意挑战自我的专业人士有机会接受它。

无论您是希望以首席信息安全官(CISO)角色工作还是使用全新技术,唯一能够限制您成长的是您的愿望。

这是一个令人兴奋的命题和理由足以选择一个网络安全职业。

2.种类繁多

所有增长机会都与安全专业人员必须处理的各种技术和情况有关。如果它使用1和0,它有一个网络安全组件(有些角色甚至扩展到物理安全!)。

安全专业人员有机会直接与团队合作,研究他们从未梦想过的技术和系统。从机器人到汽车,再到为数百万用户提供服务的网站,品种几乎无限。

这是一个令人兴奋的职业前景。无聊不是经常使用的词。

这个品种有一个有趣的分支:由于正确理解现代安全挑战所需的广泛技能,网络安全专业人士来自不同的背景。事实上,你的背景越多,安全专业人士就越好!

没有“正确”的方式来培养成为网络安全专业人士。

3.解决难题的能力

将技术及其变化的增长加在一起,您就会开始瞥见网络安全专业人员可以处理的各种类型的谜题。

在网络安全方面,我们依赖于一些经过验证的原则,但这些策略可以在日常工作中发生变化。而且总会有一个需要解决的新难题。

随着每一次新技术浪潮的出现,都会产生新的风险。安全专业人员的工作是识别,理解并帮助解决这些风险。当您考虑如何保护在云中运行的网站而不是保护老年患者的心脏起搏器时,这种情况会发生显着变化。

每种情况都是一个独特的难题,也是迎接挑战的新机遇。

4. 这项工作有实际影响

最后一个用例 - 为老年患者辩护心脏起搏器 - 是一个真实的用例。由于安全问题,最近大规模召回了心脏起搏器。 Equifax黑客攻击了1.45亿美国人。

网络安全很重要。它的影响超越了数字世界,进入了物理世界。

这是一个可怕而令人兴奋的前景,也是一个突出其重要性的前景。

如果您想处理具有实际影响的IT问题,网络安全可能是您的纪律。

为什么不选择这条道路:感知

不犯错误。网络安全的多样性,增长机会,难题和影响加起来令人兴奋。但如果你期望职业生涯更符合好莱坞安全专业人士的介绍......再想一想。

网络安全中的绝大多数角色都不要求你在世界各地躲避子弹或在几毫秒内获得扫描结果,或者能够通过红色立即识别恶意代码(<sarcasm>感谢你,CSI:Cyber </讽刺>)。

当然,这并不意味着这些角色没有回报。他们是。他们可能不是很迷人。

开始学习,不断学习

网络安全对于强大的职业生涯具有两个关键的后勤优势:低失业率和无失业补偿。

另外,如果您选择此路径,您将始终有成长空间。您将不断学习新技能并努力学习新技术。新挑战将不断涌现,您将接触到大量新人,情境和机会。

你永远不会觉得无聊,因为新的谜题需要解决,你总是可以自豪,因为你的工作将对数字和物理世界产生积极的影响。

你还能在职业生涯中要求什么呢?

讨论:请加入知识星球【首席架构师圈】

- 69 次浏览

【安全战略】2019年12项最佳网络安全实践

你的敏感资料是否安全?

这并不夸张:任何公司都可能成为网络犯罪的受害者。有关网络攻击的报告来自政府机构、教育和医疗机构、银行、律师事务所、非营利组织和许多其他组织。

黑客、内部威胁、勒索软件和其他危险都存在。

聪明的企业正在加大对网络安全的投资,以消除风险,确保敏感数据的安全,这已经带来了首批成果。请看下面的信息图表,了解网络安全的最新趋势。

接下来的问题是:作为一名企业主,在2019年我能做些什么来保护我的数据?

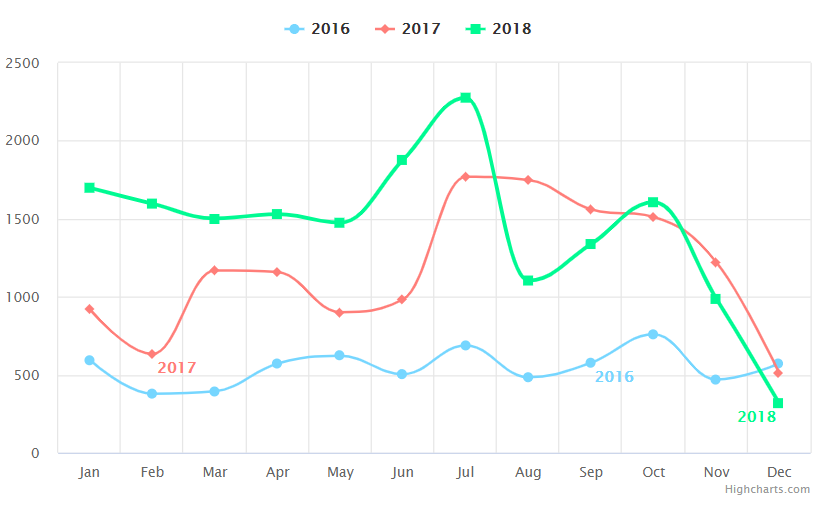

上图显示,在政府机构和企业都开始加大对网络安全的投资的同时,数据泄露的数量显著下降。

不知道从哪里开始加强你的网络安全政策?我们准备告诉你网络安全的趋势和最新的技术。

以下是我们2019年的IT安全最佳实践清单:

1. 考虑生物安全

生物识别技术确保了快速认证、安全访问管理和精确的员工监控。

在提供对有价值资产的访问之前,验证用户的身份对企业来说至关重要。语音识别、指纹扫描、手掌生物识别、面部识别、行为生物识别和步态分析是识别用户是否是他们自称的人的完美选择。

使用生物识别技术提供了比密码和短信验证更安全的身份验证。这就是为什么生物识别技术已经成为多因素认证的重要组成部分。

然而,身份验证并不是生物识别的唯一用途。安全人员受益于各种生物识别驱动的工具,这些工具允许他们实时检测受损的特权帐户。

行为生物学分析用户与输入设备交互的方式。如果检测到异常行为,工具会向安全人员发送警告,以便他们能够立即做出反应。

以下是用户和实体行为分析(UEBA)系统可以使用的几种行为生物识别技术:

- 击键动态——考虑打字速度和在某些单词中出现典型错误的倾向,以创建用户行为概要文件

- 鼠标动态—跟踪鼠标点击和鼠标移动速度、节奏和样式之间的时间间隔

- 眼动生物测定-使用眼睛和注视跟踪设备来记录眼睛运动的视频和检测独特的模式

market sandmarkets对2018年的预测显示,到2023年,生物识别市场将从2018年的168亿美元增长到418亿美元。因此,请密切关注生物特征安全技术,并为您的用例选择最佳技术。

2. 形成分级的网络安全政策

为什么书面的网络安全政策如此重要?

首先,书面政策作为贵公司所有网络安全措施的正式指南。

它允许您的安全专家和员工处于同一页面,并为您提供了一种强制执行保护数据的规则的方法。然而,每个部门的工作流程可能是独特的,而且很容易被不必要的网络安全措施打乱。

虽然集中式安全策略作为整个公司的基本方针是有益的,但它不应该覆盖每个部门的每个流程。相反,允许您的部门基于中央策略创建自己的安全策略。

以这种分层的方式确定安全策略有很多好处。通过这样做,您可以考虑每个部门的需求,并确保他们的工作流和您的底线不会在安全的名义下受到损害。

伊利诺伊州政府网站提供了一个很好的网络安全政策模板,可以作为你分级管理的起点。

如果您想学习如何预防、检测和纠正内部攻击,您应该考虑构建一个内部威胁程序。

3.采用基于风险的安全方法