数据科学

视频号

微信公众号

知识星球

- 146 次浏览

【数据科学】12 项数据科学认证将带来回报

视频号

微信公众号

知识星球

希望成为一名数据科学家? 获得这些数据科学证书之一将帮助您在 IT 最热门的职业之一中脱颖而出。

数据科学家是 IT 领域最热门的工作之一。 公司越来越渴望聘请能够理解企业收集的广泛数据的数据专业人员。 如果您想进入这个利润丰厚的领域,或者想在竞争中脱颖而出,认证可能是关键。

数据科学认证不仅让您有机会发展在您想要的行业中难以找到的技能,而且还可以验证您的数据科学知识,以便招聘人员和招聘经理知道如果他们雇用您,他们会得到什么。

无论您是想获得认可大学的认证、获得应届毕业生的经验、磨练特定于供应商的技能,还是展示您的数据分析知识,以下认证(按字母顺序排列)都将适合您。 (没有找到您要找的东西?请查看我们的顶级大数据和数据分析认证列表。)

前 12 名数据科学认证

- 认证分析专家 (CAP)

- Cloudera 数据平台通才认证

- 美国数据科学委员会 (DASCA) 高级数据科学家 (SDS)

- 美国数据科学委员会 (DASCA) 首席数据科学家 (PDS)

- IBM 数据科学专业证书

- Microsoft 认证:Azure AI 基础知识

- Microsoft 认证:Azure 数据科学家助理

- 开放认证数据科学家 (Open CDS)

- SAS 认证的人工智能和机器学习专家

- 使用 SAS 9 的 SAS 认证高级分析专家

- SAS 认证数据科学家

- Tensorflow 开发人员证书

认证分析专家 (CAP)

Certified Analytics Professional (CAP) 是一种供应商中立的认证,可验证您“将复杂数据转化为有价值的见解和行动”的能力,这正是企业在数据科学家中寻找的:理解数据的人,可以得出逻辑 结论并向关键利益相关者表达为什么这些数据点很重要。 在参加 CAP 或准水平 aCAP 考试之前,您需要申请并满足特定条件。 要获得 CAP 认证考试的资格,如果您拥有相关领域的硕士学位,则需要三年相关经验;如果您拥有相关领域的学士学位,则需要五年相关经验;如果您拥有相关领域的学士学位,则需要七年相关经验。 拥有与分析无关的任何学位。 要获得参加 aCAP 考试的资格,您需要拥有硕士学位以及少于三年的数据或分析相关经验。

- 费用:CAP考试:INFORMS会员495美元,非会员695美元; aCAP 考试:INFORMS 会员 200 美元,非会员 300 美元

- 地点:亲自到指定考试中心

- 持续时间:自定进度

- 有效期:三年有效

Cloudera 数据平台通才认证

Cloudera 已停止其 Cloudera 认证专家 (CCP) 和 Cloudera 认证助理 (CCA) 认证,取而代之的是新的 Cloudera 数据平台 (CDP) 通才认证,该认证可验证该平台的熟练程度。 新考试测试平台的一般知识,适用于多种角色,包括管理员、开发人员、数据分析师、数据工程师、数据科学家和系统架构师。 考试包括 60 个问题,考生有 90 分钟的时间完成。

- 费用:300 美元

- 地点:线上

- 时长:90 分钟

- 有效期:两年有效

美国数据科学委员会 (DASCA) 高级数据科学家 (SDS)

美国数据科学委员会 (DASCA) 高级数据科学家 (SDS) 认证计划专为具有五年或五年以上研究和分析经验的专业人士设计。 建议学生了解数据库、电子表格、统计分析、SPSS/SAS、R、定量方法以及面向对象编程和 RDBMS 的基础知识。 该计划包括五个轨道,将吸引一系列候选人——每个轨道在学位水平、工作经验和申请先决条件方面都有不同的要求。 您至少需要学士学位和五年以上的数据科学经验才有资格参加每个课程,而其他课程则需要硕士学位或过去的认证。

- 费用:775 美元

- 地点:线上

- 持续时间:自定进度

- 有效期:5年

美国数据科学委员会 (DASCA) 首席数据科学家 (PDS)

美国数据科学委员会 (DASCA) 提供首席数据科学家 (PDS) 认证,其中包括面向在大数据领域拥有 10 年或以上经验的数据科学专业人士的三个方向。 考试涵盖从基础到高级数据科学概念的所有内容,例如大数据最佳实践、数据业务战略、建立跨组织支持、机器学习、自然语言处理、学术建模等。 该考试专为“经验丰富且成绩斐然的数据科学思想和实践领导者”而设计。

- 费用:850 美元,轨道 1; 1,050 美元,轨道 2; 750 美元,第 3 轨; 1,250 美元,第 4 首曲目

- 地点:线上

- 持续时间:自定进度

- 过期:凭证不会过期

IBM 数据科学专业证书

IBM 数据科学专业证书包括九门课程,内容涉及数据科学、开源工具、数据科学方法论、Python、数据库和 SQL、数据分析、数据可视化、机器学习,以及最终的应用数据科学顶点。 认证课程通过 Coursera 在线进行,时间表灵活,平均需要三个月才能完成,但您可以自由选择更多或更少的时间。 该课程包括实践项目,可帮助您构建作品集,向潜在雇主展示您的数据科学才能。

- 费用:免费

- 地点:线上

- 持续时间:自定进度

- 过期:凭证不会过期

Microsoft 认证:Azure AI 基础知识

Microsoft 的 Azure AI Fundamentals 认证验证您对机器学习和人工智能概念的了解以及它们与 Microsoft Azure 服务的关系。 这是一项基础考试,因此您不需要丰富的经验即可通过考试。 如果你不熟悉 AI 或 Azure 上的 AI 并想向雇主展示你的技能和知识,这是一个很好的起点。

- 费用:99 美元

- 地点:线上

- 持续时间:自定进度

- 过期:凭证不会过期

Microsoft 认证:Azure 数据科学家助理

Microsoft 的 Azure Data Scientist Associate 认证侧重于您利用机器学习在 Azure 上实施和运行机器学习工作负载的能力。 该考试的考生将接受 ML、AI 解决方案、NLP、计算机视觉和预测分析方面的测试。 您需要精通部署和管理资源、管理身份和治理、实施和管理存储以及配置和管理虚拟网络。

- 费用:165 美元

- 地点:线上

- 持续时间:自定进度

- 过期:凭证不会过期

开放认证数据科学家 (Open CDS)

Open Group Professional Certification Program for the Data Scientist Professional (Open CDS) 是一种基于经验的认证,没有任何传统的培训课程或考试。 您将从一级认证数据科学家开始,然后可以进入二级认证数据科学家,最后您可以通过三级认证成为杰出认证数据科学家。 认证需要三个步骤,包括申请认证、填写经验申请表和参加董事会审查。

- 成本:联系定价

- 地点:现场

- 持续时间:因级别而异

- 过期:凭证不会过期

SAS 认证的人工智能和机器学习专家

SAS 的 AI 和机器学习专业认证证明您有能力使用开源工具,通过 AI 和分析技能从数据中获得洞察力。 该认证包括多项考试,涵盖机器学习、自然语言处理、计算机视觉以及模型预测和优化等主题。 您需要通过机器学习、预测和优化以及自然语言处理和计算机视觉方面的 SAS 认证专家考试,才能获得 AI 和机器学习专业称号。

- 费用:每次考试 180 美元

- 地点:线上

- 持续时间:自定进度

- 过期:凭证不会过期

使用 SAS 9 的 SAS 认证高级分析专家

SAS Certified Advanced Analytics Professional Using SAS 9 证书验证您使用各种统计分析和预测建模技术分析大数据的能力。 您需要具备机器学习和预测建模技术方面的经验,包括它们在大型、分布式和内存中数据集上的使用。 您还应该具有模式检测、业务优化技术实验和时间序列预测方面的经验。 该认证需要通过三门考试:使用 SAS Enterprise Miner 7、13 或 14 进行预测建模; SAS 高级预测建模; SAS 文本分析、时间序列、实验和优化。

- 费用:使用 SAS Enterprise Miner 进行预测建模考试 250 美元; 其他两门必修考试每门 180 美元

- 地点:线上

- 持续时间:自定进度

- 过期:凭证不会过期

SAS 认证数据科学家

SAS 认证数据科学家认证是 SAS 提供的其他两种数据认证的组合。 它涵盖了编程技巧; 管理和改进数据; 转换、访问和操作数据; 以及如何使用流行的数据可视化工具。 一旦您同时获得大数据专家和高级分析专家认证,您就有资格获得 SAS 认证数据科学家称号。 您需要完成所有 18 门课程,并通过两个单独认证之间的五门考试。

- 费用:每次考试 180 美元

- 地点:线上

- 持续时间:自定进度

- 过期:凭证不会过期

TensorFlow 开发人员证书

TensorFlow 开发人员证书计划是“面向希望通过使用 TensorFlow 构建和训练模型来展示实用机器学习技能的学生、开发人员和数据科学家的基础证书。” 该考试测试您将机器学习集成到各种工具和应用程序中的知识和能力。 要通过考试,您需要熟悉 ML 和深度学习的基本原理、构建 ML 模型、图像识别算法、深度神经网络和自然语言处理。

- 费用:每次考试 100 美元

- 地点:线上

- 持续时间:自定进度

- 过期:凭证不会过期

- 147 次浏览

【数据科学】16个数据学科和数据科学的对比

最初由格兰维尔博士发布。 查看原始文章以阅读大量评论,而不是在此处重新发布。

数据科学,数据挖掘,机器学习,统计学,运筹学等之间有什么区别?

在这里,我比较了几个重叠的分析学科,以解释差异和共同点。 除了历史原因,有时除了存在差异。 有时差异是真实而微妙的。 我还提供典型的职称,分析类型以及传统上与每个学科相关的行业。 带下划线的域是主要的子域。 如果有人可以在我的文章中添加历史视角,那就太好了。

Data Science

首先,让我们从描述数学科学这一新学科开始。

职位包括数据科学家,首席科学家,高级分析师,分析主管等等。它涵盖所有行业和领域,尤其是数字分析,搜索技术,营销,欺诈检测,天文学,能源,健康,社交网络,金融,法医,安全(NSA),移动,电信,天气预报和欺诈检测。

项目包括分类创建(文本挖掘,大数据),应用于大数据集的聚类,推荐引擎,模拟,统计评分引擎的规则系统,根本原因分析,自动投标,取证,外行星检测以及恐怖分子的早期发现活动或流行病,数据科学的一个重要组成部分是自动化,机器对机器通信,以及在生产模式(有时是实时)不间断运行的算法,例如检测欺诈,预测天气或预测房价为每个家庭(Zillow)。

数据科学项目的一个例子是为计算营销创建增长最快的数据科学Twitter概要。它利用大数据,是病毒式营销/增长黑客战略的一部分,其中还包括自动化高质量,相关的联合内容生成(简而言之,数字出版3.0版)。

与大多数其他分析专业不同,数据科学家被认为具有良好的商业头脑和领域专业知识 - 这是他们倾向于成为企业家的原因之一。由于数据科学是一门广泛的学科,因此有许多类型的数据科学家。许多资深数据科学家掌握他们的艺术/工艺,并拥有全部技能和知识;他们真的是招聘人员找不到的独角兽。招聘经理和不知情的高管倾向于狭隘的技术技能,而不是结合深度,广泛和专业的业务领域专业化 - 这是当前教育系统的副产品,有利于学科孤岛,而真正的数据科学是一个孤岛破坏者。独角兽数据科学家(用词不当,因为他们并不罕见 - 有些是着名的VC)通常担任顾问或高管。初级数据科学家往往更专注于数据科学的一个方面,拥有更多热门的技术技能(Hadoop,Pig,Cassandra),如果他们接受过适当的培训和/或有Facebook等公司的工作经验,就可以找到工作。 ,谷歌,eBay,苹果,英特尔,Twitter,亚马逊,Zillow等。潜在候选人的数据科学项目可以在这里找到。

数据科学与之重叠

- 计算机科学:计算复杂性,互联网拓扑和图论,分布式架构,如Hadoop,数据管道(数据流和内存分析的优化),数据压缩,计算机编程(Python,Perl,R)以及处理传感器和流数据(设计自动驾驶的汽车)

- 统计学:实验设计包括多变量检验,交叉验证,随机过程,抽样,无模型置信区间,但不是p值,也不是对大数据诅咒的假设的模糊测试

- 机器学习和数据挖掘:数据科学确实完全包含这两个领域。

- 运筹学:数据科学包括大多数运筹学研究以及旨在根据分析数据优化决策的任何技术。

- 商业智能:数据科学是设计/创建/识别优秀指标和KPI的每个BI方面,创建数据库模式(无论是否为NoSQL),仪表板设计和视觉效果以及数据驱动策略以优化决策和ROI。

与其他分析学科比较

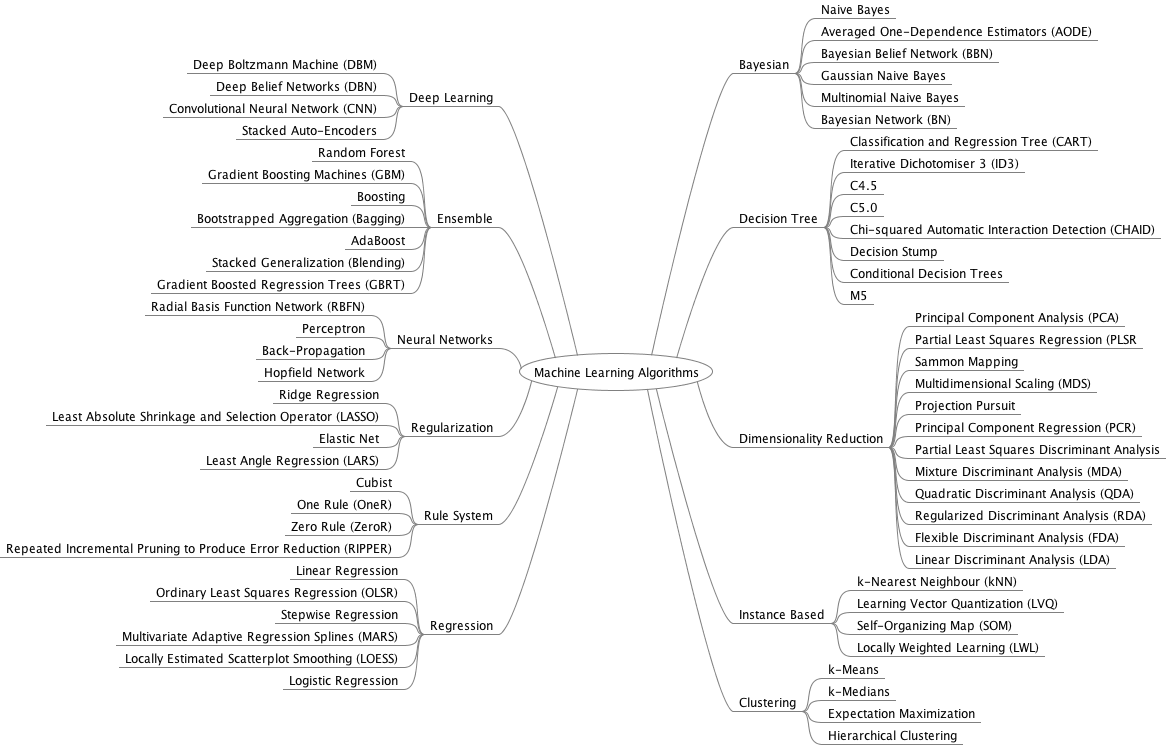

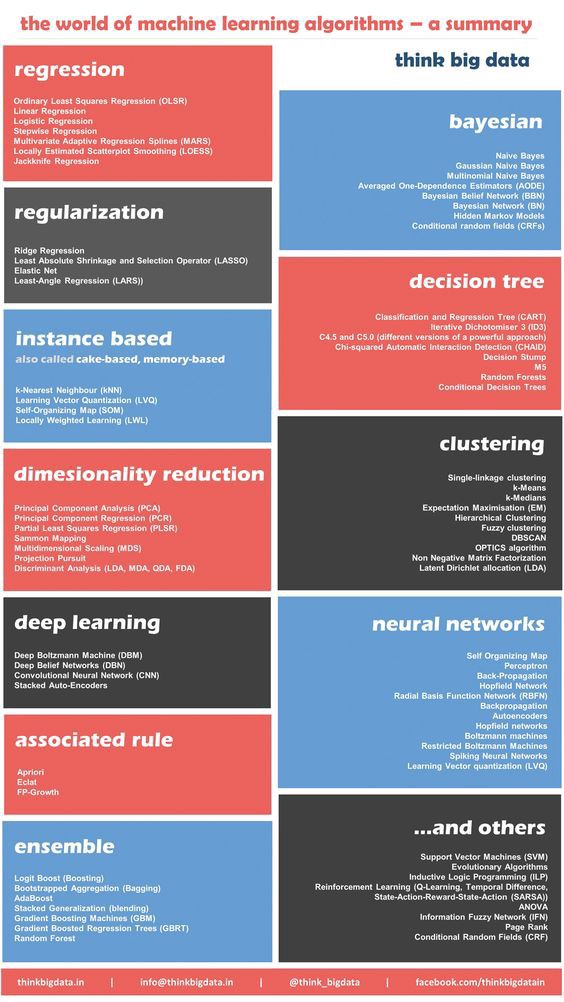

- 机器学习:非常流行的计算机科学学科,数据密集型,数据科学的一部分,与数据挖掘密切相关。机器学习是关于设计算法(如数据挖掘),但重点是生产模式的原型算法,并设计自动更新自己的自动化系统(出价算法,广告定位算法),不断训练/再培训/更新训练集/交叉每天验证,改进或发现新规则(欺诈检测)。 Python现在是ML开发的流行语言。核心算法包括聚类和监督分类,规则系统和评分技术。一个接近人工智能的子域(见下面的条目)是深度学习。

- 数据挖掘:该学科旨在设计算法以从相当大的潜在非结构化数据(文本挖掘)中提取洞察力,有时称为块金发现,例如在查看5000万行数据后发掘大量僵尸网络。技术包括模式识别,特征选择,聚类,监督分类并包含一些统计技术(尽管没有使用大多数统计方法的p值或置信区间)。相反,重点是强大的,数据驱动的,可扩展的技术,对发现原因或可解释性没有太大兴趣。因此,数据挖掘与统计学有一些交集,它是数据科学的一个子集。数据挖掘应用于计算机工程,而不是数学科学。数据挖掘者使用开源和Rapid Miner等软件。

- 预测建模:本身不是一门学科。预测建模项目在所有学科的所有行业中都有发生。预测建模应用程序旨在基于过去的数据预测未来,通常但不总是基于统计建模。预测通常带有置信区间。预测建模的根源在于统计科学。

- 统计。目前,统计数据主要是调查(通常使用SPSS软件进行),理论学术研究,银行和保险分析(营销组合优化,交叉销售,欺诈检测,通常使用SAS和R),统计编程,社会科学,全球变暖研究(和空间天气模拟),经济研究,临床试验(制药业),医学统计,流行病学,生物统计学和政府统计。雇用统计人员的机构包括人口普查局,IRS,CDC,EPA,BLS,SEC和EPA(环境/空间统计)。需要安全许可的工作报酬很高且相对安全,但制药行业中的高薪工作(统计学家的金鹅)受到许多因素的威胁 - 外包,公司合并以及医疗保健费用的压力。由于保守的,风险不利的制药行业的巨大影响,统计已成为一个狭窄的领域,不适应新数据,而不是创新,失去数据科学,工业统计,运筹学,数据挖掘,机器学习 - 使用相同的聚类,交叉验证和统计训练技术,尽管采用更自动化的方式和更大的数据。许多10年前被称为统计人员的专业人士在过去几年中将他们的职位变成了数据科学家或分析师。现代子域包括统计计算,统计学习(更接近机器学习),计算统计(更接近数据科学),数据驱动(无模型)推理,运动统计和贝叶斯统计(MCMC,贝叶斯网络和分层贝叶斯)模特很流行,现代技术)。其他新技术包括SVM,结构方程建模,预测选举结果和集合模型。

- 工业统计。统计数据经常由非统计人员(具有良好统计培训的工程师)执行,从事工程项目,如产量优化或负载平衡(系统分析员)。他们使用非常应用的统计数据,他们的框架更接近六西格玛,质量控制和运营研究,而不是传统统计。也见于石油和制造业。使用的技术包括时间序列,ANOVA,实验设计,生存分析,信号处理(过滤,噪声消除,反卷积),空间模型,模拟,马尔可夫链,风险和可靠性模型。

- 数学优化。使用单纯形算法,傅立叶变换(信号处理),微分方程和Matlab等软件解决业务优化问题。这些应用数学家可以在IBM,研究实验室,NSA(密码学)和金融行业(有时招聘物理或工程专业毕业生)等大公司中找到。这些专业人员有时使用完全相同的技术解决与统计学家完全相同的问题,尽管他们使用不同的名称。数学家使用最小二乘优化进行插值或外推;统计学家使用线性回归进行预测和模型拟合,但这两个概念是相同的,并且依赖于完全相同的数学机制:它只是描述相同事物的两个名称。然而,数学优化比运营研究更接近统计数据,雇用数学家而不是其他从业者(数据科学家)的选择通常由历史原因决定,特别是对于NSA或IBM等组织。

- 精算科学。只是使用生存模型关注保险(汽车,健康等)的一部分统计数据:预测您何时会死亡,您的健康支出将根据您的健康状况(吸烟者,性别,以前的疾病)确定您的保险费。还预测极端洪水和天气事件以确定溢价。后面这些模型出了名的错误(最近)并且导致了比预期更大的支出。出于某些原因,这是一个非常充满活力,秘密的统计学家社区,不再称自己为统计学家(职称是精算师)。随着时间的推移,他们的平均工资增长很快:专业的获取受到限制和监管,就像律师一样,除了保护主义以外,没有其他原因可以提高工资和减少合格申请人的数量。精算科学确实是数据科学(一个子领域)。

- HPC。高性能计算本身不是一门学科,但应该引起数据科学家,大数据从业者,计算机科学家和数学家的关注,因为它可以重新定义这些领域的计算范式。如果量子计算变得成功,它将完全改变算法的设计和实现方式。 HPC不应与Hadoop和Map-Reduce混淆:HPC与硬件相关,Hadoop与软件相关(尽管严重依赖Internet带宽和服务器配置和接近度)。

- 行动调查。缩写为OR。他们一段时间(如20年前)与统计数据分开,但他们就像孪生兄弟,他们各自的组织(INFORMS和ASA)合在一起。 OR是关于决策科学和优化传统业务项目:库存管理,供应链,定价。他们大量使用马尔可夫链模型,Monter-Carlosimulations,排队和图论以及AIMS,Matlab或Informatica等软件。大型传统旧公司使用OR,新的和小型的(初创公司)使用数据科学来处理定价,库存管理或供应链问题。许多运营研究分析师正在成为数据科学家,因为与OR相比,数据科学的创新和增长前景要远得多。此外,OR问题可以通过数据科学解决。 OR与六西格玛(见下文)有重大的重叠,也解决了计量经济学问题,并在军队和国防部门有许多从业者/应用。汽车交通优化是OR问题的一个现代例子,通过模拟,通勤调查,传感器数据和统计建模解决。

- 六个西格玛。它更像是一种思维方式(一种商业哲学,如果不是一种邪教)而不是一种学科,并且几十年前被摩托罗拉和通用电气大力推广。用于质量控制和优化工程流程(参见本文中的工业统计数据),由大型传统公司提供。他们拥有一个拥有270,000名成员的LinkedIn小组,是包括我们数据科学小组在内的任何其他分析LinkedIn小组的两倍。他们的座右铭很简单:将你的努力集中在20%的时间,产生80%的价值。应用简单的统计数据(简单的工作必须是时间,我同意),其目的是消除业务流程中的差异来源,使其更具可预测性并提高质量。许多人认为六西格玛是旧的东西,会消失。也许,但是基本的概念是可靠的并且将保持不变:这些也是所有数据科学家的基本概念。你可以说六西格玛是一个更简单的(如果不是简单的)运算研究版本(参见上面的条目),其中统计建模保持在最低限度。风险:非合格人员使用非强大的黑盒统计工具来解决问题,它可能导致灾难。在某些方面,六西格玛是一个更适合商业分析师的学科(见下面的商业智能条目),而不是严肃的统计学家。

- 定量。定量人士只是在华尔街为高频交易或股票市场套利等问题工作的数据科学家。他们使用C ++,Matlab,来自着名的大学,赚取大笔资金,但当投资回报太快太南时,他们立即失去工作。他们也可以用于能源交易。在经济大衰退期间被解雇的许多人现在都在解决点击仲裁,广告优化和关键字出价等问题。数量有统计学背景(很少),数学优化和工业统计。

- 人工智能。它回来了。与数据科学的交叉是模式识别(图像分析)和自动(有些人会说智能)系统的设计,以在机器对机器通信模式中执行各种任务,例如识别正确的关键字(和正确的出价) Google AdWords(每次点击付费广告系列,每天涉及数百万个关键字)。我还认为智能搜索(创建一个搜索引擎返回您期望的结果并且比Google更广泛)是数据科学中最大的问题之一,可以说也是人工智能和机器学习问题。旧的AI技术是神经网络,但它现在正在流行。相反,神经科学越来越受欢迎。

- 计算机科学。数据科学与计算机科学有一些重叠:Hadoop和Map-Reduce实现,算法和计算复杂性,以设计快速,可扩展的算法,数据管道,以及诸如Internet拓扑映射,随机数生成,加密,数据压缩和隐写术等问题(虽然这些问题与统计科学和数学优化也是重叠的)。

- 计量经济学。为什么它与统计数据分离尚不清楚。因此,许多分支机构与统计数据脱节,因为它们变得不那么通用,并开始开发自己的临时工具。但简而言之,计量经济学在本质上具有很强的统计性,使用时间序列模型,如自回归过程。也与运筹学(本身重叠统计!)和数学优化(单纯形算法)重叠。计量经济学家喜欢ROC和效率曲线(六位sigma从业者也是如此,请参阅本文中的相应条目)。许多人没有强大的统计背景,Excel是他们的主要或唯一的工具。

- 数据工程。由大型组织中的软件工程师(开发人员)或架构师(设计师)(有时是小公司的数据科学家)执行,这是计算机科学的应用部分(参见本文中的条目),适用于允许各种数据的电力系统易于处理内存或近存储器,并可以很好地传输到(和之间)最终用户,包括数据科学家等重要数据消费者。目前受攻击的子域是数据仓库,因为这个术语与静态,孤立的conventational数据库,数据架构和数据流相关联,受到NoSQL,NewSQL和图形数据库的兴起的威胁。将这些旧架构转换为新架构(仅在需要时)或使它们与新架构兼容,是一项利润丰厚的业务。

- 商业智能。简称为BI。重点关注仪表板创建,度量选择,生成和安排通过电子邮件发送或交付/呈现给管理人员的数据报告(统计摘要),竞争情报(分析第三方数据),以及参与数据库架构设计(与数据架构师合作)有效地收集有用的,可操作的业务数据。典型的职称是业务分析师,但有些人更多地参与营销,产品或财务(预测销售和收入)。他们通常拥有MBA学位。有些人已经学习了时间序列等高级统计数据,但大多数人只使用(并且需要)基本统计数据和轻度分析,依靠IT维护数据库和收集数据。他们使用Excel(包括多维数据集和数据透视表,但不包括高级分析),Brio(Oracle浏览器客户端),Birt,Micro-Sreategy或Business Objects(作为运行查询的最终用户)等工具,尽管其中一些工具是越来越多地配备了更好的分析功能。除非他们学习如何编码,否则他们将与一些在决策科学,洞察力提取和呈现(可视化),KPI设计,业务咨询以及ROI /收益/业务/流程优化方面表现优异的多价数据科学家竞争。商业智能和市场研究(但不是竞争情报)目前正在经历下降,而人工智能正在经历一次回归。这可能是周期性的。部分下降是由于不适应需要工程或数据科学技术来处理和提取价值的新类型数据(例如非结构化文本)。

- 数据分析。这是自1995年以来商业统计的新术语,它涵盖了广泛的应用,包括欺诈检测,广告组合建模,归因建模,销售预测,交叉销售优化(零售),用户细分,流失分析,计算客户的长期价值和收购成本等。除大公司外,数据分析师是初级职位;这些从业者比数据科学家具有更为狭隘的知识和经验,他们缺乏(并且不需要)商业愿景。它们是详细的,并向数据科学家或分析主管等管理人员报告。在大公司中,拥有职称的人如数据分析师III可能非常高级,但他们通常都是专业的,缺乏数据所获得的广泛知识。科学家在各种大小公司工作。

- 商业分析。与数据分析相同,但仅限于业务问题。倾向于更多的财务,营销或投资回报率的味道。热门职位包括数据分析师和数据科学家,但不包括业务分析师(请参阅商业智能的商业智能条目,不同的域名)。

- 47 次浏览

【数据科学】2024年数据科学工作导航:角色、团队和技能

视频号

微信公众号

知识星球

无论你是申请第一次实习,还是管理一个由分析师和工程师组成的多学科团队,数据科学职业都会面临一系列特定的挑战。其中一些可能比其他更令人兴奋,而另一些则可能非常乏味——当然,在任何工作中都是如此——但我们相信,将所有这些潜在的缺点都视为深化知识、扩展技能和考虑新观点的机会。

本周,我们的阵容汇集了围绕数据职业中常见障碍的广泛观点和经验,并提出了克服这些障碍的有效方法。无论您在自己的数据科学之旅中身处何处,我们都希望您探索我们推荐的阅读内容,并找到将其融入自己工作的见解。

- 数据ROI金字塔:一种衡量和最大化数据团队的方法。虽然Barr Moses的可操作路线图面向数据领导和高管,但它是公司层级上下数据专业人员的重要资源。毕竟,每个人都可以从了解他们的工作如何为业务做出贡献,以及如何向更广泛的非技术受众展示他们的影响中受益。

- 重建为我找到数据科学家工作的投资组合。一年前,马特·查普曼(Matt Chapman)撰写了关于构建数据科学投资组合的权威实践指南(并在这个过程中迅速走红)。在他的最新帖子中,Matt重新审视了他的方法,并提出了几个关键更新,以实现更精简的工作流程和更可定制的最终产品。

- Spotify资深数据科学家用来提高生产力的5个习惯。在为找到一份好的数据工作付出了所有努力之后,真正的工作开始了:你能做些什么来在新职位上表现出色,而不会有倦怠和/或冒名顶替综合症的风险?Khouloud El Alami提出了五个具体的想法,你可以根据自己的需求进行调整,也不会吝啬细节。

- 英特尔ML实习的7堂课。在银行业长期担任数据科学家后,康纳·奥沙利文最近的职业转折使他在科技巨头英特尔进行了机器学习实习;不要错过他在那里的经历,以及他在探索一个新的行业和组织文化时所学到的教训。

和往常一样,最近几周,我们的作者涵盖了令人眼花缭乱的广泛主题,从人工智能的新兴技能到预测建模和深度学习。以下是我们不希望您错过的突出帖子示例。

- 多模式模型在视觉单词谜题上的表现如何?Yennie Jun测试了GPT-4 Vision和Gemini Pro Vision的能力,试图衡量他们这一代模特的创作过程水平。

- 以物理为基础的神经网络听起来可能是一个崇高的、理论含量很高的概念,但正如郭在一篇全面综述中所展示的那样,它们在现实世界中的应用有很多——而且正在以健康的速度增长。

- 在一个易于理解、图文并茂的解释中,Shrya Rao继续探索基本的深度学习主题,这一次打开了允许神经网络学习的过程。

- 在她的TDS首秀中,Nithya(Nithhya)Ramamorthy提供了一个简单有效的框架,帮助您在数据演示中建立信心。

- 如果你正在寻找一个清晰、详细的R平方指南,也就是决定系数,不要错过Roberta Rocca的一站式资源,它将消除人们对这个无处不在的指标的困惑。

- 有心情进行一次引人入胜、亲力亲为的深潜吗?Tim Forster带领我们完成了使用线性求解器在一维以上优化非线性神经网络的过程。

感谢您对我们作者工作的支持!如果你觉得加入他们的行列很有灵感,为什么不写你的第一篇帖子呢?我们很想读一读。

- 62 次浏览

【数据科学】为什么你应该为了数据科学学习PostgreSQL

SQL是成为数据科学家的必要条件吗?答案是肯定的。数据科学已经发展了,虽然许多数据科学家仍然使用CSV文件(值以逗号分隔的文本文件),但它们不是最好的选择。Python Panda库允许从CSV文件加载数据,但是这些文件有许多约束。例如,它们通常不连接到数据库,这就要求您在每次更新数据时生成一个新的CSV文件提取。在大数据时代,这是完全不切实际的。

关系数据库为使用大数据存储库提供所需的支持和敏捷性。PostgreSQL是领先的关系数据库管理系统之一。专为处理大型数据集而设计的Postgres是数据科学的完美匹配。在本文中,我们将介绍在数据科学中使用Postgres的优点和缺点。

什么是数据科学家?

数据科学是近年来最受欢迎的职业选择之一。随着组织管理着巨大的数据集,对能够从中提取有价值信息的专家的需求也在增加。

数据科学家处理大数据,帮助组织从数据中获得可操作的见解。例如,他们可以发现一个市场利基,或者根据最新的市场趋势改进公司的产品。

数据科学的领域和它所操作的数据一样多样化,但有一些核心技能是每个数据科学家都应该具备的。

- 编程技能:数据科学家使用编码来分析和处理信息,所以有很强的编程技能是很重要的。数据库和统计编程语言,如SQL或R,是必须的。数据科学家了解的编程语言越多,可以应用的工具越多,效果就越好。

- 统计和数学技能:数据科学需要处理统计数据。您需要正确的算法从数据集提取您想知道的内容。要做到这一点,数据科学家需要对统计学和数学概念有很强的掌握。

技术技能是必须的。然而,数据科学家也需要软技能,比如决心、对细节的关注和分析能力。在数据科学领域工作的两个基本技能是好奇心和灵活性。例如,数据科学家经常需要为数据问题提出开箱即用的算法。

PostgreSQL是什么?

关系数据库管理系统(RDBMS)。这个开源平台是由PostgreSQL全球开发小组开发的,该小组由公司和个人贡献者组成。它得到了广泛的软件即服务(SaaS)解决方案市场的支持,这些解决方案用于在云中和本地运行Postgres。

PostgresSQL的主要功能包括:

- 免费许可:该平台可以免费下载、使用、扩展和分发。

- 复杂查询支持:Postgres的基本特性之一是处理复杂查询的能力。复杂查询是从数据库发出的请求,超出了SELECT和WHERE等基本SQL请求的范围。

- 多版本并发控制:该特性允许不同的用户同时对数据库进行读写操作。

- 用户定义类型:用户可以自定义函数来定义单个数据类型。数据科学家使用已知或未知的数据。将两种或三种数据类型组合成一种新的数据类型,可以帮助数据科学家解决来自不同来源的大量数据的复杂问题。

- 高度符合SQL ISO/ iec9075标准:PostgreSQL满足164个强制特性中的150个,完全符合标准要求。从一开始,遵从SQL标准就一直是Postgres的优先事项。

- 强大的社区支持:Postgres拥有一个庞大的贡献者社区,他们致力于扩展和开发这个平台。有广泛的支持文档和论坛。

- 编程语言支持:PostgresSQL支持所有主要的编程语言,如Python、C和Java。它还通过JSON支持NoSQL查询。

- 多环境支持:PostgreSQL的特点之一是支持

云计算和本地环境。这称为多环境或跨环境支持。RightScale最近的一份报告显示,大多数使用Postgres的组织选择了一种混合的云环境,即内部配置和云系统的混合。

Postgres对数据科学的利弊

PostgresSQL支持大数据,为文档添加了JSON-B,为地理定位系统添加了PostGIS。它允许用户根据自己的工作负载调整平台。

该平台在混合事务/分析处理(HTAP)中结合了数据分析和事务功能。该特性使数据库能够同时执行在线分析处理(OLAP)和在线事务处理(OLTP)。例如,组织可以使用Postgres中的HTAP技术来管理来自物联网设备和其他操作应用程序的信息。

由于Postgres的灵活性和可扩展性,它在数据科学家中非常流行。但是,它不将数据存储在列中,这使得大型数据仓库很难处理这些数据。

在数据科学中使用PostgresSQL有利有弊。以下是一些优点和缺点:

优点

- SQL Rich:由于强调SQL标准遵从性,所以Postgres支持很多SQL语法。这包括公共表表达式、表继承和Windows函数。

- 非结构化数据支持:Postgres支持NoSQL数据,如XML、JSON和HStore。

- 并行查询:该特性允许同时运行处理器中的所有核心。这在数据科学中尤其重要,因为在数据科学中经常运行一个通用查询。

- 声明式分区:该功能可以指定如何将表划分为称为分区的部分。例如,当处理地理上分布的大型研究数据集时,这使您能够为每个区号分离不同的分区。

缺点

- 没有压缩:没有足够的空间会限制某些分析的性能。压缩数据有助于避免在向云中上传数据时形成瓶颈。PostgreSQL不提供数据压缩,这使得上传数据的速度慢得多。

- 无列:分析数据库通常以列而不是行存储数据。Postgres缺少列状表,这使得数据难以摄取。例如,如果您有一个包含300列的表,那么您需要将它分成两个或更多的表来读取它。

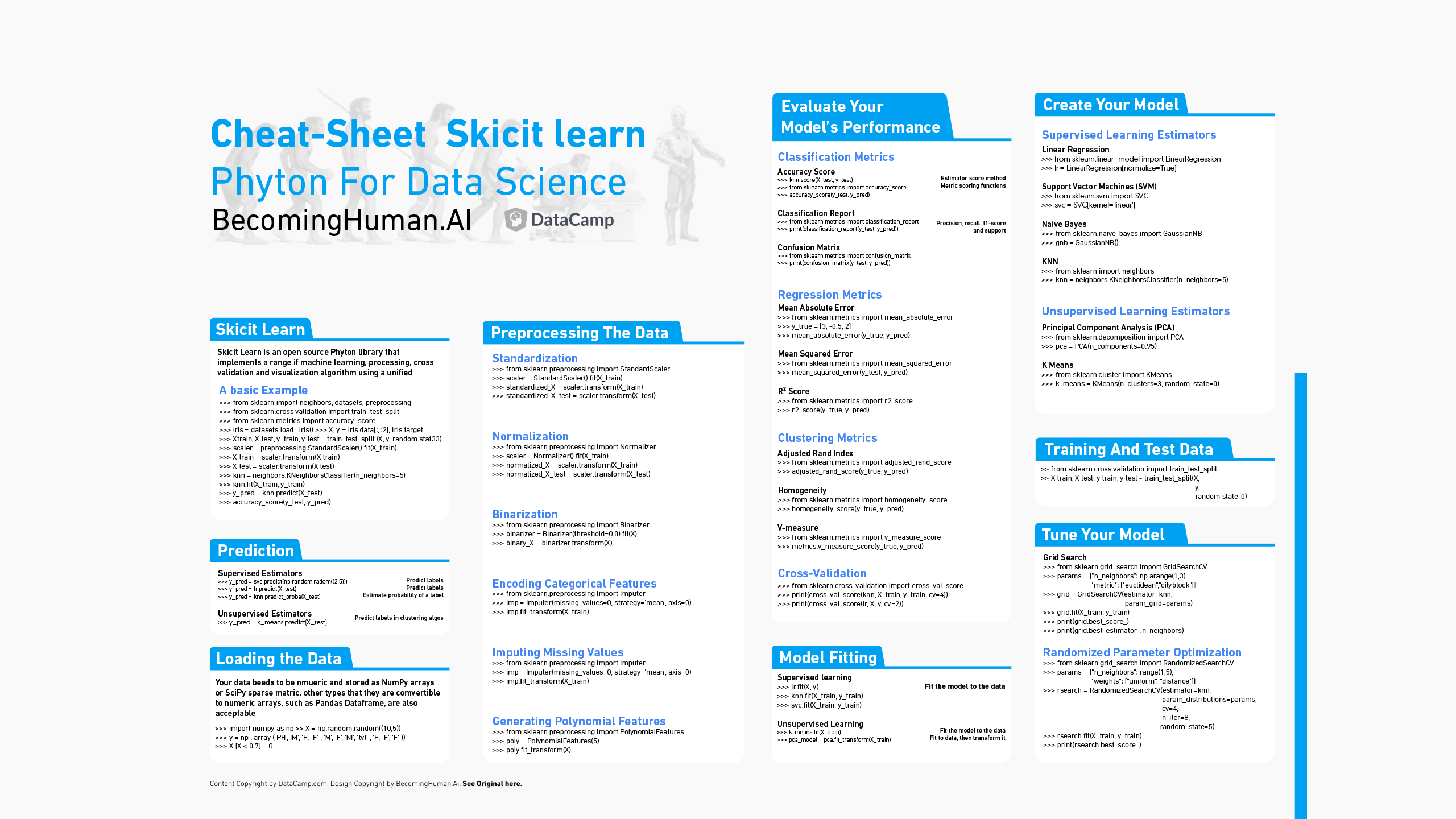

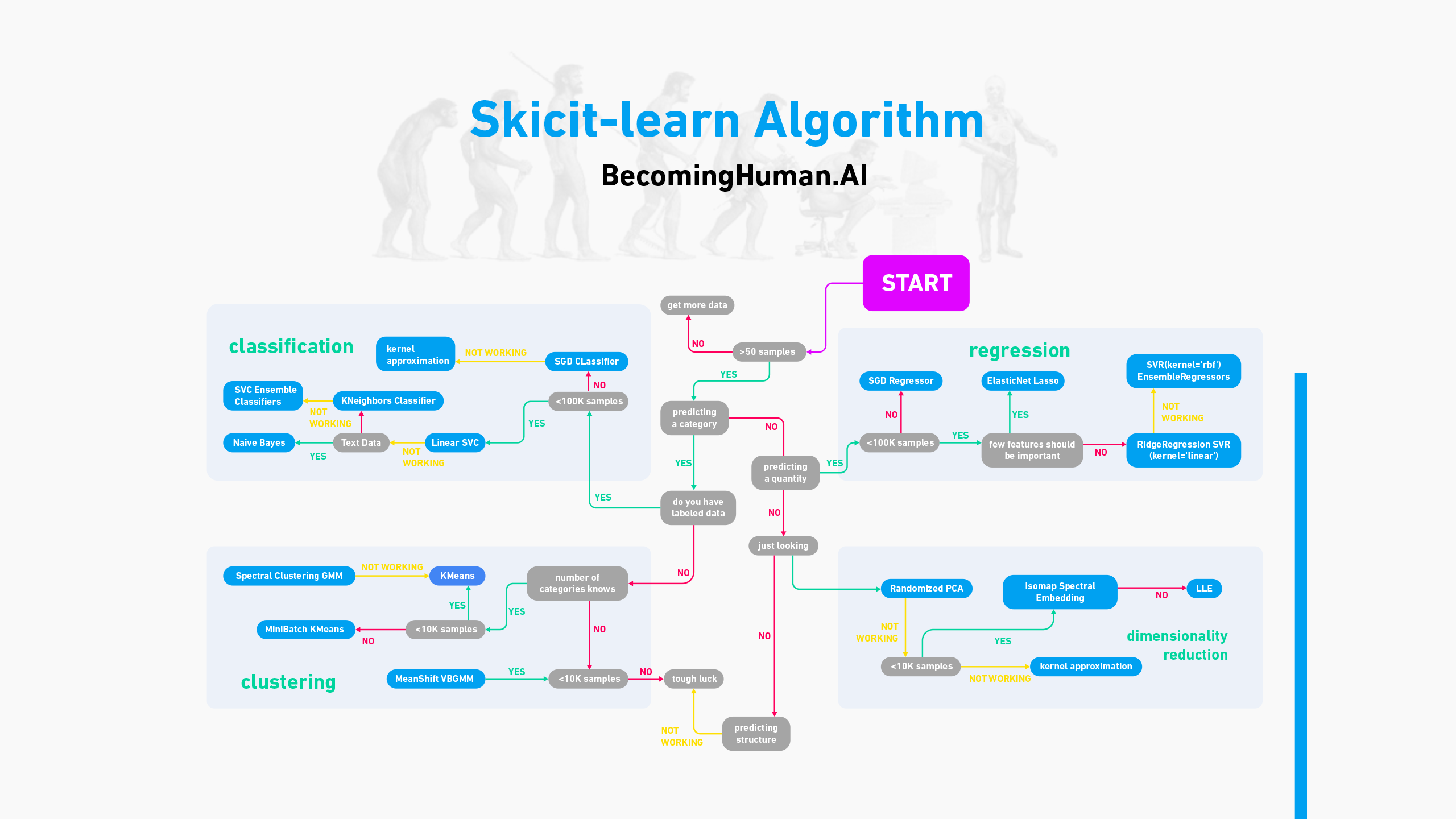

- 没有内置机器学习:这可能是最大的缺点,因为机器学习对于处理大数据至关重要。机器学习需要自己处理大量的数据来进行学习,而这种内置的特性可以帮助数据科学以一种高效的方式处理巨大的数据集,即使有人工干预,也是最少的。您可以添加Apache MADLib,这是一个用于机器学习的开源数据库算法库,但遗憾的是,它不能在Windows上运行。幸运的是,您可以通过使用一个sci-kit-learn库安装PLP/Python来克服这个挑战,从而直接在Postgres中编写您自己的机器学习算法。

你可以在哪里学习基础?

要学习PostgreSQL,您应该从SQL基础知识开始。这将为您构建PostgreSQL知识提供一个坚实的基础。你可以从免费的教程中学习,比如Codecademy。一旦您掌握了SQL的基础知识,您就可以开始学习如何将它与Postgres一起使用。

虽然从文档中学习可能是最彻底的方法,但也可能很乏味。网上有许多免费和付费的PostgreSQL课程。其中包括:

- PostgreSQL Tutorial: :这个免费的教程涵盖了Postgres的基础知识,包括基本的功能。

- Postgres Video Course::这个免费视频课程使用Postgres来教初学者SQL的基础。

- Postgres Administration Essentials:这个全面的培训面向数据库管理员和架构师。虽然课程本身是免费的,但该项目需要订阅。

- Postgres for Data Engineers: 这个付费课程是为数据工程师准备的,用数据科学的例子和案例涵盖了Postgres的基础知识。

总结

PostgreSQL为数据科学提供了一种低成本、功能强大的处理解决方案。最大的问题是它不提供数据压缩。您可以通过批量上传或仅在云环境中运行数据库来解决这个问题。

尽管如此,一个刚起步的数据科学家还是应该认真考虑学习PostgreSQL。Postgres可以帮助您准备使用大多数数据科学工具,成为掌握数据库知识的瑞士军刀。

原文:https://www.dataversity.net/why-you-should-learn-postgresql-for-data-science/

本文:

讨论:请加入知识星球【首席架构师圈】或者小号【jiagoushi_pro】

- 60 次浏览

【数据科学】什么是数据科学? 将数据转化为价值

视频号

微信公众号

知识星球

数据科学是一种将业务数据转化为资产的方法,可帮助组织提高收入、降低成本、抓住商机、改善客户体验等。

什么是数据科学?

数据科学是一种使用从统计分析到机器学习的方法从结构化和非结构化数据中收集见解的方法。 对于大多数组织而言,它被用来以提高收入、降低成本、业务敏捷性、改善客户体验、开发新产品等形式将数据转化为价值。 数据科学为组织收集的数据赋予了目的。

数据科学与数据分析

虽然密切相关,但数据分析是数据科学的一个组成部分,用于了解组织的数据是什么样子的。 数据科学利用分析的输出来解决问题。 数据科学家说,用数据调查某事只是分析。 数据科学通过分析进一步解释和解决问题。 数据分析和数据科学之间的区别也是时间尺度之一。 数据分析描述现实的当前状态,而数据科学使用该数据来预测和/或了解未来。

数据科学的好处

数据科学的商业价值取决于组织需求。 数据科学可以帮助组织构建工具来预测硬件故障,使组织能够执行维护并防止意外停机。 它可以帮助预测超市货架上放什么,或者根据产品的属性预测产品的受欢迎程度。

数据科学职位

虽然数据科学学位课程的数量正在快速增加,但它们不一定是组织在寻找数据科学家时所寻找的。 具有统计背景的候选人很受欢迎,特别是如果他们能够证明他们知道他们是否正在查看真实结果; 具有将结果置于上下文中的领域知识; 和沟通技巧,使他们能够将结果传达给业务用户。

许多组织都在寻找拥有博士学位的候选人,尤其是在物理学、数学、计算机科学、经济学甚至社会科学领域。 博士学位证明候选人有能力对某个主题进行深入研究并向他人传播信息。

一些最优秀的数据科学家或数据科学团队的领导者具有非传统背景,即使是很少受过正规计算机培训的人。 在许多情况下,关键能力是能够从非传统的角度看待事物并理解它。

有关数据科学家技能的更多信息,请参阅“什么是数据科学家? 关键的数据分析角色和有利可图的职业”,以及“精英数据科学家的基本技能和特质”。

数据科学薪水

根据 PayScale 的数据,以下是一些与数据科学相关的最受欢迎的职位以及每个职位的平均工资:

- Analytics manager: $71K-$131K

- Associate data scientist: $61K-$101K

- Business intelligence analyst: $52K-$97K

- Data analyst: $45K-$87K

- Data architect: $79K-$159K

- Data engineer: $66K-$132K

- Data scientist: $60K-$159K

- Data scientist, IT: $$60K-$159K

- Lead data scientist: $98K-$178K

- Research analyst: $43K-$82K

- Research scientist: $52K-$123K

- Senior data scientist: $96K-$162K

- Statistician: $55K-$117K

数据科学学位

据《财富》杂志报道,这些是数据科学领域的顶级研究生学位课程:

- University of Illinois at Urbana-Champaign

- University of California—Berkeley

- Texas Tech University

- Bay Path University

- Worcester Polytechnic Institute

- Loyola University Maryland

- University of Missouri—Columbia

- New Jersey Institute of Technology

- CUNY School of Professional Studies

- Syracuse University

数据科学培训和训练营

鉴于目前数据科学人才短缺,许多组织正在制定计划来培养内部数据科学人才。

训练营是另一种快速发展的培训工作者承担数据科学角色的途径。 有关数据科学训练营的更多详细信息,请参阅“促进职业发展的 15 个最佳数据科学训练营”。

数据科学认证

组织需要具有数据分析技术专业知识的数据科学家和分析师。 他们还需要大数据架构师将需求转化为系统,需要数据工程师来构建和维护数据管道,需要熟悉 Hadoop 集群和其他技术的开发人员,还需要系统管理员和经理将所有内容联系在一起。 认证是求职者证明自己具备合适技能的一种方式。

一些顶级大数据和数据分析认证包括:

- Certified Analytics Professional (CAP)

- Cloudera Data Platform Generalist Certification

- Data Science Council of America (DASCA) Senior Data Scientist (SDS)

- Data Science Council of America (DASCA) Principal Data Scientist (PDS)

- IBM Data Science Professional Certificate

- Microsoft Certified: Azure Data Scientist Associate

- Open Certified Data Scientist (Open CDS)

- SAS Certified Data Scientist

有关大数据和数据分析认证的更多信息,请参阅“11 大大数据和数据分析认证”和“12 项有回报的数据科学认证”。

数据科学团队

数据科学通常是一门团队学科。 数据科学家是大多数数据科学团队的核心,但从数据到分析再到生产价值需要一系列技能和角色。 例如,数据分析师应该参与调查,然后再将数据呈现给团队并维护数据模型。 数据工程师需要构建数据管道以丰富数据集并使数据可供公司其他部门使用。

如需进一步了解构建数据科学团队,请参阅“如何组建高效的分析团队”和“高度成功的数据分析团队的秘诀”。

数据科学目标和可交付成果

数据科学的目标是构建从数据中提取以业务为中心的洞察力的方法。 这需要了解价值和信息在企业中的流动方式,以及利用这种理解来识别商机的能力。 虽然这可能涉及一次性项目,但更典型的数据科学团队会寻求识别关键数据资产,这些资产可以转化为数据管道,为可维护的工具和解决方案提供数据。 示例包括银行使用的信用卡欺诈监控解决方案,或用于优化风力涡轮机在风电场中的位置的工具。

递增地,传达团队正在做什么的演示文稿也是重要的可交付成果。

数据科学过程和方法

生产工程团队在冲刺周期内工作,并有预计的时间表。 对于数据科学团队来说,这通常很难做到,因为前期可能会花费大量时间来确定项目是否可行。 必须收集和清理数据。 然后团队必须确定它是否可以有效地回答问题。

理想情况下,数据科学应该遵循科学方法,尽管情况并非总是如此,甚至不可行。 真正的科学需要时间。 您会花一点时间来确认您的假设,然后花很多时间来反驳自己。 在业务中,回答时间很重要。 因此,数据科学通常意味着选择“足够好”的答案,而不是最佳答案。 然而,危险在于结果可能会成为确认偏差或过度拟合的牺牲品。

数据科学工具

数据科学团队使用范围广泛的工具,包括 SQL、Python、R、Java 以及 Hive、oozie 和 TensorFlow 等开源项目的聚宝盆。 这些工具用于各种与数据相关的任务,从提取和清理数据到通过统计方法或机器学习对数据进行算法分析。 一些常用工具包括:

- SAS”这一专有统计工具用于数据挖掘、统计分析、商业智能、临床试验分析和时间序列分析。

- Tableau:Tableau 现在归 Salesforce 所有,是一种数据可视化工具。

- TensorFlow:由 Google 开发并获得 Apache License 2.0 许可,TensorFlow 是一个用于机器学习的软件库,用于深度神经网络的训练和推理。

- DataRobot:这个自动化机器学习平台用于构建、部署和维护 AI。

- BigML:BigML 是机器学习平台,专注于简化数据集和模型的构建和共享。

- Knime:Knime 是一个开源数据分析、报告和集成平台。

- Apache Spark:这个统一的分析引擎专为处理大规模数据而设计,支持数据清理、转换、模型构建和评估。

- RapidMiner:这个数据科学平台旨在支持团队,支持数据准备、机器学习和预测模型部署。

- Matplotlib:这个用于 Python 的开源绘图库提供了用于创建静态、动画和交互式可视化的工具。

- Excel:Microsoft 的电子表格软件可能是周围使用最广泛的 BI 工具。 对于处理较小数据集的数据科学家来说,它也很方便。

- js:此 JavaScript 库用于在 Web 浏览器中进行交互式可视化。

- ggplot2:这个高级数据可视化包让数据科学家可以根据分析数据创建可视化效果。

- Jupyter:这个基于 Python 的开源工具用于编写实时代码、可视化和演示。

- 18 次浏览

【数据科学】从头开始学习 R的数据科学的完整的教程

A Complete Tutorial to learn Data Science in R from Scratch

Introduction

R is a powerful language used widely for data analysis and statistical computing. It was developed in early 90s. Since then, endless efforts have been made to improve R’s user interface. The journey of R language from a rudimentary text editor to interactive R Studio and more recently Jupyter Notebookshas engaged many data science communities across the world.

This was possible only because of generous contributions by R users globally. Inclusion of powerful packages in R has made it more and more powerful with time. Packages such as dplyr, tidyr, readr, data.table, SparkR, ggplot2 have made data manipulation, visualization and computation much faster.

But, what about Machine Learning ?

My first impression of R was that it’s just a software for statistical computing. Good thing, I was wrong! R has enough provisions to implement machine learning algorithms in a fast and simple manner.

This is a complete tutorial to learn data science and machine learning using R. By the end of this tutorial, you will have a good exposure to building predictive models using machine learning on your own.

Note: No prior knowledge of data science / analytics is required. However, prior knowledge of algebra and statistics will be helpful.

Table of Contents

-

Basics of R Programming for Data Science

-

Why learn R ?

-

How to install R / R Studio ?

-

How to install R packages ?

-

Basic computations in R

-

Essentials of R Programming

-

Data Types and Objects in R

-

Control Structures (Functions) in R

-

Useful R Packages

-

Exploratory Data Analysis in R

-

Basic Graphs

-

Treating Missing values

-

Working with Continuous and Categorical Variables

-

Data Manipulation in R

-

Feature Engineering

-

Label Encoding / One Hot Encoding

-

Predictive Modeling using Machine Learning in R

-

Linear Regression

-

Decision Tree

-

Random Forest

Let’s get started !

Note: The data set used in this article is from Big Mart Sales Prediction.

1. Basics of R Programming

Why learn R ?

I don’t know if I have a solid reason to convince you, but let me share what got me started. I have no prior coding experience. Actually, I never had computer science in my subjects. I came to know that to learn data science, one must learn either R or Python as a starter. I chose the former. Here are some benefits I found after using R:

-

The style of coding is quite easy.

-

It’s open source. No need to pay any subscription charges.

-

Availability of instant access to over 7800 packages customized for various computation tasks.

-

The community support is overwhelming. There are numerous forums to help you out.

-

Get high performance computing experience ( require packages)

-

One of highly sought skill by analytics and data science companies.

There are many more benefits. But, these are the ones which have kept me going. If you think they are exciting, stick around and move to next section. And, if you aren’t convinced, you may like Complete Python Tutorial from Scratch.

How to install R / R Studio ?

You could download and install the old version of R. But, I’d insist you to start with RStudio. It provides much better coding experience. For Windows users, R Studio is available for Windows Vista and above versions. Follow the steps below for installing R Studio:

-

In ‘Installers for Supported Platforms’ section, choose and click the R Studio installer based on your operating system. The download should begin as soon as you click.

-

Click Next..Next..Finish.

-

Download Complete.

-

To Start R Studio, click on its desktop icon or use ‘search windows’ to access the program. It looks like this:

Let’s quickly understand the interface of R Studio:

-

R Console: This area shows the output of code you run. Also, you can directly write codes in console. Code entered directly in R console cannot be traced later. This is where R script comes to use.

-

R Script: As the name suggest, here you get space to write codes. To run those codes, simply select the line(s) of code and press Ctrl + Enter. Alternatively, you can click on little ‘Run’ button location at top right corner of R Script.

-

R environment: This space displays the set of external elements added. This includes data set, variables, vectors, functions etc. To check if data has been loaded properly in R, always look at this area.

-

Graphical Output: This space display the graphs created during exploratory data analysis. Not just graphs, you could select packages, seek help with embedded R’s official documentation.

How to install R Packages ?

The sheer power of R lies in its incredible packages. In R, most data handling tasks can be performed in 2 ways: Using R packages and R base functions. In this tutorial, I’ll also introduce you with the most handy and powerful R packages. To install a package, simply type:

install.packages("package name")

As a first time user, a pop might appear to select your CRAN mirror (country server), choose accordingly and press OK.

Note: You can type this either in console directly and press ‘Enter’ or in R script and click ‘Run’.

Basic Computations in R

Let’s begin with basics. To get familiar with R coding environment, start with some basic calculations. R console can be used as an interactive calculator too. Type the following in your console:

> 2 + 3

> 5

> 6 / 3

> 2

> (3*8)/(2*3)

> 4

> log(12)

> 1.07

> sqrt (121)

> 11

Similarly, you can experiment various combinations of calculations and get the results. In case, you want to obtain the previous calculation, this can be done in two ways. First, click in R console, and press ‘Up / Down Arrow’ key on your keyboard. This will activate the previously executed commands. Press Enter.

But, what if you have done too many calculations ? It would be too painful to scroll through every command and find it out. In such situations, creating variable is a helpful way.

In R, you can create a variable using <- or = sign. Let’s say I want to create a variable x to compute the sum of 7 and 8. I’ll write it as:

> x <- 8 + 7

> x

> 15

Once we create a variable, you no longer get the output directly (like calculator), unless you call the variable in the next line.

Remember, variables can be alphabets, alphanumeric but not numeric. You can’t create numeric variables.

2. Essentials of R Programming

Understand and practice this section thoroughly. This is the building block of your R programming knowledge. If you get this right, you would face less trouble in debugging.

R has five basic or ‘atomic’ classes of objects. Wait, what is an object ?

Everything you see or create in R is an object. A vector, matrix, data frame, even a variable is an object. R treats it that way. So, R has 5 basic classes of objects. This includes:

-

Character

-

Numeric (Real Numbers)

-

Integer (Whole Numbers)

-

Complex

-

Logical (True / False)

Since these classes are self-explanatory by names, I wouldn’t elaborate on that. These classes have attributes. Think of attributes as their ‘identifier’, a name or number which aptly identifies them. An object can have following attributes:

-

names, dimension names

-

dimensions

-

class

-

length

Attributes of an object can be accessed using attributes() function. More on this coming in following section.

Let’s understand the concept of object and attributes practically. The most basic object in R is known as vector. You can create an empty vector using vector(). Remember, a vector contains object of same class.

For example: Let’s create vectors of different classes. We can create vector using c() or concatenate command also.

> a <- c(1.8, 4.5) #numeric

> b <- c(1 + 2i, 3 - 6i) #complex

> d <- c(23, 44) #integer

> e <- vector("logical", length = 5)

Similarly, you can create vector of various classes.

Data Types in R

R has various type of ‘data types’ which includes vector (numeric, integer etc), matrices, data frames and list. Let’s understand them one by one.

Vector: As mentioned above, a vector contains object of same class. But, you can mix objects of different classes too. When objects of different classes are mixed in a list, coercion occurs. This effect causes the objects of different types to ‘convert’ into one class. For example:

> qt <- c("Time", 24, "October", TRUE, 3.33) #character

> ab <- c(TRUE, 24) #numeric

> cd <- c(2.5, "May") #character

To check the class of any object, use class(“vector name”) function.

> class(qt)

"character"

To convert the class of a vector, you can use as. command.

> bar <- 0:5

> class(bar)

> "integer"

> as.numeric(bar)

> class(bar)

> "numeric"

> as.character(bar)

> class(bar)

> "character"

Similarly, you can change the class of any vector. But, you should pay attention here. If you try to convert a “character” vector to “numeric” , NAs will be introduced. Hence, you should be careful to use this command.

List: A list is a special type of vector which contain elements of different data types. For example:

> my_list <- list(22, "ab", TRUE, 1 + 2i)

> my_list

[[1]]

[1] 22

[[2]]

[1] "ab"

[[3]]

[1] TRUE

[[4]]

[1] 1+2i

As you can see, the output of a list is different from a vector. This is because, all the objects are of different types. The double bracket [[1]] shows the index of first element and so on. Hence, you can easily extract the element of lists depending on their index. Like this:

> my_list[[3]]

> [1] TRUE

You can use [] single bracket too. But, that would return the list element with its index number, instead of the result above. Like this:

> my_list[3]

> [[1]]

[1] TRUE

Matrices: When a vector is introduced with row and column i.e. a dimension attribute, it becomes a matrix. A matrix is represented by set of rows and columns. It is a 2 dimensional data structure. It consist of elements of same class. Let’s create a matrix of 3 rows and 2 columns:

> my_matrix <- matrix(1:6, nrow=3, ncol=2)

> my_matrix

[,1] [,2]

[1,] 1 4

[2,] 2 5

[3,] 3 6

> dim(my_matrix)

[1] 3 2

> attributes(my_matrix)

$dim

[1] 3 2

As you can see, the dimensions of a matrix can be obtained using either dim() or attributes() command. To extract a particular element from a matrix, simply use the index shown above. For example(try this at your end):

> my_matrix[,2] #extracts second column

> my_matrix[,1] #extracts first column

> my_matrix[2,] #extracts second row

> my_matrix[1,] #extracts first row

As an interesting fact, you can also create a matrix from a vector. All you need to do is, assign dimension dim() later. Like this:

> age <- c(23, 44, 15, 12, 31, 16)

> age

[1] 23 44 15 12 31 16

> dim(age) <- c(2,3)

> age

[,1] [,2] [,3]

[1,] 23 15 31

[2,] 44 12 16

> class(age)

[1] "matrix"

You can also join two vectors using cbind() and rbind() functions. But, make sure that both vectors have same number of elements. If not, it will return NA values.

> x <- c(1, 2, 3, 4, 5, 6)

> y <- c(20, 30, 40, 50, 60)

> cbind(x, y)

> cbind(x, y)

x y

[1,] 1 20

[2,] 2 30

[3,] 3 40

[4,] 4 50

[5,] 5 60

[6,] 6 70

> class(cbind(x, y))

[1] “matrix”

Data Frame: This is the most commonly used member of data types family. It is used to store tabular data. It is different from matrix. In a matrix, every element must have same class. But, in a data frame, you can put list of vectors containing different classes. This means, every column of a data frame acts like a list. Every time you will read data in R, it will be stored in the form of a data frame. Hence, it is important to understand the majorly used commands on data frame:

> df <- data.frame(name = c("ash","jane","paul","mark"), score = c(67,56,87,91))

> df

name score

1 ash 67

2 jane 56

3 paul 87

4 mark 91

> dim(df)

[1] 4 2

> str(df)

'data.frame': 4 obs. of 2 variables:

$ name : Factor w/ 4 levels "ash","jane","mark",..: 1 2 4 3

$ score: num 67 56 87 91

> nrow(df)

[1] 4

> ncol(df)

[1] 2

Let’s understand the code above. df is the name of data frame. dim() returns the dimension of data frame as 4 rows and 2 columns. str() returns the structure of a data frame i.e. the list of variables stored in the data frame. nrow() and ncol() return the number of rows and number of columns in a data set respectively.

Here you see “name” is a factor variable and “score” is numeric. In data science, a variable can be categorized into two types: Continuous and Categorical.

Continuous variables are those which can take any form such as 1, 2, 3.5, 4.66 etc. Categorical variables are those which takes only discrete values such as 2, 5, 11, 15 etc. In R, categorical values are represented by factors. In df, name is a factor variable having 4 unique levels. Factor or categorical variable are specially treated in a data set. For more explanation, click here. Similarly, you can find techniques to deal with continuous variables here.

Let’s now understand the concept of missing values in R. This is one of the most painful yet crucial part of predictive modeling. You must be aware of all techniques to deal with them. The complete explanation on such techniques is provided here.

Missing values in R are represented by NA and NaN. Now we’ll check if a data set has missing values (using the same data frame df).

> df[1:2,2] <- NA #injecting NA at 1st, 2nd row and 2nd column of df

> df

name score

1 ash NA

2 jane NA

3 paul 87

4 mark 91

> is.na(df) #checks the entire data set for NAs and return logical output

name score

[1,] FALSE TRUE

[2,] FALSE TRUE

[3,] FALSE FALSE

[4,] FALSE FALSE

> table(is.na(df)) #returns a table of logical output

FALSE TRUE

6 2

> df[!complete.cases(df),] #returns the list of rows having missing values

name score

1 ash NA

2 jane NA

Missing values hinder normal calculations in a data set. For example, let’s say, we want to compute the mean of score. Since there are two missing values, it can’t be done directly. Let’s see:

mean(df$score)

[1] NA

> mean(df$score, na.rm = TRUE)

[1] 89

The use of na.rm = TRUE parameter tells R to ignore the NAs and compute the mean of remaining values in the selected column (score). To remove rows with NA values in a data frame, you can use na.omit:

> new_df <- na.omit(df)

> new_df

name score

3 paul 87

4 mark 91

Control Structures in R

As the name suggest, a control structure ‘controls’ the flow of code / commands written inside a function. A function is a set of multiple commands written to automate a repetitive coding task.

For example: You have 10 data sets. You want to find the mean of ‘Age’ column present in every data set. This can be done in 2 ways: either you write the code to compute mean 10 times or you simply create a function and pass the data set to it.

Let’s understand the control structures in R with simple examples:

if, else – This structure is used to test a condition. Below is the syntax:

if (<condition>){

##do something

} else {

##do something

}

Example

#initialize a variable

N <- 10

#check if this variable * 5 is > 40

if (N * 5 > 40){

print("This is easy!")

} else {

print ("It's not easy!")

}

[1] "This is easy!"

for – This structure is used when a loop is to be executed fixed number of times. It is commonly used for iterating over the elements of an object (list, vector). Below is the syntax:

for (<search condition>){

#do something

}

Example

#initialize a vector

y <- c(99,45,34,65,76,23)

#print the first 4 numbers of this vector

for(i in 1:4){

print (y[i])

}

[1] 99

[1] 45

[1] 34

[1] 65

while – It begins by testing a condition, and executes only if the condition is found to be true. Once the loop is executed, the condition is tested again. Hence, it’s necessary to alter the condition such that the loop doesn’t go infinity. Below is the syntax:

#initialize a condition

Age <- 12

#check if age is less than 17

while(Age < 17){

print(Age)

Age <- Age + 1 #Once the loop is executed, this code breaks the loop

}

[1] 12

[1] 13

[1] 14

[1] 15

[1] 16

There are other control structures as well but are less frequently used than explained above. Those structures are:

-

repeat – It executes an infinite loop

-

break – It breaks the execution of a loop

-

next – It allows to skip an iteration in a loop

-

return – It help to exit a function

Note: If you find the section ‘control structures’ difficult to understand, not to worry. R is supported by various packages to compliment the work done by control structures.

Useful R Packages

Out of ~7800 packages listed on CRAN, I’ve listed some of the most powerful and commonly used packages in predictive modeling in this article. Since, I’ve already explained the method of installing packages, you can go ahead and install them now. Sooner or later you’ll need them.

Importing Data: R offers wide range of packages for importing data available in any format such as .txt, .csv, .json, .sql etc. To import large files of data quickly, it is advisable to install and use data.table, readr, RMySQL, sqldf, jsonlite.

Data Visualization: R has in built plotting commands as well. They are good to create simple graphs. But, becomes complex when it comes to creating advanced graphics. Hence, you should install ggplot2.

Data Manipulation: R has a fantastic collection of packages for data manipulation. These packages allows you to do basic & advanced computations quickly. These packages are dplyr, plyr, tidyr, lubridate, stringr. Check out this complete tutorial on data manipulation packages in R.

Modeling / Machine Learning: For modeling, caret package in R is powerful enough to cater to every need for creating machine learning model. However, you can install packages algorithms wise such as randomForest, rpart, gbm etc

Note: I’ve only mentioned the commonly used packages. You might like to check this interesting infographic on complete list of useful R packages.

Till here, you became familiar with the basic work style in R and its associated components. From next section, we’ll begin with predictive modeling. But before you proceed. I want you to practice, what you’ve learnt till here.

Practice Assignment:

As a part of this assignment, install ‘swirl’ package in package. Then type, library(swirl) to initiate the package. And, complete this interactive R tutorial. If you have followed this article thoroughly, this assignment should be an easy task for you!

3. Exploratory Data Analysis in R

From this section onwards, we’ll dive deep into various stages of predictive modeling. Hence, make sure you understand every aspect of this section. In case you find anything difficult to understand, ask me in the comments section below.

Data Exploration is a crucial stage of predictive model. You can’t build great and practical models unless you learn to explore the data from begin to end. This stage forms a concrete foundation for data manipulation (the very next stage). Let’s understand it in R.

In this tutorial, I’ve taken the data set from Big Mart Sales Prediction. Before we start, you must get familiar with these terms:

Response Variable (a.k.a Dependent Variable): In a data set, the response variable (y) is one on which we make predictions. In this case, we’ll predict ‘Item_Outlet_Sales’. (Refer to image shown below)

Predictor Variable (a.k.a Independent Variable): In a data set, predictor variables (Xi) are those using which the prediction is made on response variable. (Image below).

Train Data: The predictive model is always built on train data set. An intuitive way to identify the train data is, that it always has the ‘response variable’ included.

Test Data: Once the model is built, it’s accuracy is ‘tested’ on test data. This data always contains less number of observations than train data set. Also, it does not include ‘response variable’.

Right now, you should download the data set. Take a good look at train and test data. Cross check the information shared above and then proceed.

Let’s now begin with importing and exploring data.

#working directory

path <- ".../Data/BigMartSales"

#set working directory

setwd(path)

As a beginner, I’ll advise you to keep the train and test files in your working directly to avoid unnecessary directory troubles. Once the directory is set, we can easily import the .csv files using commands below.

#Load Datasets

train <- read.csv("Train_UWu5bXk.csv")

test <- read.csv("Test_u94Q5KV.csv")

In fact, even prior to loading data in R, it’s a good practice to look at the data in Excel. This helps in strategizing the complete prediction modeling process. To check if the data set has been loaded successfully, look at R environment. The data can be seen there. Let’s explore the data quickly.

#check dimesions ( number of row & columns) in data set

> dim(train)

[1] 8523 12

> dim(test)

[1] 5681 11

We have 8523 rows and 12 columns in train data set and 5681 rows and 11 columns in data set. This makes sense. Test data should always have one column less (mentioned above right?). Let’s get deeper in train data set now.

#check the variables and their types in train

> str(train)

'data.frame': 8523 obs. of 12 variables:

$ Item_Identifier : Factor w/ 1559 levels "DRA12","DRA24",..: 157 9 663 1122 1298 759 697 739 441 991 ...

$ Item_Weight : num 9.3 5.92 17.5 19.2 8.93 ...

$ Item_Fat_Content : Factor w/ 5 levels "LF","low fat",..: 3 5 3 5 3 5 5 3 5 5 ...

$ Item_Visibility : num 0.016 0.0193 0.0168 0 0 ...

$ Item_Type : Factor w/ 16 levels "Baking Goods",..: 5 15 11 7 10 1 14 14 6 6 ...

$ Item_MRP : num 249.8 48.3 141.6 182.1 53.9 ...

$ Outlet_Identifier : Factor w/ 10 levels "OUT010","OUT013",..: 10 4 10 1 2 4 2 6 8 3 ...

$ Outlet_Establishment_Year: int 1999 2009 1999 1998 1987 2009 1987 1985 2002 2007 ...

$ Outlet_Size : Factor w/ 4 levels "","High","Medium",..: 3 3 3 1 2 3 2 3 1 1 ...

$ Outlet_Location_Type : Factor w/ 3 levels "Tier 1","Tier 2",..: 1 3 1 3 3 3 3 3 2 2 ...

$ Outlet_Type : Factor w/ 4 levels "Grocery Store",..: 2 3 2 1 2 3 2 4 2 2 ...

$ Item_Outlet_Sales : num 3735 443 2097 732 995 ..

.

Let’s do some quick data exploration.

To begin with, I’ll first check if this data has missing values. This can be done by using:

> table(is.na(train))

FALSE TRUE

100813 1463

In train data set, we have 1463 missing values. Let’s check the variables in which these values are missing. It’s important to find and locate these missing values. Many data scientists have repeatedly advised beginners to pay close attention to missing value in data exploration stages.

> colSums(is.na(train))

Item_Identifier Item_Weight

0 1463

Item_Fat_Content Item_Visibility

0 0

Item_Type Item_MRP

0 0

Outlet_Identifier Outlet_Establishment_Year

0 0

Outlet_Size Outlet_Location_Type

0 0

Outlet_Type Item_Outlet_Sales

0 0

Hence, we see that column Item_Weight has 1463 missing values. Let’s get more inferences from this data.

> summary(train)

Here are some quick inferences drawn from variables in train data set:

-

Item_Fat_Content has mis-matched factor levels.

-

Minimum value of item_visibility is 0. Practically, this is not possible. If an item occupies shelf space in a grocery store, it ought to have some visibility. We’ll treat all 0’s as missing values.

-

Item_Weight has 1463 missing values (already explained above).

-

Outlet_Size has a unmatched factor levels.

These inference will help us in treating these variable more accurately.

Graphical Representation of Variables

I’m sure you would understand these variables better when explained visually. Using graphs, we can analyze the data in 2 ways: Univariate Analysis and Bivariate Analysis.

Univariate analysis is done with one variable. Bivariate analysis is done with two variables. Univariate analysis is a lot easy to do. Hence, I’ll skip that part here. I’d recommend you to try it at your end. Let’s now experiment doing bivariate analysis and carve out hidden insights.

For visualization, I’ll use ggplot2 package. These graphs would help us understand the distribution and frequency of variables in the data set.

> ggplot(train, aes(x= Item_Visibility, y = Item_Outlet_Sales)) + geom_point(size = 2.5, color="navy") + xlab("Item Visibility") + ylab("Item Outlet Sales") + ggtitle("Item Visibility vs Item Outlet Sales")

We can see that majority of sales has been obtained from products having visibility less than 0.2. This suggests that item_visibility < 2 must be an important factor in determining sales. Let’s plot few more interesting graphs and explore such hidden stories.

> ggplot(train, aes(Outlet_Identifier, Item_Outlet_Sales)) + geom_bar(stat = "identity", color = "purple") +theme(axis.text.x = element_text(angle = 70, vjust = 0.5, color = "black")) + ggtitle("Outlets vs Total Sales") + theme_bw()

Here, we infer that OUT027 has contributed to majority of sales followed by OUT35. OUT10 and OUT19 have probably the least footfall, thereby contributing to the least outlet sales.

> ggplot(train, aes(Item_Type, Item_Outlet_Sales)) + geom_bar( stat = "identity") +theme(axis.text.x = element_text(angle = 70, vjust = 0.5, color = "navy")) + xlab("Item Type") + ylab("Item Outlet Sales")+ggtitle("Item Type vs Sales")

From this graph, we can infer that Fruits and Vegetables contribute to the highest amount of outlet sales followed by snack foods and household products. This information can also be represented using a box plot chart. The benefit of using a box plot is, you get to see the outlier and mean deviation of corresponding levels of a variable (shown below).

> ggplot(train, aes(Item_Type, Item_MRP)) +geom_boxplot() +ggtitle("Box Plot") + theme(axis.text.x = element_text(angle = 70, vjust = 0.5, color = "red")) + xlab("Item Type") + ylab("Item MRP") + ggtitle("Item Type vs Item MRP")

The black point you see, is an outlier. The mid line you see in the box, is the mean value of each item type. To know more about boxplots, check this tutorial.

Now, we have an idea of the variables and their importance on response variable. Let’s now move back to where we started. Missing values. Now we’ll impute the missing values.

We saw variable Item_Weight has missing values. Item_Weight is an continuous variable. Hence, in this case we can impute missing values with mean / median of item_weight. These are the most commonly used methods of imputing missing value. To explore other methods of this techniques, check out this tutorial.

Let’s first combine the data sets. This will save our time as we don’t need to write separate codes for train and test data sets. To combine the two data frames, we must make sure that they have equal columns, which is not the case.

> dim(train)

[1] 8523 12

> dim(test)

[1] 5681 11

Test data set has one less column (response variable). Let’s first add the column. We can give this column any value. An intuitive approach would be to extract the mean value of sales from train data set and use it as placeholder for test variable Item _Outlet_ Sales. Anyways, let’s make it simple for now. I’ve taken a value 1. Now, we’ll combine the data sets.

> test$Item_Outlet_Sales <- 1

> combi <- rbind(train, test)

Impute missing value by median. I’m using median because it is known to be highly robust to outliers. Moreover, for this problem, our evaluation metric is RMSE which is also highly affected by outliers. Hence, median is better in this case.

> combi$Item_Weight[is.na(combi$Item_Weight)] <- median(combi$Item_Weight, na.rm = TRUE)

> table(is.na(combi$Item_Weight))

FALSE

14204

Trouble with Continuous Variables & Categorical Variables

It’s important to learn to deal with continuous and categorical variables separately in a data set. In other words, they need special attention. In this data set, we have only 3 continuous variables and rest are categorical in nature. If you are still confused, I’ll suggest you to once again look at the data set using str() and proceed.

Let’s take up Item_Visibility. In the graph above, we saw item visibility has zero value also, which is practically not feasible. Hence, we’ll consider it as a missing value and once again make the imputation using median.

> combi$Item_Visibility <- ifelse(combi$Item_Visibility == 0,

median(combi$Item_Visibility), combi$Item_Visibility)

Let’s proceed to categorical variables now. During exploration, we saw there are mis-matched levels in variables which needs to be corrected.

> levels(combi$Outlet_Size)[1] <- "Other"

> library(plyr)

> combi$Item_Fat_Content <- revalue(combi$Item_Fat_Content,

c("LF" = "Low Fat", "reg" = "Regular"))

> combi$Item_Fat_Content <- revalue(combi$Item_Fat_Content, c("low fat" = "Low Fat"))

> table(combi$Item_Fat_Content)

Low Fat Regular

9185 5019

Using the commands above, I’ve assigned the name ‘Other’ to unnamed level in Outlet_Size variable.

Rest, I’ve simply renamed the various levels of Item_Fat_Content.

4. Data Manipulation in R

Let’s call it as, the advanced level of data exploration. In this section we’ll practically learn about feature engineering and other useful aspects.

Feature Engineering: This component separates an intelligent data scientist from a technically enabled data scientist. You might have access to large machines to run heavy computations and algorithms, but the power delivered by new features, just can’t be matched. We create new variables to extract and provide as much ‘new’ information to the model, to help it make accurate predictions.

If you have been thinking all this time, great. But now is the time to think deeper. Look at the data set and ask yourself, what else (factor) could influence Item_Outlet_Sales ? Anyhow, the answer is below. But, I want you to try it out first, before scrolling down.

1. Count of Outlet Identifiers – There are 10 unique outlets in this data. This variable will give us information on count of outlets in the data set. More the number of counts of an outlet, chances are more will be the sales contributed by it.

> library(dplyr)

> a <- combi%>%

group_by(Outlet_Identifier)%>%

tally()

> head(a)

Source: local data frame [6 x 2]

Outlet_Identifier n

(fctr) (int)

1 OUT010 925

2 OUT013 1553

3 OUT017 1543

4 OUT018 1546

5 OUT019 880

6 OUT027 1559

> names(a)[2] <- "Outlet_Count"

> combi <- full_join(a, combi, by = "Outlet_Identifier")

As you can see, dplyr package makes data manipulation quite effortless. You no longer need to write long function. In the code above, I’ve simply stored the new data frame in a variable a. Later, the new column Outlet_Count is added in our original ‘combi’ data set. To know more about dplyr, follow this tutorial.

2. Count of Item Identifiers – Similarly, we can compute count of item identifiers too. It’s a good practice to fetch more information from unique ID variables using their count. This will help us to understand, which outlet has maximum frequency.

> b <- combi%>%

group_by(Item_Identifier)%>%

tally()

> names(b)[2] <- "Item_Count"

> head (b)

Item_Identifier Item_Count

(fctr) (int)

1 DRA12 9

2 DRA24 10

3 DRA59 10

4 DRB01 8

5 DRB13 9

6 DRB24 8

> combi <- merge(b, combi, by = “Item_Identifier”)

3. Outlet Years – This variable represent the information of existence of a particular outlet since year 2013. Why just 2013? You’ll find the answer in problem statement here. My hypothesis is, older the outlet, more footfall, large base of loyal customers and larger the outlet sales.

> c <- combi%>%

select(Outlet_Establishment_Year)%>%

mutate(Outlet_Year = 2013 - combi$Outlet_Establishment_Year)

> head(c)

Outlet_Establishment_Year Outlet_Year

1 1999 14

2 2009 4

3 1999 14

4 1998 15

5 1987 26

6 2009 4

> combi <- full_join(c, combi)

This suggests that outlets established in 1999 were 14 years old in 2013 and so on.

4. Item Type New – Now, pay attention to Item_Identifiers. We are about to discover a new trend. Look carefully, there is a pattern in the identifiers starting with “FD”,”DR”,”NC”. Now, check the corresponding Item_Types to these identifiers in the data set. You’ll discover, items corresponding to “DR”, are mostly eatables. Items corresponding to “FD”, are drinks. And, item corresponding to “NC”, are products which can’t be consumed, let’s call them non-consumable. Let’s extract these variables into a new variable representing their counts.

Here I’ll use substr(), gsub() function to extract and rename the variables respectively.

> q <- substr(combi$Item_Identifier,1,2)

> q <- gsub("FD","Food",q)

> q <- gsub("DR","Drinks",q)

> q <- gsub("NC","Non-Consumable",q)

> table(q)

Drinks Food Non-Consumable

1317 10201 2686

Let’s now add this information in our data set with a variable name ‘Item_Type_New.

> combi$Item_Type_New <- q

I’ll leave the rest of feature engineering intuition to you. You can think of more variables which could add more information to the model. But make sure, the variable aren’t correlated. Since, they are emanating from a same set of variable, there is a high chance for them to be correlated. You can check the same in R using cor() function.

Label Encoding and One Hot Encoding

Just, one last aspect of feature engineering left. Label Encoding and One Hot Encoding.

Label Encoding, in simple words, is the practice of numerically encoding (replacing) different levels of a categorical variables. For example: In our data set, the variable Item_Fat_Content has 2 levels: Low Fat and Regular. So, we’ll encode Low Fat as 0 and Regular as 1. This will help us convert a factor variable in numeric variable. This can be simply done using if else statement in R.

> combi$Item_Fat_Content <- ifelse(combi$Item_Fat_Content == "Regular",1,0)

One Hot Encoding, in simple words, is the splitting a categorical variable into its unique levels, and eventually removing the original variable from data set. Confused ? Here’s an example: Let’s take any categorical variable, say, Outlet_ Location_Type. It has 3 levels. One hot encoding of this variable, will create 3 different variables consisting of 1s and 0s. 1s will represent the existence of variable and 0s will represent non-existence of variable. Let look at a sample:

> sample <- select(combi, Outlet_Location_Type)

> demo_sample <- data.frame(model.matrix(~.-1,sample))

> head(demo_sample)

Outlet_Location_TypeTier.1 Outlet_Location_TypeTier.2 Outlet_Location_TypeTier.3

1 1 0 0

2 0 0 1

3 1 0 0

4 0 0 1

5 0 0 1

6 0 0 1

model.matrix creates a matrix of encoded variables. ~. -1 tells R, to encode all variables in the data frame, but suppress the intercept. So, what will happen if you don’t write -1 ? model.matrix will skip the first level of the factor, thereby resulting in just 2 out of 3 factor levels (loss of information).

This was the demonstration of one hot encoding. Hope you have understood the concept now. Let’s now apply this technique to all categorical variables in our data set (excluding ID variable).

>library(dummies)

>combi <- dummy.data.frame(combi, names = c('Outlet_Size','Outlet_Location_Type','Outlet_Type', 'Item_Type_New'), sep='_')

With this, I have shared 2 different methods of performing one hot encoding in R. Let’s check if encoding has been done.

> str (combi)

$ Outlet_Size_Other : int 0 1 1 0 1 0 0 0 0 0 ...

$ Outlet_Size_High : int 0 0 0 1 0 0 0 0 0 0 ...

$ Outlet_Size_Medium : int 1 0 0 0 0 0 1 1 0 1 ...

$ Outlet_Size_Small : int 0 0 0 0 0 1 0 0 1 0 ...

$ Outlet_Location_Type_Tier 1 : int 1 0 0 0 0 0 0 0 1 0 ...

$ Outlet_Location_Type_Tier 2 : int 0 1 0 0 1 1 0 0 0 0 ...

$ Outlet_Location_Type_Tier 3 : int 0 0 1 1 0 0 1 1 0 1 ...

$ Outlet_Type_Grocery Store : int 0 0 1 0 0 0 0 0 0 0 ...

$ Outlet_Type_Supermarket Type1: int 1 1 0 1 1 1 0 0 1 0 ...

$ Outlet_Type_Supermarket Type2: int 0 0 0 0 0 0 0 1 0 0 ...

$ Outlet_Type_Supermarket Type3: int 0 0 0 0 0 0 1 0 0 1 ...

$ Item_Outlet_Sales : num 1 3829 284 2553 2553 ...

$ Year : num 14 11 15 26 6 9 28 4 16 28 ...

$ Item_Type_New_Drinks : int 1 1 1 1 1 1 1 1 1 1 ...

$ Item_Type_New_Food : int 0 0 0 0 0 0 0 0 0 0 ...

$ Item_Type_New_Non-Consumable : int 0 0 0 0 0 0 0 0 0 0 ...

As you can see, after one hot encoding, the original variables are removed automatically from the data set.

5. Predictive Modeling using Machine Learning

Finally, we’ll drop the columns which have either been converted using other variables or are identifier variables. This can be accomplished using select from dplyr package.

> combi <- select(combi, -c(Item_Identifier, Outlet_Identifier, Item_Fat_Content, Outlet_Establishment_Year,Item_Type))

> str(combi)

In this section, I’ll cover Regression, Decision Trees and Random Forest. A detailed explanation of these algorithms is outside the scope of this article. These algorithms have been satisfactorily explained in our previous articles. I’ve provided the links for useful resources.

As you can see, we have encoded all our categorical variables. Now, this data set is good to take forward to modeling. Since, we started from Train and Test, let’s now divide the data sets.

> new_train <- combi[1:nrow(train),]

> new_test <- combi[-(1:nrow(train)),]

Linear (Multiple) Regression

Multiple Regression is used when response variable is continuous in nature and predictors are many. Had it been categorical, we would have used Logistic Regression. Before you proceed, sharpen your basics of Regression here.

Linear Regression takes following assumptions:

-

There exists a linear relationship between response and predictor variables

-

The predictor (independent) variables are not correlated with each other. Presence of collinearity leads to a phenomenon known as multicollinearity.

-

The error terms are uncorrelated. Otherwise, it will lead to autocorrelation.

-

Error terms must have constant variance. Non-constant variance leads to heteroskedasticity.

Let’s now build out first regression model on this data set. R uses lm() function for regression.

> linear_model <- lm(Item_Outlet_Sales ~ ., data = new_train)

> summary(linear_model)

Adjusted R² measures the goodness of fit of a regression model. Higher the R², better is the model. Our R² = 0.2085. It means we really did something drastically wrong. Let’s figure it out.

In our case, I could find our new variables aren’t helping much i.e. Item count, Outlet Count and Item_Type_New. Neither of these variables are significant. Significant variables are denoted by ‘*’ sign.

As we know, correlated predictor variables brings down the model accuracy. Let’s find out the amount of correlation present in our predictor variables. This can be simply calculated using:

> cor(new_train)

Alternatively, you can also use corrplot package for some fancy correlation plots. Scrolling through the long list of correlation coefficients, I could find a deadly correlation coefficient:

cor(new_train$Outlet_Count, new_train$`Outlet_Type_Grocery Store`)

[1] -0.9991203

Outlet_Count is highly correlated (negatively) with Outlet Type Grocery Store. Here are some problems I could find in this model:

-

We have correlated predictor variables.

-

We did one hot encoding and label encoding. That’s not necessary since linear regression handle categorical variables by creating dummy variables intrinsically.

-

The new variables (item count, outlet count, item type new) created in feature engineering are not significant.

Let’s try to create a more robust regression model. This time, I’ll be using a building a simple model without encoding and new features. Below is the entire code:

#load directory

> path <- "C:/Users/manish/desktop/Data/February 2016"

> setwd(path)

#load data

> train <- read.csv("train_Big.csv")

> test <- read.csv("test_Big.csv")

#create a new variable in test file

> test$Item_Outlet_Sales <- 1

#combine train and test data

> combi <- rbind(train, test)

#impute missing value in Item_Weight

> combi$Item_Weight[is.na(combi$Item_Weight)] <- median(combi$Item_Weight, na.rm = TRUE)

#impute 0 in item_visibility

> combi$Item_Visibility <- ifelse(combi$Item_Visibility == 0, median(combi$Item_Visibility), combi$Item_Visibility)

#rename level in Outlet_Size

> levels(combi$Outlet_Size)[1] <- "Other"

#rename levels of Item_Fat_Content

> library(plyr)

> combi$Item_Fat_Content <- revalue(combi$Item_Fat_Content,c("LF" = "Low Fat", "reg" = "Regular"))

> combi$Item_Fat_Content <- revalue(combi$Item_Fat_Content, c("low fat" = "Low Fat"))

#create a new column 2013 - Year

> combi$Year <- 2013 - combi$Outlet_Establishment_Year

#drop variables not required in modeling

> library(dplyr)

> combi <- select(combi, -c(Item_Identifier, Outlet_Identifier, Outlet_Establishment_Year))

#divide data set

> new_train <- combi[1:nrow(train),]

> new_test <- combi[-(1:nrow(train)),]

#linear regression

> linear_model <- lm(Item_Outlet_Sales ~ ., data = new_train)

> summary(linear_model)

Now we have got R² = 0.5623. This teaches us that, sometimes all you need is simple thought process to get high accuracy. Quite a good improvement from previous model. Next, time when you work on any model, always remember to start with a simple model.

Let’s check out regression plot to find out more ways to improve this model.

> par(mfrow=c(2,2))

> plot(linear_model)

You can zoom these graphs in R Studio at your end. All these plots have a different story to tell. But the most important story is being portrayed by Residuals vs Fitted graph.

Residual values are the difference between actual and predicted outcome values. Fitted values are the predicted values. If you see carefully, you’ll discover it as a funnel shape graph (from right to left ). The shape of this graph suggests that our model is suffering from heteroskedasticity (unequal variance in error terms). Had there been constant variance, there would be no pattern visible in this graph.

A common practice to tackle heteroskedasticity is by taking the log of response variable. Let’s do it and check if we can get further improvement.

> linear_model <- lm(log(Item_Outlet_Sales) ~ ., data = new_train)

> summary(linear_model)

And, here’s a snapshot of my model output. Congrats! We have got an improved model with R² = 0.72. Now, we are on the right path. Once again you can check the residual plots (you might zoom it). You’ll find there is no longer a trend in residual vs fitted value plot.

This model can be further improved by detecting outliers and high leverage points. For now, I leave that part to you! I shall write a separate post on mysteries of regression soon. For now, let’s check our RMSE so that we can compare it with other algorithms demonstrated below.

To calculate RMSE, we can load a package named Metrics.

> install.packages("Metrics")

> library(Metrics)

> rmse(new_train$Item_Outlet_Sales, exp(linear_model$fitted.values))

[1] 1140.004

Let’s proceed to decision tree algorithm and try to improve our RMSE score.

Decision Trees

Before you start, I’d recommend you to glance through the basics of decision tree algorithms. To understand what makes it superior than linear regression, check this tutorial Part 1 and Part 2.

In R, decision tree algorithm can be implemented using rpart package. In addition, we’ll use caret package for doing cross validation. Cross validation is a technique to build robust models which are not prone to overfitting. Read more about Cross Validation.

In R, decision tree uses a complexity parameter (cp). It measures the tradeoff between model complexity and accuracy on training set. A smaller cp will lead to a bigger tree, which might overfit the model. Conversely, a large cp value might underfit the model. Underfitting occurs when the model does not capture underlying trends properly. Let’s find out the optimum cp value for our model with 5 fold cross validation.

#loading required libraries

> library(rpart)

> library(e1071)

> library(rpart.plot)

> library(caret)

#setting the tree control parameters

> fitControl <- trainControl(method = "cv", number = 5)

> cartGrid <- expand.grid(.cp=(1:50)*0.01)

#decision tree

> tree_model <- train(Item_Outlet_Sales ~ ., data = new_train, method = "rpart", trControl = fitControl, tuneGrid = cartGrid)

> print(tree_model)

The final value for cp = 0.01. You can also check the table populated in console for more information. The model with cp = 0.01 has the least RMSE. Let’s now build a decision tree with 0.01 as complexity parameter.

> main_tree <- rpart(Item_Outlet_Sales ~ ., data = new_train, control = rpart.control(cp=0.01))

> prp(main_tree)

Here is the tree structure of our model. If you have gone through the basics, you would now understand that this algorithm has marked Item_MRP as the most important variable (being the root node). Let’s check the RMSE of this model and see if this is any better than regression.

> pre_score <- predict(main_tree, type = "vector")

> rmse(new_train$Item_Outlet_Sales, pre_score)

[1] 1102.774

As you can see, our RMSE has further improved from 1140 to 1102.77 with decision tree. To improve this score further, you can further tune the parameters for greater accuracy.

Random Forest

Random Forest is a powerful algorithm which holistically takes care of missing values, outliers and other non-linearities in the data set. It’s simply a collection of classification trees, hence the name ‘forest’. I’d suggest you to quickly refresh your basics of random forest with this tutorial.

In R, random forest algorithm can be implement using randomForest package. Again, we’ll use train package for cross validation and finding optimum value of model parameters.

For this problem, I’ll focus on two parameters of random forest. mtry and ntree. ntree is the number of trees to be grown in the forest. mtry is the number of variables taken at each node to build a tree. And, we’ll do a 5 fold cross validation.

Let’s do it!

#load randomForest library

> library(randomForest)

#set tuning parameters

> control <- trainControl(method = "cv", number = 5)

#random forest model

> rf_model <- train(Item_Outlet_Sales ~ ., data = new_train, method = "parRF", trControl = control,

prox = TRUE, allowParallel = TRUE)

#check optimal parameters

> print(rf_model)

If you notice, you’ll see I’ve used method = “parRF”. This is parallel random forest. This is parallel implementation of random forest. This package causes your local machine to take less time in random forest computation. Alternatively, you can also use method = “rf” as a standard random forest function.

Now we’ve got the optimal value of mtry = 15. Let’s use 1000 trees for computation.

#random forest model

> forest_model <- randomForest(Item_Outlet_Sales ~ ., data = new_train, mtry = 15, ntree = 1000)

> print(forest_model)

> varImpPlot(forest_model)

This model throws RMSE = 1132.04 which is not an improvement over decision tree model. Random forest has a feature of presenting the important variables. We see that the most important variable is Item_MRP (also shown by decision tree algorithm).

This model can be further improved by tuning parameters. Also, Let’s make out first submission with our best RMSE score by decision tree.

> main_predict <- predict(main_tree, newdata = new_test, type = "vector")

> sub_file <- data.frame(Item_Identifier = test$Item_Identifier, Outlet_Identifier = test$Outlet_Identifier, Item_Outlet_Sales = main_predict)

> write.csv(sub_file, 'Decision_tree_sales.csv')

When predicted on out of sample data, our RMSE has come out to be 1174.33. Here are some things you can do to improve this model further:

-

Since we did not use encoding, I encourage you to use one hot encoding and label encoding for random forest model.

-

Parameters Tuning will help.

-

Use Gradient Boosting.

-

Build an ensemble of these models. Read more about Ensemble Modeling.

Do implement the ideas suggested above and share your improvement in the comments section below. Currently, Rank 1 on Leaderboard has obtained RMSE score of 1137.71. Beat it!

End Notes

This brings us to the end of this tutorial. Regret for not so happy ending. But, I’ve given you enough hints to work on. The decision to not use encoded variables in the model, turned out to be beneficial until decision trees.

The motive of this tutorial was to get your started with predictive modeling in R. We learnt few uncanny things such as ‘build simple models’. Don’t jump towards building a complex model. Simple models give you benchmark score and a threshold to work with.

In this tutorial, I have demonstrated the steps used in predictive modeling in R. I’ve covered data exploration, data visualization, data manipulation and building models using Regression, Decision Trees and Random Forest algorithms.

Did you find this tutorial useful ? Are you facing any trouble at any stage of this tutorial ? Feel free to mention your doubts in the comments section below. Do share if you get a better score.

Edit: On visitor’s request, the PDF version of the tutorial is available for download. You need to create a log in account to download the PDF. Also, you can bookmark this page for future reference. Download Here.

- 59 次浏览

【数据科学】内部发展数据科学技能:真实世界的经验教训

视频号

微信公众号

知识星球

各组织正在向内看,以满足数据科学的需求,发展必要的文化、课程和计划,以深化数据分析专业知识。

几乎每个行业的公司都非常需要数据科学家,因为他们希望启动大数据和分析项目,并从数据资源中获得更多价值和见解。

然而,对这些专业人员的需求继续以相当大的幅度超过供应,而且没有迹象表明这种情况会很快改变。

在线就业网站CareerCast.com将数据科学家列为2018年最佳工作之一,预计今年的需求将增长19%。CareerCast评估了美国劳工统计局关于增长前景、行业招聘趋势、贸易统计、大学毕业生就业数据以及该网站自己的列表数据库的数据,以确定哪些因素推动了招聘需求。

就需求而言,数据科学专业经常跻身于顶级职业之列,组织需要专业地分析数据并将其转化为可操作的信息,这推动了数据科学行业的增长。

对于许多组织来说,填补这些职位的斗争是激烈的。从外部聘请专家当然可以成为建立数据科学团队战略的一部分,但考虑到极端的竞争,一些组织正在转向自己的队伍来培养他们需要的数据科学人才。

以下是一些组织如何鼓励数据驱动的文化,并在内部发展更深入的数据分析专业知识。

在嘉年华培养数据驱动的文化

数据科学是嘉年华风险咨询和保证服务部的战略重点,该部门运营嘉年华邮轮。该部门经理Daniel Bukowski表示,该部门提供内部审计服务,其领导层有力地支持了该领域的专业发展和培训。

例如,该部门支持Bukowski参加Udacity预测分析纳米学位课程,他有审计和会计背景,但没有受过IT或技术知识的正规教育。Udacity在人工智能、数据科学、编程与开发以及自主系统等领域提供了一系列在线高等教育项目。

Bukowski说:“该部门的许多其他审计员看到了数据分析的重要性,并正在寻求领导力支持的培训”,包括如何使用Alteryx、Tableau等供应商的分析工具。他说,该部门2018年7月的年度务虚会包括一次关于数据可视化的外部培训课程和一个关于审计相关数据分析举措的内部培训计划。

审计部门的两名数据科学家被聘为数据科学家。然而,该部门赞助的培训帮助Bukowski和其他几位审计员提高了数据素养,并能够将数据分析概念应用于审计和调查。

Bukowski说:“并不是所有的审计师都需要成为数据科学家,但他们必须具备数据素养。”。他又迈出了一步,报名参加了科学硕士数据分析项目,“因为我看到了数据在我的职业生涯中有多么重要,”他说。

随着数据科学/分析方面的额外教育,Bukowski的角色在过去12个月里从主要执行个人审计和调查演变为为为执行自己审计和调查的同事提供数据分析支持。

使用各种分析工具,Bukowski可以混合和分析大型数据集,而他的同事只能使用Excel电子表格。他说:“这导致了对Excel中较小数据集的分析不太可能发现的多次审计结果。”。

Bukowski表示,审计部门正在根据审计结果启动咨询项目,为嘉年华及其运营公司提供额外的分析驱动价值。

在SessionM让工程师参与数据科学工作

提供客户数据和参与平台的SessionM正在创建一个由专门的数据科学工程师(DSE)组成的团队,负责设计和编写用于生产的人工智能(AI)软件。SessionM负责数据科学、人工智能和机器学习的副总裁Amelio Vázquez Reina表示,这些人对机器学习(ML)、统计学和决策理论都很了解。

Vázquez-Reina表示,他们的主要职责是自动生成见解、预测和建议,并构建软件产品,为整个公司的决策提供自动执行。

Vázquez Reina表示,除了开发正式的DSE外,SessionM还有几项举措来帮助公司提高数据科学素养。他说:“我们定期与其他部门举行会议,要求DSE向我们的销售、业务分析师、产品和解决方案体系结构团队解释他们的数据模型和解决方案。”。

这些会议有两个目标。一个是向员工介绍SessionM的数据科学战略、方法和最佳实践。另一个是帮助公司的每个人理解并宣传其所谓的人工智能“价值生成链”。这是一个过程,包括从每个客户那里收集数据,明确规定客户目标,并强调软件开发的实验,以最大限度地为客户带来结果和见解。

此外,该公司还为软件工程师提供机会,通过其敏捷开发流程和为客户提供的数据科学服务,为其数据科学软件做出贡献。SessionM还举办以人工智能为中心的会议和社交活动。

“这些会议以描述公司感兴趣的问题的SessionM DSE的技术演示开始,然后对该问题进行数学表征,该问题适合公司的所有[软件工程师],最后围绕所选择的解决方案、实施以及在此过程中探索的任何权衡和替代方案进行开放式讨论。”

Ogury培养数据科学人才

Ogury是一家提供移动数据技术的公司,据该公司首席技术官Louis-Marie Brierre介绍,该公司每天接收的数据超过1TB。要获得处理如此大量信息的资源、技能和能力,需要一支敬业且才华横溢的数据科学团队。维持这样一个团队的关键之一是创造一个有吸引力的工作场所。

Brierre说:“我们激励团队的最佳方式是给他们学习和控制个人成长的空间。”。“我们授权我们的数据团队拥有和管理他们的项目,并承担全部责任。”

该公司的数据科学家与数据工程师以及开发和产品团队密切合作。Brierre说:“这让他们了解了业务,并使他们能够了解自己在公司中的角色和影响。”。“我们从不限制他们正在操纵的数据的计算能力以及他们想要测试的想法。”

Brierre说,由于项目和团队的多样性,“我们喜欢挑战人们,并通过每12或18个月加入一个新的部门为他们提供新的增长途径。”。“这让他们有机会离开舒适区,发现新的团队合作伙伴和项目。”

Ogury还致力于保持其数据科学家训练有素。

Ogury首席算法官Christophe Thibault表示:“我目睹了许多公司急切地等待新数据科学家的到来。”。“这些公司相信,他或她会来拯救他们的业务,提高所有(绩效指标)。是的,数据科学家和分析师是组织中的关键人物,但他们仍然需要像其他有价值的团队成员一样得到培养和培训。”

Thibault说,为了建立一支数据科学家团队,公司必须培养优秀的人才。“但他们也有责任为他们的到来做好组织准备,并为他们的成功做好准备,”他说。

自2014年以来,Ogury采取了几种做法来吸引和留住数据科学家。一个是消除技术限制。Thibault说:“我们所有的数据科学家都可以访问云上的沙盒环境,这样他们就可以测量自己的计算能力,并将其与他们正在操纵的数据和他们想要测试的想法进行全面比较。”。

另一个是鼓励合作。Thibault说,数据科学家和数据工程师拥有不同的技能和词汇。但对于一个组织的数据分析工作来说,他们一起工作和合作是至关重要的。“一个组织内知识的自由流动是企业蓬勃发展的方式,”他说。

第三种做法是将算法与数据相匹配,而不是相反。Thibault表示:“数据科学家与商业分析师密切合作,以了解数据。”。“尤其是在Ogury,我们有独特的、细粒度的第一方数据,数据科学家需要时间来理解信息。最重要的是,我们的团队必须确保他们使用的算法能够完美地拟合数据,而不是仅仅因为这是一条简单的出路就扭曲数据以将其拟合到众所周知或预先确定的算法中。”

美光协助获得高级学位

持续的学习和教育是计算机存储器技术提供商美光的首要任务。美光首席信息官Trevor Schulze表示:“由于许多数据科学都需要深入掌握统计学和机器学习,(公司)支持许多人在这一领域攻读高级学位。”。

此外,舒尔茨说,美光的员工发现大规模的在线开放课程(MOOC)有助于巩固某些技能。该公司还通过支持出席外部和内部会议和在会议上发言,向同行学习。

美光在世界各地的数据科学团队中雇佣了数百名员工。舒尔茨说,这些团队中约有一半的数据科学家来自公司的不同岗位,通常是工程部门。

舒尔茨说:“当人们有强大的数据基础、好奇和探索的心态,最关键的是掌握统计学和机器学习方法的能力时,就会成功地向数据科学过渡。”。“这些人在正规、高级教育中可能缺乏的东西,他们往往会在工业和数据知识方面弥补。”

数据科学的兴起对公司产生了巨大的影响。舒尔茨说:“三十多年来,机器人和计算机自动化一直是开发和生产下一代存储芯片的关键推动者。”。“然而,仅靠自动化已经无法推动行业向前发展。随着数据科学成为许多制造流程和商业决策的核心,美光正在发生真正的变革。”

在McAfee的指导并将培训作为首要任务

安全技术公司McAfee创建了一个卓越分析中心(ACE),其框架包括价值主张、宣传(包括培训和指导)、模型/算法和数据管理。该公司首席数据科学家Celeste Fralick表示,这得到了首席技术官和主要副总裁的支持。

为了实现该框架,ACE参与者定期安排关于算法的“技术讲座”;McAfee创建了八个实践社区,即教育、人力资源、工业/学术合作等领域的工作组。它还成立了技术工作组,如分析审查委员会、对抗性机器学习和分析门户网站。

ACE是全球性的,拥有150多名来自公司各个技能水平的人员。Fralick说:“我们现在正在制定一个辅导计划和一个关于数据货币化的短期课程,并探讨管理人员等非数据科学家可以提出的关于算法和模型开发的问题。”。

此外,McAfee还赞助了深入的培训,包括分析、清洁和预处理数据的介绍,以及模型和机器学习的介绍。

Fralick说:“虽然我们不教授‘工具’本身,但我们教授的是一般的‘窍门’和特定主题的概念。”。“工具会改变,但数学和可能破坏算法的陷阱通常不会改变。”

Fralick说,这些努力是故意缓慢而自愿地开始的,目的是在非对抗性的氛围中获得最初的积极影响。她说,对课程的需求猛增。

Fralick说:“我们还推荐特定的外部课程、书籍以及学位或证书课程。”。“我们发现,计算机科学家通常没有被教授数据科学的关键要素。当他们得到信息时,他们会热情地回应,明白数据不仅仅是收集和快速应用模型。开发成功的分析还有更多的工作要做。”

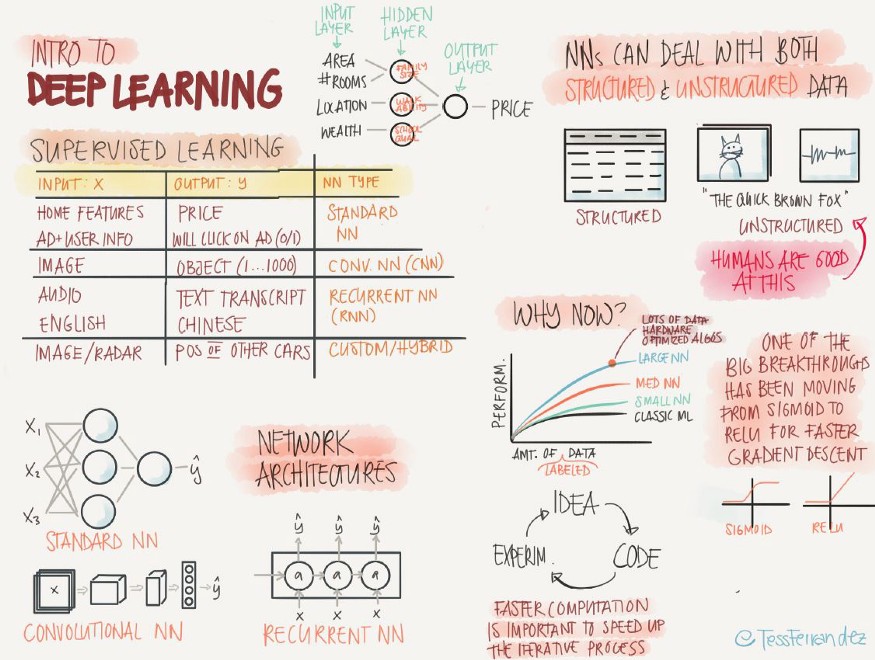

Fralick说,对于训练有素的数据科学家来说,项目“正在知识和智能的金字塔上向上发展,从统计学到机器学习,从深度学习到人工智能”。“由于机器驱动的算法增强了人类的决策,因此人机团队在这一过程中至关重要。”

具体的分析开发需求正在集成到软件产品生命周期中。Fralick说:“我们打算让公司里的每个人都上一门分析入门课程。”。“数据科学工作对组织和我们的业务/数据战略的总体影响已经随着更高的数据量、客户期望和数据融合而凝结,以使我们的业务能够以数据和模型为驱动。”

在Ibotta,课程和合作

在过去的两年里,移动购物应用程序开发商Ibotta通过正式和非正式的培训,在组织内部建立了一个分析团队。

该团队开发了为期六周的SQL、Python和Spark课程,以及关于有效沟通分析结果的技巧和窍门、频率学家与贝叶斯统计的利弊以及利用TensorFlow构建神经网络等主题的简短入门培训课程。

数据分析和科学副总裁Laura Spencer表示:“此外,我们每两周举行一次头脑风暴会议,团队成员在会上讨论和构思各种分析和数据科学主题,以及如何在整个公司利用这些主题。”。

该公司还高度重视具有不同技能的分析师之间的合作项目,以鼓励分享技能、能力和限制。

Spencer说:“例如,我们最近与营销分析、机器学习和用户研究方面的专家进行了一次保留深度挖掘,为业务建立[推荐]。”。“我们还采取了一些举措,鼓励员工继续从外部学习,并将新的工具和方法带回团队。”

Ibotta在其总部附近主持并出席各种大数据和数据科学会议。Spencer说:“我们还赞助每一位数据科学家每年参加他们选择的会议,作为回报,他们会向组织的其他成员提供会议学习的培训。”。

在过去的几年里,Ibotta的分析团队已经发展到大约45人,包括数据工程、统计学和机器学习等技能。

- 19 次浏览

【数据科学】反思十年数据科学和可视化工具的未来

数据科学在过去十年中呈爆炸式增长,改变了我们开展业务的方式,并让下一代年轻人为未来的工作做好准备。但是这种快速增长伴随着对数据科学工作的不断发展的理解,这导致我们在如何使用数据科学从我们的大量数据中获得可操作的见解方面存在很多模糊性。在数据科学的发展塑造了我自己的职业生涯之后,我想深入研究什么是数据科学、数据科学的工作是什么以及谁是数据科学家等问题。我翻阅了研究文献,以提取关于数据科学和数据科学家的各种研究和分析的线索,将这些问题的答案编织在一起。我在一篇题为“传递数据指挥棒:对数据科学工作和工作者的回顾性分析”的研究出版物中介绍了这些结果。

这项研究的部分动机是作为研究和开发的基础,以便我可以确定可视化分析工具可能解决未满足需求的领域。然而,另一个动机是对一个十多年前我第一次开始计算机科学高级研究时还不存在的领域的个人反思。在这篇博文中,我总结了这篇研究论文的几个关键要点,并分享了我对它的发现如何帮助我们为数据科学构建下一代数据可视化工具的想法。

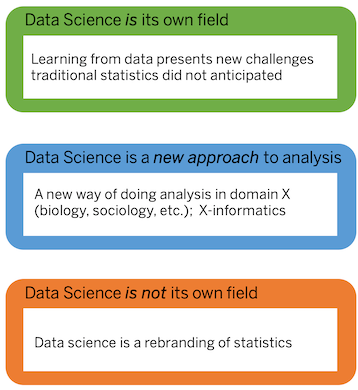

什么是数据科学?

事实证明,数据科学对不同的人来说是不同的东西。对某些人来说,数据科学并不是什么新鲜事物,它只是已经存在很长时间的统计技术的实际应用。对其他人来说,这种观点过于狭隘,因为数据科学不仅需要统计方法的知识,还需要计算技术才能使这些方法的应用变得实用。例如,数据科学家仅了解线性回归是不够的,他们还需要知道如何将其大规模应用于大量数据——这不是传统统计学教育的一部分。尽管如此,即使是那些认为数据科学不仅仅是应用统计学的人也可能会犹豫说它是新事物。收集和分析数据(甚至是大量数据)的做法长期以来一直是科学研究的一部分,例如生物学或物理学;许多人认为数据科学只是经验科学中已经发生的事情的延伸。

但这里还有第三种观点,即数据科学确实是新事物,既不同于统计学,也不同于科学家在研究原子和基因时使用的方法。将统计学和计算机科学与必要的主题专业知识结合在一起,带来了新的挑战,这些挑战由数据科学独特地解决,并由数据科学家解决。此外,数据科学家开展的工作不同于其他类型的数据分析,因为它需要更广泛的多学科技能。我们的研究和其他人的研究认为,数据科学确实是新的和不同的东西,因此我们创建了一个工作定义,作为我们工作的基础:

“数据科学是一个多学科领域,旨在通过主要统计和计算技术的结构化应用, 从现实世界的数据中学习新的见解”

这个定义很重要,因为它有助于我们理解数据科学工作者面临的挑战和未满足的需求,这主要源于使用真实数据而不是模拟数据的挑战,以及伴随应用统计和计算方法的挑战这些数据大规模。

什么是数据科学工作?

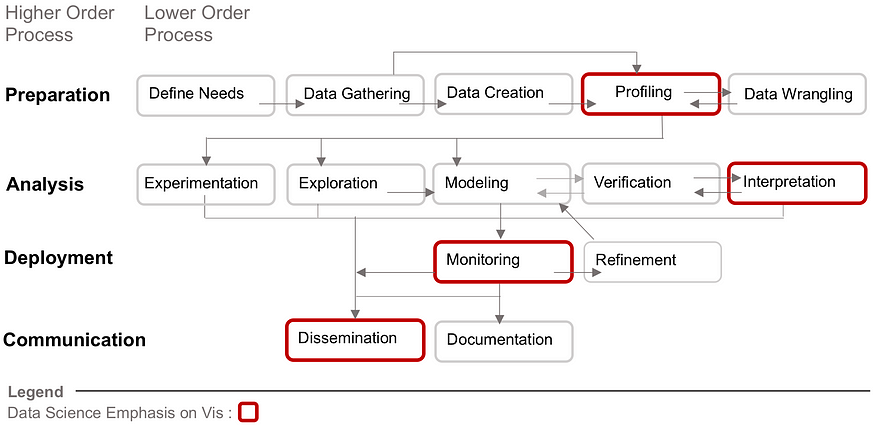

- 将数据科学工作提炼成四个高阶(准备、分析、部署和通信)和 14 个低阶过程。 红色标出的过程是主要使用数据可视化的过程,但这并不排除它在数据科学工作的其他方面的使用。

重要的是,数据科学的工作定义缩小了研究范围。我们没有考虑人们可能希望进行的所有可能类型的数据分析,而是仔细研究数据科学家进行的分析类型。这种区别很重要,因为实验物理学家分析数据所采取的具体步骤与数据科学家可能采取的分析步骤不同,即使它们有共同点。这导致了一个重要的后续问题:数据科学的工作到底是什么?

有几个行业标准用于分解数据科学工作。第一个是 KDD(或数据发现中的知识)方法,随着时间的推移,它被其他人修改和扩展。根据这些推导以及采访数据科学家的研究,我们创建了一个框架,该框架具有四个高阶流程(准备、分析、部署和通信)和 14 个低阶流程。使用红色笔划轮廓,我们还强调了数据可视化已经在数据科学工作中发挥重要作用的特定领域。在我们的研究文章中,我们提供了这些过程的详细定义和示例。

谁是数据科学工作者?