PostgreSQL架构

视频号

微信公众号

知识星球

- 340 次浏览

【PostgreSQL 】PostgreSQL 12的8大改进

PostgreSQL 12专注于性能和优化。此版本的发布并未考虑到全新的闪亮功能;相反,它是对现有PostgreSQL功能的微调和精心设计的实现。因为PostgreSQL每年都会发布新版本,所以并不是每一个新功能都完全具备。在发布了几个版本之后,当该功能有机会从其最初的实现中发展出来时,其性能将得到改善,边缘情况将得到支持,缺失的功能将得到实现。

这是PostgreSQL 12中发现的八个最重要的改进。

1.分区性能

分区并不是一项新功能,它已经存在了好几年了,但是分区开销却降低了性能。 PostgreSQL 11引入了一些分区性能改进,而PostgreSQL 12提供了完善的实现。对于从具有数千个分区的其他数据库迁移来的用户,PostgreSQL 12现在通过提供可同时有效处理数千个分区的功能而带来性能优势。分区性能增强可以提高查询性能,尤其是INSERT和COPY语句的性能。此外,用户现在可以更改分区表而不会阻止查询,并可以使用外键引用分区表。

2. B树增强

B-Tree功能是近年来对PostgreSQL添加的最复杂的功能之一。使用B树的好处是减少了访问的磁盘块的数量。考虑到B-Tree技术可以追溯到1970年代,很难对已经存在数十年的可靠功能进行改进。但是PostgreSQL 12团队致力于提供可自动启用的重大性能改进,旨在避免某些极端情况和B树代码中曾经存在的“病理行为”。现在,通过更有效地利用空间,多列索引大小最多可减少40%,从而节省了磁盘空间。具有重复项(非唯一B树索引)的索引的性能得以提高,并且从索引中删除元组(行)的真空运行效率更高。此外,索引更新期间的锁定要求有所降低。

3.多列最有价值(MCV)统计信息

此更新已经进行了几年的开发,旨在解决多年来引起投诉的问题:查询中相关列的边缘情况。以俄亥俄州辛辛那提为例-您有一个标记为“城市”的字段,另一字段称为“州”,其中“辛辛那提”位于一列,而俄亥俄州则在另一列。俄亥俄州的辛辛那提市将相当普遍,但亚利桑那州的辛辛那提市却很少见。在此功能之前,PostgreSQL仅记录了多个列的单个相关值。从本质上讲,它将俄亥俄州的辛辛那提和亚利桑那州的辛辛那提视为同一件事。现在,您可以比较多个列并关联组合以优化查询索引。

4.公用表表达式(CTE)

正确实现的另一个过期功能是通用表表达式(带有查询内联)。公用表表达式充当优化障碍,公用表表达式中的查询首先执行,然后PostgreSQL将在查询中执行之后的任何操作。一些用户采用通用表表达式来提高SQL的可读性和调试,而不是优化SQL的执行。这些用户不可避免地会遇到优化行为。 PostgreSQL 12使用关键字“ MATERIALIZE”实现了一项新功能,该功能允许用户打开优化围栏。如果您不使用MATERIALIZE,则不会获得优化范围,并且可能会看到更快的查询。

5.准备好的计划控制

一项重要的新功能使用户可以控制PostgreSQL优化器的行为,并有可能提高性能。早期版本的PostgreSQL将使用自定义计划五次,第六次创建一个通用计划,并在与自定义计划一样好的情况下使用它。现在,可以通过名为“ plan_cache_mode”的新变量手动控制此行为,该变量允许用户立即强制执行通用计划。这为那些知道其参数恒定并且知道通用计划将起作用的用户带来了显着的性能优势。

6.即时编译

PostgreSQL 11最初引入的一项功能是现在在PostgreSQL 12中默认启用即时复杂功能。即时编译允许处理大量数据的数据仓库查询来更有效地运行执行程序。由于许多用户启用了此功能,因此该功能现已成为PostgreSQL 12的默认功能。

7.校验和控制

追溯到2013年,PostgreSQL引入了一种校验和功能,用于识别数据损坏。首次初始化数据库时必须打开此功能,否则用户必须转储,打开该功能并重新加载数据。这使得某些用户几乎无法使用该功能。在PostgreSQL 12中,通过一个称为“ pg checksums”的命令(以前称为pg verify checksum),用户可以在不转储和重新加载数据的情况下将群集从无校验和更改为校验和。当前,在此更改期间,群集必须处于脱机状态,但是正在开发联机校验和支持。

8.并发重新编制索引

索引并发功能已经存在多年,允许用户创建索引而又不阻止写入索引。重新索引不允许您在写入数据库时创建索引。同时使用reindex,通过在同一位置创建新索引来替换现有索引。同时使用Reindex可以写入索引并保留原始索引名称。显然,当替换索引时,最小的锁定将发生,直到实现替换为止。长期以来要求的功能很难开发,但最终在PostgreSQL 12中交付。

升级到PostgreSQL 12

这八个功能只是PostgreSQL 12中许多改进中的几个。从分区改进到公用表表达式的实现,PostgreSQL 12提供了显着的可用性增强,将使许多新用户和长期用户满意。

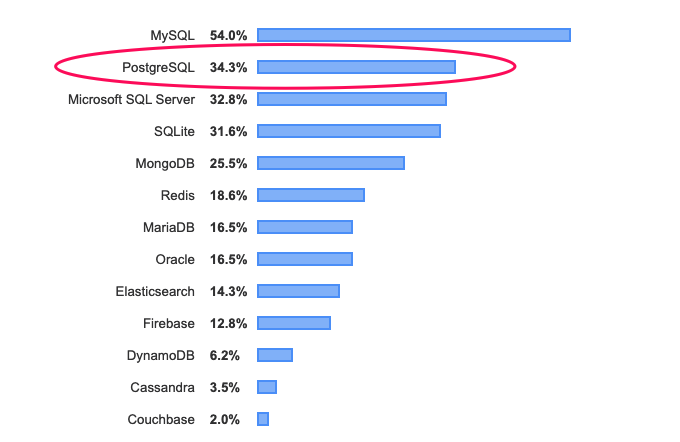

Postgres已成为数据库领域的巨头。 根据2019年Stack Overflow对近90,000名开发人员的调查,Postgres的部署现在比SQL Server部署得更为普遍。

原文:https://www.enterprisedb.com/ko/blog/8-major-improvements-postgresql-12

本文:http://jiagoushi.pro/8-major-improvements-postgresql-12

讨论:请加入知识星球或者微信圈子【首席架构师圈】

- 69 次浏览

【PostgreSQL 】PostgreSQL 16扩展分析功能

视频号

微信公众号

知识星球

最近的版本还包括对支持新体系结构的逻辑表示和超级用户权限的改进。

最近发布的PostgreSQL 16之所以意义重大,原因有很多。它实现了更灵活的访问控制机制,这对涉及托管服务提供商(MSP)的部署具有直接影响。

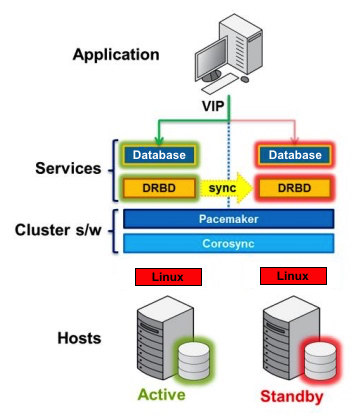

EnterpriseDB(EDB)高级产品经理Adam Wright肯定道,版本16还支持热备用功能,当它作为逻辑复制的源时,它能够“允许新的体系结构”。EDB是PostgreSQL 16(一个开源关系数据库管理系统)最重要的代码贡献者之一。

然而,最重要的是,最新版本的PostgreSQL包含了分析功能,用于促进复杂的聚合和窗口查询。当与数据库分别用于管理地理空间数据和矢量数据的扩展相结合时,这种增强可能是事务数据库与分析相关性日益增强的最新指标。

“我认为你开始看到的是,对专业数据仓库的需求开始降低,”Wright反思道。“在数据仓库市场的极端,拥有专业系统是必要的。但这真的开始成为极端,在很多用例中,你可以只使用Postgres,而不需要专业系统。”

分析

尽管PostgreSQL在事务系统中被广泛使用,但它在版本16中实现了Wright所说的“任意值函数”,具有明确的分析含义。此函数是SQL:2023标准的一部分。“这个函数实际上主要用于分析数据库,”Wright透露。“复杂的聚合/窗口查询是一种可以用来做什么的副标题。”

这个特殊的函数允许管理员和开发人员跨表中的一组行进行计算。Wright解释道:“你可以比较一行与另一行的计算方式,并对这两行进行汇总。”。“因此,可以通过几行SQL轻松地获得一个运行总数。”这一功能对于比较零售中库存订购的产品类型等用例很有价值,尤其是在大表中表示的不同位置。

向量和地理空间数据

根据Wright的说法,在数据库级别管理此任务通常比在应用程序级别更高效。使用后一种方法,管理员或开发人员将不得不编写比其他方法更多的代码,以及编写多个函数。然后,他们必须将数据带回并进行比较,而不是从数据库服务器中过滤所有内容。然而,“如果我在数据库服务器上编写这个聚合查询,我会比较表中的不同行,”Wright提到。“一旦全部完成,我将只流式传输应用程序所需的记录。”

PostgreSQL扩展PostGIS使用户能够存储和查询地理空间数据。Wright引用了另一个用于管理矢量工作负载的扩展,包括存储矢量数据和支持矢量运算符。Wright评论道:“这只是Postgres中的另一个用例,你不需要去找专业数据库供应商,获得另一份合同和另一份支持,也不需要加入任何你可能需要的东西来实际支持这些工作负载。”

逻辑复制

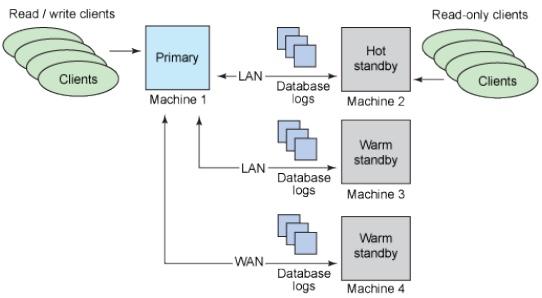

尽管Wright提到的扩展不是PostgreSQL 16中发布的新功能的一部分,但它们证明了数据库日益增长的分析实用性,这与最近发布的聚合和窗口功能不谋而合。Wright表示,新版还包括对其逻辑复制功能的增强,其中最重要的是“您可以从备用服务器中进行逻辑表示”。有了这种范式,用户可以从Wright所说的热备用中进行逻辑表示,他将其描述为将PostgreSQL数据中的每一个更改物理复制到目标系统——通常是为了实现高可用性。

Wright观察到:“有了逻辑表示,你可能只想复制几个表、一个销售表、一份订单表,并将它们提供给这些不同的系统,而不是从数据库中获取所有更改。”。逻辑表示使用户能够指定要复制的表,当与从备用系统进行复制的能力相结合时,可以广泛扩展复制和体系结构方法的可能性。Wright说:“你可以级联多个复制和类似的事情。”。“你可以在一个系统中做任何事情,但也可以更容易地从Postgres中获取数据子集,进入只读系统……由于这些原生功能,将支持更多的体系结构。”

超级用户改进

PostgreSQL 16还增强了与超级用户相关的控制程度和范围,超级用户拥有相当多的数据和系统访问权限。Wright承认,在以前的版本中,超级用户几乎可以做任何事情,包括篡改底层的“作为Postgres运行的服务的操作系统”。“这对托管数据服务来说是个大问题。”因此,托管服务提供商(包括一些超规模提供商)会将数据库、用户和设置从原始集群“分叉”或复制到另一个集群。

根据Wright的说法,这个过程可能会导致“错误和安全问题”。因此,最新版本的PostgreSQL中更精细的超级用户控件使“你能够对权限进行细粒度管理,并委托DBA管理数据库所需的任务,但不会给他们一些东西,让他们脱离数据库,”Wright说。或者,您可以管理一个角色,但不一定要管理该角色的数据

数据库空间

PostgreSQL 16的新增内容在很大程度上表明了正在影响整个数据库空间的发展。传统上用于事务目的的系统正在承担更多的分析责任。PostgreSQL对用于编写聚合和窗口查询的聚合函数的原生支持,以及对与地理空间和矢量数据相关的工作负载的扩展,可能预示着未来事务数据库和分析数据库之间的传统区别不再那么明显。

- 24 次浏览

【PostgreSQL 】PostgreSQL 中的并行性

PostgreSQL 是最好的对象关系数据库之一,它的架构是基于进程而不是基于线程的。虽然几乎所有当前的数据库系统都使用线程进行并行处理,但 PostgreSQL 基于进程的架构是在 POSIX 线程之前实现的。 PostgreSQL 在启动时启动一个进程“postmaster”,之后每当有新客户端连接到 PostgreSQL 时都会跨越新进程。

在版本 10 之前,单个连接中没有并行性。诚然,来自不同客户端的多个查询由于进程架构而具有并行性,但它们无法从彼此之间获得任何性能优势。换句话说,单个查询串行运行并且没有并行性。这是一个巨大的限制,因为单个查询不能利用多核。 PostgreSQL 中的并行性是从 9.6 版开始引入的。从某种意义上说,并行性是单个进程可以有多个线程来查询系统并利用系统中的多核。这为 PostgreSQL 提供了查询内并行性。

PostgreSQL 中的并行性是作为涵盖顺序扫描、聚合和连接的多个功能的一部分实现的。

PostgreSQL 中的并行组件

PostgreSQL 中有三个重要的并行性组件。这些是进程本身、聚集器和工人。如果没有并行性,进程本身会处理所有数据,但是,当规划器决定查询或其一部分可以并行化时,它会在计划的可并行化部分中添加一个 Gather 节点,并生成该子树的一个 Gather 根节点。查询执行从进程(领导者)级别开始,计划的所有串行部分都由领导者运行。但是,如果对查询的任何部分(或全部)启用并允许并行性,则为它分配带有一组工作人员的收集节点。工作者是与需要并行化的部分树(部分计划)并行运行的线程。关系的块在线程之间划分,使得关系保持顺序。线程数由 PostgreSQL 配置文件中的设置控制。工作人员使用共享内存进行协调/通信,工作人员完成工作后,将结果传递给领导者进行积累。

并行顺序扫描

在 PostgreSQL 9.6 中,添加了对并行顺序扫描的支持。 顺序扫描是对表的扫描,其中依次评估一系列块。 就其本质而言,这允许并行性。 因此,这是第一个实现并行性的自然候选者。 在这种情况下,整个表在多个工作线程中被顺序扫描。 这是一个简单的查询,我们查询 pgbench_accounts 表行 (63165),它有 1,500,000,000 个元组。 总执行时间为 4,343,080ms。 由于没有定义索引,因此使用顺序扫描。 整个表在没有线程的单个进程中扫描。 因此,无论有多少内核可用,都使用 CPU 的单核。

db=# EXPLAIN ANALYZE SELECT *

FROM pgbench_accounts

WHERE abalance > 0;

QUERY PLAN

----------------------------------------------------------------------

Seq Scan on pgbench_accounts (cost=0.00..73708261.04 rows=1 width=97)

(actual time=6868.238..4343052.233 rows=63165 loops=1)

Filter: (abalance > 0)

Rows Removed by Filter: 1499936835

Planning Time: 1.155 ms

Execution Time: 4343080.557 ms

(5 rows)如果这 1,500,000,000 行在一个进程中使用“10”个工作人员并行扫描会怎样? 它将大大减少执行时间。

db=# EXPLAIN ANALYZE select * from pgbench_accounts where abalance > 0;

QUERY PLAN

----------------------------------------------------------------------

Gather (cost=1000.00..45010087.20 rows=1 width=97)

(actual time=14356.160..1628287.828 rows=63165 loops=1)

Workers Planned: 10

Workers Launched: 10

-> Parallel Seq Scan on pgbench_accounts

(cost=0.00..45009087.10 rows=1 width=97)

(actual time=43694.076..1628068.096 rows=5742 loops=11)

Filter: (abalance > 0)

Rows Removed by Filter: 136357894

Planning Time: 37.714 ms

Execution Time: 1628295.442 ms

(8 rows)现在总执行时间是1,628,295ms; 使用 10 个工作线程进行扫描时,这提高了 266%。

用于基准的查询:SELECT * FROM pgbench_accounts WHERE abalance > 0;

表大小:426GB

表中的总行数:1,500,000,000

用于基准测试的系统:

CPU:2 Intel(R) Xeon(R) CPU E5-2643 v2 @ 3.50GHz

内存:256GB DDR3 1600

磁盘:ST3000NM0033

上图清楚地显示了并行性如何提高顺序扫描的性能。添加单个工作人员时,性能会降低,这是可以理解的,因为没有获得并行性,但是创建额外的收集节点和单个工作会增加开销。但是,使用多个工作线程时,性能会显着提高。此外,重要的是要注意性能不会以线性或指数方式增加。它会逐渐改善,直到添加更多工人不会带来任何性能提升;有点像接近水平渐近线。该基准测试是在 64 核机器上执行的,很明显,拥有 10 名以上的工作人员不会带来任何显着的性能提升。

并行聚合

在数据库中,计算聚合是非常昂贵的操作。在单个过程中进行评估时,这些需要相当长的时间。在 PostgreSQL 9.6 中,通过简单地将它们分成块(分而治之的策略)添加了并行计算这些的能力。这允许多个工作人员在基于这些计算的最终值由领导者计算之前计算聚合的部分。从技术上讲,PartialAggregate 节点被添加到计划树中,每个 PartialAggregate 节点从一个工作人员那里获取输出。然后将这些输出发送到 FinalizeAggregate 节点,该节点组合来自多个(所有)PartialAggregate 节点的聚合。如此有效地,并行部分计划包括根处的 FinalizeAggregate 节点和将 PartialAggregate 节点作为子节点的 Gather 节点。

db=# EXPLAIN ANALYZE SELECT count(*) from pgbench_accounts;

QUERY PLAN

----------------------------------------------------------------------

Aggregate (cost=73708261.04..73708261.05 rows=1 width=8)

(actual time=2025408.357..2025408.358 rows=1 loops=1)

-> Seq Scan on pgbench_accounts (cost=0.00..67330666.83 rows=2551037683 width=0)

(actual time=8.162..1963979.618 rows=1500000000 loops=1)

Planning Time: 54.295 ms

Execution Time: 2025419.744 ms

(4 rows)以下是要并行评估聚合时的计划示例。 您可以在这里清楚地看到性能改进。

db=# EXPLAIN ANALYZE SELECT count(*) from pgbench_accounts;

QUERY PLAN

----------------------------------------------------------------------

Finalize Aggregate (cost=45010088.14..45010088.15 rows=1 width=8)

(actual time=1737802.625..1737802.625 rows=1 loops=1)

-> Gather (cost=45010087.10..45010088.11 rows=10 width=8)

(actual time=1737791.426..1737808.572 rows=11 loops=1)

Workers Planned: 10

Workers Launched: 10

-> Partial Aggregate

(cost=45009087.10..45009087.11 rows=1 width=8)

(actual time=1737752.333..1737752.334 rows=1 loops=11)

-> Parallel Seq Scan on pgbench_accounts

(cost=0.00..44371327.68 rows=255103768 width=0)

(actual time=7.037..1731083.005 rows=136363636 loops=11)

Planning Time: 46.031 ms

Execution Time: 1737817.346 ms

(8 rows)使用并行聚合,在这种特殊情况下,当涉及 10 个并行工作人员时,由于 2,025,419.744 的执行时间减少到 1,737,817.346,我们的性能提升了 16% 以上。

用于基准的查询:SELECT count(*) FROM pgbench_accounts WHERE abalance > 0;

表大小:426GB

表中的总行数:1500000000

用于基准测试的系统:

CPU:2 Intel(R) Xeon(R) CPU E5-2643 v2 @ 3.50GHz

内存:256GB DDR3 1600

磁盘:ST3000NM0033

并行索引(B-Tree)扫描

对 B-Tree 索引的并行支持意味着索引页面是并行扫描的。 B-Tree 索引是 PostgreSQL 中最常用的索引之一。 在 B-Tree 的并行版本中,worker 扫描 B-Tree,当它到达其叶节点时,它会扫描块并触发阻塞的等待 worker 扫描下一个块。

使困惑? 让我们看一个例子。 假设我们有一个包含 id 和 name 列的表 foo,有 18 行数据。 我们在表 foo 的 id 列上创建一个索引。 系统列 CTID 附加到表的每一行,用于标识该行的物理位置。 CTID 列中有两个值:块号和偏移量。

postgres=# <strong>SELECT</strong> ctid, id <strong>FROM</strong> foo; ctid | id --------+----- (0,55) | 200 (0,56) | 300 (0,57) | 210 (0,58) | 220 (0,59) | 230 (0,60) | 203 (0,61) | 204 (0,62) | 300 (0,63) | 301 (0,64) | 302 (0,65) | 301 (0,66) | 302 (1,31) | 100 (1,32) | 101 (1,33) | 102 (1,34) | 103 (1,35) | 104 (1,36) | 105 (18 rows)

让我们在该表的 id 列上创建 B-Tree 索引。

CREATE INDEX foo_idx ON foo(id)

假设我们要选择 id <= 200 且有 2 个工作人员的值。 Worker-0 将从根节点开始扫描,直到叶子节点 200。它将节点 105 下的下一个块移交给处于阻塞和等待状态的 Worker-1。如果还有其他工作人员,则将块划分为工作人员。重复类似的模式,直到扫描完成。

并行位图扫描

要并行化位图堆扫描,我们需要能够以非常类似于并行顺序扫描的方式在工作人员之间划分块。为此,对一个或多个索引进行扫描,并创建指示要访问哪些块的位图。这是由领导进程完成的,即这部分扫描是按顺序运行的。但是,当将识别出的块传递给工作人员时,并行性就会启动,这与并行顺序扫描中的方式相同。

平行连接

合并连接支持中的并行性也是此版本中添加的最热门功能之一。在这种情况下,一个表与其他表的内部循环哈希或合并连接。无论如何,内部循环不支持并行性。将整个循环作为一个整体进行扫描,当每个worker作为一个整体执行内部循环时,就会发生并行。每个连接发送到聚集的结果累积并产生最终结果。

概括

从我们已经在本博客中讨论过的内容可以明显看出,并行性可以显着提升某些情况的性能,而对另一些情况则略有提升,并且在某些情况下可能会导致性能下降。 确保正确设置了 parallel_setup_cost 或 parallel_tuple_cost,以使查询计划程序能够选择并行计划。 即使为这些 GUI 设置了较低的值,如果没有生成并行计划,请参阅 PostgreSQL 并行性文档以获取详细信息。

对于并行计划,您可以获得每个计划节点的每个工作人员的统计信息,以了解负载在工作人员之间的分布情况。 您可以通过 EXPLAIN (ANALYZE, VERBOSE) 做到这一点。 与任何其他性能特性一样,没有适用于所有工作负载的规则。 应根据需要仔细配置并行性,并且您必须确保获得性能的概率明显高于性能下降的概率。

原文:https://www.percona.com/blog/2019/07/30/parallelism-in-postgresql/

- 50 次浏览

【PostgreSQL 】PostgreSQL 简介

PostgreSQL,也称为Postgres,是一个免费的开源关系数据库管理系统(RDBMS),强调可扩展性和技术标准合规性。 它旨在处理各种工作负载,从单机到数据仓库或具有许多并发用户的Web服务。 它是macOS Server的默认数据库,[11] [12] [13],也适用于Linux,FreeBSD,OpenBSD和Windows。

PostgreSQL具有原子性,一致性,隔离性,耐久性(ACID)属性,自动可更新视图,物化视图,触发器,外键和存储过程的事务。[14] PostgreSQL由PostgreSQL全球开发小组开发,该小组是众多公司和个人贡献者的多元化小组。[15]

名称

PostgreSQL的开发人员将PostgreSQL称为/poʊstɡrɛsˌkjuːːl/。[16]它简称为Postgres,因为关系数据库中对SQL标准的支持无处不在。最初命名为POSTGRES,名称(Post Ingres)指的是该项目起源于加州大学伯克利分校的RDBMS。[17] [18]经过审查,PostgreSQL核心团队在2007年宣布该产品将继续使用PostgreSQL这个名称。[19]

历史

PostgreSQL是从加州大学伯克利分校的Ingres项目发展而来的。 1982年,Ingres团队的负责人Michael Stonebraker离开伯克利,制作了Ingres的专有版本。[17]他于1985年回到伯克利,并开始了一个后Ingres项目,以解决当代数据库系统的问题,这些系统在20世纪80年代早期变得越来越清晰。他在2014年为这些项目和其他项目赢得了图灵奖,[20]以及其中首创的技术。

新项目POSTGRES旨在增加完全支持数据类型所需的最少功能。[21]这些功能包括定义类型和完全描述关系的能力 - 广泛使用的东西,但完全由用户维护。在POSTGRES中,数据库理解关系,并且可以使用规则以自然的方式检索相关表中的信息。 POSTGRES使用了Ingres的许多想法,但没有使用它的代码。[22]

从1986年开始,已发表的论文描述了该系统的基础,并在1988年的ACM SIGMOD会议上展示了原型版本。该团队于1989年6月向少数用户发布了第1版,随后是1990年6月重新编写规则系统的第2版。1991年发布的第3版再次重写了规则系统,并增加了对多个用户的支持。存储管理器[引证需要]和改进的查询引擎。到1993年,随着支持和功能的要求,用户数量开始超过项目。 1994年6月30日发布版本4.2 [23]后 - 主要是清理 - 项目结束。 Berkeley在MIT许可证变体下发布了POSTGRES,这使得其他开发人员可以将代码用于任何用途。当时,POSTGRES使用了受Ingres影响的POSTQUEL查询语言解释器,该解释器可以与名为monitor的控制台应用程序交互使用。

1994年,伯克利大学的研究生Andrew Yu和Jolly Chen用一种SQL查询语言替换了POSTQUEL查询语言解释器,创建了Postgres95。监视器也被psql取代。 Yu和Chen于1995年5月5日向beta测试者宣布了第一个版本(0.01).Postgres95的1.0版本于1995年9月5日宣布,更加自由的许可证使软件可以自由修改。

1996年7月8日,Hub.org Networking Services的Marc Fournier为开源开发工作提供了第一个非大学开发服务器。[1]在Bruce Momjian和Vadim B. Mikheev的参与下,工作开始稳定从伯克利继承的代码。

1996年,该项目更名为PostgreSQL以反映其对SQL的支持。 PostgreSQL.org网站的在线展示始于1996年10月22日。[24]第一个PostgreSQL版本于1997年1月29日形成6.0版。从那时起,全世界的开发人员和志愿者都将该软件作为PostgreSQL全球开发组维护。[15]

该项目继续根据其免费和开源软件PostgreSQL许可证发布。代码来自专有供应商,支持公司和开源程序员的贡献。

多版本并发控制(MVCC)

PostgreSQL通过多版本并发控制(MVCC)管理并发,它为每个事务提供数据库的“快照”,允许在不影响其他事务的情况下进行更改。这在很大程度上消除了对读锁的需要,并确保数据库保持ACID原则。 PostgreSQL提供三个级别的事务隔离:Read Committed,Repeatable Read和Serializable。因为PostgreSQL不受脏读操作的影响,所以请求Read Uncommitted事务隔离级别提供read committed。 PostgreSQL通过可序列化快照隔离(SSI)方法支持完全可序列化。[25]

存储和复制

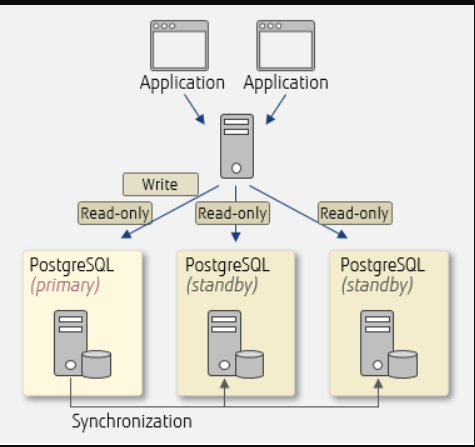

复制

PostgreSQL包括内置的二进制复制,它基于将更改(预写日志(WAL))异步传递到副本节点,并能够对这些复制节点运行只读查询。这允许有效地在多个节点之间分割读取流量。早期允许类似读取扩展的复制软件通常依赖于向主服务器添加复制触发器,从而增加负载。

PostgreSQL包含内置的同步复制[26],可确保对于每个写入事务,主服务器等待至少一个副本节点已将数据写入其事务日志。与其他数据库系统不同,可以按数据库,每用户,每会话甚至每个事务指定事务的持久性(无论是异步还是同步)。这对于不需要此类保证的工作负载非常有用,并且可能不需要所有数据,因为由于需要确认事务到达同步备用数据库而导致性能降低。

备用服务器可以是同步或异步的。可以在配置中指定同步备用服务器,以确定哪些服务器可用于同步复制。列表中第一个主动流式传输将用作当前的同步服务器。当此操作失败时,系统将故障转移到下一行。

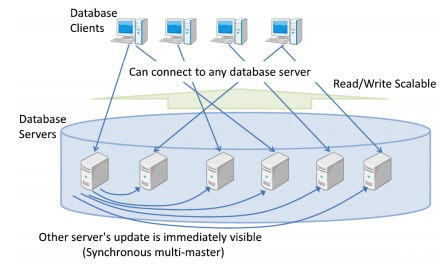

PostgreSQL核心中不包含同步多主复制。 Postgres-XC基于PostgreSQL,提供可扩展的同步多主复制。[27]它的许可与PostgreSQL相同。一个相关项目叫做Postgres-XL。 Postgres-R是另一个分支。[28]双向复制(BDR)是PostgreSQL的异步多主复制系统。[29]

repmgr等工具可以更轻松地管理复制集群。

有几个基于异步触发器的复制包可用。即使在引入扩展核心功能之后,对于完整数据库集群的二进制复制不合适的情况,这些仍然有用:

Slony聚-I

Londiste,SkyTools的一部分(由Skype开发)

Bucardo多主复制(由Backcountry.com开发)[30]

SymmetricDS多主,多层复制

索引

PostgreSQL包括对常规B树和散列表索引的内置支持,以及四种索引访问方法:广义搜索树(GiST),广义反向索引(GIN),空间分区GiST(SP-GiST)[31]和Block范围索引(BRIN)。此外,可以创建用户定义的索引方法,尽管这是一个非常复杂的过程。 PostgreSQL中的索引还支持以下功能:

可以使用表达式或函数的结果索引创建表达式索引,而不仅仅是列的值。

可以通过在CREATE INDEX语句的末尾添加WHERE子句来创建仅索引表的一部分的部分索引。这允许创建较小的索引。

规划器能够使用多个索引来使用临时内存位图索引操作来满足复杂查询(对于将大型事实表连接到较小维度表(例如以星型模式排列的那些),数据仓库应用程序非常有用)。

k-最近邻(k-NN)索引(也称为KNN-GiST [32])提供了对指定的“最接近的值”的有效搜索,对于查找相似的单词或用地理空间数据关闭对象或位置很有用。这是在没有穷尽的值匹配的情况下实现的。

仅索引扫描通常允许系统从索引获取数据,而无需访问主表。

PostgreSQL 9.5引入了块范围索引(BRIN)。

Schema

在PostgreSQL中,Schema包含除角色和表空间之外的所有对象。模式有效地像名称空间一样,允许同名对象在同一个数据库中共存。默认情况下,新创建的数据库具有名为public的模式,但可以添加任何其他模式,并且公共模式不是必需的。

search_path设置确定PostgreSQL检查非限定对象(没有前缀模式的对象)的模式的顺序。默认情况下,它设置为$ user,public($ user指当前连接的数据库用户)。此缺省值可以在数据库或角色级别设置,但由于它是会话参数,因此可以在客户端会话期间自由更改(甚至多次),仅影响该会话。

在对象查找期间,将以无提示方式跳过search_path中列出的不存在的模式。

在search_path中首先出现新的对象,无论哪个有效的模式(当前存在的模式)都出现.Schema是数据库的概要。

数据类型

支持各种本机数据类型,包括:

- 布尔

- 任意精度数值

- 字符(text,varchar,char)

- 二进制

- 日期/时间(时间戳/时间有/无时区,日期,间隔)

- 钱

- 枚举

- 位串

- 文字搜索类型

- 综合

- HStore,PostgreSQL中支持扩展的键值存储[33]

- 数组(可变长度,可以是任何数据类型,包括文本和复合类型),总存储大小最多为1 GB

- 几何图元

- IPv4和IPv6地址

- 无类别域间路由(CIDR)块和MAC地址

- 支持XPath查询的XML

- 通用唯一标识符(UUID)

- JavaScript Object Notation(JSON)和更快的二进制JSONB(自版本9.4起;与BSON [34]不同)

此外,用户可以创建自己的数据类型,通常可以通过PostgreSQL的索引基础结构 - GiST,GIN,SP-GiST完全索引。这些示例包括来自PostgreSQL的PostGIS项目的地理信息系统(GIS)数据类型。

还有一种称为域的数据类型,它与任何其他数据类型相同,但具有由该域的创建者定义的可选约束。这意味着使用域输入到列中的任何数据都必须符合作为域的一部分定义的任何约束。

可以使用表示一系列数据的数据类型,称为范围类型。这些可以是离散范围(例如,所有整数值1到10)或连续范围(例如,在上午10:00到11:00之间的任何时间)。可用的内置范围类型包括整数范围,大整数,十进制数,时间戳(有和没有时区)和日期。

可以创建自定义范围类型以使新类型的范围可用,例如使用inet类型作为基础的IP地址范围,或使用float数据类型作为基础的浮点范围。范围类型分别使用[/]和(/)字符支持包含和排除范围边界。 (例如,[4,9]表示从4开始包括但不包括9的所有整数。)范围类型也与用于检查重叠,包含,权限等的现有运算符兼容。

用户定义的对象

可以创建数据库中几乎所有对象的新类型,包括:

- 类型转换

- 转换

- 数据类型

- 数据域

- 功能,包括聚合函数和窗口函数

- 索引包括自定义类型的自定义索引

- 运营商(现有运营商可能超载)

- 程序语言

继承

可以将表设置为从父表继承其特征。子表中的数据似乎存在于父表中,除非使用ONLY关键字从父表中选择数据,即SELECT * FROM ONLY parent_table;。在父表中添加列将导致该列显示在子表中。

继承可用于实现表分区,使用触发器或规则将父表的插入指向正确的子表。

截至2010年,尚未完全支持此功能 - 特别是,表约束目前不可继承。父表上的所有检查约束和非空约束都由其子表自动继承。其他类型的约束(唯一,主键和外键约束)不会被继承。

继承提供了一种将实体关系图(ERD)中描述的泛化层次结构的特征直接映射到PostgreSQL数据库的方法。

其他存储功能

- 参照完整性约束,包括外键约束,列约束和行检查

- 二进制和文本大对象存储

- 表空间

- 每列整理

- 在线备份

- 使用预写日志记录实现的时间点恢复

- 使用pg_upgrade进行就地升级以减少停机时间(支持从8.3.x及更高版本升级)

控制和连接

外国数据包装器

PostgreSQL可以链接到其他系统,通过外部数据包装器(FDW)检索数据。[35]这些可以采用任何数据源的形式,例如文件系统,另一个关系数据库管理系统(RDBMS)或Web服务。这意味着常规数据库查询可以使用常规表等这些数据源,甚至可以将多个数据源连接在一起。

接口

PostgreSQL有几个可用的接口,并且在编程语言库中也得到广泛支持。内置接口包括libpq(PostgreSQL的官方C应用程序接口)和ECPG(嵌入式C系统)。外部接口包括:

- libpqxx:C ++接口

- Pgfe:C ++接口

- PostgresDAC:PostgresDAC(适用于Embarcadero RadStudio,Delphi,CBuilder XE-XE3)

- DBD :: Pg:Perl DBI驱动程序

- JDBC:Java数据库连接(JDBC)接口

- Lua:Lua接口

- Npgsql:.NET数据提供程序

- ST-Links SpatialKit:链接工具到ArcGIS

- PostgreSQL.jl:Julia界面

- node-postgres:Node.js接口

- pgoledb:OLE DB接口

- psqlODBC:打开数据库连接(ODBC)接口

- psycopg2:[36] Python接口(也被HTSQL使用)

- pgtclng:Tcl接口

- pyODBC:Python库

- php5-pgsql:基于libpq的PHP驱动程序

- 后现代:一个Common Lisp接口

- pq:Go数据库/ sql包的纯Go PostgreSQL驱动程序。驱动程序通过了兼容性测试套件。[37]

- RPostgreSQL:R接口[38]

- dpq:libpq的D接口

- epgsql:Erlang接口

- Rust-Postgres:Rust界面

程序语言

过程语言允许开发人员使用自定义子例程(函数)扩展数据库,通常称为存储过程。这些函数可用于构建数据库触发器(在修改某些数据时调用的函数)以及自定义数据类型和聚合函数。[39]在SQL级别使用DO命令,也可以在不定义函数的情况下调用过程语言。[40]

语言分为两组:用安全语言编写的程序是沙箱,可以由任何用户安全地创建和使用。以不安全语言编写的过程只能由超级用户创建,因为它们允许绕过数据库的安全限制,但也可以访问数据库外部的源。像Perl这样的语言提供了安全和不安全的版本。

PostgreSQL内置了对三种过程语言的支持:

普通的SQL(安全)。更简单的SQL函数可以内联扩展到调用(SQL)查询,这样可以节省函数调用开销,并允许查询优化器“查看”函数内部。

过程语言/ PostgreSQL(PL / pgSQL)(安全),类似于Oracle的SQL(PL / SQL)过程语言和SQL /持久存储模块(SQL / PSM)的过程语言。

C(不安全),允许将一个或多个自定义共享库加载到数据库中。用C语言编写的函数提供了最佳性能,但代码中的错误可能会崩溃并可能破坏数据库。大多数内置函数都是用C语言编写的。

此外,PostgreSQL允许通过扩展将过程语言加载到数据库中。 PostgreSQL包含三种语言扩展,以支持Perl,Python [41]和Tcl。有外部项目可以添加对许多其他语言的支持,[42]包括Java,JavaScript(PL / V8),R,Ruby等。

触发器

触发器是由SQL数据操作语言(DML)语句的操作触发的事件。例如,INSERT语句可能会激活一个触发器,该触发器检查语句的值是否有效。大多数触发器仅由INSERT或UPDATE语句激活。

触发器完全受支持,可以附加到表。触发器可以是每列和条件的,因为UPDATE触发器可以定位表的特定列,并且可以告诉触发器在触发器的WHERE子句中指定的一组条件下执行。可以使用INSTEAD OF条件将触发器附加到视图。按字母顺序触发多个触发器。除了调用本机PL / pgSQL中编写的函数之外,触发器还可以调用用其他语言编写的函数,如PL / Python或PL / Perl。

异步通知

PostgreSQL提供了一个异步消息传递系统,可通过NOTIFY,LISTEN和UNLISTEN命令进行访问。会话可以发出NOTIFY命令以及用户指定的通道和可选的有效负载,以标记发生的特定事件。其他会话能够通过发出LISTEN命令来检测这些事件,该命令可以侦听特定通道。此功能可用于多种用途,例如让其他会话知道表何时更新,或者让单独的应用程序检测何时执行特定操作。这样的系统可以防止应用程序连续轮询以查看是否有任何更改,并减少不必要的开销。通知是完全事务性的,因为在提交它们的事务之前不会发送消息。这消除了为正在执行的操作发送消息的问题,然后回滚。

PostgreSQL的许多连接器都支持这个通知系统(包括libpq,JDBC,Npgsql,psycopg和node.js),因此外部应用程序可以使用它。

规则

规则允许重写传入查询的“查询树”。 “查询重写规则”附加到表/类,并将传入的DML(选择,插入,更新和/或删除)“重写”到一个或多个查询中,这些查询替换原始DML语句或执行除此之外。查询重写发生在DML语句解析之后,但在查询规划之前。

其他查询功能

- 交易

- 全文检索

- Views

- 物化Views43]

- 可更新的Views44]

- 递归Views[45]

- 内,外(全,左,右)和交叉连接

- 子选择

- 相关的子查询[46]

- 正则表达式[47]

- 公用表表达式和可写公用表表达式

- 通过传输层安全性(TLS)加密连接;当前版本不使用易受攻击的SSL,即使使用该配置选项[48]

- 域

- 保存点

- 两阶段提交

- 超大属性存储技术(TOAST)用于通过自动压缩在单独的区域中透明地存储大型表属性(例如大型MIME附件或XML消息)。

- 嵌入式SQL使用预处理器实现。 SQL代码首先被嵌入到C代码中。然后代码通过ECPG预处理器运行,它将SQL替换为对代码库的调用。然后可以使用C编译器编译代码。嵌入也适用于C ++,但它不能识别所有C ++构造。

并发模型

PostgreSQL服务器是基于进程的(非线程化的),每个数据库会话使用一个操作系统进程。多个会话由操作系统自动分布在所有可用的CPU上。从PostgreSQL 9.6开始,许多类型的查询也可以跨多个后台工作进程并行化,利用多个CPU或核心。[49]客户端应用程序可以使用线程并从每个线程创建多个数据库连接。[50]

安全

PostgreSQL基于每个角色管理其内部安全性。角色通常被视为用户(可以登录的角色)或组(其他角色是其成员的角色)。可以在列级别的任何对象上授予或撤消权限,还可以允许/阻止在数据库,模式或表级别创建新对象。

PostgreSQL的SECURITY LABEL功能(SQL标准的扩展)允许额外的安全性;带有捆绑的可加载模块,支持基于安全增强型Linux(SELinux)安全策略的基于标签的强制访问控制(MAC)。[51] [52]

PostgreSQL本身支持大量的外部认证机制,包括:

- 密码:MD5或纯文本

- 通用安全服务应用程序接口(GSSAPI)

- 安全支持提供程序接口(SSPI)

- Kerberos的

- ident(将标识服务器提供的O / S用户名映射到数据库用户名)

- 对等(将本地用户名映射到数据库用户名)

- 轻量级目录访问协议(LDAP)

- 活动目录(AD)

- 半径

- 证书

- 可插拔认证模块(PAM)

- GSSAPI,SSPI,Kerberos,对等,身份和证书方法也可以使用指定的“映射”文件,该文件列出允许该身份验证系统匹配的用户作为特定数据库用户进行连接。

这些方法在集群的基于主机的身份验证配置文件(pg_hba.conf)中指定,该文件确定允许的连接。这允许控制哪个用户可以连接到哪个数据库,他们可以从哪里连接(IP地址,IP地址范围,域套接字),将强制执行哪个身份验证系统,以及连接是否必须使用传输层安全性(TLS)。

符合标准

PostgreSQL声称与SQL标准的一致性很高,但并不完整。一个例外是处理不带引号的标识符,如表名或列名。在PostgreSQL中,它们被折叠 - 内部 - 小写字符[53],而标准则表示不带引号的标识符应折叠成大写字母。因此,根据标准,Foo应该等同于FOO而不是foo。

基准和表现

PostgreSQL的许多非正式表演研究已经完成。[54]旨在提高可伸缩性的性能改进始于8.1版。 8.0版和8.4版之间的简单基准测试表明,后者在只读工作负载上的速度提高了10倍以上,在读写工作负载上的速度提高了至少7.5倍。[55]

第一个行业标准和同行验证的基准测试于2007年6月完成,使用Sun Java System Application Server(GlassFish的专有版本)9.0 Platform Edition,基于UltraSPARC T1的Sun Fire服务器和PostgreSQL 8.2。[56] 778.14 SPECjAppServer2004 JOPS @ Standard的结果与基于Itanium的HP-UX系统上的874 JOPS @ Standard与Oracle 10相比毫不逊色。[54]

2007年8月,Sun提交了一份改进的基准分数813.73 SPECjAppServer2004 JOPS @ Standard。随着被测系统的降价,价格/性能从84.98美元/ JOPS提高到70.57美元/ JOPS。[57]

PostgreSQL的默认配置仅使用少量专用内存用于性能关键目的,例如缓存数据库块和排序。这种限制主要是因为较旧的操作系统需要更改内核以允许分配大块共享内存。[58] PostgreSQL.org在维基中提供有关基本推荐性能实践的建议。[59]

2012年4月,EnterpriseDB的Robert Haas使用64核的服务器演示了PostgreSQL 9.2的线性CPU可扩展性。[60]

Matloob Khushi在Postgresql 9.0和MySQL 5.6.15之间进行基准测试,以处理基因组数据。在他的表现分析中,他发现PostgreSQL提取的重叠基因组区域比MySQL快8倍,使用两个80,000个数据集,每个数据集形成随机的人类DNA区域。 PostgreSQL中的插入和数据上传也更好,尽管两个数据库的一般搜索能力几乎相同。[61]

平台

PostgreSQL可用于以下操作系统:Linux(所有最新发行版),Windows(Windows 2000 SP4及更高版本;可编译,例如Visual Studio,现在最近的2017版本),FreeBSD,OpenBSD,[62] NetBSD,macOS (OS X),[13] AIX,HP-UX,Solaris和UnixWare;尚未正式测试:DragonFly BSD,BSD / OS,IRIX,OpenIndiana,[63] OpenSolaris,OpenServer和Tru64 UNIX。大多数其他类Unix系统也可以工作;最现代化的支持。

PostgreSQL适用于以下任何指令集体系结构:Windows和其他操作系统上的x86和x86-64;除了Windows之外,还支持这些:IA-64 Itanium(HP-UX的外部支持),PowerPC,PowerPC 64,S / 390,S / 390x,SPARC,SPARC 64,ARMv8-A(64位)[64]和较旧的ARM(32位,包括较旧的,如Raspberry Pi [65]中的ARMv6),MIPS,MIPSel和PA-RISC。它也被称为Alpha(在9.5中删除),M68k,M32R,NS32k和VAX。除此之外,还可以通过禁用自旋锁来为不受支持的CPU构建PostgreSQL。[66]

数据库管理

另请参见:数据库工具的比较

用于管理PostgreSQL的开源前端和工具包括:

- PSQL

-

- PostgreSQL的主要前端是psql命令行程序,可用于直接输入SQL查询或从文件执行它们。此外,psql提供了许多元命令和各种类似shell的功能,以便于编写脚本和自动执行各种任务;例如,对象名称和SQL语法的选项卡完成。

- pgAdmin的

- pgAdmin包是PostgreSQL的免费开源图形用户界面(GUI)管理工具,许多计算机平台都支持该工具。[67]该计划有十几种语言版本。第一个原型名为pgManager,是从1998年开始为PostgreSQL 6.3.2编写的,并在后几个月以GNU通用公共许可证(GPL)的形式重写并发布为pgAdmin。第二个版本(名为pgAdmin II)是完全重写的,首次发布于2002年1月16日。第三个版本pgAdmin III最初是在Artistic License下发布的,然后在与PostgreSQL相同的许可下发布。与以Visual Basic编写的先前版本不同,pgAdmin III是用C ++编写的,使用wxWidgets [68]框架允许它在大多数常见操作系统上运行。查询工具包括一个名为pgScript的脚本语言,用于支持管理和开发任务。 2014年12月,pgAdmin项目创始人兼主要开发人员Dave Page [69]宣布,随着向基于网络的模式的转变,pgAdmin 4的工作已经开始,旨在促进云部署。[70] 2016年,pgAdmin 4发布。 pgAdmin 4后端是用Python编写的,使用Flask和Qt框架。[71]

- phpPgAdmin的

- phpPgAdmin是一个基于Web的PostgreSQL管理工具,用PHP编写,基于最初为MySQL管理编写的流行的phpMyAdmin接口。[72]

- PostgreSQL Studio

- PostgreSQL Studio允许用户从基于Web的控制台执行必要的PostgreSQL数据库开发任务。 PostgreSQL Studio允许用户使用云数据库而无需打开防火墙。[73]

- TeamPostgreSQL

- 用于PostgreSQL的AJAX / JavaScript驱动的Web界面。允许通过Web浏览器浏览,维护和创建数据和数据库对象。该界面提供带选项卡的SQL编辑器,包括自动完成,行编辑小部件,行和表之间的点击式外键导航,常用脚本的收藏夹管理以及其他功能。支持Web界面和数据库连接的SSH。安装程序可用于Windows,Macintosh和Linux,以及一个从脚本运行的简单跨平台存档。[74]

- LibreOffice,OpenOffice.org

- LibreOffice和OpenOffice.org Base可以用作PostgreSQL的前端。[75] [76]

- pgBadger

- pgBadger PostgreSQL日志分析器从PostgreSQL日志文件生成详细报告。[77]

- pgDevOps

- pgDevOps是一套Web工具,用于安装和管理多个PostgreSQL版本,扩展和社区组件,开发SQL查询,监视正在运行的数据库并查找性能问题。[78]

- 许多公司为PostgreSQL提供专有工具。它们通常由适用于各种特定数据库产品的通用核心组成。这些工具主要与开源工具共享管理功能,但在数据建模,导入,导出或报告方面提供了改进。

知名的用户

使用PostgreSQL作为主数据库的着名组织和产品包括:

- 2009年,社交网站Myspace使用Aster Data Systems的nCluster数据库进行数据仓库,这是基于未经修改的PostgreSQL构建的。[79] [80]

- Geni.com使用PostgreSQL作为他们的主要家谱数据库。[81]

- OpenStreetMap,一个创建免费可编辑世界地图的合作项目。[82]

- Afili,.org,.info等域名注册机构。[83] [84]

- 索尼在线多人在线游戏。[85]

- 巴斯夫,他们的农业综合企业门户网站的购物平台。[86]

- Reddit社交新闻网站。[87]

- Skype VoIP应用程序,中央商业数据库。[88]

- Sun xVM,Sun的虚拟化和数据中心自动化套件。[89]

- MusicBrainz,开放在线音乐百科全书。[90]

- 国际空间站 - 收集轨道上的遥测数据并将其复制到地面。[91]

- MyYearbook社交网站。[92]

- Instagram,一种移动照片共享服务。[93]

- Disqus,在线讨论和评论服务。[94]

- TripAdvisor,旅游信息网站,主要是用户生成的内容。[95]

- 俄罗斯互联网公司Yandex将其Yandex.Mail服务从Oracle改为Postgres。[96]

- Amazon Redshift是AWS的一部分,是基于ParAccel Postgres修改的柱状在线分析处理(OLAP)系统。

- 国家海洋和大气管理局(NOAA)国家气象局(NWS),交互式预报准备系统(IFPS),该系统集成了NEXRAD天气雷达,地面和水文系统的数据,以建立详细的本地化预报模型。[84] [ 97]

- 英国的国家气象服务部门Met Office已经开始将Oracle for PostgreSQL转换为部署更多开源技术的战略。[97] [98]

- WhitePages.com一直在使用Oracle [99] [循环引用]和MySQL,但是当它在内部移动其核心目录时,它转向了PostgreSQL。由于WhitePages.com需要结合来自多个来源的大量数据,因此PostgreSQL以高速率加载和索引数据的能力是决定使用PostgreSQL的关键。[84]

- FlightAware,一个航班跟踪网站。[100]

- Grofers,一种在线杂货店送货服务。[101]

- 卫报在2018年从MongoDB迁移到PostgreSQL。[102]

服务实施

一些着名的供应商提供PostgreSQL作为软件即服务:

- 作为服务提供商的平台Heroku从2007年开始就支持PostgreSQL。[103]它们提供增值功能,如完全数据库回滚(从任何指定时间恢复数据库的能力),[104]基于WAL-E,由Heroku开发的开源软件。[105]

- 2012年1月,EnterpriseDB发布了PostgreSQL和他们自己专有的Postgres Plus Advanced Server的云版本,并自动配置了故障转移,复制,负载平衡和扩展。它在Amazon Web Services上运行。[106]

- 自2012年5月起,VMware为VMware vSphere上的私有云提供了vFabric Postgres(也称为vPostgres [107])。[108]

- 2013年11月,亚马逊网络服务公司宣布将PostgreSQL添加到他们的关系数据库服务产品中。[109] [110]

- 2016年11月,亚马逊网络服务公司宣布将PostgreSQL兼容性添加到其原生的Amazon Aurora托管数据库产品中。[111]

- 2017年5月,Microsoft Azure宣布为PostgreSQL提供Azure数据库[112]

原文:https://en.wikipedia.org/wiki/PostgreSQL

讨论:请加入知识星球或者小红圈【首席架构师圈】

- 259 次浏览

【PostgreSQL 】如何在CentOS 7 / CentOS 8上安装PostgreSQL 12

本指南将引导您完成在CentOS 7 / CentOS 8 Linux服务器上安装PostgreSQL 12的步骤。 PostgreSQL是一个基于POSTGRES 4.2的对象关系数据库管理系统。开发人员和数据库管理员可以使用PostgreSQL 12。

PostgreSQL项目为最常见的发行版提供了所有受支持版本的软件包的存储库。支持的发行版包括所有Red Hat系列,其中包括CentOS,Fedora,Scientific Linux,Oracle Linux和Red Hat Enterprise Linux。

使用以下步骤在CentOS 8 / CentOS 7上安装PostgreSQL 12。

步骤1:将PostgreSQL Yum存储库添加到CentOS 7 / CentOS 8

PostgreSQL Yum存储库将与您的常规系统和补丁程序管理集成,并在PostgreSQL的整个支持期限内为所有受支持的PostgreSQL版本提供自动更新。

可以通过运行以下命令将其添加到CentOS系统中:

CentOS 8:

sudo yum -y install https://download.postgresql.org/pub/repos/yum/reporpms/EL-8-x86_64/pgdg-redhat-repo-latest.noarch.rpm

CentOS 7:

sudo yum -y install https://download.postgresql.org/pub/repos/yum/reporpms/EL-7-x86_64/pgdg-redhat-repo-latest.noarch.rpm

您可以通过运行以下命令获取有关已安装软件包的更多信息:

$ rpm -qi pgdg-redhat-repo Name : pgdg-redhat-repo Version : 42.0 Release : 4 Architecture: noarch Install Date: Thu 19 Sep 2019 06:34:53 PM UTC Group : System Environment/Base Size : 6915 License : PostgreSQL Signature : DSA/SHA1, Wed 17 Apr 2019 04:12:42 AM UTC, Key ID 1f16d2e1442df0f8 Source RPM : pgdg-redhat-repo-42.0-4.src.rpm Build Date : Wed 17 Apr 2019 04:12:41 AM UTC Build Host : koji-centos7-x86-64-pgbuild Relocations : (not relocatable) Vendor : PostgreSQL Global Development Group URL : https://yum.postgresql.org Summary : PostgreSQL PGDG RPMs- Yum Repository Configuration for Red Hat / CentOS / Scientific Linux Description : This package contains yum configuration for Red Hat Enterprise Linux, CentOS and Scientific Linux. and also the GPG key for PGDG RPMs.

步骤2:在CentOS 8 / CentOS 7上安装PostgreSQL 12

添加YUM存储库后,我们可以使用以下命令在CentOS 7/8上安装PostgreSQL 12。

CentOS 8上的PostgreSQL 12

禁用内置的PostgreSQL模块:

sudo dnf -qy module disable postgresql

然后安装客户端和服务器软件包:

sudo dnf -y install postgresql12 postgresql12-server

CentOS 7上的PostgreSQL 12

安装PostgreSQL客户端和服务器软件包:

sudo yum -y install epel-release yum-utils sudo yum-config-manager --enable pgdg12 sudo yum install postgresql12-server postgresql12

样本安装输出:

Dependencies Resolved =================================================================================================================================================== Package Arch Version Repository Size =================================================================================================================================================== Installing: postgresql12 x86_64 12beta4-1PGDG.rhel7 pgdg12-testing 1.8 M postgresql12-server x86_64 12beta4-1PGDG.rhel7 pgdg12-testing 5.4 M Installing for dependencies: libicu x86_64 50.2-3.el7 base 6.9 M postgresql12-libs x86_64 12beta4-1PGDG.rhel7 pgdg12-testing 383 k python3 x86_64 3.6.8-10.el7 base 69 k python3-libs x86_64 3.6.8-10.el7 base 7.0 M python3-pip noarch 9.0.3-5.el7 base 1.8 M python3-setuptools noarch 39.2.0-10.el7 base 629 k Transaction Summary =================================================================================================================================================== Install 2 Packages (+6 Dependent packages) Total download size: 24 M Installed size: 104 M Downloading packages: (1/8): libicu-50.2-3.el7.x86_64.rpm | 6.9 MB 00:00:00 warning: /var/cache/yum/x86_64/7/pgdg12-testing/packages/postgresql12-libs-12beta4-1PGDG.rhel7.x86_64.rpm: Header V4 DSA/SHA1 Signature, key ID 442df0f8: NOKEY Public key for postgresql12-libs-12beta4-1PGDG.rhel7.x86_64.rpm is not installed (2/8): postgresql12-libs-12beta4-1PGDG.rhel7.x86_64.rpm | 383 kB 00:00:00 (3/8): python3-3.6.8-10.el7.x86_64.rpm | 69 kB 00:00:00 (4/8): python3-setuptools-39.2.0-10.el7.noarch.rpm | 629 kB 00:00:00 (5/8): postgresql12-12beta4-1PGDG.rhel7.x86_64.rpm | 1.8 MB 00:00:00 (6/8): python3-libs-3.6.8-10.el7.x86_64.rpm | 7.0 MB 00:00:00 (7/8): postgresql12-server-12beta4-1PGDG.rhel7.x86_64.rpm | 5.4 MB 00:00:00 (8/8): python3-pip-9.0.3-5.el7.noarch.rpm | 1.8 MB 00:00:00 --------------------------------------------------------------------------------------------------------------------------------------------------- Total 15 MB/s | 24 MB 00:00:01 Retrieving key from file:///etc/pki/rpm-gpg/RPM-GPG-KEY-PGDG Importing GPG key 0x442DF0F8: Userid : "PostgreSQL RPM Building Project <pgsqlrpms-hackers@pgfoundry.org>" Fingerprint: 68c9 e2b9 1a37 d136 fe74 d176 1f16 d2e1 442d f0f8 Package : pgdg-redhat-repo-42.0-4.noarch (installed) From : /etc/pki/rpm-gpg/RPM-GPG-KEY-PGDG Running transaction check Running transaction test Transaction test succeeded Running transaction Installing : libicu-50.2-3.el7.x86_64 1/8 Installing : postgresql12-libs-12beta4-1PGDG.rhel7.x86_64 2/8 Installing : python3-libs-3.6.8-10.el7.x86_64 3/8 Installing : python3-setuptools-39.2.0-10.el7.noarch 4/8 Installing : python3-3.6.8-10.el7.x86_64 5/8 Installing : python3-pip-9.0.3-5.el7.noarch 6/8 Installing : postgresql12-12beta4-1PGDG.rhel7.x86_64 7/8 Installing : postgresql12-server-12beta4-1PGDG.rhel7.x86_64 8/8 Verifying : postgresql12-libs-12beta4-1PGDG.rhel7.x86_64 1/8 Verifying : python3-pip-9.0.3-5.el7.noarch 2/8 Verifying : libicu-50.2-3.el7.x86_64 3/8 Verifying : python3-libs-3.6.8-10.el7.x86_64 4/8 Verifying : postgresql12-12beta4-1PGDG.rhel7.x86_64 5/8 Verifying : postgresql12-server-12beta4-1PGDG.rhel7.x86_64 6/8 Verifying : python3-setuptools-39.2.0-10.el7.noarch 7/8 Verifying : python3-3.6.8-10.el7.x86_64 8/8 Installed: postgresql12.x86_64 0:12beta4-1PGDG.rhel7 postgresql12-server.x86_64 0:12beta4-1PGDG.rhel7 Dependency Installed: libicu.x86_64 0:50.2-3.el7 postgresql12-libs.x86_64 0:12beta4-1PGDG.rhel7 python3.x86_64 0:3.6.8-10.el7 python3-libs.x86_64 0:3.6.8-10.el7 python3-pip.noarch 0:9.0.3-5.el7 python3-setuptools.noarch 0:39.2.0-10.el7

步骤3:初始化并启动数据库服务

安装后,需要先进行数据库初始化,然后才能启动服务。

sudo /usr/pgsql-12/bin/postgresql-12-setup initdb

数据库主要配置ifile写入:/var/lib/pgsql/12/data/postgresql.conf

启动并启用数据库服务器服务。

sudo systemctl enable --now postgresql-12

确认服务已启动,没有任何错误。

$ systemctl status postgresql-12 ● postgresql-12.service - PostgreSQL 12 database server Loaded: loaded (/usr/lib/systemd/system/postgresql-12.service; enabled; vendor preset: disabled) Active: active (running) since Thu 2019-09-19 18:50:10 UTC; 39s ago Docs: https://www.postgresql.org/docs/12/static/ Process: 10647 ExecStartPre=/usr/pgsql-12/bin/postgresql-12-check-db-dir ${PGDATA} (code=exited, status=0/SUCCESS) Main PID: 10652 (postmaster) CGroup: /system.slice/postgresql-12.service ├─10652 /usr/pgsql-12/bin/postmaster -D /var/lib/pgsql/12/data/ ├─10654 postgres: logger ├─10656 postgres: checkpointer ├─10657 postgres: background writer ├─10658 postgres: walwriter ├─10659 postgres: autovacuum launcher ├─10660 postgres: stats collector └─10661 postgres: logical replication launcher Sep 19 18:50:10 cent7.novalocal systemd[1]: Starting PostgreSQL 12 database server... Sep 19 18:50:10 cent7.novalocal postmaster[10652]: 2019-09-19 18:50:10.207 UTC [10652] LOG: starting PostgreSQL 12beta4 on x86_64-pc-lin... 64-bit Sep 19 18:50:10 cent7.novalocal postmaster[10652]: 2019-09-19 18:50:10.209 UTC [10652] LOG: listening on IPv6 address "::1", port 5432 Sep 19 18:50:10 cent7.novalocal postmaster[10652]: 2019-09-19 18:50:10.209 UTC [10652] LOG: listening on IPv4 address "127.0.0.1", port 5432 Sep 19 18:50:10 cent7.novalocal postmaster[10652]: 2019-09-19 18:50:10.214 UTC [10652] LOG: listening on Unix socket "/var/run/postgresq...L.5432" Sep 19 18:50:10 cent7.novalocal postmaster[10652]: 2019-09-19 18:50:10.229 UTC [10652] LOG: listening on Unix socket "/tmp/.s.PGSQL.5432" Sep 19 18:50:10 cent7.novalocal postmaster[10652]: 2019-09-19 18:50:10.254 UTC [10652] LOG: redirecting log output to logging collector process Sep 19 18:50:10 cent7.novalocal postmaster[10652]: 2019-09-19 18:50:10.254 UTC [10652] HINT: Future log output will appear in directory "log". Sep 19 18:50:10 cent7.novalocal systemd[1]: Started PostgreSQL 12 database server. Hint: Some lines were ellipsized, use -l to show in full.

如果您有正在运行的防火墙服务,并且远程客户端应连接到数据库服务器,则允许PostgreSQL服务。

sudo firewall-cmd --add-service=postgresql --permanent sudo firewall-cmd --reload

第4步:设置PostgreSQL管理员用户的密码

设置PostgreSQL管理员用户

$ sudo su - postgres ~]$ psql -c "alter user postgres with password 'StrongPassword'" ALTER ROLE

步骤5:启用远程访问(可选)

编辑文件/var/lib/pgsql/12/data/postgresql.conf并将所有服务器的“监听地址”设置为服务器IP地址或“ *”。

listen_addresses ='192.168.10.10'

还设置PostgreSQL接受远程连接

$ sudo vim /var/lib/pgsql/12/data/pg_hba.conf # Accept from anywhere host all all 0.0.0.0/0 md5 # Accept from trusted subnet host all all 192.168.18.0/24 md5

提交更改后,重新启动数据库服务。

sudo systemctl restart postgresql-12

步骤6:安装pgAdmin 4 Web界面

pgAdmin是领先的开源功能丰富的PostgreSQL管理和开发平台,可在Linux,Unix,Mac OS X和Windows上运行。 这是在CentOS上安装pgAdmin4的链接。

How To Install pgAdmin 4 on CentOS 8 Linux

原文:https://computingforgeeks.com/how-to-install-postgresql-12-on-centos-7/

本文:http://jiagoushi.pro/node/920

讨论:请加入知识星球或者微信圈子【首席架构师圈】

- 74 次浏览

【PostgreSQL 技术】扩展Postgresql到TB甚至更大的想法

在最近与一位DBA交谈后,他迈出了将大型数据库从Oracle迁移到Postgres的第一步。

我认为没有足够的文章介绍PostgreSQL的特性和黑客,从硬件中挤出最后一部分,安全地容纳好几个tb大小的数据库以实现可伸缩性。特别是在有相当多的选择的情况下,我很惊讶有这么多的人担心PostgreSQL在伸缩性方面是非常有限的。也许确实曾经是这样(我在2011年开始使用Postgres),但在2018年,事情已经相当稳固了——所以请继续读下去,看看如何轻松地处理tb。

标准Postgres设施

如果你不喜欢出汗太多,然后做一些开拓性的尺度。应该是最安全的方法坚持证明Postgres的开箱即用的特性,首先我建议看看以下关键词和一些简短的解释,也许是你需要的一切。

轻量级/特殊用途索引

对于支持数百个奇怪查询的复杂OLTP系统,索引实际上占用的磁盘空间比保存数据的表文件要多得多,这是很常见的。为了改善这一点(特别是对于不经常使用的索引),可以通过适当使用部分、BRIN、GIN甚至少量实验性BLOOM索引来大幅减小索引的大小。总共支持7种不同的索引类型……但是大多数人只知道和使用默认的b -树——这在多tb设置中是个大错误!

部分索引只允许数据的一个子集——例如,在销售系统中,我们可能对快速访问状态为“FINISHED”的订单不感兴趣(一些夜间报告通常会处理这个问题,它们可能会花很多时间),那么我们为什么要索引这样的行呢?

GIN可能是最知名的非默认索引类型,它已经存在很长时间了(全文搜索),简而言之,它非常适合索引有很多重复值的列——考虑各种状态或老的Mr/Mrs/Miss。GIN只将每个惟一的列值存储一次,对于默认的b树,您将拥有1,000,000个叶节点,其中包含整数“1”。

BRIN(block-range又名min-max指数)另一方面,是新的和非常不同——它是一种有损压缩指数与一个很小的磁盘占用,并不是所有的列值建立索引,但只有最大和最小值的行范围(1 MB的默认表)——这仍然很有效有序的值,例如适合时间序列数据或其他“日志”类型的表。

BLOOM可能有点奇怪,但如果你能找到一个很好的用例(“位图/矩阵搜索”),它的效率会比传统索引高出20倍——这里有一个看起来过于抽象的用例。

但是为什么我要把索引这个有点不太原创的话题放在列表的最前面呢?因为这个解决方案的最大优点是您不需要更改任何应用程序—DBA可以让它轻松地在幕后工作,就像一次性工作一样!完美的。

表分区

Postgres分区已经15年我相信……但“弄脏你的手”的方式——一个不得不做一些附加的低级管理分区,添加检查约束和直接插入行纠正子表,或路由通过父表插入触发器。所有这些都是从Postgres version 10开始的历史,有声明式分区,并且在version 11中变得更好,在版本11中,功能可以被称为功能完整的功能,支持主键和外键。

但何苦呢?分区的优点是:它可以干净地分离“冷数据”和“热数据”,这给了我们一些不错的选项如使用VACUUM FULL最大限度压缩旧数据或把它放在另一个媒体(参见下面的“表空间”)作为一个副作用较小的索引,以少得多的“shared_buffers”空间所以我们有更多的空间数据。对于统一访问的数据场景(通过名称/电子邮件/散列),这种影响最大,大型索引的所有部分仍然需要遍历/读取/缓存,但实际使用的只是其中很小的一部分。同样类似于索引,在良好的应用程序条件下,dba无需在后台更改任何代码就可以实现分区。

表空间

如上所述——借助表空间可以有选择地将表/索引移动到不同的磁盘介质。这里可以实现不同的目标之一——为了节省资金,使用较慢/负担得起的磁盘分区来处理“冷”数据,只在快速/昂贵的媒体上保存最新/重要的数据,对重复次数很多的数据使用一些特殊的压缩文件系统,对大量非持久性数据使用一些网络共享甚至远程节点上的内存文件系统——有一些选项。而且表空间的管理实际上也非常简单,由于完全锁定,只有在实时操作期间传输现有的表/索引才会有问题。

最大限度地使用多进程特性

从Postgres 9.6开始,可以对数据的一些常见操作进行并行化。在Postgres 10/11中,默认情况下也启用了相关参数“max_parallel_workers_per_gather”,其值为2,因此是max。使用了2个后台进程。对于“大数据”用例,增加更多(以及一些相关参数)是有意义的。此外,对并行化操作的支持也会随着每一个新的主要发行版的增加而增加。例如,即将发布的version 11现在可以执行并行散列连接、索引扫描和UNION-s。

使用副本进行查询负载平衡

现在我们已经走出了“单节点”或“扩展”的领域……但是考虑到非常合理的硬件价格和可用的Postgres集群管理软件(Patroni是我们的最爱),它不仅适用于更大的“商店”,而且应该适用于每个人。当然,这种扩展只能在主要是读取数据的情况下使用……按照目前(以及未来几年)的官方规定,一个接受写操作的集群中只能有一个“主/主”节点。此外,根据您选择的技术栈,您可能需要处理一些技术细节(特别是连接路由),但实际上,Postgres 10确实在驱动程序级别增加了对多主机用例的支持——因此电池也包括在内!更多信息请看这里。同样,从Postgres 9.6开始,副本可以在“镜像”模式下运行,这样您选择哪个节点运行就无关紧要了!不过,作为一个友好的警告——这只能在读取查询是纯OLTP的情况下工作,也就是说非常快。

有一些妥协的方法

所以现在我们已经完成了传统的事情…但是如果你准备走一条非常规的路

也许对您的应用程序做一些细微的调整,或者尝试一些命名有趣的扩展,您可能会从单节点硬件中挤出最后一滴性能。我的意思是:

混合/外部表

我称之为混合表,实际上是基于Postgres的优秀的MED SQL标准的实现也被称为外部数据包装(FDW),基本上,他们看起来像正常Postgres表读取查询,但数据可能存在或管道从字面上任何地方——它可能是来自Twitter、LDAP或Amazon S3,看到疯狂的数据源支持的完整列表。实际上,最常用的外部数据包装程序可能是使正常(正确格式化的)文件看起来像表,例如将服务器日志公开为表,以便更容易监视。

你可能会问扩展部分在哪里?FDW方法工作得非常好,因为它能够通过使用一些聪明的文件格式或仅仅压缩来减少数据量,这通常会减少数据大小10-20x,以便数据适合节点!这对于“冷”数据非常有效,为“热”数据的真实表留下更多的磁盘空间/缓存可用。由于Postgres 10,它也很容易实现——这里是示例代码。

另一个非常有前途的用例是使用柱状数据存储格式(ORC)—查看“c_store”扩展项目以获得更多信息。它特别适合帮助扩展大型数据仓库,其中的表可以小到10倍,查询速度可以快到100%。

为什么我没有把这个特性添加到上面的“标准Postgres设施”部分,尽管外部数据包装基础设施已经牢固地构建到Postgres中?好的,缺点是您通常不能通过SQL更改数据和添加索引或约束,因此它的使用有一定的限制。

外表继承,即分片!(Foreign table inheritance a.k.a. sharding!)

与上一点基本相同——但是引入了表分区并将子表驻留在远程节点上!数据可以被植入到附近的Postgres服务器,并根据需要通过网络自动提取。实际上,它们不必是Postgres表!它很可能是MySQL、Oracle或MS SQL任何其他流行的服务器,对某些查询子集工作得很好。这有多酷?虽然只有“postgres_fdw”支持所有的写操作、事务和聪明的过滤器下推,所以通过网络传递的数据量最小化,但是可以从postgres_fdw到postgres的交互中得到最好的结果。

terabyte-hunting快乐!

原文:https://www.cybertec-postgresql.com/en/ideas-for-scaling-postgresql-to-multi-terabyte-and-beyond/

本文:http://jiagoushi.pro/node/1180

讨论:请加入知识星球【首席架构师圈】或者小号【jiagoushi_pro】

- 56 次浏览

【PostgreSQL 架构】PostgreSQL 10和逻辑复制-概述

- 41 次浏览

【PostgreSQL 架构】PostgreSQL 11和即时编译查询

PostgreSQL 11正在酝酿之中,即将发布。同时,使用您自己的应用程序对其进行测试是确保社区在零点发行之前捕获所有剩余错误的好方法。

下一个PostgreSQL版本的重大变化之一是Andres Freund在查询执行器引擎上的工作成果。 Andres已经在系统的这一部分上工作了一段时间,在下一发行版中,我们将看到执行引擎中的一个新组件:一个JIT表达式编译器!

基准和TPC-H

我喜欢在Citus Data进行工程工作以通过Citus扩展扩展PostgreSQL的一件事就是,我可以运行基准测试!基准测试是一个很好的工具,可以显示性能改进可带来哪些好处。当前,JIT表达式编译器在以下情况下效果最佳:

- 该查询包含多个复杂的表达式,例如聚合。

- 该查询读取了大量数据,但没有IO资源短缺。

- 该查询非常复杂,以至于需要花费大量的JIT精力。

通过主键代理ID获取某些信息的查询不太适合查看PostgreSQL中新的JIT基础结构所提供的改进。

TPC-H基准测试第1季度查询可以很好地评估新执行程序堆栈的影响,因此我们在这里使用它。

基准测试的规范可在137页的名为TPC Benchmark™H的PDF文档中找到。该规范中的每个查询都附带一个业务问题,因此请参阅第一季度

定价摘要报告查询(Q1)

此查询报告已开票,发货和退回的业务量。

定价摘要报告查询提供了给定日期发货的所有订单项的摘要定价报告。该日期位于数据库中包含的最晚发货日期的60-120天之内。该查询列出了扩展价格,折扣扩展价格,折扣扩展价格加税,平均数量,平均扩展价格和平均折扣的总计。这些聚合按RETURNFLAG和LINESTATUS分组,并按RETURNFLAG和LINESTATUS的升序排列。包括每个组中的行项目数的计数。

这就是SQL中的样子:

select l_returnflag, l_linestatus, sum(l_quantity) as sum_qty, sum(l_extendedprice) as sum_base_price, sum(l_extendedprice * (1 - l_discount)) as sum_disc_price, sum(l_extendedprice * (1 - l_discount) * (1 + l_tax)) as sum_charge, avg(l_quantity) as avg_qty, avg(l_extendedprice) as avg_price, avg(l_discount) as avg_disc, count(*) as count_order from lineitem where l_shipdate <= date '1998-12-01' - interval ':1' day group by l_returnflag, l_linestatus order by l_returnflag, l_linestatus :n -1 ;

此外,该规范还提供有关查询的注释:

注释:1998-12-01是数据库填充中定义的最高可能的发货日期。 (这是ENDDATE-30)。 该查询将包括该日期之前减去DELTA天之前发货的所有订单项。 目的是选择DELTA,以便扫描表中95%至97%的行。

为了使查询有资格显示新的PostgreSQL表达式以执行JIT编译器,我们将选择适合内存的比例因子。

结果

选择10的比例因子时,我们得到的数据库大小为22GB,包括创建的索引。 此处使用的完整架构在tpch-schema.sql上可用,而索引在tpch-pkeys.sql和tpch-index.sql上。

在我的测试中,执行TPCH Q1查询时,PostgreSQL 11比PostgreSQL 10快29.31%。 在循环中运行查询10分钟时,当PostgreSQL 10仅执行同一查询时,它允许PostgreSQL 11执行30次。 21次。

如我们所见,PostgreSQL 10中的Andres工作已经对该查询产生了巨大影响。在此版本中,对执行程序的表达式评估进行了全面修订,以考虑到CPU缓存行和指令管道。在此基准测试中,我们选择在PostgreSQL中禁用并行查询,以便评估主要由新执行程序导致的改进。 PostgreSQL 10 then 11中的并行支持能够大大增强我们在此看到的查询时间!

在PostgreSQL 11中,由于在查询计划时使用LLVM编译器基础结构,SQL表达式已转换为机器代码,这对查询性能产生了另一个非常好的影响!

工具

基准测试规范有两个文件可用:

llvm-q1-infra.ini定义了用于运行此测试的AWS EC2实例。

- 在这里您可以看到我们选择了c5.4xlarge实例来托管我们的PostgreSQL数据库。它们每个都有30GB的RAM,因此我们的22GB数据集和索引非常适合RAM。

- 另外,我们使用http://apt.postgresql.org中的软件包选择了debian操作系统,该软件包提供了我们在此处一直使用的PostgreSQL 11开发快照。

llvm-q1-schedule.ini定义了我们的基准计划,这在这里非常简单:

[schedule]

full = initdb, single-user-stream, multi-user-stream

- 在initdb阶段,在8个并发进程中加载比例因子10的数据,每个进程一次执行一个步骤,考虑到我们将工作负载分为10个子进程。

- 我们在这里使用TPC-H s语。另外,在我研究的PostgreSQL的TPC-H实现中,我增加了对直接加载机制的支持,这意味着dbgen工具连接到数据库服务器并使用COPY协议。

- 然后执行一个单用户流,该流包括在客户端的单个CPU上运行尽可能多的查询,并持续10分钟。

- 然后执行一个多用户流,该流包含从所有8个CPU并行运行尽可能多的查询,并持续10分钟。

此处使用的基准测试工具是“开源”,可从https://github.com/dimitri/tpch-citus免费获得。这是一个简单的应用程序,可以自动在动态的AWS EC2基础架构中运行TPCH。

这个想法是,在创建几个配置文件后,可以在多个系统上并行驱动一个完整的基准测试,并在合并的数据库中检索结果以供以后分析。

此外,该项目还包括适用于PostgreSQL的TPCH C代码版本,并使用COPY协议实现直接加载。然后,该项目使用dbgen工具生成数据,并使用qgen工具为每个客户端根据规范生成新的查询流。

期待未来的Postgres

PostgreSQL 11引入了一个新的PostgreSQL执行引擎,借助LLVM框架,该引擎将您的SQL代码编译为机器代码。对于足够昂贵的查询(遍历许多行并一次又一次地计算表达式的查询),其好处可能是巨大的!

为了帮助PostgreSQL实现版本11的最佳发行,请考虑在测试和CI环境中使用beta版本,并报告您可能会发现的所有错误或性能下降,并通过一种简便的方法来再现它们。有关声明和如何报告相关发现的详细信息,请参见PostgreSQL 10.5和11 Beta 3 Released。

在我们的基准测试中,PostgreSQL 11 JIT是一项很棒的技术,它提供了高达29.31%的速度改进,在使用PostgreSQL 10时以20.5s的比例因子10执行TPC-H Q1而不是29s。

在Citus,我们几个月来一直在忙于针对PostgreSQL测试Citus扩展。因为Citus是Postgres的纯粹扩展,而不是fork,这意味着当时候到来时,您应该能够升级以获得Postgres 11的所有新优势,以帮助您保持扩展。

原文:https://www.citusdata.com/blog/2018/09/11/postgresql-11-just-in-time/

本文:http://jiagoushi.pro/node/924

讨论:请加入知识星球或者微信圈子【首席架构师圈】

- 61 次浏览

【PostgreSQL 架构】PostgreSQL的大量处理开发

- 34 次浏览

【PostgreSQL】PostgreSQL CDC:如何设置实时同步

视频号

微信公众号

知识星球

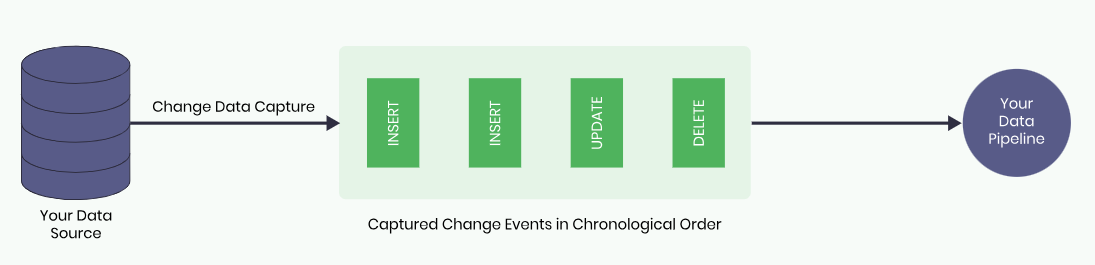

PostgreSQL是使用最广泛的开源关系数据库之一。其全面的查询层和符合技术标准的特性使其成为OLTP工作负载,数据仓库和分析用例等各种用例的最爱。在典型的体系结构中,组织将有一个关系数据库来处理事务负载,然后有一个单独的数据仓库来执行所有分析用例和汇总报告。这里的挑战是确保数据仓库具有事务数据库中存在的最新数据版本。通常有时间紧迫的报告要求,无法在这些数据库之间进行每小时或每天的批处理同步。使用基于变更数据捕获范例的实例之间的连续同步来处理此类需求。这篇文章是关于PostgreSQL CDC及其实现方法的。

在本文中,您将学习:

- 实现PostgreSQL CDC的方法

- 方法1 –使用自定义代码的Postgres CDC

- 方法1 –使用审核触发器

- 方法2:使用Postgres逻辑解码

- 方法3:使用时间戳列

- 方法2 –实施PostgreSQL CDC的简便方法

实施PostgreSQL变化数据捕获(CDC)的方法

有很多实现Postgres CDC的方法。 该博客讨论了以下两种方法:方法1:构建自定义代码以实现PostgreSQL CDC

我们将在此博客中讨论以下方法:

- 使用Postgres审核触发器

- 使用Postgres逻辑解码

- 使用时间戳列

方法2:使用完全自动化的数据管道解决方案,如Hevo Data

尽管构建自定义代码可能看起来是非常有利可图的选择,但仍有许多障碍,挑战和限制使其变得很费力。 实施类似Hevo的解决方案有助于实现PostgreSQL CDC到您选择的任何目标,而无需编写任何代码。

Postgres使用自定义代码更改数据捕获

方法1:使用Postgres审核触发器(Audit Triggers)

基于触发器的方法涉及在数据库上创建审核触发器,以捕获与INSERT,UPDATE和DELETE方法有关的所有事件。这种方法的优点是,一切都发生在SQL级别,并且开发人员只需要读取一个包含所有审核日志的单独表。

要在Postgres表中创建触发器,请执行以下命令。

SELECT audit.audit_table('target_table');

该语句将以具有访问审核模式权限的用户角色执行。写入表的应用程序一定不能使用超级用户角色连接到数据库。

如果要求不需要跟踪不经常更改的字段,则可以在特定字段的情况下关闭这些审核日志。

然后,我们有了一个捕获审计日志的表。开发人员仍然需要编写程序来读取和解析这些日志并将其推送到目标数据库中。此逻辑的复杂性还将取决于将数据推送到的目标数据库或数据仓库。

在PostgreSQL CDC中使用Postgres审计触发器的局限性

这种方法的缺点是触发器会影响数据库的性能。避免这种性能下降的常见做法是拥有一个单独的表来跟踪主表,并在第二个表上具有触发器。可以使用Postgres逻辑复制功能完成主表和辅助表之间的同步。

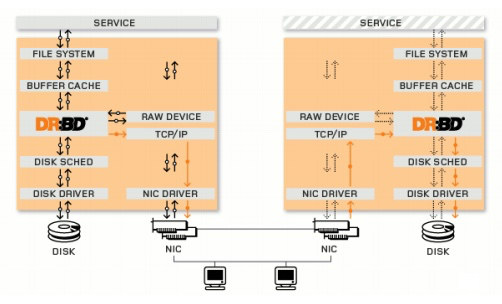

方法2:使用Postgres逻辑解码( Logical Decoding)

逻辑解码使用预写日志的内容来创建数据库中发生的活动的日志。预写日志是内部日志,描述了存储级别上的数据库更改。这种方法的优点是它不会以任何方式影响数据库的性能。

该方法基于输出插件的安装而工作。为了启用逻辑解码,需要在Postgres配置中设置以下参数。

wal_level = logical max_replication_slots = 10

设置完这些参数后,执行以下命令以创建逻辑解码槽。

SELECT * FROM pg_create_logical_replication_slot('slot_repl', 'decode_test');这将确保对表的每次更新都将创建可在视图选择语句中访问的审计事件。 逻辑解码支持两种选择语句来访问这些事件。 以下命令可用于窥视事件,

SELECT * FROM pg_logical_slot_peek_changes('slot_repl', NULL, NULL);要使用或获取结果,请使用以下命令。

SELECT * FROM pg_logical_slot_get_changes('slot_repl', NULL, NULL);“消费”和“窥视”之间的区别在于,第二条命令在消费事件后便将其删除。 让我们尝试通过一个例子来理解这一点。

假设有一个学生表,我们在该表中插入了一个条目。

Insert into students (id, name, age) values (1, ‘Peter’, '30');

一旦执行了peek命令,结果将如下所示。

SELECT * FROM pg_logical_slot_peek_changes('slot_repl', NULL, NULL);0/16CEE88 | 102 | BEGIN 102 0/16CEE88 | 102 | table public.students: INSERT: id[integer]:1 name[character varying]:' Peter' age[integer]:30 0/16CEFA0 | 102 | COMMIT 102

同样,如果我们执行相同的命令,您仍然会看到相同的审核事件。

SELECT * FROM pg_logical_slot_peek_changes('slot_repl', NULL, NULL);0/16CEE88 | 102 | BEGIN 102 0/16CEE88 | 102 | table public.students: INSERT: id[integer]:1 name[character varying]:' Peter' age[integer]:30 0/16CEFA0 | 102 | COMMIT 102

现在执行get命令。

SELECT * FROM pg_logical_slot_get_changes('slot_repl', NULL, NULL);0/16CEE88 | 102 | BEGIN 102 0/16CEE88 | 102 | table public.students: INSERT: id[integer]:1 name[character varying]:' Peter' age[integer]:30 0/16CEFA0 | 102 | COMMIT 102

结果是一样的。 但是,如果再次执行相同的命令或peek命令,则会发现结果为零。

SELECT * FROM pg_logical_slot_get_changes('slot_repl', NULL, NULL);

(0 rows)这意味着当执行get命令时,将提供结果并删除结果,从而大大增强了我们编写使用这些事件创建表副本的逻辑的能力。

Postgres还支持使用输出插件-基本上是c程序,可以基于INSERT,UPDATE和DELETE事件执行,并将事件转换为更加用户友好的格式。 Wal2json是一个这样的插件,可以以JSON格式输出这些事件。大多数Degrecium之类的Postgres CDC附件都广泛使用了此插件。

这里要注意的一点是,这些事件不会捕获表的创建和修改步骤。

对Postgres CDC使用Postgres逻辑解码的缺点

同样,在这种情况下,开发人员需要编写复杂的逻辑来处理这些事件,然后将其转换为目标数据库的语句。根据您要解决的用例,这可能会增加项目时间表。

方法3:使用时间戳列

Postgres引擎提供了以上两种方法来实现CDC。如果您在表中具有timestamp列的灵活性,那么还有一个稍微复杂的自定义方法。这意味着开发人员将需要定期查询表并监视对timestamp列的更改。当检测到更改时,脚本可以创建适当的数据库语句以将这些更改写入目标数据库。但是,这种方法需要大量的精力,并且需要开发人员花费大量的时间和精力。

简而言之,即使Postgres提供了通过触发器,逻辑解码或通过自定义逻辑的连续同步支持,开发人员仍然需要捕获这些事件并将其转换为目标数据库。根据用例,将需要为不同的目标数据库专门编写此逻辑。一种替代方法是使用像Hevo这样的基于云的服务,该服务可以使用Postgres CDC将数据连续同步到大多数目的地。

设置POSTGRESQL更改数据捕获的简便方法

Hevo是一个完全托管的数据集成平台,可以帮助您将数据从PostgreSQL实时加载到您选择的任何目标,而无需编写任何代码。

Hevo开箱即用地支持Postgres CDC,并提供了一个点击式视觉界面来启用更改数据捕获。 您只需要将Hevo指向Postgres数据库中的auto-crementing列或timestamp列即可。

Hevo将完成所有艰苦的工作,并确保您的Postgres数据始终在目标数据库/数据仓库中是最新的。

本文:http://jiagoushi.pro/node/1041

讨论:请加入知识星球【首席架构师圈】或者小号【cea_csa_cto】

- 1344 次浏览

【PostgreSQL】PostgreSQL变更数据捕获(CDC):完整指南

视频号

微信公众号

知识星球

本指南帮助您开始将CDC与PostgreSQL数据库系统一起使用。

目录

- 介绍

- PostgreSQL中使用触发器的变更数据捕获

- PostgreSQL中使用查询进行变更数据捕获

- PostgreSQL中带有逻辑复制的变更数据捕获

- 总结

介绍

PostgreSQL是一个著名的开源数据库管理系统,目前正在众多企业生产。在典型的设置中,PostgreSQL管理应用程序的事务数据,例如电子商务商店中的产品,并集成第三方数据系统用于其他目的,例如用于分析的数据仓库、用于报告的BI工具等。

连接PostgreSQL与其他数据存储的传统方法是基于批处理的。数据管道时不时地从PostgreSQL中提取所有数据并发送到下游的数据存储中,这不仅效率低下,而且容易出错。

变更数据捕获(CDC)是一种现代的替代方案,可以从PostgreSQL中实时提取记录级变更事件(插入、更新和删除)。变更数据捕获的主要好处是:

- CDC实时捕获更改事件,保持下游系统(如数据仓库)始终与PostgreSQL同步,并启用完全事件驱动的数据体系结构。

- 使用CDC可以减少PostgreSQL的负载,因为只处理相关信息,例如更改。

- CDC支持高效地实现需要访问PostgreSQL更改事件(如审核或更改日志)的用例,而无需修改应用程序代码。

在本文中,我们将提供一个完整的介绍,介绍如何将变更数据捕获与PostgreSQL结合使用。我们介绍了实现更改数据捕获的三种常用方法:触发器、查询和逻辑复制。虽然每种方法都有各自的优缺点,但在DataCate,我们最喜欢的是使用逻辑复制的基于日志的CDC。

在PostgreSQL中使用触发器更改数据捕获

使用PostgreSQL的触发器特性,我们可以侦听感兴趣的表中发生的所有插入、更新和删除事件,并为每个事件将一行插入第二个表中,从而构建变更日志。

PostgreSQL社区提供了一个通用触发器函数(代码),该函数支持PostgreSQL 9.1版及更高版本,并将所有更改事件存储在表audit.logged\u actions中。如果希望为表public.users启用基于触发器的更改数据捕获,则可以运行以下SQL语句:

SELECT audit.audit_table('public.users');为表public.users启用基于触发器的CDC。

CDC的这种方法只在PostgreSQL中存储捕获的事件。如果要将更改事件同步到其他数据系统(如数据仓库),则必须重复查询包含更改事件的PostgreSQL表(此处为audit.logged\u操作),这会增加实现的复杂性。

让我们比较一下在PostgreSQL中使用触发器实现更改数据捕获的优缺点:

- 可以立即捕获更改,从而实现更改事件的实时处理。

- 触发器可以捕获所有事件类型:插入、更新和删除。

- 默认情况下,此处使用的PostgreSQL触发器函数将有用的元数据添加到事件中,例如导致更改的语句、事务ID或会话用户名。

- 触发器会增加原始语句的执行时间,从而影响PostgreSQL的性能。

- 触发器需要更改PostgreSQL数据库。

- 如果更改事件应同步到同一PostgreSQL数据库以外的数据存储,则需要设置单独的数据管道,该管道轮询触发器函数(此处为audit.logged\u actions)填充的表。

- 创建和管理触发器会导致额外的操作复杂性。

在PostgreSQL中使用查询更改数据捕获

使用PostgreSQL实现更改数据捕获的第二种方法是基于查询的。

如果受监视数据库表的模式具有一个timestamp列,该列指示上一次更改行的时间,那么我们可以使用该列重复查询PostgreSQL,并请求自上次查询PostgreSQL以来已修改的所有记录。假设有一个名为public.users的表和一个名为updated\u at的时间戳列,这样的查询可以按如下方式实现:

SELECT * FROM public.users WHERE updated_at > 'TIMESTAMP_LAST_QUERY';示例:提取自上次访问时间以来已修改的所有用户的SQL查询(请替换TIMESTAMP\u last\u查询)。

请注意,基于查询的CDC无法捕获删除(除非使用软删除),但仅限于插入和更新事件。

- 如果模式具有指示行修改时间的timestamp列,则可以实现基于查询的CDC,而无需对PostgreSQL进行任何更改。

- 基于查询的CDC实现使用查询层提取数据,这给PostgreSQL带来了额外的负载。

- 基于查询的CDC需要对受监视表(此处为public.users)进行周期性轮询,如果数据很少更改,这将浪费资源。

- 基于查询的CDC需要一个列(此处为updated\u at)来跟踪记录上次修改的时间。

- 基于查询的CDC无法捕获删除事件(除非应用程序使用软删除)。

在PostgreSQL中使用逻辑复制更改数据捕获

自9.4版以来,PostgreSQL提供了逻辑复制,以便在可能不同的物理机器上的不同PostgreSQL实例之间高效、安全地复制数据。从技术上讲,它是一个磁盘上的预写日志,它保存更改PostgreSQL数据库数据的所有事件,例如插入、更新和删除。

PostgreSQL使用具有发布服务器和订阅服务器的订阅模型来实现逻辑复制。为了实现变更数据捕获,我们可以使用感兴趣的数据库作为发布者并订阅其日志。

虽然许多数据库系统可能已经使用复制,但默认情况下不启用复制。您可以通过对配置文件postgresql.conf引入以下更改来启用逻辑复制。

wal_level = logical

在postgresql.conf中启用逻辑复制。

在下一步中,您需要修改配置文件pga\u hba.conf以允许复制(请参阅PostgreSQL文档了解各个配置):

host all repuser 0.0.0.0/0 md5

允许在pga\u hba.conf中进行逻辑复制。

假设您要从public.users表中捕获更改。您可以通过创建新发布为该表启用CDC,如下所示:

CREATE PUBLICATION newpub FOR TABLE public.users;为表public.users创建发布。

在下一步中,您可以开始订阅此出版物。订阅从初始快照开始,然后复制所有增量更改。如果要使用另一个PostgreSQL实例中的事件,可以按如下方式创建订阅:

CREATE SUBSCRIPTION newsub CONNECTION 'dbname=foo host=bar user=repuser' PUBLICATION newpub;为使用更改创建订阅。

从技术上讲,逻辑复制是通过逻辑解码插件实现的。如果您使用的PostgreSQL版本早于10,则需要在PostgreSQL数据库中手动安装插件,例如wal2json或decoderbufs。从版本10开始,PostgreSQL默认提供插件pgoutput。

对于基于日志的变更数据捕获的技术实现,我们强烈建议使用现有的开源项目之一,例如Debezium。DataCate的PostgreSQL源连接器基于Debezium。

据我们所知,大多数托管PostgreSQL服务都提供对逻辑复制的支持,例如AWS RDS、Google Cloud SQL或Azure数据库。

下表显示了使用PostgreSQL的逻辑复制实现CDC的优缺点:

- 基于日志的CDC支持实时捕获事件驱动的数据更改。下游应用程序始终可以访问来自PostgreSQL的最新数据。

- 基于日志的CDC可以检测PostgreSQL中的所有更改事件类型:插入、更新和删除。

- 通过逻辑复制使用事件归结为直接访问文件系统,这不会影响PostgreSQL数据库的性能。

- 非常旧版本的PostgreSQL(早于9.4)不支持逻辑复制。

总结

在比较使用PostgreSQL实现变更数据捕获的三种方法时,使用逻辑复制显然是胜利者。它不仅高效、实时捕获所有事件类型而不损害PostgreSQL数据库的性能,而且广泛可用(无论您使用的是自管理还是托管PostgreSQL安装),并且在不更改数据库模式的情况下适用。

CDC连接器通常比传统的SELECT*FROM表更复杂;查询。在DataCate中,我们提供用于更改数据捕获的即插即用连接器,它使您能够在几分钟内使用PostgreSQL设置基于日志的CDC,并降低操作复杂性。试试看!

- 918 次浏览

【PostgreSQL】PostgreSQL在性能和可伸缩性方面是否与SQL SERVER匹配?

数据库系统的性能和可伸缩性可以对任何项目产生重大影响。在许多情况下,开发人员必须从一个数据库系统迁移到另一个数据库系统,以提高数据库密集型应用程序的性能和操作速度。不仅如此,每个应用程序都会进行修改,以获得更好的用户体验,并引入新功能,对数据库存储的需求也会大大增加。如果您的应用程序的数据库系统没有提供健壮的可伸缩性功能,并且如果随着负载的增加性能受到影响,那么应用程序的受欢迎程度将受到影响。今天,让我们来比较两个最流行的数据库系统MS SQL Server和PostgreSQL的性能和可伸缩性因素。

性能-

并发性-

并发性是决定数据库系统性能的一个重要因素。并发性是指多个进程可以同时访问和修改共享数据的特性。在每一个应用程序中,某些数据被运行的各种并发进程共享,数据的这种并发性可以是健壮的,数据库和应用程序的性能将是更快、更完美的。SQL Server的并发性不足,您肯定会在日志中得到各种锁定、阻止和死锁的报告。这会导致数据管理不当,应用程序的进程变得非常缓慢。相比之下,PostgreSQL具有更好的并发管理系统,并且由于其优化MVCC的特性,死锁的可能性更小。

分区-

与并发性一样,分区也是数据库系统的一大特性。分区是将大表分成小部分的过程。随着数据库大小,特别是表大小的增长,分区是很重要的。这有助于在访问分数数据而不是整个大表时提高性能。从可伸缩性的角度来看,分区也很重要。随着应用程序规模的增大,数据库会变得很大,如果不进行拆分,数据库会变得更大,访问数据将需要很多时间。至于SQL Server,有一个合适的分区特性,但是你必须购买这个特性作为附加组件,而在PostgreSQL中,你可以以更低的价格和更高的效率获得它。

索引-

技术更新的速度比以往任何时候都快。在这种情况下,SQL Server在几年后发布新版本的方法已经过时。PostgreSQL定期发布更新版本,并紧跟潮流,提供更快的性能。接下来,PostgreSQL的可索引函数特性将把数据库的性能提升到另一个级别。不仅如此,PostgreSQL还支持模块或扩展,您可以做很多SQL server无法做到的事情。由于缺乏正确的索引实现是SQL server,它们省略了一个最常用的变量系统array。

可扩展性-

数据库系统的可伸缩性直接取决于数据的压缩能力。理想情况下,数据库系统必须具有先进的现成的压缩技术。在某些数据库系统中,开发人员必须手动压缩,不仅耗时而且效率低下。MS SQL Server提供了开箱即用的压缩,但您必须手动实现它。另一方面,PostgreSQL免费提供,整个过程是自动的。

平台-

在当今世界,应用程序必须是通用的。这意味着每个操作系统的人,无论是Windows、Linux、Mac还是其他什么,都应该可以访问应用程序。数据库系统也应该如此,这样开发人员可以根据自己的选择在任何操作系统上工作。由于SQL Server是微软的产品,它只能在Windows上运行,而拥有Mac或Linux的开发人员不能在它上工作。这是开发可伸缩性和灵活性方面的一个主要缺点。值得庆幸的是,PostgreSQL在每一个平台上都能工作,为开发人员开辟了一条新的途径。这也是将数据库从SQL Server迁移到PostgreSQL的主要原因之一,因为各种商业公司的开发人员都在基于Mac的计算机上开发应用程序。JSON和JavaScript统治着web世界,PostgreSQL支持JSON。您可以正确地同步客户机、服务器和数据库,但SQL server仍然停留在XML上。甚至PostgreSQL的数据类型也优于SQL server,克服了所有缺点,使PostgreSQL具有更好的性能和可扩展性。

最终裁决-

PostgreSQL不仅与SQL Server的性能或可伸缩性相匹配,而且在多个参数上都明显优于sqlserver。就企业级而言,它的定价比SQL Server好,而且在PostgreSQL中有一些特性是免费的,而sqlserver对它们收费很高。

本文:http://jiagoushi.pro/does-postgresql-match-sql-server-terms-performance-and-scalability

讨论:请加入知识星球【首席架构师圈】或者微信小号【jiagoushi_pro】

- 44 次浏览

【PostgreSQL】SQL还是NoSQL?为什么不同时使用(与PostgreSQL一起使用)?

视频号

微信公众号

知识星球

对于任何一个开始新项目的开发人员来说,这都是一个艰难的决定。您应该将数据存储在标准的、经过时间测试的SQL数据库中,还是使用较新的基于NoSQL文档的数据库?这个看似简单的决定实际上可以决定你的项目的成败。正确选择并构建好数据结构,你就可以顺利进入生产阶段,看着你的应用程序起飞。如果选择错误,你可能会在应用程序问世之前做噩梦(甚至可能会进行一些重大重写)。

简洁与强大

SQL和NoSQL解决方案都存在折衷。通常,开始使用NoSQL数据结构更容易,尤其是在数据复杂或层次结构时。您只需从前端代码中获取一个JSON数据对象,并将其放入数据库中即可完成操作。但以后,当您需要访问该数据来回答一些基本的业务问题时,这将更加困难。SQL解决方案使收集数据和得出结论变得更加容易。让我们看一个例子:

每天我都会跟踪我吃的食物,以及每种食物中的卡路里数:

| Day | Food Item | Calories | Meal |

|---|---|---|---|

| 01 Jan | Apple | 72 | Breakfast |

| 01 Jan | Oatmeal | 146 | Breakfast |

| 01 Jan | Sandwich | 445 | Lunch |

| 01 Jan | Chips | 280 | Lunch |

| 01 Jan | Cookie | 108 | Lunch |

| 01 Jan | Mixed Nuts | 175 | Snack |

| 01 Jan | Pasta/Sauce | 380 | Dinner |

| 01 Jan | Garlic Bread | 200 | Dinner |

| 01 Jan | Broccoli | 32 | Dinner |

我还跟踪我喝的水的杯数以及何时喝:

| Day | Time | Cups |

|---|---|---|

| Jan 01 | 08:15 | 1 |

| Jan 01 | 09:31 | 1 |

| Jan 01 | 10:42 | 2 |

| Jan 01 | 12:07 | 2 |

| Jan 01 | 14:58 | 1 |

| Jan 01 | 17:15 | 1 |

| Jan 01 | 18:40 | 1 |

| Jan 01 | 19:05 | 1 |

最后,我跟踪我的锻炼:

| Day | Time | Duration | Exercise |

|---|---|---|---|

| Jan 01 | 11:02 | 0.5 | Walking |

| Jan 02 | 09:44 | 0.75 | Bicycling |

| Jan 02 | 17:00 | 0.25 | Walking |

对于每一天,我还跟踪我当前的体重以及当天的任何笔记:

| Day | Weight | Notes |

|---|---|---|

| Jan 01 | 172.6 | This new diet is awesome! |

| Jan 14 | 170.2 | Not sure all this is worth it. |

| Jan 22 | 169.8 | Jogged past a McDonald's today. It was hard. |

| Feb 01 | 168.0 | I feel better, but sure miss all that greasy food. |

收集所有数据

需要收集、存储、检索和稍后分析大量不同的数据。它的组织简单而容易,但记录的数量每天都有所不同。在任何一天,我可能没有或更多关于食物、水和锻炼的条目,我可能有零或一个关于体重和笔记的条目。

在我的应用程序中,我在一个页面上收集一天的所有数据,让我的用户更轻松。因此,我每天都会得到一个JSON对象,如下所示:

{

"date": "2022-01-01",

"weight": 172.6,

"notes": "This new diet is awesome!",

"food": [

{ "title": "Apple", "calories": 72, "meal": "Breakfast" },

{ "title": "Oatmeal", "calories": 146, "meal": "Breakfast" },

{ "title": "Sandwich", "calories": 445, "meal": "Lunch" },

{ "title": "Chips", "calories": 280, "meal": "Lunch" },

{ "title": "Cookie", "calories": 108, "meal": "Lunch" },

{ "title": "Mixed Nuts", "calories": 175, "meal": "Snack" },

{ "title": "Pasta/Sauce", "calories": 380, "meal": "Dinner" },

{ "title": "Garlic Bread", "calories": 200, "meal": "Dinner" },

{ "title": "Broccoli", "calories": 32, "meal": "Dinner" }

],

"water": [

{ "time": "08:15", "qty": 1 },

{ "time": "09:31", "qty": 1 },

{ "time": "10:42", "qty": 2 },

{ "time": "10:42", "qty": 2 },

{ "time": "12:07", "qty": 1 },

{ "time": "14:58", "qty": 1 },

{ "time": "17:15", "qty": 1 },

{ "time": "18:40", "qty": 1 },

{ "time": "19:05", "qty": 1 }

],

"exercise": [{ "time": "11:02", "duration": 0.5, "type": "Walking" }]

}保存数据

一旦我们收集了一天的所有数据,我们就需要将其存储在数据库中。在NoSQL数据库中,这可能是一个非常简单的过程,因为我们只需为特定日期的特定用户创建一个记录(文档),然后将文档放入集合中,就完成了。使用SQL,我们有一些必须在其中工作的结构,在这种情况下,它看起来像4个独立的表:食物、水、锻炼和笔记。我们想在这里做4个单独的插入,每个表一个。如果我们没有特定表格的数据(比如今天没有记录锻炼),那么我们可以跳过该表格。

如果您使用SQL来存储这些数据,您可能希望在数据输入表单中输入每个表的数据时保存该表的数据(而不是等到输入完所有数据后再保存。)或者您可能希望创建一个数据库函数,该函数获取所有JSON数据,对其进行解析,并在单个事务中将其写入所有相关表。有很多方法可以处理这一问题,但只要这样说就足够了:这比将数据保存在NoSQL数据库中要复杂一些。

检索数据

如果我们想显示一天的所有数据,那基本上是一样的。使用NoSQL,您可以获取用户当天的数据,然后在应用程序中使用它。美好的使用SQL,我们需要查询4个表来获取所有数据(或者我们可以使用一个函数在一次调用中获取所有数据。

分析数据

现在我们已经保存了数据,并且可以检索和显示它,让我们使用它进行一些分析。让我们展示一张我在过去一个月里总共摄入了多少卡路里的图表。使用SQL,这是一项简单的任务:

select date, sum(calories) as total_calories from food_log group by date where user_id = 'xyz' and day between '2022-01-01' and '2022-01-31' order by date;

砰!完成!现在我们可以把这些结果发送到我们的绘图库,并把我的饮食习惯画得很漂亮。

但是,如果我们将这些数据存储在NoSQL中,它会变得更加复杂。我们需要:

- 为用户获取当月的所有数据

- 解析每天的数据以获得食物日志信息

- 每天循环并计算热量

- 将聚合数据发送到我们的绘图模块

如果这是我们要定期做的事情,那么计算每天的总热量并将其存储在当天的文档中是有意义的,这样我们就可以更快地获取数据。但这需要更多的前期工作,我们仍然需要提取每天的数据,并首先解析出卡路里总量。如果我们更新数据,我们仍然需要重新计算并更新总数。最终,我们会想在水和运动总量方面做到这一点。代码最终会变得越来越长、越来越复杂。

SQL和NoSQL在一起-FTW

让我们看看如何在同一个数据库中使用SQL的强大功能和NoSQL的易用性,使这一切变得更容易。我们将为每天的数据(为每个用户)创建一个表,并首先存储权重和注释等基本字段。然后,我们将在JSONB字段中抛出food_log、water_log和exercise_log字段。

CREATE TABLE calendar (

id uuid DEFAULT gen_random_uuid() NOT NULL,

date date,

user_id uuid NOT NULL,

weight numeric,

notes text,

food_log jsonb,

water_log jsonb,

exercise_log jsonb

);

-- (Optional) - create a foreign key relationship for the user_id field

ALTER TABLE ONLY calendar

ADD CONSTRAINT calendar_user_id_fkey FOREIGN KEY (user_id) REFERENCES auth.users(id);

现在让我们在表中插入一些数据。PostgreSQL同时提供JSON和JSONB字段,由于后者更容易被数据库优化,查询处理速度更快,所以我们几乎总是希望使用JSONB。我们将使用food_log、water_log和exercise_log的JSONB字段,并将从应用程序中获得的数据作为字符串直接转储到这些字段中:

insert into calendar

(date, user_id, weight, notes, food_log, water_log, exercise_log)

values

(

'2022-01-01',

'xyz',

172.6,

'This new diet is awesome!',

'[

{ "title": "Apple", "calories": 72, "meal": "Breakfast"},

{ "title": "Oatmeal", "calories": 146, "meal": "Breakfast"},

{ "title": "Sandwich", "calories": 445, "meal": "Lunch"},

{ "title": "Chips", "calories": 280, "meal": "Lunch"},

{ "title": "Cookie", "calories": 108, "meal": "Lunch"},

{ "title": "Mixed Nuts", "calories": 175, "meal": "Snack"},

{ "title": "Pasta/Sauce", "calories": 380, "meal": "Dinner"},

{ "title": "Garlic Bread", "calories": 200, "meal": "Dinner"},

{ "title": "Broccoli", "calories": 32, "meal": "Dinner"}

]',

'[

{"time": "08:15", "qty": 1},

{"time": "09:31", "qty": 1},

{"time": "10:42", "qty": 2},

{"time": "10:42", "qty": 2},

{"time": "12:07", "qty": 1},

{"time": "14:58", "qty": 1},

{"time": "17:15", "qty": 1},

{"time": "18:40", "qty": 1},

{"time": "19:05", "qty": 1}

]',

'[

{"time": "11:02", "duration": 0.5, "type": "Walking"}

]'

);

虽然这是一个很大的insert语句,但它肯定比在4个单独的表上进行insert要好。对于所有这些食物条目和水日志条目,我们必须在主表中创建1个条目,然后是9个食物日志条目、9个水日志条目和一个锻炼日志条目,总共20个数据库记录。我们把它包装成一张唱片。

但是我们如何查询这些数据?

很好,我们现在正在收集数据,而且很容易将数据插入数据库。编辑数据也不算太糟,因为我们只是将数据下载到客户端,根据需要更新JSON字段,然后将它们扔回数据库。不太难。但我如何查询这些数据?以前的任务怎么样?让我们展示一张我在过去一个月里总共摄入了多少卡路里的图表。

在这种情况下,该数据存储在日历表的food_log字段中。如果PostgreSQL能够将JSONB数组转换为单独的数据库记录(记录集)就好了。的确如此!jsonb_array_elements函数将为我们做这件事,允许创建一个简单的表,我们可以使用它来计算我们的热量摄入。

以下是一些SQL,用于将food_log数组转换为单独的输出记录:

select user_id, date, jsonb_array_elements(food_log)->>'title' as title, jsonb_array_elements(food_log)->'calories' as calories, jsonb_array_elements(food_log)->'meal' as meal from calendar where user_id = 'xyz' and date between '2022-01-01' and '2022-01-31';

这将返回一个如下所示的表:

| date | title | calories | meal |

|---|---|---|---|

| 2022-01-01 | Apple | 72 | Breakfast |

| 2022-01-01 | Oatmeal | 146 | Breakfast |

| 2022-01-01 | Sandwich | 445 | Lunch |

| 2022-01-01 | Chips | 280 | Lunch |

| 2022-01-01 | Cookie | 108 | Lunch |

| 2022-01-01 | Mixed Nuts | 175 | Snack |

| 2022-01-01 | Pasta/Sauce | 380 | Dinner |

| 2022-01-01 | Garlic Bread | 200 | Dinner |

| 2022-01-01 | Broccoli | 32 | Dinner |

需要注意的几点:

- jsonb_array_elements(food_log)->>'title' as title 作为title这将返回一个文本字段,因为->>运算符返回text

- jsonb_array_elements(food_log)->'calories' as calories ,这返回一个JSON对象,因为->运算符返回JSON

如果我们想对卡路里求和以获得一些总数,我们就不能有JSON对象,所以我们需要将其转换为更有用的对象,比如INTEGER:

- (jsonb_array_elements(food_log)->'calories')::INTEGER as calories,返回一个整数

现在我们不能只在这个问题上加上求和运算来得到一天的总热量。如果我们尝试这样做:

select date, sum((jsonb_array_elements(food_log)->'calories')::integer) as total_calories from calendar where user_id = 'xyz' and date between '2022-01-01' and '2022-01-31' group by date;

我们从PostgreSQL得到一个错误:运行sql查询失败:聚合函数调用不能包含返回集合的函数调用。

相反,我们需要将其视为一组构建块,其中我们的第一条SQL语句返回一个表:

select date, (jsonb_array_elements(food_log)->'calories')::integer as calories from calendar where user_id = 'xyz' and date between '2022-01-01' and '2022-01-31';

现在,我们可以使用“table”语句,在它周围插入一些(括号),然后查询它:

with data as

(

select

date,

(jsonb_array_elements(food_log)->'calories')::integer as calories

from calendar

where user_id = 'xyz'

and date between '2022-01-01' and '2022-01-31'

)

select date, sum(calories)

from data

group by date;

这正是我们想要的:

| date | sum |

|---|---|

| 2022-01-01 | 1838 |

如果我们在这个月剩下的日子里添加更多的数据,我们将拥有一个漂亮的图表所需的所有数据。

搜索数据

如果我们想回答这个问题:我上个月吃的大蒜面包里有多少卡路里?这些数据存储在日历表的food_log字段中。我们可以使用以前使用的相同类型的查询来“压平”food_log数据,以便进行搜索。

要获得我在一月份吃的每一件东西,我们可以使用:

select date, jsonb_array_elements(food_log)->>'title' as title, (jsonb_array_elements(food_log)->'calories')::integer as calories from calendar where user_id = 'xyz' and date between '2022-01-01' and '2022-01-31'

现在,为了搜索大蒜面包,我们可以在它周围放(括号)来制作一张“桌子”,然后搜索我们想要的物品:

with my_food as

(

select

date,

jsonb_array_elements(food_log)->>'title' as title,

(jsonb_array_elements(food_log)->'calories')::integer as calories

from calendar

where user_id = 'xyz'

and date between '2022-01-01' and '2022-01-31'

)

select

title,

calories

from my_food

where title = 'Garlic Bread';这给了我们:

| title | calories |

|---|---|

| Garlic Bread | 200 |

结论

如果我们花一点时间研究PostgreSQL提供的JSON函数和运算符,我们可以将Postgres变成一个易于使用的NoSQL数据库,它仍然保留了SQL的所有功能。这为我们在数据库中存储来自应用程序代码的复杂JSON数据提供了一种非常简单的方法。然后,我们可以使用强大的SQL功能来分析数据,并在应用程序中显示这些数据。这是两全其美!

- 52 次浏览

【PostgreSQL】使用PostgreSQL和ApacheAGE实现多模型:图形数据库的实验

视频号

微信公众号

知识星球

让我们探索多种可用的数据库,并使用PostgreSQL和ApacheAGE进行图形模型实验

数据库环境

当谈到数据库时,对大多数人来说,第一个想到的是经典的关系数据库,或者他们经常提到的SQL数据库。在这些数据库中,数据存储在表中的行和列中,这些行和列可以通过外键相关联,外键是一个或多个链接回另一个表中行的主键(也称为ID)的列。

近五十年来,关系数据库一直是常态,但近年来,出现了其他类型的数据库来处理关系模型可能显示其局限性(主要是性能和可扩展性)的特定用例。

在过去的十五年里,已经创建了许多不同类型的数据库,如列数据库(例如AWS Dynamo DB或Apache Cassandra)、文档数据库(MongoDB或CouchDB)和图形数据库(Neo4J)。

创建这些新形式的数据库中的每一种都是为了更好地满足特定应用程序领域的需求,并提高传统关系系统的性能和可扩展性。

为什么要使用图形数据库

如果我们谈论存储数据并能够查询数据,那么关系数据库几乎可以很好地对每个应用程序领域进行建模。但在某些情况下,关系模型在性能或复杂性方面并不是最佳选择。在这些上下文中,关系与实体本身具有相同甚至更大的含义。

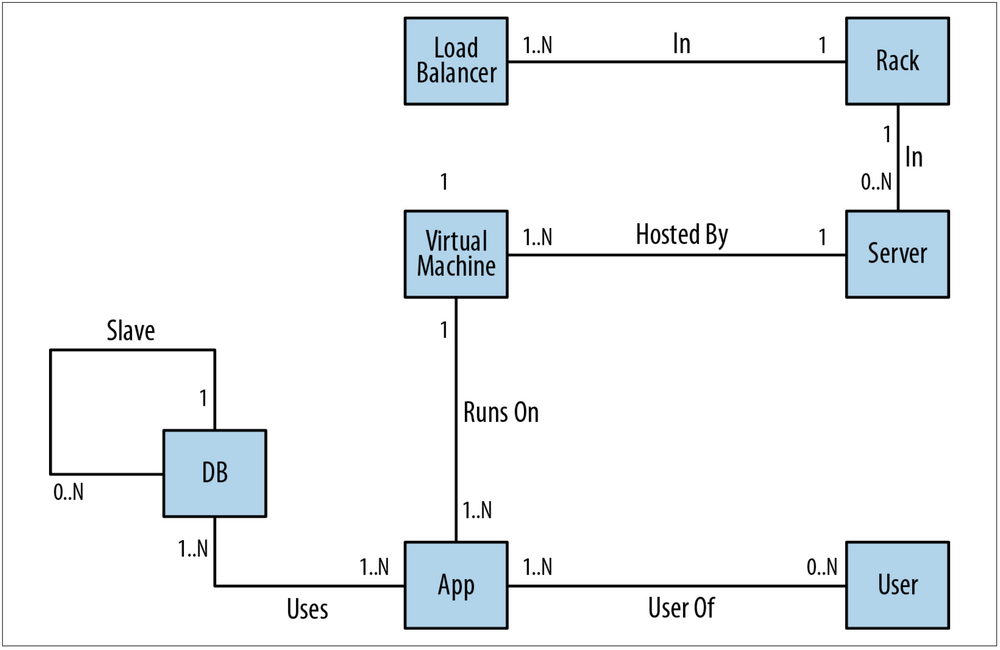

让我们借用《图形数据库》第二版一书中关于数据中心域上下文的一个例子(您可以从Neo4J网站上获取该书的副本)。

A Datacenter ER example model

这仍然是一个非常简单的域上下文,但它有足够数量的实体和关系,可以开始使传统数据库上的查询变得又大又慢。

以下是先前ER模型上的密钥和关系的可能建模

现在,让我们试着想象一个查询,它查找受基础结构的某个组件(服务器、负载均衡器、数据库等)故障影响的用户。您可能会得到一个带有许多JOIN的怪物查询,或者有很多小查询,每个查询都指向模型中的特定资产。当然,我们将能够得到问题的答案,但性能可能会成为一个问题,尤其是当资产数量开始增长时。

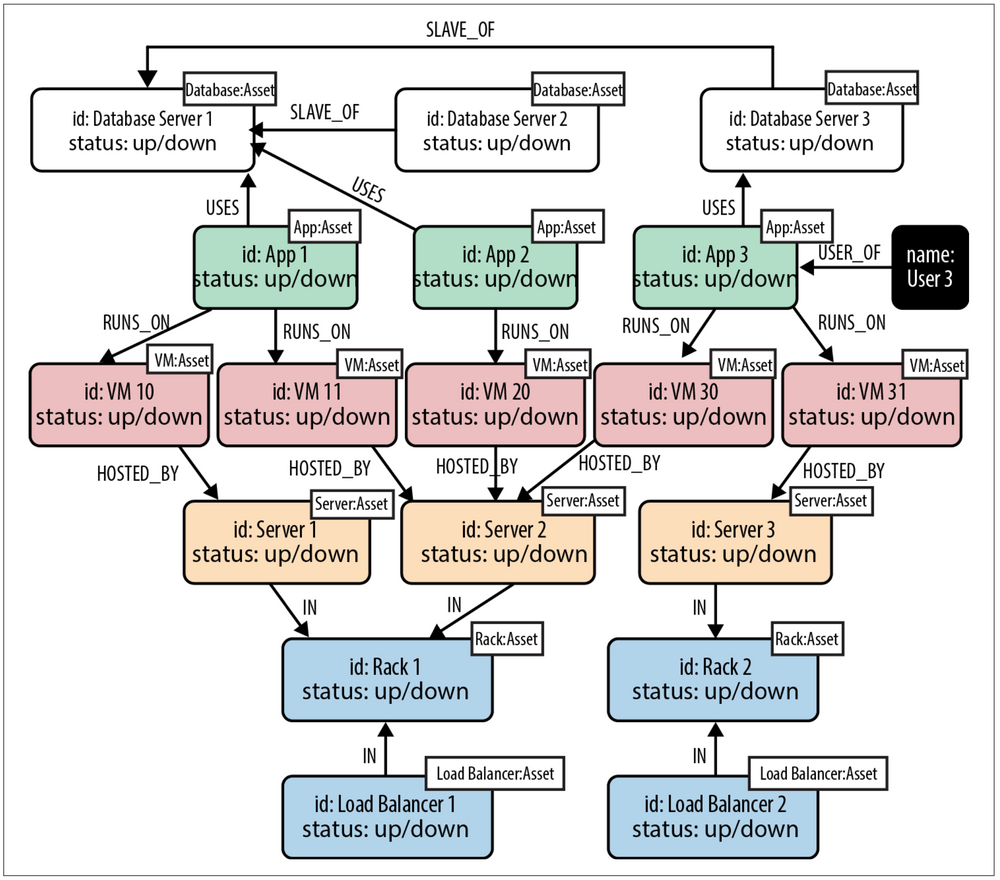

现在,让我们尝试将上一个域建模为具有资产和它们之间关系的Graph。

Example graph model for the Datacenter context

首先你可以注意到,现在关系已经成为模型中的“头等公民”,这意味着现在每个箭头都有一个特定的含义,比如HOSTED_BY、RUNS_ON、USES、USER_OF等等。在关系模型中,您只知道一个表链接到另一个表,但这种关系的含义可能很难理解。

例如,如果现在前一张图片的用户3报告了一个问题,我们可以通过发出以下查询来查询该图,以查找任何可能涉及的资产:

MATCH (user:User)-[*1..5]-(asset:Asset)

WHERE user.name = 'User 3' AND asset.status = 'down'

RETURN DISTINCT asset等待这是什么样的疑问?!?这是一种名为Cypher的查询语言,由Neo4J引入,旨在以一种简单的方式查询图。它被定义为“在图表中导航的某种ASCIIart”。

前面的查询用通俗英语翻译如下:查找任何名为“用户3”的用户,该用户与状态为“向下”的资产有一到五个关系,然后返回找到的不同资产列表。

如果你在SQL中也这么想。。。这可能吗?可能是的,但不是以如此简短和富有表现力的方式。现在,您应该开始了解图形模型的要点了。

NEO4J

我们之前讨论过Neo4J作为一个图形数据库,有充分的理由,它是市场上最广为人知的图形数据库,它已经存在了十多年,所以它非常坚固,经过了战斗测试。

但是,如果我必须在Neo4J中找到我不喜欢的东西,那就是Graph Only,所以传统的关系数据库没有“平稳过渡”,如果你已经编写了一些软件,你必须重写所有内容才能使用新的数据模型。除此之外,Neo4J是用Java编写的,即使我每天都使用Java进行应用程序开发,我也有偏见地认为用Java编写数据库可能有点内存不足。

不要误解我的意思,如果你需要使用纯图数据模型,Neo4J仍然是最好的选择,它有很多功能,如果你想要支持,开发它的公司会提供企业支持。

一种混合方法

我想在我的应用程序中介绍图数据库的强大功能,但正如一切一样,没有一刀切的方法,图数据库也不例外,它们有利于图遍历,但不是所有可能场景的最佳选择。

应用程序的需求有时可能涉及广泛,在谈论数据库时,最好是将数据模型的一部分作为图,另一部分作为一组表,也许另一部分在文档集合中。问题是,我不喜欢在同一个应用程序中使用许多不同的数据库引擎。

有解决办法吗?

PostgreSQL与Apache AGE

PostgreSQL在数据库领域是一个众所周知的名字,原因有很多。举几个例子,它是可用的最强大的开源数据库之一,同时它坚如磐石,性能卓越。有几十兆字节的PostgreSQL数据库的例子。

PostgreSQL的一个好处是,它允许使用扩展来增强数据库本身的功能,并且有许多强大的扩展允许PostgreSQL跨越许多不同的上下文。扩展示例如下:

- TimescaleDB:处理时间序列和窗口的扩展

- PostGIS:用于地理信息系统(GIS)的扩展,允许使用坐标和地理空间计算

- ZomboDB:在与Elasticsearch集成的同时增强PostgreSQL全文搜索功能的扩展

Apache AGE(其中AGE代表“图形扩展”)是其中的另一个扩展,它是关系数据库、文档数据库和图形数据库世界之间的桥梁,利用PostgreSQL数据库的稳定性和稳定性,同时利用图形数据库的强大功能增强其功能。

AGE仍在Apache孵化器中,这意味着它仍处于早期开发阶段(当前版本i 0.7),但它是基于BitNine的AgentsGraph所做的工作,即使采用了不同的方法。AgentsGraph是一个基于PostgreSQL 10分支构建的商业图形数据库,而Apache AGE是作为标准PostgreSQL的扩展构建的(在撰写本文时,它支持版本11,但预计2022年会支持新版本),因此它可以用作标准功能的“升级”,而不会失去其余功能。

这种方法的好处在于,您可以将关系模型的特性与图数据库的特性混合在一起,这意味着您可以将表上的SQL查询与图上的OpenCyhpher查询混合在一起。

如果您认为PostgreSQL还支持JSON和JSONB数据类型,这样您就可以拥有文档数据库的部分功能,那么您就可以理解为什么这种混合解决方案是一个不错的选择。

让我们看看如何使用Docker开始使用ApacheAGE,然后在下一篇文章中,我们将看到OpenCyhper的一些功能以及与标准关系世界的集成。

使用Docker开始使用Apache AGE

开始使用Apache AGE的最快方法是在预构建的Docker容器中运行它,您可以使用以下命令来完成:

docker run -it -e POSTGRES_PASSWORD={MyPassword} -p {HostPort}:5432 sorrell/apache-age这是Docker的“官方”镜像,但在撰写本文时,它已经有三个月的历史了,所以它没有最近添加的所有功能和错误修复。为了测试所有功能,让我们使用GitHub repo的最新来源构建一个新的映像。

使用Docker从源代码构建最新版本

- GitHub - apache/incubator-age: Graph database optimized for fast analysis and real-time data processing. It is provided as an extension to PostgreSQL.

- Graph database optimized for fast analysis and real-time data processing. It is provided as an extension to PostgreSQL. - GitHub - apache/incubator-age: Graph database optimized for fast analysis a...

- GitHubapache

您可以认为从源代码构建Docker映像可能是一个复杂的过程,但实际上这很容易,只需使用以下命令在您的机器上克隆存储库即可:

git clone https://github.com/apache/incubator-age.git

cd incubator-age并告诉Docker构建镜像:

docker build -t apache/age .几分钟后(取决于网络连接的速度和计算机的电源),该过程应该完成。

使用Docker启动AGE实例

要使用PostgreSQL 11和AGE扩展启动新建映像的实例,可以运行以下命令:

docker run -it -e POSTGRES_PASSWORD=mypassword -p 5432:5432 apache/age一旦容器启动,您就可以连接到数据库并开始使用SQL和OpenCypher。

如果您更喜欢查询输出的图形表示,还可以试用AGE Viewer,这是一个node.js应用程序(处于早期开发阶段),允许您直接在浏览器内以图形或表格的方式查询和导航结果。

- GitHub - apache/incubator-age-viewer: Graph database optimized for fast analysis and real-time data processing. It is provided as an extension to PostgreSQL.

- Graph database optimized for fast analysis and real-time data processing. It is provided as an extension to PostgreSQL. - GitHub - apache/incubator-age-viewer: Graph database optimized for fast ana...

- GitHubapache

正在连接到数据库

使用ApacheAGE的另一个好处是,您正在使用标准的PostgreSQL数据库进行数据处理,因此要连接到它,您可以使用标准的psql命令行客户端

psql -h 0.0.0.0 -p 5432 -U postgres

or your preferred SQL client, like DBeaver.

如果在启动时未自动加载AGE扩展,则可以通过发出以下SQL命令来启用AGE扩展:

CREATE EXTENSION IF NOT EXISTS age;

LOAD 'age';

SET search_path = ag_catalog, "$user", public;

现在您已经准备好开始使用新的图形数据库了。

创建图形

开始玩grap模型需要做的第一件事是…创建一个图形。您可以使用create_graph('graph_NAME')函数执行此操作:

SELECT create_graph('my_graph_name');创建图形后,您可以使用Cypher('graph_NAME',QUERY)函数执行Cypher命令,如下所示:

SELECT * from cypher('my_graph_name', $$

CypherQuery

$$) as (a agtype);

例如,要创建节点(或图形语言中的“顶点”),可以运行:

SELECT * from cypher('my_graph_name', $$

CREATE (a:User { firstName: 'Fabio', lastName: 'Marini'})

RETURN a

$$) as (a agtype);

这将创建一个带有标签User以及firstName和lastName属性的顶点。图形数据库的另一个好方面是,“顶点”和“边”都可以包含可以动态添加和查询的属性。

我们刚刚触及了图形数据库的表面,您可以查看AGE的文档来了解OpenCypher查询语言的功能和语法

- 313 次浏览

【PostgreSQL架构】PostgreSQL 10和逻辑复制-设置

This article is the result of a series of articles on logical replication in PostgreSQL 10

This one will focus on the implementation of logical replication.

- PostgreSQL 10 : Logical replication - Overview

- PostgreSQL 10 : Logical replication - Setup

- PostgreSQL 10 : Logical replication - Limitations

Table of Contents

Installation

When writing this article Postgres 10 is not released yet. However, the community provides packages of beta versions. Of course, do not use in production.

Repository installation (PostgreSQL Developpement Group)

From http://www.postgresql.org then “download” -> “debian”. On this page, the site tells you how to install the pgdg repository. However it will only offer stable versions. But, the site sends you to a wiki page:

For more information about the apt repository, including answers to frequent questions, please see the apt page on the wiki.

You will find :

For packages of development/alpha/beta versions of PostgreSQL, see the FAQ entry about beta versions.

Who tells you :

To use packages of postgresql-10, you need to add the 10 component to your

/etc/apt/sources.list.d/pgdg.listentry, so the 10 version of libpq5 will be available for installation

So for debian, commands are :

wget --quiet -O - https://www.postgresql.org/media/keys/ACCC4CF8.asc | sudo apt-key add -

sudo sh -c 'echo "deb http://apt.postgresql.org/pub/repos/apt/ $(lsb_release -cs)-pgdg main 10" > /etc/apt/sources.list.d/pgdg.list'

sudo apt-get update

Packages installation

sudo apt install postgresql-10

Create instances

A first instance is created during installation. We will install a second one. Thus one will be the publisher and the other will be subscriber. So for debian, commands are:

# pg_lsclusters

Ver Cluster Port Status Owner Data directory Log file

10 main 5432 online postgres /var/lib/postgresql/10/main /var/log/postgresql/postgresql-10-main.log

# pg_createcluster 10 sub

Creating new PostgreSQL cluster 10/sub ...

/usr/lib/postgresql/10/bin/initdb -D /var/lib/postgresql/10/sub --auth-local peer --auth-host md5

The files belonging to this database system will be owned by user "postgres".

This user must also own the server process.

The database cluster will be initialized with locale "en_US.UTF-8".

The default database encoding has accordingly been set to "UTF8".

The default text search configuration will be set to "english".

Data page checksums are disabled.

fixing permissions on existing directory /var/lib/postgresql/10/sub ... ok

creating subdirectories ... ok

selecting default max_connections ... 100

selecting default shared_buffers ... 128MB

selecting dynamic shared memory implementation ... posix

creating configuration files ... ok

running bootstrap script ... ok

performing post-bootstrap initialization ... ok

syncing data to disk ... ok

Success. You can now start the database server using:

/usr/lib/postgresql/10/bin/pg_ctl -D /var/lib/postgresql/10/sub -l logfile start

Ver Cluster Port Status Owner Data directory Log file

10 sub 5433 down postgres /var/lib/postgresql/10/sub /var/log/postgresql/postgresql-10-sub.log

# pg_ctlcluster 10 sub start

# pg_lsclusters

Ver Cluster Port Status Owner Data directory Log file

10 main 5432 online postgres /var/lib/postgresql/10/main /var/log/postgresql/postgresql-10-main.log

10 sub 5433 online postgres /var/lib/postgresql/10/sub /var/log/postgresql/postgresql-10-sub.log

Logical replication setup

Prerequisites

There are very few changes to the default configuration. Most parameters are already set to set up logical replication. However, there is one parameter to modify on the instance that “publishes”: wal_level. Set to “replica”, it must be “logical”.

In /etc/postgresql/10/main/postgresql.conf

wal_level = logical

To apply changes we must restart the cluster:

pg_ctlcluster 10 main restart

Publication

Let’s create a database b1 that contains a table t1.

postgres=# create database b1;

CREATE DATABASE

postgres=# \c b1

You are now connected to database "b1" as user "postgres".

b1=# create table t1 (c1 text);

CREATE TABLE

b1=# insert into t1 values ('un');

INSERT 0 1

b1=# select * from t1;

c1

----

un

(1 row)

Then, we use this order to create publication:

b1=# CREATE PUBLICATION pub1 FOR TABLE t1 ;

And that’s all! Note that it is possible to use the keyword FOR ALL TABLES to add all present and future tables to the publication.

We can verify that the publication was created with the following psql meta-command:

b1=# \dRp+

Publication pub1

All tables | Inserts | Updates | Deletes

------------+---------+---------+---------

f | t | t | t

Tables:

"public.t1"

Subscription

Logical replication does not replicate DDL orders, so we must create the table on the “sub” instance. It is not necessary to have the same database name, so we will create a database b2.

postgres@blog:~$ psql -p 5433

psql (10beta2)

Type "help" for help.

postgres=# CREATE DATABASE b2;

CREATE DATABASE

postgres=# \c b2

You are now connected to database "b2" as user "postgres".

b2=# create table t1 (c1 text);

CREATE TABLE

As for the publication, the subscription is created with an SQL order:

b2=# CREATE SUBSCRIPTION sub1 CONNECTION 'host=/var/run/postgresql port=5432 dbname=b1' PUBLICATION pub1;

NOTICE: created replication slot "sub1" on publisher

CREATE SUBSCRIPTION

b2=# select * from t1;

c1

----

un

(1 row)

Most importing part is: CONNECTION 'host=/var/run/postgresql port=5432 dbname=b1'

Indeed, we indicate to the subscriber how to connect to the publication. In my example the two instances are on the same server and listen on a local socket. If you have instances on different server you will have to specify IP address. Then the port and do not forget the database where the publication was created.

As you can see, Postgres automatically synchronize data that was already present in table t1.

Now if I add rows in table t1, they will automatically be replicated to the instance “sub”:

postgres@blog:~$ psql b1

psql (10beta2)

Type "help" for help.

b1=# insert into t1 values ('deux');

INSERT 0 1

postgres=# \q

postgres@blog:~$ psql -p 5433 b2

psql (10beta2)

Type "help" for help.

b2=# select * from t1;

c1

------

un

deux

(2 rows)

As for the publication, there is a meta-command to display subscriptions:

\dRs+

List of subscriptions

Name | Owner | Enabled | Publication | Synchronous commit | Conninfo

------+----------+---------+-------------+--------------------+----------------------------------------------

sub1 | postgres | t | {pub1} | off | host=/var/run/postgresql port=5432 dbname=b1

(1 row)

That’s all for this article, in a future article we will see limitations.

- 383 次浏览

【PostgreSQL架构】PostgreSQL 10:性能改进

- 25 次浏览

【PostgreSQL架构】PostgreSQL-JSONB和统计

- 48 次浏览

【PostgreSQL架构】PostgreSQL中的并行性

PostgreSQL是最优秀的对象关系数据库之一,其体系结构是基于进程的,而不是基于线程的。虽然目前几乎所有的数据库系统都使用线程来实现并行性,但是PostgreSQL的基于进程的体系结构是在POSIX线程之前实现的。PostgreSQL在启动时启动一个进程“postmaster”,之后每当一个新的客户端连接到PostgreSQL时,它就会跨越新的进程。

在版本10之前,单个连接中没有并行性。诚然,由于流程架构的原因,来自不同客户机的多个查询可以具有并行性,但它们无法从彼此获得任何性能好处。换句话说,单个查询是串行运行的,没有并行性。这是一个巨大的限制,因为单个查询不能利用多核。PostgreSQL中的并行性是从9.6版引入的。在某种意义上,并行是指一个进程可以有多个线程来查询系统并利用系统中的多核。这就提供了PostgreSQL内部查询并行性。

PostgreSQL中的并行性是作为多个功能的一部分实现的,这些功能包括顺序扫描、聚合和连接。

PostgreSQL中的并行组件

在PostgreSQL中,并行性有三个重要组成部分。这些是过程本身,聚集,和工人。如果没有并行,进程本身将处理所有数据,但是,当planner决定某个查询或其一部分可以并行时,它会在计划的可并行部分中添加一个Gather节点,并生成该子树的Gather根节点。查询执行从流程(leader)级别开始,计划的所有序列部分都由leader运行。但是,如果对查询的任何部分(或全部)启用并允许并行,则为其分配具有一组工作线程的gather节点。工作线程是与需要并行化的部分树(部分计划)并行运行的线程。关系的块在线程之间被划分,这样关系就保持顺序。线程数由PostgreSQL配置文件中设置的设置控制。工人使用共享内存进行协调/交流,一旦工人完成工作,结果将传递给领导进行积累。

并行顺序扫描

在PostgreSQL 9.6中,增加了对并行顺序扫描的支持。顺序扫描是对一个表的扫描,在这个表中,一个块序列一个接一个地被求值。这就其本质而言,允许并行性。所以这是第一个并行实现的自然候选。在这种情况下,整个表在多个工作线程中被顺序扫描。这里是一个简单的查询,我们在这里查询pgbench_accounts表行(63165),它有150000000个元组。总执行时间为4343080ms。由于没有定义索引,因此使用顺序扫描。整个表在一个没有线程的进程中被扫描。因此,无论有多少可用内核,都要使用CPU的单核。

db=# EXPLAIN ANALYZE SELECT *

FROM pgbench_accounts

WHERE abalance > 0;

QUERY PLAN

----------------------------------------------------------------------

Seq Scan on pgbench_accounts (cost=0.00..73708261.04 rows=1 width=97)

(actual time=6868.238..4343052.233 rows=63165 loops=1)

Filter: (abalance > 0)

Rows Removed by Filter: 1499936835

Planning Time: 1.155 ms

Execution Time: 4343080.557 ms

(5 rows)

如果这些150000000行在一个进程中使用“10”个工作线程并行扫描呢?它将大大缩短执行时间。

db=# EXPLAIN ANALYZE select * from pgbench_accounts where abalance > 0;

QUERY PLAN

----------------------------------------------------------------------

Gather (cost=1000.00..45010087.20 rows=1 width=97)

(actual time=14356.160..1628287.828 rows=63165 loops=1)

Workers Planned: 10

Workers Launched: 10

-> Parallel Seq Scan on pgbench_accounts

(cost=0.00..45009087.10 rows=1 width=97)

(actual time=43694.076..1628068.096 rows=5742 loops=11)

Filter: (abalance > 0)

Rows Removed by Filter: 136357894

Planning Time: 37.714 ms

Execution Time: 1628295.442 ms

(8 rows)

现在,总的执行时间是1628295ms;这是一个266%的改进,而使用10个工人线程用于扫描。

用于基准的查询:从abalance>0的pgbench_帐户中选择*;

表大小:426GB

表中总行:150000000

用于基准测试的系统:

CPU:2个Intel(R)Xeon(R)CPU E5-2643 v2@3.50GHz

内存:256GB DDR3 1600

磁盘:ST3000NM0033

上图清楚地显示了并行性如何提高顺序扫描的性能。添加单个工作进程时,由于没有获得并行性,性能下降是可以理解的,但是创建额外的聚集节点和单个工作会增加开销。但是,使用多个工作线程时,性能会显著提高。另外,需要注意的是,性能不会以线性或指数方式增加。它会逐渐改善,直到增加更多的工人不会给性能带来任何提升;有点像接近水平渐近线。这个基准测试是在一个64核的机器上执行的,很明显,拥有10个以上的工人不会显著提高性能。

平行聚合

在数据库中,计算聚合是非常昂贵的操作。当在单个过程中进行评估时,这些过程需要相当长的时间。在PostgreSQL 9.6中,通过简单地将它们分成块(一种分而治之的策略)来增加并行计算这些数据的能力。这允许多个工人在领导计算基于这些计算的最终值之前计算聚合部分。更严格地说,PartialAggregate节点被添加到一个计划树中,每个PartialAggregate节点从一个worker获取输出。这些输出随后发送到FinalizeAggregate节点,该节点组合来自多个(所有)PartialAggregate节点的聚合。因此,有效的并行部分计划包括一个FinalizeAggregate节点和一个Gather节点,后者将PartialAggregate节点作为子节点。

db=# EXPLAIN ANALYZE SELECT count(*) from pgbench_accounts;

QUERY PLAN

----------------------------------------------------------------------

Aggregate (cost=73708261.04..73708261.05 rows=1 width=8)

(actual time=2025408.357..2025408.358 rows=1 loops=1)

-> Seq Scan on pgbench_accounts (cost=0.00..67330666.83 rows=2551037683 width=0)

(actual time=8.162..1963979.618 rows=1500000000 loops=1)

Planning Time: 54.295 ms

Execution Time: 2025419.744 ms

(4 rows)

下面是并行计算聚合时计划的示例。在这里你可以清楚地看到性能的提高。

db=# EXPLAIN ANALYZE SELECT count(*) from pgbench_accounts;

QUERY PLAN

----------------------------------------------------------------------

Finalize Aggregate (cost=45010088.14..45010088.15 rows=1 width=8)

(actual time=1737802.625..1737802.625 rows=1 loops=1)