【语言模型】2022年NLP的10个主要语言模型

视频号

微信公众号

知识星球

更新:考虑到大型语言模型的最新研究进展,我们已经发布了本文的更新版本。看看2023年改变人工智能的前六大NLP语言模型。

迁移学习和预训练语言模型在自然语言处理(NLP)中的引入推动了语言理解和生成的极限。迁移学习和将变压器应用于不同的下游NLP任务已成为最新研究进展的主要趋势。

与此同时,NLP界对占据排行榜的巨大预训练语言模型的研究价值存在争议。尽管许多人工智能专家同意安娜·罗杰斯的说法,即仅仅通过使用更多的数据和计算能力来获得最先进的结果不是研究新闻,但其他NLP意见领袖指出了当前趋势中的一些积极时刻,例如,看到当前范式的根本局限性的可能性。

无论如何,NLP语言模型的最新改进似乎不仅是由于计算能力的巨大提升,而且还因为发现了在保持高性能的同时减轻模型重量的巧妙方法。

为了帮助您了解语言建模方面的最新突破,我们总结了过去几年中引入的关键语言模型的研究论文。

订阅本文底部的人工智能研究邮件列表,以便在我们发布新摘要时得到提醒。

如果你想跳过,以下是我们的专题报道:

- BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

- GPT2: Language Models Are Unsupervised Multitask Learners

- XLNet: Generalized Autoregressive Pretraining for Language Understanding

- RoBERTa: A Robustly Optimized BERT Pretraining Approach

- ALBERT: A Lite BERT for Self-supervised Learning of Language Representations

- T5: Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer

- GPT3: Language Models Are Few-Shot Learners

- ELECTRA: Pre-training Text Encoders as Discriminators Rather Than Generators

- DeBERTa: Decoding-enhanced BERT with Disentangled Attention

- PaLM: Scaling Language Modeling with Pathways

重要的预训练语言模型

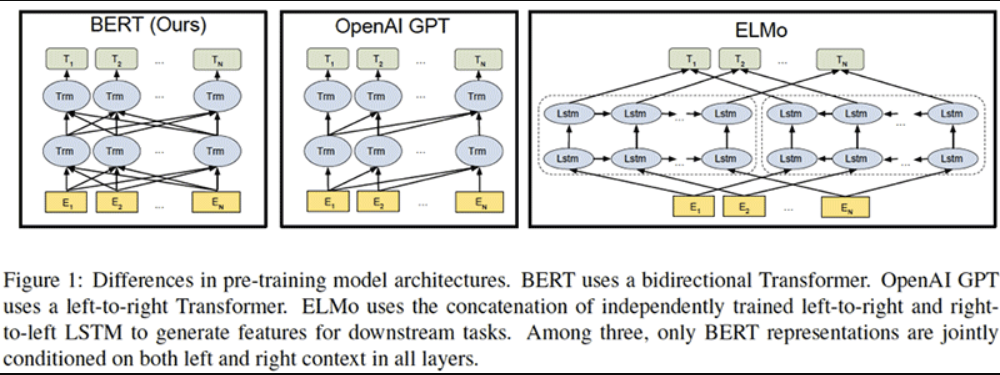

1.《BERT:语言理解深度双向转换的预训练》

,Jacob Devlin、Ming Wei Chang、Kenton Lee和Kristina Toutanova著

原始摘要

我们介绍了一种新的语言表示模型,称为BERT,它代表来自Transformers的双向编码器表示。与最近的语言表示模型不同,BERT被设计为通过在所有层中联合调节左右上下文来预训练深度双向表示。因此,只需一个额外的输出层,就可以对预先训练的BERT表示进行微调,为广泛的任务(如问答和语言推理)创建最先进的模型,而无需对特定任务的架构进行实质性修改。

BERT概念简单,经验丰富。它在11项自然语言处理任务上获得了最先进的结果,包括将GLUE基准提高到80.4%(7.6%的绝对改进),将MultiNLI准确率提高到86.7(5.6%的绝对改善),以及将SQuAD v1.1问答测试F1提高到93.2(1.5%的绝对提高),比人类表现高2.0%。

我们的总结

谷歌人工智能团队为自然语言处理(NLP)提出了一个新的尖端模型——BERT,即来自Transformers的双向编码器表示。它的设计允许模型从每个单词的左侧和右侧考虑上下文。虽然概念上很简单,但BERT在11项NLP任务上获得了最先进的结果,包括问答、命名实体识别和其他与一般语言理解相关的任务。

这篇论文的核心思想是什么?

- 通过随机屏蔽一定比例的输入令牌来训练深度双向模型,从而避免单词可以间接“看到自己”的循环。

- 此外,通过构建一个简单的二元分类任务来预测句子B是否紧跟在句子a之后,从而使BERT能够更好地理解句子之间的关系,从而预训练句子关系模型。

- 用大量数据(33亿个单词语料库)训练一个非常大的模型(24个Transformer块,1024个隐藏,340M个参数)。

关键成就是什么?

- 推进11项NLP任务的最先进技术,包括:

- GLUE得分为80.4%,比之前的最佳成绩提高了7.6%;

- 在SQuAD 1.1上实现了93.2%的准确率,并比人类性能高出2%。

- 提出了一个预先训练的模型,该模型不需要任何实质性的架构修改即可应用于特定的NLP任务。

人工智能界是怎么想的?

- BERT模型标志着NLP进入了一个新的时代。

- 简而言之,两个无监督任务(“填空”和“句子B在句子a之后吗?”)一起为许多NLP任务提供了很好的结果。

- 语言模型的预训练成为一种新的标准。

未来的研究领域是什么?

- 在更广泛的任务中测试该方法。

- 研究BERT可能捕捉到或不捕捉到的语言现象。

什么是可能的业务应用程序?

- BERT可以帮助企业解决一系列NLP问题,包括:

- 聊天机器人提供更好的客户体验;

- 分析客户评价;

- 搜索相关信息等。

从哪里可以获得实现代码?

- Google Research has released an official Github repository with Tensorflow code and pre-trained models for BERT.

- PyTorch implementation of BERT is also available on GitHub.

2.语言模型是无监督的多任务学习者,

作者:Alec Radford,Jeffrey Wu,Rewon Child,David Luan,Dario Amodei,Ilya Sutskever

原始摘要

自然语言处理任务,如问答、机器翻译、阅读理解和摘要,通常在特定任务数据集上进行监督学习。我们证明,当在一个名为WebText的数百万网页的新数据集上进行训练时,语言模型在没有任何明确监督的情况下开始学习这些任务。当以文档加问题为条件时,语言模型生成的答案在CoQA数据集上达到55 F1——在不使用127000+训练示例的情况下,匹配或超过了四分之三的基线系统的性能。语言模型的能力对于零样本任务转移的成功至关重要,增加它可以以对数方式跨任务提高性能。我们最大的模型GPT-2是一个1.5B参数的Transformer,它在8个测试语言建模数据集中有7个在零样本设置下获得了最先进的结果,但仍低于WebText。模型中的样本反映了这些改进,并包含连贯的文本段落。这些发现为构建语言处理系统提供了一条很有前途的途径,该系统从自然发生的演示中学习执行任务。

我们的总结

在本文中,OpenAI团队证明了预训练的语言模型可以用于解决下游任务,而无需任何参数或架构修改。他们在一个庞大而多样的数据集上训练了一个非常大的模型,一个1.5B参数的Transformer,该数据集包含从4500万个网页中抓取的文本。该模型生成连贯的文本段落,并在各种任务上取得有希望、有竞争力或最先进的结果。

这篇论文的核心思想是什么?

- 在庞大多样的数据集上训练语言模型:

- 选择由人类策划/过滤的网页;

- 清理和消除文本的重复,并删除所有维基百科文档,以最大限度地减少训练集和测试集的重叠;

- 使用最终的WebText数据集,该数据集具有略多于800万个文档,总共40GB的文本。

- 使用字节级版本的字节对编码(BPE)进行输入表示。

- 构建一个非常大的基于Transformer的模型GPT-2:

- 最大的模型包括1542M个参数和48层;

- 该模型主要遵循OpenAI GPT模型,很少进行修改(即扩展词汇表和上下文大小、修改初始化等)。

关键成就是什么?

- 在8个测试语言建模数据集中的7个上获得最先进的结果。

- 在常识推理、问答、阅读理解和翻译方面显示出相当有希望的结果。

- 生成连贯的文本,例如,一篇关于发现会说话的独角兽的新闻文章。

人工智能界是怎么想的?

“研究人员建立了一个有趣的数据集,应用了现在的标准工具,并产生了一个令人印象深刻的模型。”——卡内基梅隆大学助理教授Zachary C.Lipton。

未来的研究领域是什么?

研究对decaNLP和GLUE等基准的微调,以了解GPT-2的巨大数据集和容量是否可以克服BERT单向表示的低效性。

什么是可能的业务应用程序?

就实际应用而言,GPT-2模型在没有任何微调的情况下的性能远远不能使用,但它显示了一个非常有前途的研究方向。

从哪里可以获得实现代码?

- 最初,OpenAI决定只发布一个较小版本的GPT-2,参数为117M。决定不发布更大的模型是“因为担心大型语言模型被用来大规模生成欺骗性、偏见或滥用语言”。

- 11月,OpenAI终于发布了其最大的1.5B参数模型。此处提供代码。

- 拥抱脸引入了最初发布的GPT-2模型的PyTorch实现。

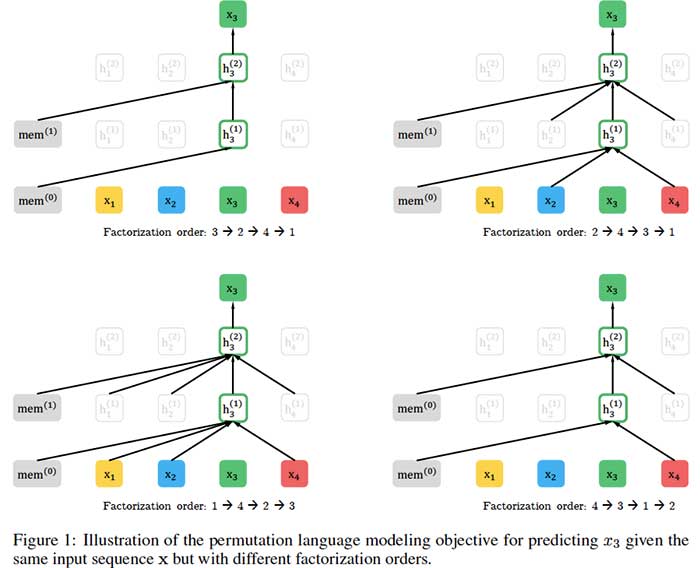

3、 XLNet: Generalized Autoregressive Pretraining for Language Understanding

by Zhilin Yang, Zihang Dai, Yiming Yang, Jaime Carbonell, Ruslan Salakhutdinov, Quoc V. Le

原始摘要

由于具有对双向上下文建模的能力,与基于自回归语言建模的预训练方法相比,像BERT这样的基于去噪自动编码的预训练获得了更好的性能。然而,依赖于用掩码破坏输入,BERT忽略了掩码位置之间的依赖性,并受到预训练微调差异的影响。鉴于这些优点和缺点,我们提出了XLNet,这是一种广义自回归预训练方法,它(1)通过最大化因子分解阶的所有排列上的期望似然来实现双向上下文的学习,(2)由于其自回归公式克服了BERT的局限性。此外,XLNet将最先进的自回归模型Transformer XL的思想集成到预训练中。从经验上看,XLNet在20项任务上的表现优于BERT,通常相差很大,并在18项任务上取得了最先进的结果,包括问答、自然语言推理、情感分析和文档排名。

我们的总结

卡内基梅隆大学和谷歌的研究人员开发了一种新的模型XLNet,用于自然语言处理(NLP)任务,如阅读理解、文本分类、情绪分析等。XLNet是一种广义的自回归预训练方法,它利用了自回归语言建模(例如Transformer XL)和自动编码(例如BERT)的优点,同时避免了它们的局限性。实验表明,新模型的性能优于BERT和Transformer XL,并在18个NLP任务上实现了最先进的性能。

这篇论文的核心思想是什么?

- XLNet将BERT的双向能力与Transformer XL的自回归技术相结合:

- 与BERT一样,XLNet使用双向上下文,这意味着它查看给定令牌之前和之后的单词,以预测它应该是什么。为此,XLNet最大化了序列相对于因子分解顺序的所有可能排列的预期对数似然性。

- 作为一种自回归语言模型,XLNet不依赖于数据损坏,因此避免了BERT因掩蔽而受到的限制——即预训练微调差异和未掩蔽令牌相互独立的假设。

- 为了进一步改进预训练的架构设计,XLNet集成了Transformer XL的分段递归机制和相关编码方案。

关键成就是什么?

- XLnet在20项任务上优于BERT,通常有很大的优势。

- 新模型在18项NLP任务上实现了最先进的性能,包括问答、自然语言推理、情感分析和文档排序。

人工智能界是怎么想的?

- 这篇论文被人工智能领域的领先会议NeurIPS 2019接受口头演讲。

- “国王死了。国王万岁。BERT的统治可能即将结束。CMU和谷歌的新模型XLNet在20项任务上优于BERT。”——Deepmind的研究科学家Sebastian Ruder。

- “XLNet可能会在一段时间内成为任何NLP从业者的重要工具……[它]是NLP中最新的尖端技术。”——卡耐基梅隆大学的Keita Kurita。

未来的研究领域是什么?

- 将XLNet扩展到新的领域,例如计算机视觉和强化学习。

什么是可能的业务应用程序?

- XLNet可以帮助企业解决各种NLP问题,包括:

- 用于一线客户支持或回答产品咨询的聊天机器人;

- 情绪分析,用于基于客户评论和社交媒体来衡量品牌知名度和感知;

- 在文档库或网上搜索相关信息等。

从哪里可以获得实现代码?

- 作者已经发布了XLNet的官方Tensorflow实现。

- 该模型的PyTorch实现也可在GitHub上获得。

4.《RoBERTa:一种稳健优化的BERT预训练方法》,

作者:Yinhan Liu、Myle Ott、Naman Goyal、Du Jingfei、Mandar Joshi、Danqi Chen、Omer Levy、Mike Lewis、Luke Zettlemoyer、Veselin Stoyanov

原始摘要

语言模型预训练带来了显著的性能提升,但不同方法之间的仔细比较具有挑战性。训练在计算上是昂贵的,通常在不同大小的私人数据集上进行,正如我们将要展示的,超参数选择对最终结果有重大影响。我们提出了一项BERT预训练的复制研究(Devlin et al.,2019),该研究仔细测量了许多关键超参数和训练数据大小的影响。我们发现BERT的训练严重不足,可以达到或超过之后发布的每个模型的性能。我们最好的模型在GLUE、RACE和SQuAD方面取得了最先进的结果。这些结果突出了以前被忽视的设计选择的重要性,并对最近报告的改进来源提出了疑问。我们发布了我们的模型和代码。

我们的总结

由于预训练方法的引入,自然语言处理模型取得了重大进展,但训练的计算费用使复制和微调参数变得困难。在这项研究中,脸书人工智能和华盛顿大学的研究人员分析了谷歌双向编码器表示从变压器(BERT)模型的训练,并确定了训练程序的几个变化,以提高其性能。具体来说,研究人员使用了一个新的、更大的数据集进行训练,在更多的迭代中训练模型,并删除了下一个序列预测训练目标。由此产生的优化模型RoBERTa(鲁棒优化BERT方法)与最近引入的XLNet模型在GLUE基准上的得分相匹配。

这篇论文的核心思想是什么?

- 脸书人工智能研究团队发现,BERT训练严重不足,并提出了一个改进的训练配方,名为RoBERTa:

- 更多数据:160GB的文本,而不是最初用于训练BERT的16GB数据集。

- 更长的训练:将迭代次数从100K增加到300K,然后进一步增加到500K。

- 较大的批次:8K,而不是原来BERT基本型号中的256。

- 具有50K子字单元的较大字节级BPE词汇表,而不是大小为30K的字符级BPE词汇量。

- 从训练过程中删除下一个序列预测目标。

- 动态更改应用于训练数据的掩蔽模式。

关键成就是什么?

- 在通用语言理解评估(GLUE)基准测试中,RoBERTa在所有单项任务中都优于BERT。

- 新模型与最近在GLUE基准上引入的XLNet模型相匹配,并在九个单独任务中的四个任务中设定了新的技术水平。

未来的研究领域是什么?

- 包含更复杂的多任务微调程序。

什么是可能的业务应用程序?

- 像RoBERTa这样经过预训练的大型语言框架可以在业务环境中用于广泛的下游任务,包括对话系统、问答、文档分类等。

从哪里可以获得实现代码?

本研究中使用的模型和代码可在GitHub上获得。

5. ALBERT: A Lite BERT for Self-supervised Learning of Language Representations,

by Zhenzhong Lan, Mingda Chen, Sebastian Goodman, Kevin Gimpel, Piyush Sharma, Radu Soricut

原始摘要

在预训练自然语言表示时增加模型大小通常会提高下游任务的性能。然而,在某些时候,由于GPU/TPU内存限制、较长的训练时间和意外的模型退化,进一步的模型增加变得更加困难。为了解决这些问题,我们提出了两种参数约简技术来降低BERT的内存消耗和提高训练速度。综合的经验证据表明,与最初的BERT相比,我们提出的方法产生了规模更好的模型。我们还使用了一种自我监督损失,该损失侧重于对句子间连贯性进行建模,并表明它始终有助于多句子输入的下游任务。因此,我们的最佳模型在GLUE、RACE和SQuAD基准上建立了新的最先进的结果,同时与BERT-large相比,参数更少。

我们的总结

谷歌研究团队解决了预先训练的语言模型不断增长的问题,这会导致内存限制、训练时间延长,有时还会意外地降低性能。具体而言,他们引入了一种精简的BERT(ALBERT)架构,该架构包含两种参数约简技术:因子化嵌入参数化和跨层参数共享。此外,所提出的方法包括句子顺序预测的自监督损失,以提高句间连贯性。实验表明,ALBERT的最佳版本在GLUE、RACE和SQuAD基准上设定了新的最先进的结果,同时具有比BERT-large更少的参数。

这篇论文的核心思想是什么?

- 由于可用硬件的内存限制、较长的训练时间以及随着参数数量的增加模型性能的意外下降,通过使语言模型更大来进一步改进语言模型是不合理的。

- 为了解决这个问题,研究人员引入了ALBERT架构,该架构包含两种参数缩减技术:

- 因子化嵌入参数化,其中通过将大的词汇嵌入矩阵分解为两个小矩阵,将隐藏层的大小与词汇嵌入的大小分离;

- 跨层参数共享,以防止参数的数量随着网络的深度而增长。

- 通过引入句子顺序预测的自监督损失来解决BERT在句间连贯方面的局限性,进一步提高了ALBERT的性能。

关键成就是什么?

- 通过引入参数约简技术,与原始BERT大模型相比,参数减少了18倍、训练速度加快了1.7倍的ALBERT配置仅实现了略差的性能。

- 比BERT大得多的ALBERT配置仍然具有更少的参数,其性能优于当前所有最先进的语言模式,如下所示:

- 在RACE基准上的准确率为89.4%;

- GLUE基准得分89.4分;和

- 在SQuAD 2.0基准上,F1成绩为92.2。

人工智能界是怎么想的?

- 该论文已提交给ICLR 2020,可在OpenReview论坛上查看,您可以在论坛上查看NLP专家的评论和意见。评审人员主要对所提交的论文非常赞赏。

未来的研究领域是什么?

- 通过稀疏注意力和块注意力等方法加快训练和推理。

- 通过硬示例挖掘、更高效的模型训练和其他方法进一步提高模型性能。

什么是可能的业务应用程序?

- ALBERT语言模型可以在商业环境中使用,以提高一系列下游任务的性能,包括聊天机器人性能、情感分析、文档挖掘和文本分类。

从哪里可以获得实现代码?

- ALBERT的原始实现可在GitHub上获得。

- 这里还提供了ALBERT的TensorFlow实现。

- ALBERT的PyTorch实现可以在这里和这里找到。

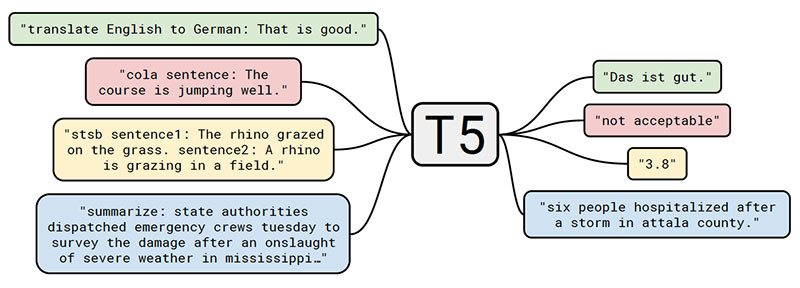

6.Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer

by Colin Raffel, Noam Shazeer, Adam Roberts, Katherine Lee, Sharan Narang, Michael Matena, Yanqi Zhou, Wei Li, Peter J. Liu

原始摘要

迁移学习是自然语言处理(NLP)中一种强大的技术,它首先在数据丰富的任务上对模型进行预训练,然后在下游任务上进行微调。迁移学习的有效性导致了方法、方法和实践的多样性。在本文中,我们通过引入一个统一的框架来探索NLP的迁移学习技术的前景,该框架将每个语言问题转换为文本到文本的格式。我们的系统研究比较了数十项语言理解任务的预训练目标、架构、未标记数据集、迁移方法和其他因素。通过将我们的探索见解与规模和我们新的“Colossal Clean Crawled Corpus”相结合,我们在许多基准测试上取得了最先进的成果,包括摘要、问答、文本分类等。为了促进NLP迁移学习的未来工作,我们发布了我们的数据集、预先训练的模型和代码。

我们的总结

谷歌研究团队提出了一种在NLP中进行迁移学习的统一方法,目的是在该领域开创一个新的技术状态。为此,他们建议将每个NLP问题视为“文本到文本”的问题。这样的框架允许对不同的任务使用相同的模型、目标、训练过程和解码过程,包括摘要、情绪分析、问答和机器翻译。研究人员将他们的模型称为文本到文本转换转换器(T5),并在大量网络抓取数据的语料库上对其进行训练,以在许多NLP任务中获得最先进的结果。

这篇论文的核心思想是什么?

- 该文件有几个重要贡献:

- 通过探索和比较现有技术,提供一个关于NLP领域现状的全面视角。

- 通过建议将每一个NLP问题都视为一个文本到文本的任务,介绍了一种在NLP中进行迁移学习的新方法:

- 由于在原始输入句子中添加了特定于任务的前缀(例如,“将英语翻译成德语:”、“总结:”),该模型可以理解应该执行哪些任务。

- 展示并发布了一个新的数据集,该数据集由数百千兆字节的干净的网络抓取英语文本组成,即Colossal clean Crawled Corpus(C4)。

- 在C4数据集上训练一个称为文本到文本转换转换器(T5)的大型(高达11B参数)模型。

关键成就是什么?

- 拥有110亿个参数的T5模型在考虑的24项任务中的17项任务中实现了最先进的性能,包括:

- GLUE得分为89.7,在CoLA、RTE和WNLI任务上的表现显著改善;

- 在SQuAD数据集上的精确匹配得分为90.06;

- SuperGLUE得分为88.9,这比之前最先进的结果(84.6)有了非常显著的改进,非常接近人类的表现(89.8);

- 在CNN/每日邮报抽象摘要任务中,ROUGE-2F得分为21.55。

未来的研究领域是什么?

- 研究用更便宜的型号实现更强性能的方法。

- 探索更有效的知识提取技术。

- 进一步研究语言不可知论模型。

什么是可能的业务应用程序?

- 尽管引入的模型有数十亿个参数,并且可能太重而无法应用于商业环境,但所提出的思想可以用于提高不同NLP任务的性能,包括摘要、问题回答和情绪分析。

从哪里可以获得实现代码?

- 经过预训练的模型以及数据集和代码在GitHub上发布。

7.Language Models are Few-Shot Learners

by Tom B. Brown, Benjamin Mann, Nick Ryder, Melanie Subbiah, Jared Kaplan, Prafulla Dhariwal, Arvind Neelakantan, Pranav Shyam, Girish Sastry, Amanda Askell, Sandhini Agarwal, Ariel Herbert-Voss, Gretchen Krueger, Tom Henighan, Rewon Child, Aditya Ramesh, Daniel M. Ziegler, Jeffrey Wu, Clemens Winter, Christopher Hesse, Mark Chen, Eric Sigler, Mateusz Litwin, Scott Gray, Benjamin Chess, Jack Clark, Christopher Berner, Sam McCandlish, Alec Radford, Ilya Sutskever, Dario Amodei

原始摘要

最近的工作表明,通过对大量文本进行预训练,然后对特定任务进行微调,在许多NLP任务和基准测试方面取得了实质性的进展。虽然在架构上通常与任务无关,但这种方法仍然需要数千或数万个实例的特定任务微调数据集。相比之下,人类通常只能通过几个例子或简单的指令来执行一项新的语言任务,而当前的NLP系统在很大程度上仍然难以做到这一点。在这里,我们表明,扩大语言模型的规模大大提高了任务不可知的、少镜头的性能,有时甚至与之前最先进的微调方法相比具有竞争力。具体来说,我们训练GPT-3,这是一个具有1750亿个参数的自回归语言模型,比以前的任何非稀疏语言模型都多10倍,并测试其在少数镜头设置中的性能。对于所有任务,GPT-3在没有任何梯度更新或微调的情况下应用,任务和少量镜头演示完全通过与模型的文本交互指定。GPT-3在许多NLP数据集上实现了强大的性能,包括翻译、问答和完形填空任务,以及一些需要即时推理或领域自适应的任务,如解读单词、在句子中使用新词或执行三位数算术。同时,我们还确定了GPT-3的少量镜头学习仍然很困难的一些数据集,以及GPT-3面临与在大型网络语料库上训练相关的方法论问题的一些数据集中。最后,我们发现GPT-3可以生成新闻文章的样本,而人类评估者很难将其与人类撰写的文章区分开来。我们讨论了这一发现和GPT-3的更广泛的社会影响。

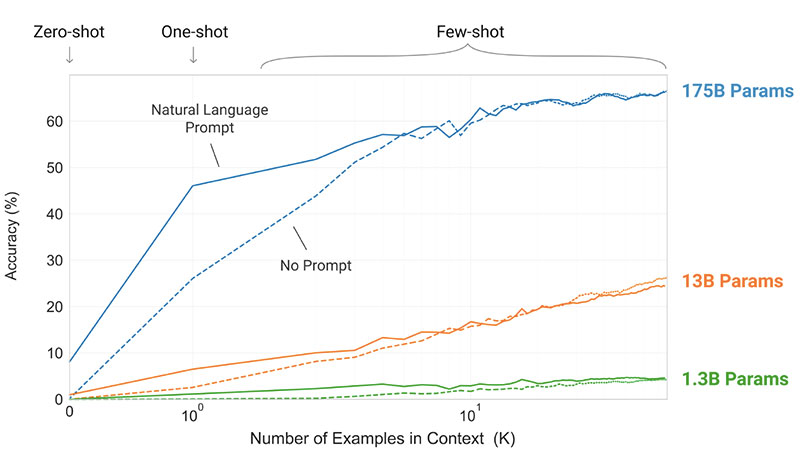

我们的总结

OpenAI研究团队提请注意这样一个事实,即每一项新的语言任务都需要一个标记的数据集,这限制了语言模型的适用性。考虑到可能的任务范围很广,而且通常很难收集到一个大的标记训练数据集,研究人员提出了一种替代解决方案,即扩大语言模型的规模,以提高与任务无关的少镜头性能。他们通过训练一个175B参数的自回归语言模型GPT-3来测试他们的解决方案,并评估其在二十多个NLP任务中的性能。在少拍学习、一拍学习和零样本学习下的评估表明,GPT-3取得了很好的效果

这篇论文的核心思想是什么?

- GPT-3模型使用与GPT-2相同的模型和架构,包括修改的初始化、预规范化和可逆标记化。

- 然而,与GPT-2相比,它在变换器的层中使用交替的密集和局部带状稀疏注意力模式,如稀疏变换器中一样。

- 该模型在三种不同的设置中进行评估:

- 很少的镜头学习,当在推理时给模型一些任务演示(通常是10到100),但不允许权重更新时。

- 一次性学习,只允许进行一次演示,同时提供任务的自然语言描述。

- 当不允许演示且模型只能访问任务的自然语言描述时,进行零样本学习。

关键成就是什么?

- 没有微调的GPT-3模型在许多NLP任务上取得了有希望的结果,甚至偶尔会超过为该特定任务微调的最先进模型:

- 在CoQA基准测试中,与微调SOTA获得的90.7 F1分数相比,零样本设置中的F1分数为81.5,单射设置中的F184.0,少射设置中为85.0。

- 在TriviaQA基准测试中,零样本设置的准确率为64.3%,一射设置的准确度为68.0%,少射设置的精确度为71.2%,超过了最新技术(68%)3.2%。

- 在LAMBADA数据集上,零样本设置的准确率为76.2%,一次性设置为72.5%,少量快照设置为86.4%,超过当前技术水平(68%)18%。

- 根据人类的评估,175B参数GPT-3模型生成的新闻文章很难与真实的区分开来(准确率略高于约52%的概率水平)。

未来的研究领域是什么?

- 提高训练前样本的效率。

- 探索少镜头学习是如何运作的。

- 将大型模型精简到可管理的大小,以用于实际应用。

人工智能界是怎么想的?

- “GPT-3的炒作太过了。它给人留下了深刻的印象(感谢你的赞美!)但它仍然有严重的弱点,有时还会犯非常愚蠢的错误。人工智能将改变世界,但GPT-3只是一个很早的一瞥。我们还有很多事情要弄清楚。”——OpenAI首席执行官兼联合创始人Sam Altman。

- Gradio首席执行官兼创始人Abubakar Abid表示:“我很震惊,从GPT-3中生成与暴力……或被杀无关的关于穆斯林的文本是多么困难。”。

- “不。GPT-3从根本上不了解它所谈论的世界。进一步增加语料库将使它能够产生更可信的模仿,但不能解决其对世界根本缺乏理解的问题。GPT-4的演示仍然需要人类挑选樱桃。”——Robust.ai首席执行官兼创始人Gary Marcus。

- “将GPT3的惊人性能外推到未来,表明生命、宇宙和一切的答案只有4.398万亿个参数。”——图灵奖得主杰弗里·辛顿。

什么是可能的业务应用程序?

- 由于其不切实际的资源需求,具有175B参数的模型很难应用于实际的业务问题,但如果研究人员设法将该模型提取到可行的大小,它可以应用于广泛的语言任务,包括问答和广告副本生成。

从哪里可以获得实现代码?

- 代码本身不可用,但GitHub上发布了一些数据集统计数据以及GPT-3中无条件、未经过滤的2048个令牌样本。

8. ELECTRA: Pre-training Text Encoders as Discriminators Rather Than Generators,

by Kevin Clark, Minh-Thang Luong, Quoc V. Le, Christopher D. Manning

原始摘要

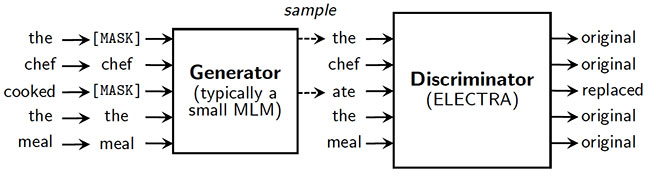

掩码语言建模(MLM)预训练方法(如BERT)通过用[MASK]替换一些令牌来破坏输入,然后训练模型来重建原始令牌。虽然它们在转移到下游NLP任务时产生了良好的结果,但它们通常需要大量的计算才能有效。作为一种替代方案,我们提出了一种更具样本效率的预训练任务,称为替换令牌检测。我们的方法不是屏蔽输入,而是通过用从小型生成器网络中采样的看似合理的替代品替换一些令牌来破坏输入。然后,我们不是训练一个预测损坏令牌的原始身份的模型,而是训练一个判别模型,该判别模型预测损坏输入中的每个令牌是否被生成器样本替换。彻底的实验表明,这种新的预训练任务比MLM更有效,因为该任务是在所有输入令牌上定义的,而不仅仅是被屏蔽的子集。因此,在给定相同的模型大小、数据和计算的情况下,我们的方法所学习的上下文表示大大优于BERT所学习的。小型车型的收益尤其强劲;例如,我们在一个GPU上训练一个模型4天,该模型在GLUE自然语言理解基准上优于GPT(使用30倍以上的计算训练)。我们的方法在规模上也能很好地工作,在使用不到其计算量1/4的情况下,其性能与RoBERTa和XLNet相当,在使用相同计算量的情况下优于它们。

我们的总结

BERT和XLNet等流行语言模型的预训练任务包括掩蔽未标记输入的一小部分,然后训练网络以恢复该原始输入。尽管它工作得很好,但这种方法并不是特别高效,因为它只从一小部分代币(通常约15%)中学习。作为一种替代方案,斯坦福大学和谷歌大脑的研究人员提出了一种新的预训练任务,称为替代令牌检测。他们建议用一个小语言模型生成的看似合理的替代品来代替屏蔽,而不是屏蔽。然后,使用预先训练的鉴别器来预测每个令牌是原始的还是替换的。因此,该模型从所有输入令牌中学习,而不是从小的掩码部分中学习,从而提高了计算效率。实验证实,所引入的方法在下游NLP任务上带来了显著更快的训练和更高的准确性。

这篇论文的核心思想是什么?

- 基于掩蔽语言建模的预训练方法在计算上效率低下,因为它们只使用一小部分令牌进行学习。

- 研究人员提出了一种新的预训练任务,称为替换令牌检测,其中:

- 一些令牌被来自小型生成器网络的样本所取代;

- 将模型预先训练为鉴别器,以区分原始令牌和替换令牌。

- 引入的方法被称为ELECTRA(高效学习准确分类令牌替换的编码器):

- 使模型能够从所有输入令牌而不是小的屏蔽子集中学习;

- 尽管与GAN相似,但不是对抗性的,因为生成用于替换的令牌的生成器是以最大可能性训练的。

关键成就是什么?

- 证明区分真实数据和具有挑战性的负样本的判别任务比现有的语言表征学习生成方法更有效。

- 引入一种大大优于最先进方法的模型,同时需要更少的预训练计算:

- ELECTRA Small的GLUE得分为79.9,优于得分为75.1的相对较小的BERT模型和得分为78.8的大得多的GPT模型。

- 与XLNet和RoBERTa性能相当的ELECTRA模型只使用了其训练前计算的25%。

- ELECTRA Large在GLUE和SQuAD基准测试上的性能超过了其他最先进的模型,同时仍然需要更少的预训练计算。

人工智能界是怎么想的?

- 该论文被选中在ICLR 2020上发表,ICLR 2020是深度学习领域的领先会议。

什么是可能的业务应用程序?

- 由于其计算效率,ELECTRA方法可以使业务从业者更容易地使用预先训练的文本编码器。

从哪里可以获得实现代码?

- 最初的TensorFlow实现和预先训练的权重在GitHub上发布。

9、 DeBERTa: Decoding-enhanced BERT with Disentangled Attention,

by Pengcheng He, Xiaodong Liu, Jianfeng Gao, Weizhu Chen

原始摘要

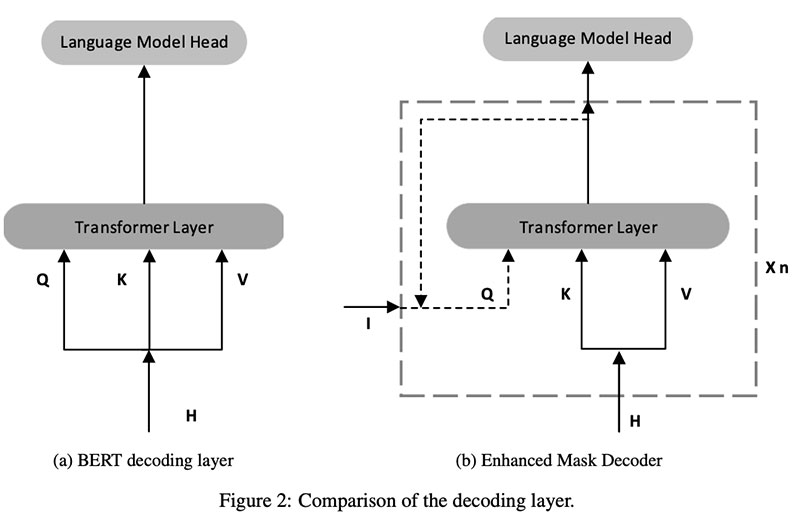

预训练神经语言模型的最新进展显著提高了许多自然语言处理(NLP)任务的性能。在本文中,我们提出了一种新的模型架构DeBERTa(具有解纠缠注意力的解码增强型BERT),该架构使用两种新技术改进了BERT和RoBERTa模型。第一种是解纠缠注意力机制,其中每个单词使用分别编码其内容和位置的两个向量来表示,并且单词之间的注意力权重分别使用关于其内容和相对位置的解纠缠矩阵来计算。其次,使用增强的掩码解码器在解码层中结合绝对位置,以预测模型预训练中的掩码令牌。此外,还采用了一种新的虚拟对抗性训练方法进行微调,以提高模型的泛化能力。我们表明,这些技术显著提高了模型预训练的效率,以及自然语言理解(NLU)和自然语言生成(NLG)下游任务的性能。与RoBERTa Large相比,在一半训练数据上训练的DeBERTa模型在广泛的NLP任务上始终表现更好,在MNLI上实现了+0.9%(90.2%对91.1%)的改进,在SQuAD v2.0上实现了+2.3%(88.4%对90.7%)的改进和在RACE上实现了+3.6%(83.2%对86.8%)的改进。值得注意的是,我们通过训练由48个具有15亿个参数的变换层组成的更大版本来放大DeBERTa。这一显著的性能提升使单个DeBERTa模型在宏观平均得分方面首次超过了人类在SuperGLUE基准上的表现(Wang et al.,2019a)(89.9对89.8),而截至2021年1月6日,整体DeBERTa模型位居SuperGLUE排行榜首位,以相当大的优势超过了人类基准(90.3对89.8。

我们的总结

微软研究公司的作者提出了DeBERTa,它比BERT有两个主要的改进,即消除纠缠的注意力和增强的掩码解码器。DeBERTa具有两个向量,分别通过对内容和相对位置进行编码来表示令牌/单词。DeBERTa中的自我注意机制处理内容对内容、内容对位置以及位置对内容的自我注意,而BERT中的自我关注相当于只有前两个组成部分。作者假设,位置到内容的自我关注也需要对令牌序列中的相对位置进行全面建模。此外,DeBERTa配备了增强型掩码解码器,其中令牌/字的绝对位置也与相对信息一起提供给解码器。DeBERTa的单一放大变体首次超过了SuperGLUE基准上的人类基线。在本出版物出版时,合奏DeBERTa是SuperGLUE上表现最好的方法。

这篇论文的核心思想是什么?

- 纠缠注意力:在原始BERT中,在自注意力之前添加了内容嵌入和位置嵌入,而自注意力仅应用于内容和位置向量的输出。作者假设,这只考虑了内容到内容的自我关注和内容到位置的自我关注,我们需要位置到内容的自关注以及对位置信息的完整建模。DeBERTa有两个表示内容和位置的独立向量,并且在所有可能的对之间计算自我关注,即内容到内容、内容到位置、位置到内容和位置到位置。位置到位置的自我注意一直是琐碎的1,并且没有信息,所以它没有被计算出来。

- 增强的掩码解码器:作者假设模型需要绝对的位置信息来理解句法上的细微差别,如主-客体特征。因此,DeBERTa被提供有绝对位置信息以及相对位置信息。绝对位置嵌入被提供给softmax层之前的最后一个解码器层,其给出输出。

- 尺度不变微调:一种称为尺度不变微调的虚拟对抗性训练算法被用作正则化方法,以提高泛化能力。单词嵌入被扰动到很小的程度,并被训练以产生与在非扰动单词嵌入上相同的输出。单词嵌入向量被归一化为随机向量(其中向量中的元素之和为1),以对模型中的参数数量不变。

关键成就是什么?

- 与目前最先进的方法RoBERTa Large相比,在一半训练数据上训练的DeBERTA模型实现了:

- MNLI的准确性提高了+0.9%(91.1%对90.2%),

- 与SQuAD v2.0相比,准确率提高了+2.3%(90.7%对88.4%),

- RACE的准确率提高了+3.6%(86.8%对83.2%)

- DeBERTa的单个放大变体首次超过了SuperGLUE基准上的人类基线(89.9对89.8)。在本出版物发表时,DeBERTa是SuperGLUE上表现最好的方法,以相当大的优势超过了人类基线(90.3对89.8。

人工智能界是怎么想的?

- 该论文已被ICLR 2021接受,ICLR 2021是深度学习的关键会议之一。

未来的研究领域是什么?

- 使用增强掩码解码器(EMD)框架,通过引入除位置之外的其他有用信息来改进预训练。

- 对尺度不变微调(SiFT)进行了更全面的研究。

什么是可能的业务应用程序?

- 预训练语言建模的上下文表示可用于搜索、问答、摘要、虚拟助理和聊天机器人等任务。

从哪里可以获得实现代码?

- DeBERTa的实现可在GitHub上获得。

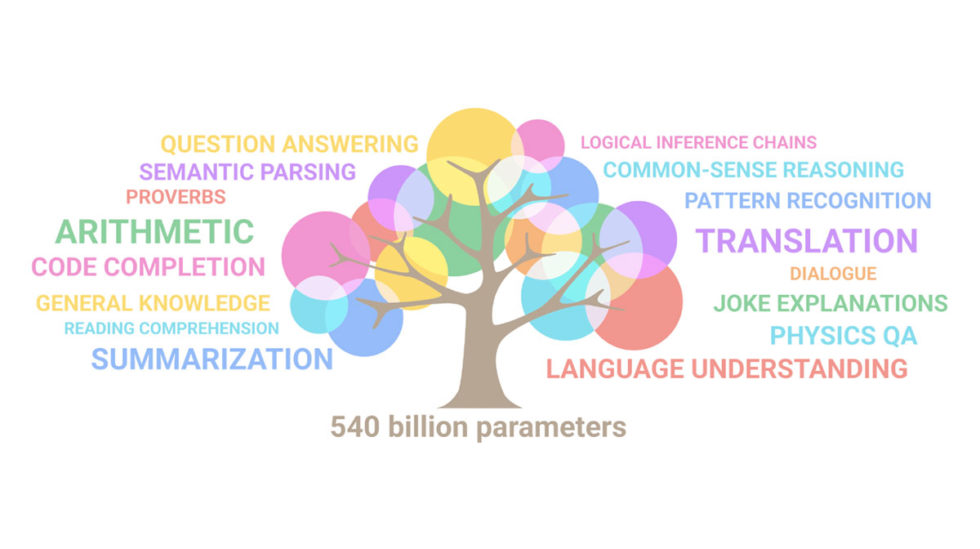

10. PaLM: Scaling Language Modeling with Pathways,

by Aakanksha Chowdhery, Sharan Narang, Jacob Devlin, Maarten Bosma, Gaurav Mishra, Adam Roberts, Paul Barham, Hyung Won Chung, Charles Sutton, Sebastian Gehrmann, Parker Schuh, Kensen Shi, Sasha Tsvyashchenko, Joshua Maynez, Abhishek Rao, Parker Barnes, Yi Tay, Noam Shazeer, Vinodkumar Prabhakaran, Emily Reif, Nan Du, Ben Hutchinson, Reiner Pope, James Bradbury, Jacob Austin, Michael Isard, Guy Gur-Ari, Pengcheng Yin, Toju Duke, Anselm Levskaya, Sanjay Ghemawat, Sunipa Dev, Henryk Michalewski, Xavier Garcia, Vedant Misra, Kevin Robinson, Liam Fedus, Denny Zhou, Daphne Ippolito, David Luan, Hyeontaek Lim, Barret Zoph, Alexander Spiridonov, Ryan Sepassi, David Dohan, Shivani Agrawal, Mark Omernick, Andrew M. Dai, Thanumalayan Sankaranarayana Pillai, Marie Pellat, Aitor Lewkowycz, Erica Moreira, Rewon Child, Oleksandr Polozov, Katherine Lee, Zongwei Zhou, Xuezhi Wang, Brennan Saeta, Mark Diaz, Orhan Firat, Michele Catasta, Jason Wei, Kathy Meier-Hellstern, Douglas Eck, Jeff Dean, Slav Petrov, Noah Fiedel

原始摘要

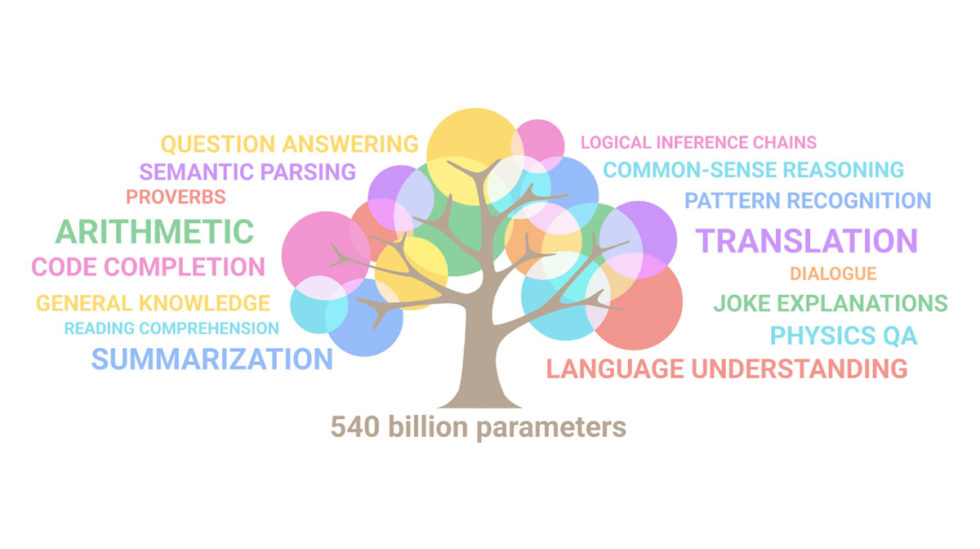

大型语言模型已被证明使用少镜头学习在各种自然语言任务中实现了显著的性能,这大大减少了使模型适应特定应用所需的特定任务训练示例的数量。为了进一步理解规模对少镜头学习的影响,我们训练了一个5400亿参数、密集激活的Transformer语言模型,我们称之为Pathways语言模型PaLM。我们使用Pathways在6144 TPU v4芯片上训练了PaLM,Pathways是一种新的ML系统,可以在多个TPU吊舱上进行高效训练。我们通过在数百个语言理解和生成基准上实现最先进的少量学习结果,展示了扩展的持续优势。在许多这样的任务上,PaLM 540B实现了突破性的性能,在一套多步骤推理任务上优于微调后的最先进技术,在最近发布的BIG基准测试上优于平均人类性能。大量的BIG工作台任务显示出与模型规模相比的不连续改进,这意味着随着我们扩展到最大的模型,性能急剧提高。PaLM在多语言任务和源代码生成方面也具有强大的能力,我们在一系列基准测试中对此进行了演示。此外,我们还提供了关于偏倚和毒性的全面分析,并研究了训练数据记忆相对于模型规模的程度。最后,我们讨论了与大型语言模型相关的伦理考虑,并讨论了潜在的缓解策略。

我们的总结

谷歌研究团队在BERT、ALBERT和T5模型的预训练语言模型领域做出了很大贡献。他们的最新贡献之一是Pathways语言模型(PaLM),这是一个使用Pathways系统训练的5400亿参数、仅密集解码器的Transformer模型。Pathways系统的目标是协调加速器的分布式计算。在它的帮助下,该团队能够在多个TPU v4吊舱上高效地训练单个模型。hundre的实验

这篇论文的核心思想是什么?

- 本文的主要思想是利用Pathways系统对5400亿参数语言模型进行规模化训练:

- 该团队在两个Cloud TPU v4 Pod之间使用Pod级别的数据并行性,同时在每个Pod中使用标准数据和模型并行性。

- 他们能够将训练扩展到6144个TPU v4芯片,这是迄今为止用于训练的最大的基于TPU的系统配置。

- 该模型实现了57.8%的硬件FLOP利用率的训练效率,正如作者所声称的,这是该规模的大型语言模型迄今为止实现的最高训练效率。

- PaLM模型的训练数据包括英语和多语言数据集的组合,其中包含高质量的网络文档、书籍、维基百科、对话和GitHub代码。

关键成就是什么?

- 大量实验表明,随着团队规模扩大到他们最大的模型,模型性能急剧提高。

- PaLM 540B在多项非常困难的任务上取得了突破性的性能:

- 语言理解和生成。所引入的模型在29项任务中的28项上超过了先前大型模型的少镜头表现,这些任务包括问答任务、完形填空和句子完成任务、上下文阅读理解任务、常识推理任务、SuperGLUE任务等。PaLM在BIG工作台任务中的表现表明,它可以区分因果关系,并在适当的上下文中理解概念组合。

- 推理。在8次提示下,PaLM解决了GSM8K中58%的问题,GSM8K是数千道具有挑战性的小学级数学问题的基准,优于之前通过微调GPT-3 175B模型获得的55%的高分。PaLM还展示了在需要多步骤逻辑推理、世界知识和深入语言理解的复杂组合的情况下生成明确解释的能力。

- 代码生成。PaLM的性能与经过微调的Codex 12B不相上下,同时使用更少50倍的Python代码进行训练,这证实了大型语言模型更有效地转移了对其他编程语言和自然语言数据的学习。

未来的研究领域是什么?

- 将Pathways系统的扩展能力与新颖的架构选择和培训方案相结合。

什么是可能的业务应用程序?

- 与最近引入的其他预训练语言模型类似,PaLM可以应用于广泛的下游任务,包括会话人工智能、问答、机器翻译、文档分类、广告副本生成、代码错误修复等。

从哪里可以获得实现代码?

- 到目前为止,PaLM还没有正式的代码实现版本,但它实际上使用了标准的Transformer模型体系结构,并进行了一些定制。

- 可以在GitHub上访问PaLM中特定Transformer架构的Pytorch实现。

- 如果你喜欢这些研究摘要,你可能还会对以下文章感兴趣:

- 2020年度人工智能与机器学习研究论文

- GPT-3及以后:你应该阅读的10篇NLP研究论文

- 会话人工智能代理的最新突破

- 每一位NLP工程师都需要了解的关于预训练语言模型的知识

- 430 次浏览